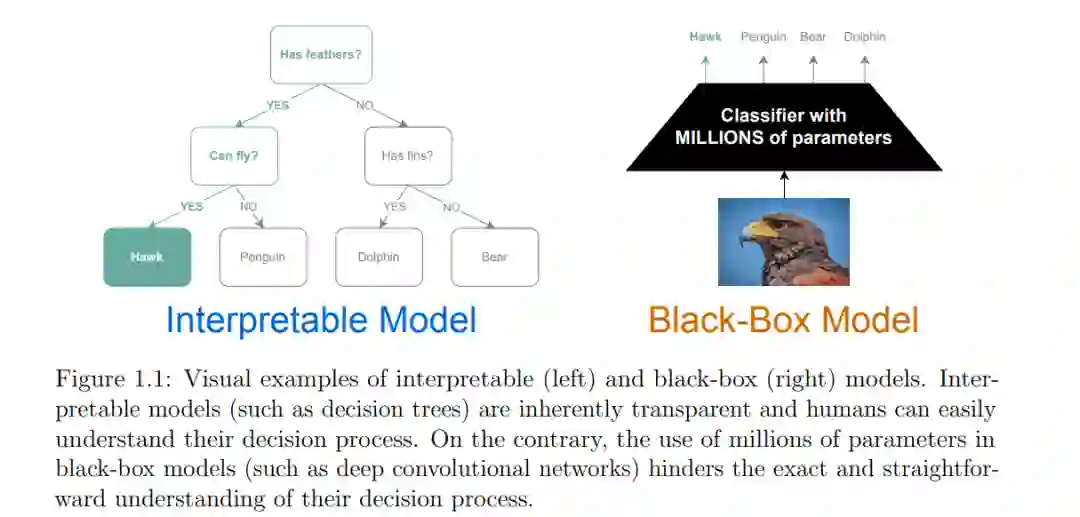

深度学习研究者们几乎与他们在模型中发现的缺陷同样快地积累了开创性的成就。尽管深度学习模型可以达到超人的表现,但解释深度学习的决策和错误对于“可解释AI”专家来说通常是不可能的,这使得立法者质疑部署深度学习系统的道德和法律后果。因此,该领域的关键开放问题是提高深度神经网络的透明度和可信度,以便安全地部署这些技术。

人们对深度学习的信任不足受到三个关键因素的影响。首先,缺乏正式和全面的理论破坏了可解释AI的领域。这导致了提出不恰当的问题,诱发了重新发现相似思想,并妨碍了研究者接近该领域。其次,可解释的AI文献主要被提供事后、定性和局部解释的方法所主导,这些解释通常是不准确和误导性的。最后,机器学习系统—包括深度神经网络—在任务准确性和可解释性之间努力寻找平衡。现有的解决方案要么为任务准确性牺牲模型透明度,要么反之,使得同时优化这两个目标变得困难。

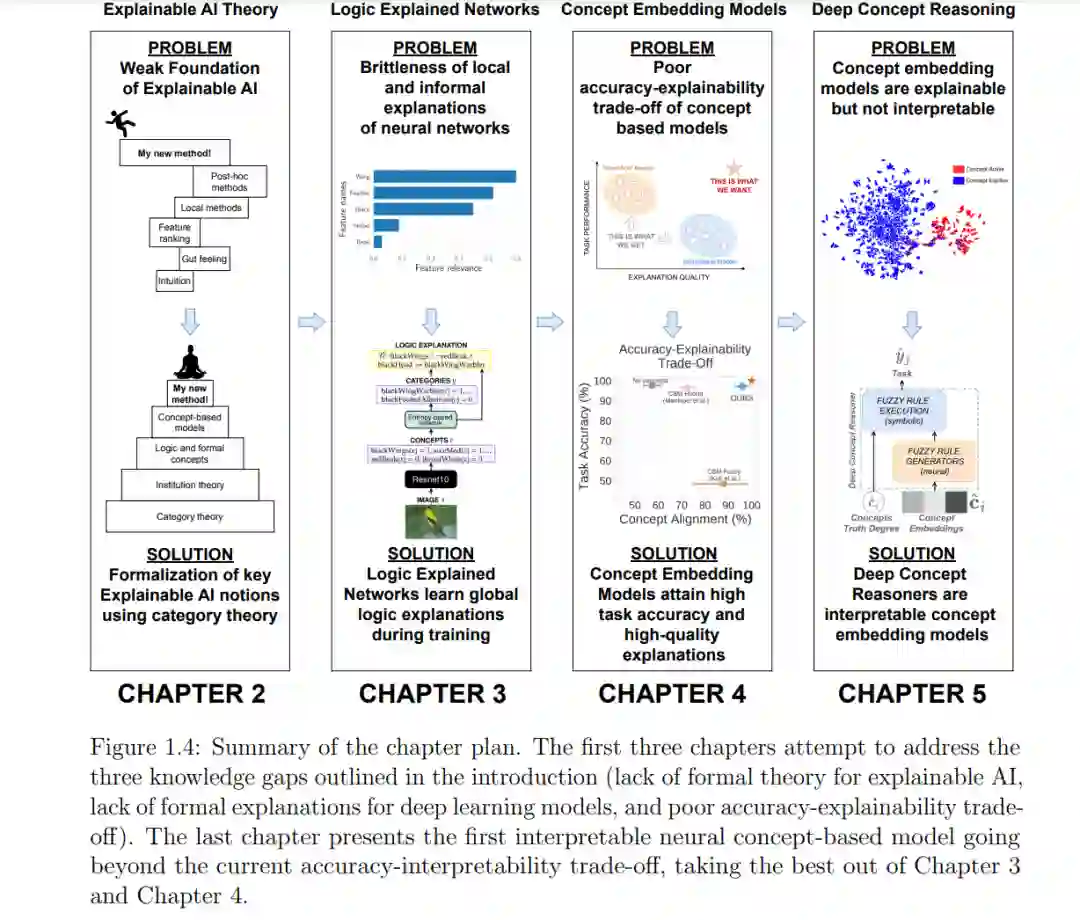

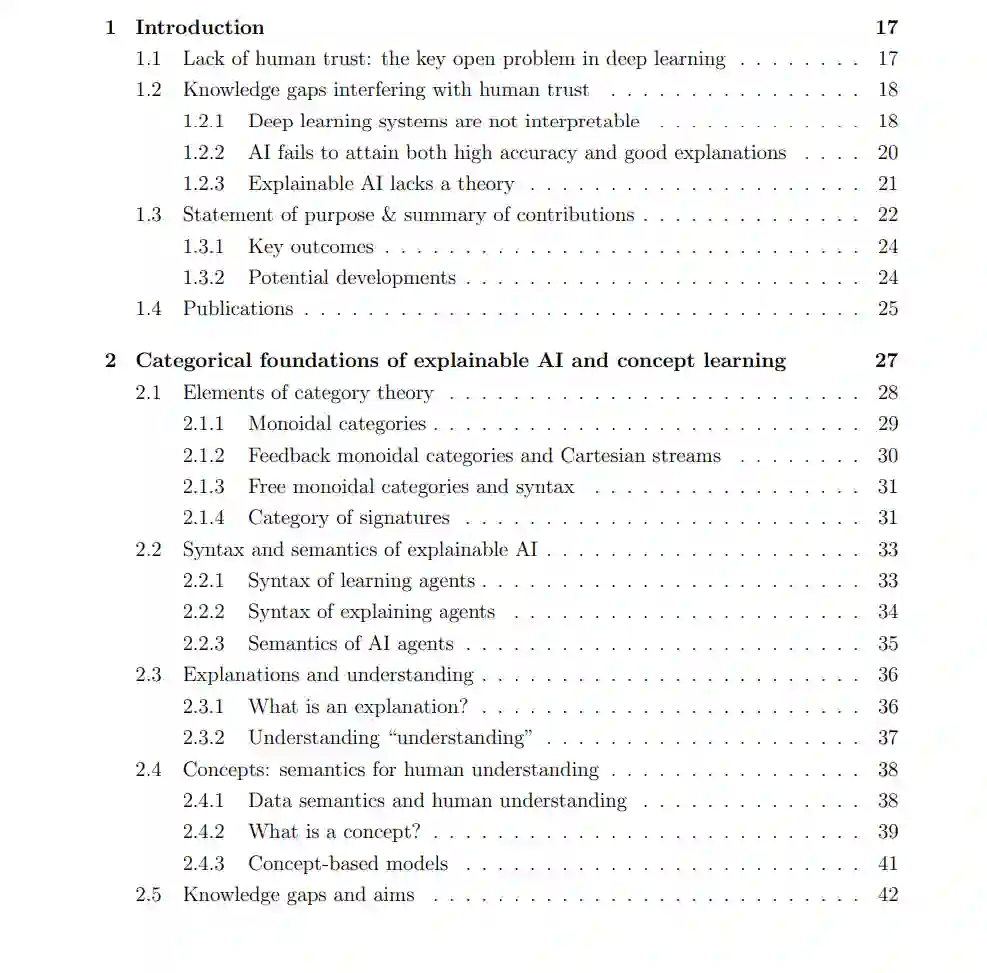

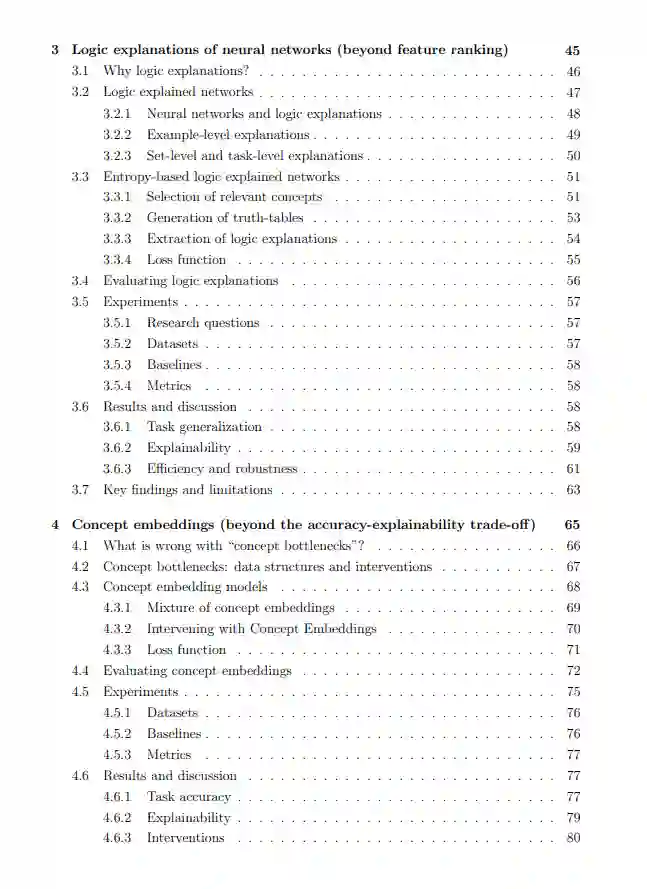

这篇论文包括四项研究工作,旨在解决这些挑战。第一项工作解决了可解释AI的正式理论的缺乏。这项工作提出了第一个关于可解释AI和概念学习的理论,它正式化了该领域使用的一些基本观念。本章的关键创新是使用范畴结构来正式化可解释AI的概念和过程。特别值得注意的是使用范畴理论,因为它提供了一个健全和抽象的形式主义,用于检查一般结构和结构系统,避免偶然的细节,并专注于它们的基本本质。这个理论基础为论文中的其他章节提供了坚实的基础。第二项工作旨在克服当前可解释AI技术提供事后、定性和局部解释的局限性。

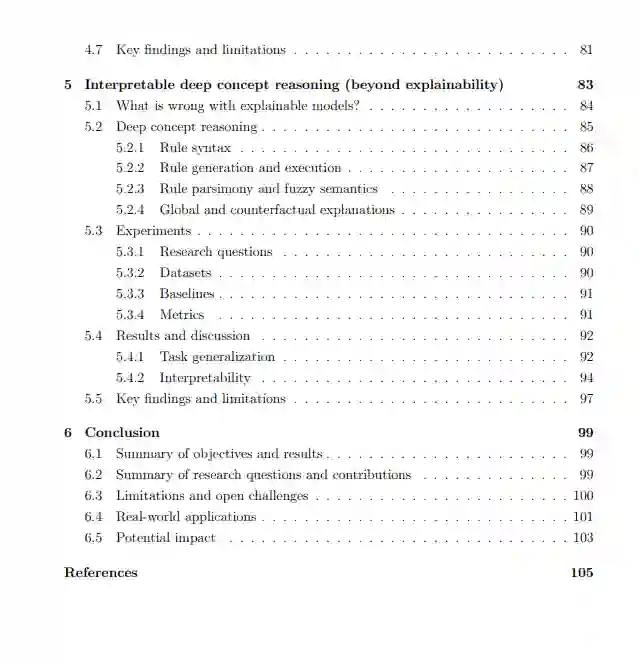

为此,该研究提出了逻辑解释网络,这是一种新型的基于概念的模型,可以同时解决和解释分类问题。逻辑解释网络的关键创新是一个稀疏注意力层,选择神经概念模型中最相关的概念。这样,模型学会生成简单的逻辑解释。第三项工作解决了准确性与解释性的权衡,这是基于概念的模型的主要局限性。为了解决这个问题,这项研究提出了概念嵌入模型。概念嵌入模型的关键创新是一个完全监督的高维概念表示。高维表示使概念嵌入模型克服了信息瓶颈,使它们在不牺牲模型透明度的情况下达到了最先进的准确性。第四项工作解决了概念嵌入模型的局限性,它们无法为其预测提供基于概念的逻辑解释。为了填补这一空白,这项研究提出了深度概念推理器,这是使用概念嵌入的第一个可解释的基于概念的模型。深度概念推理器的关键创新是使用神经网络生成可解释的规则,这些规则在符号层面上执行以进行任务预测。这使得深度概念推理器在复杂任务中达到了最先进的性能,并为其预测提供了人类可以理解且正式的解释。

总体上,这篇论文通过引入第一个关于可解释AI的正式理论,并展示了超越当前准确性与解释性权衡的新型深度学习技术,做出了重要贡献。实验结果展示了这些创新如何导致了一代既透明又准确的深度学习架构。引入这些新技术为增加深度学习的透明度和可信度奠定了基础,使得稳健且可控的机器学习代理的安全部署成为可能。