深度学习已经彻底改变了科学研究,并被用于在越来越复杂的场景中做出决策。随着强大的能力的增长,对透明度和可解释性的需求也在增长。可解释人工智能领域旨在为AI系统的预测提供解释。然而,AI可解释性的最新进展远未令人满意。

例如,在计算机视觉中,最著名的事后解释方法生成像素级的热图,覆盖在输入域上,旨在可视化图像或视频的单个像素的重要性。我们认为,这种密集的归因图对非专家用户来说解释性较差,因为解释形成的领域——我们可能在热图中识别出形状,但它们只是像素的斑点。事实上,输入域更接近于数码相机的原始数据,而不是人类用来交流的可解释结构,例如物体或概念。

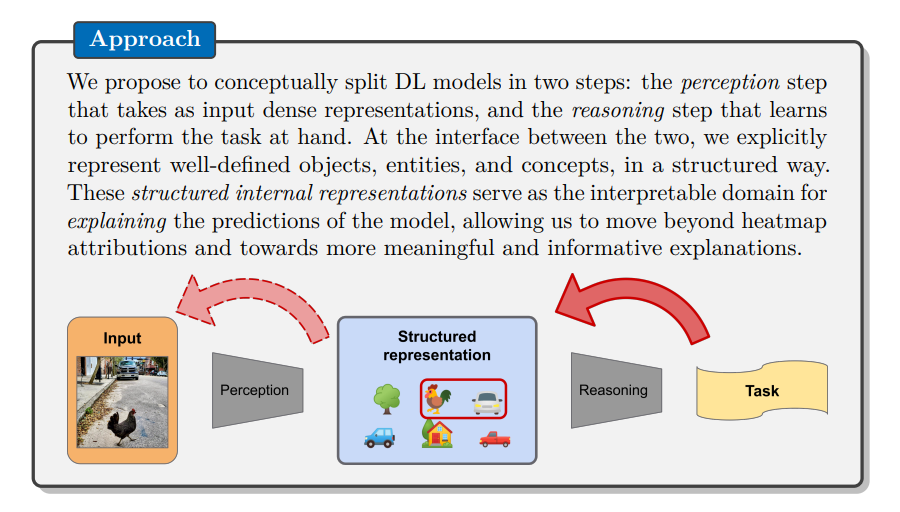

在这篇论文中,我们提出超越密集特征归因,通过采用结构化内部表示作为更可解释的解释域。从概念上讲,我们的方法将深度学习模型分为两部分:感知步骤,输入密集表示;推理步骤,学习执行手头任务。两者之间的接口是对应于明确定义的物体、实体和概念的结构化表示。这些表示作为解释模型预测的可解释域,使我们能够朝着更有意义和信息丰富的解释迈进。

提出的方法引入了几个挑战,比如如何获得结构化表示,如何将它们用于下游任务,以及如何评估结果解释。本论文包含的工作解决了这些问题,验证了方法并为该领域提供了具体贡献。在感知步骤中,我们探讨了如何从密集表示中获得结构化表示,无论是通过使用领域知识手动设计它们,还是通过无监督地从数据中学习它们。在推理步骤中,我们探讨了如何将结构化表示用于从生物学到计算机视觉的下游任务,以及如何评估学到的表示。在解释步骤中,我们探讨了如何解释在结构化域中运作的模型的预测,以及如何评估结果解释。总的来说,我们希望这项工作能激发对可解释AI的进一步研究,并帮助弥合高性能深度学习模型与现实世界应用中对透明度和可解释性需求之间的差距。

人工智能系统在商业、科学和社会的各个领域得到了广泛应用。特别是由于性能的快速提升,深度学习模型现在能够在复杂场景中支持甚至取代人类专家。然而,强大的能力伴随着巨大的责任,人工智能(AI)的日益普及引发了对透明度和可解释性的增长需求。确实,使用高精度检测癌症很有用,但AI医生必须能够向患者解释其诊断,并与其他医生合作。同样,一家公司可能开发了一个用于自动驾驶的杰出系统,但在公共道路上部署之前,需要说服监管机构其行为是安全且可预测的。 透明度、解释和可解释性是可解释人工智能(XAI)的重点。尽管在理解深度学习模型和解释其决策方面取得了重大进展,但XAI的最新状态远未令人满意。例如,计算机视觉中最著名的解释方法产生的热图被叠加到图像或视频上,以突出重要区域。我们称之为密集特征归因的这种可视化类型,对模型识别什么(纹理、部分、物体等)和如何推理(属性、关系等)提供的洞察很少。我们将这种局限性归因于解释形成的领域。实际上,对于大多数深度学习模型,解释域与输入域相对应,它更接近于感官数据(例如原始像素),而不是人类用于推理和交流的可解释结构(例如物体或概念)。 本论文的目标是超越密集特征归因,转而采用结构化表示作为更可解释的解释域。我们通过分离感知步骤(将密集输入转换为结构化表示)和推理步骤(使用结构化表示进行预测)来实现这一目标。这种分离使我们能够就结构化表示解释预测,这比密集输入更具可解释性。 在这个引言章节中,我们对我们的方法进行了背景阐述:第1.1节提供了可解释人工智能的介绍,包括其概念和需求;第1.2节描述了表示方法,无论是密集的还是结构化的,在解释深度学习模型中的作用。最后,第1.3节对提出的方法进行了正式阐述,并概述了本论文各章节中的发展情况。