摘要——图上的分布偏移,即训练和使用图机器学习模型时数据分布之间的差异,在现实场景中普遍存在且常常不可避免。这些分布偏移可能会严重削弱模型性能,给可靠的图机器学习带来重大挑战。因此,针对分布偏移下的图机器学习研究激增,旨在训练模型在分布外(OOD)测试数据上实现令人满意的表现。在本综述中,我们提供了关于分布偏移下深度图学习的最新且具有前瞻性的回顾。具体而言,我们涵盖了三个主要场景:图的OOD泛化、训练阶段的图OOD自适应,以及测试阶段的图OOD自适应。我们首先对问题进行正式表述,并讨论可能影响图学习的各种分布偏移类型,如协变量偏移和概念偏移。为便于理解相关文献,我们基于提出的分类法系统地对现有模型进行分类,并研究其背后的技术方法。此外,我们还总结了该研究领域中常用的数据集,以便于进一步探索。最后,我们指出了一些有前景的研究方向及其相应的挑战,以推动这一重要领域的进一步研究。此外,我们在 https://github.com/kaize0409/Awesome-Graph-OOD 上提供了持续更新的阅读列表。

关键词——图学习,分布偏移,图的分布外泛化,图的分布外自适应。

1 引言

受图结构数据在众多实际场景中普遍存在的驱动,图机器学习逐渐获得了越来越多的关注,因为它能够有效地捕获图中实体之间的关系与依赖性。尤其是图神经网络(Graph Neural Networks, GNNs)通过消息传递机制[1], [2], [3],在图上进行表示学习,已在社交网络、物理问题和交通网络等多个应用领域展现了显著成效[4], [5], [6]。

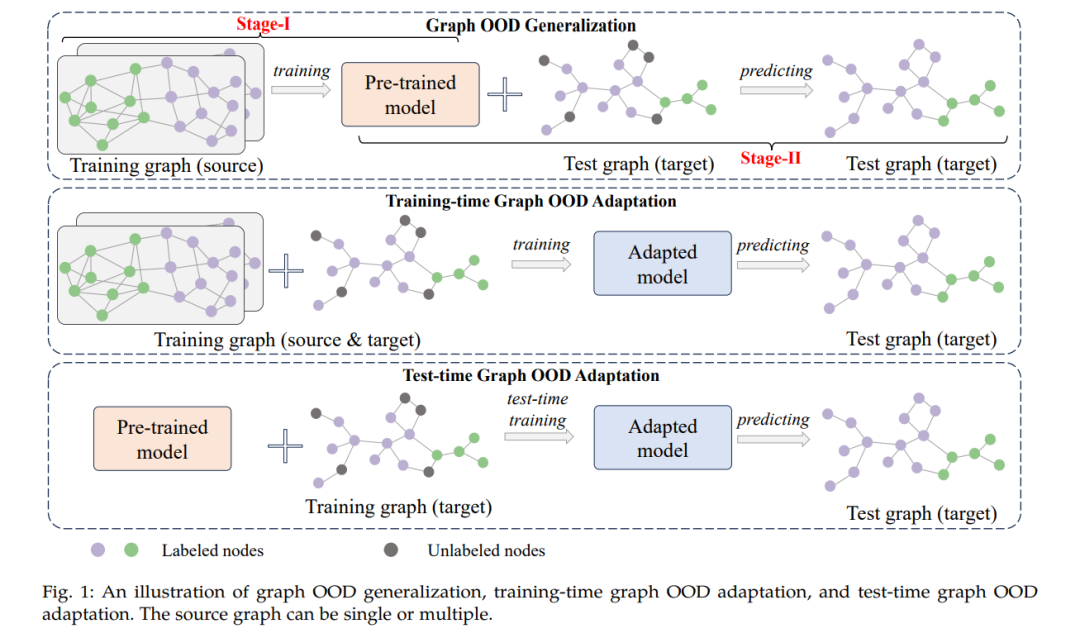

尽管图机器学习取得了显著的成功,但大多数现有方法假设测试数据的分布与训练数据相同,而这种假设在真实环境中往往不成立。当面对分布外(Out-of-Distribution, OOD)样本时,图机器学习方法的性能可能大幅下降,限制了其在金融和医疗等高风险图应用中的有效性[7]。尽管已有众多迁移学习方法被提出以应对欧几里得数据的分布偏移[8], [9], [10],但直接将这些方法应用于图数据存在挑战。这是由于图中的实体是相互关联的,违背了传统迁移学习方法中独立同分布(IID)假设。此外,各类图分布偏移带来了新的挑战。这些偏移存在于特征、结构和标签等不同模态中,表现形式多种多样,包括图大小、子图密度和同质性等的变化[11]。鉴于这些障碍,越来越多的研究致力于提高图机器学习在分布偏移下的可靠性,主要集中在三个场景:图的OOD泛化[7], [11]、训练阶段的图OOD自适应[12], [13],以及测试阶段的图OOD自适应[14], [15]。

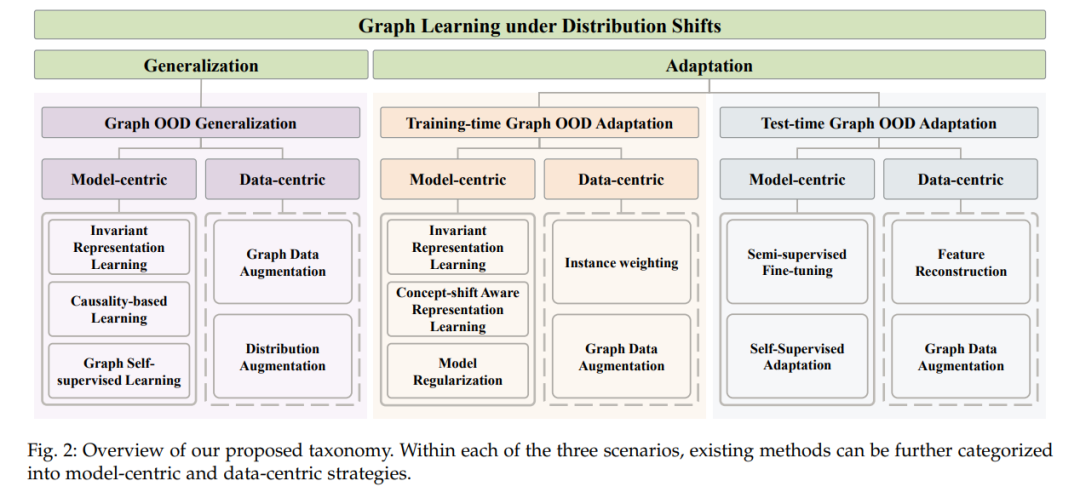

图的OOD泛化与自适应方法的主要区别在于对目标数据可用性的假设。图的OOD泛化方法通常假设在模型训练过程中目标数据不可用,旨在提升模型对任何潜在未见测试分布的泛化能力。相反,训练阶段和测试阶段的自适应方法则假设目标数据可用,目标是提高模型在该特定目标上的表现。然而,两者在对源数据的假设和如何利用源分布知识方面有所不同。训练阶段的自适应假设源图和目标图同时可用,使得模型可以从头开始在训练过程中进行适应;而测试阶段的自适应通常假设访问的是预先在源图上训练好的模型,而非源图本身,然后从该预训练状态开始适应目标数据。尽管图的OOD泛化、训练阶段的OOD自适应和测试阶段的OOD自适应密切相关,但目前尚无统一的框架能够全面探讨这三个场景下的深度图学习在分布偏移下的表现。 随着图OOD学习领域的最新进展,对该领域的最新且具有前瞻性的回顾显得尤为必要。在本综述中,我们提供了据我们所知的第一个关于分布偏移下深度图学习的统一、系统性的文献回顾。我们首先对问题进行正式表述,讨论图机器学习中不同类型的图分布偏移。接着,我们提出了新的分类法,将现有方法根据模型学习场景分为三类:(1) 图的OOD泛化,通过对源数据训练时的模型设计提升泛化能力;(2) 训练阶段的图OOD自适应,通过基于源数据和目标数据的联合训练实现适应[16], [17];(3) 测试阶段的图OOD自适应,通过将预训练源模型调整至目标数据进行适应[18], [19]。

为了加深对这些方法的理解,我们进一步将每类中的现有方法分为模型中心和数据中心策略。模型中心的方法关注于学习过程或图模型架构本身,通过优化模型结构、训练目标或学习机制来增强模型在分布偏移下的泛化或适应能力。相比之下,数据中心的方法强调对输入图的处理,通过预处理技术或数据增强策略直接提升模型性能。在每个研究子方向中,我们详细介绍了在图分布偏移下提升泛化性或适应性的技术。此外,我们总结了该研究领域使用的数据集,着重介绍了它们的特征以及与分布偏移挑战的相关性。基于图OOD学习的当前进展,本文最后指出了该领域中一些有前景的研究方向及相应的挑战。

与现有综述的差异

尽管图学习在分布偏移下急需概览,但现有综述主要聚焦于该领域内的某些子领域,而未能从多场景的角度提供全面的概述。目前已有一些相关领域的综述,但其关注点各不相同,包括图的OOD泛化[7], [20]、图域适应[21], [22]、分布偏移相关的可信图学习[23]。本综述的不同之处体现在以下方面:(1) 主要关注点。我们的综述重点是分布偏移下图学习的挑战和解决方案,而[23]从可信性的角度分析了OOD问题,但未深入探讨方法学层面。相反,[20]从因果视角审视图机器学习,范围较我们广泛探讨的角度更为狭窄。(2) 分类法。我们提供了现有方法的全面分类并对其进行了总结,而相关工作如[24]则缺少类似总结。其他综述如[21]和[22]主要聚焦于域适应,未涉及更广泛的图OOD学习。此外,我们还涵盖了该领域最新进展及讨论。

综述结构

本综述的总体结构如下:第2节介绍符号和预备知识。第3、4和5节分别回顾图的OOD泛化、训练阶段的图OOD自适应以及测试阶段的图OOD自适应。每节在相应场景下讨论模型中心和数据中心方法,并详细介绍每类方法的相关技术。此外,第6节对文献中使用的数据集进行了全面总结,重点介绍了常用的图数据集及其与分布偏移挑战的相关性。第7节探讨了该领域中有前景的未来研究方向及相关挑战。最后,第8节总结了本综述的内容。

正如问题定义所示,图的OOD泛化、训练阶段图的OOD自适应和测试阶段图的OOD自适应在模型学习场景上存在显著差异。具体而言,图的OOD泛化方法假设目标数据不可访问,仅使用源数据;训练阶段图的OOD自适应方法同时涉及源数据和目标数据,并从零开始训练模型,而测试阶段图的OOD自适应方法则假设源数据不可用,旨在将预训练的源模型适应至目标数据。因此,在接下来的三部分中,我们首先将现有方法分类为图的OOD泛化、训练阶段的图OOD自适应和测试阶段的图OOD自适应。在每一部分中,我们进一步将方法细分为模型中心方法和数据中心方法。模型中心方法聚焦于学习过程或图模型的设计,而数据中心方法则侧重于对输入图的处理,例如变换图结构或特征。我们的分类体系如图2所示。