本论文针对机器学习中的关键挑战,重点通过统计工具提高效率和可信性。它探讨了大模型和大数据时代的新兴课题,包括模型压缩、联邦学习和数据隐私。

论文引入了新的模型和训练数据压缩方法,利用率失真理论和为机器学习任务特定设计的新型编码技术。此外,还提出了新的联邦学习框架,以在降低通信成本的同时保持甚至提高准确性和推理效率。这些框架采用了模型更新稀疏化、利用现代模型中的过参数化,以及利用附加信息等策略,实现了在不牺牲性能的前提下大幅减少比特率。

该研究推进了对训练数据处理和分布式均值估计中的压缩-隐私-效用权衡的理解,并提出了新型最优算法,有效地平衡了这些权衡。这些贡献为在增强数据隐私的同时降低通信和存储成本奠定了坚实的理论基础,且不损害效用。

总体而言,本研究通过提出适应这些模型的独特条件、限制和灵活性的解决方案,推进了机器学习系统的发展,最终在多个领域提升了效率和可信性。

机器学习已成功融入各种应用中,如人脸识别、语言处理和自动驾驶。这一成功的一个主要因素是深度神经网络模型日益复杂的过参数化特性。然而,在边缘设备上部署这些过参数化模型具有挑战性,因为这些设备的存储、计算和电源资源有限。这促使了对通过高效训练和微调方法以及模型压缩来实现高效机器学习系统的研究。

另一个推动机器学习发展的重要因素是大量用户数据的可用性——所谓的大数据。随着应用规模的扩大,训练模型所需的数据量也在增加。这催生了对训练数据的高效表示的需求,以便实现大规模存储。幸运的是,训练数据在压缩率显著扭曲其他度量(如图像的均方误差)的情况下,仍然可以保留其在学习任务中的效用。最近的研究方向之一是开发专门用于训练数据的新压缩算法,并利用数据对有损压缩的“抗性”。

在这些模型的训练中对用户数据的需求也带来了隐私问题。当在中央服务器上训练大规模模型时(如谷歌或Meta等公司),用户数据从本地设备传输到中央服务器,这会泄露用户的敏感信息。解决这一问题的一个方法是用户在将数据发送到第三方或服务器之前,通过隐私保护方法对其数据进行扰动。然而,正如前面提到的,用户数据的通信和存储成本很高,因此用户和服务器必须压缩这些受扰动的、可能是噪声的数据。然而,当隐私保护机制和压缩方法天真地独立应用时,预期会降低数据在神经网络训练任务中的效用。因此,理解用户数据的隐私、压缩和效用之间的权衡对于高效的隐私保护数据处理流程至关重要。

同时,在私密且高效地传输用户数据的挑战促使了一种称为联邦学习的分布式学习框架的兴起,在该框架下,用户将数据保留在本地设备上,进行一些本地训练,并仅向服务器传输模型参数的更新。尽管联邦学习在许多方面具有吸引力,但每轮传输模型更新的高通信成本仍然是一个主要挑战。由于模型更新的大小与模型本身一样大,因此必须对其进行压缩以应对过参数化问题。

最近,基础模型已经取代了许多应用中的较小模型,导致高效且可信的机器学习研究发生了范式转变。为了实现这些大型模型的可持续部署,高效的预训练、微调和存储变得比以往更加重要。例如,为较小模型开发的许多模型压缩技术由于复杂性问题而无法扩展到基础模型。这就需要开发新的、复杂性较低的模型压缩技术。此外,由于基础模型是在如此大规模的数据集上训练的,它们解锁了新的能力,并在安全性和可信性方面提出了新的挑战,超出了隐私问题的范畴。因此,高效且可信的机器学习的研究已经转向解决这些由大型模型带来的新问题。

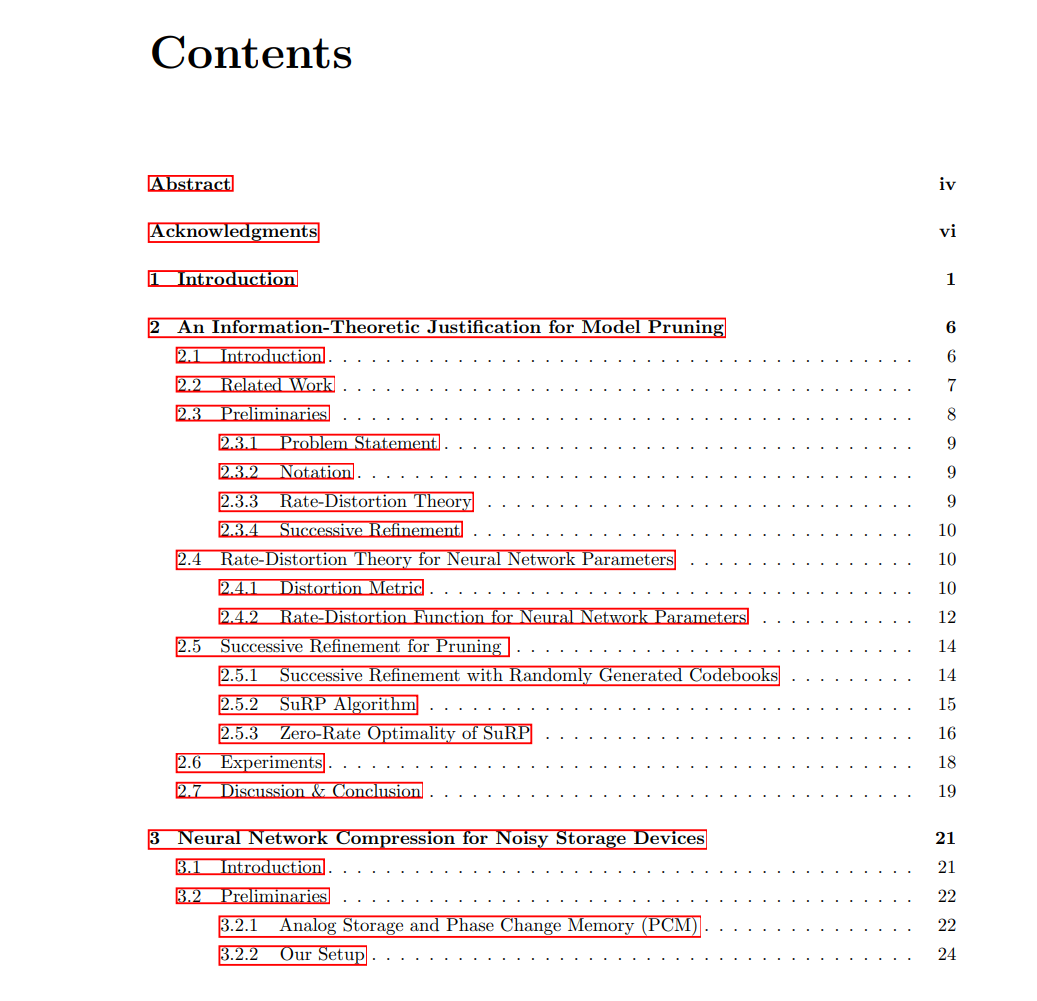

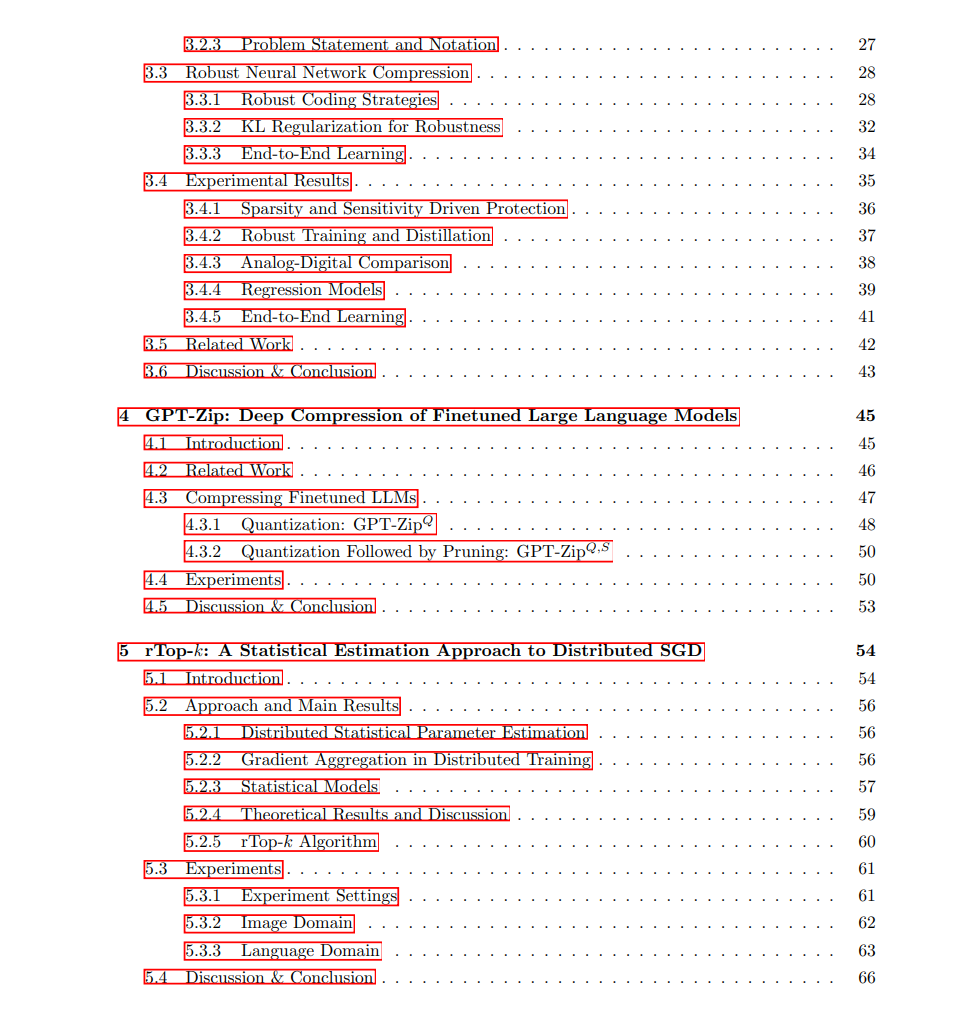

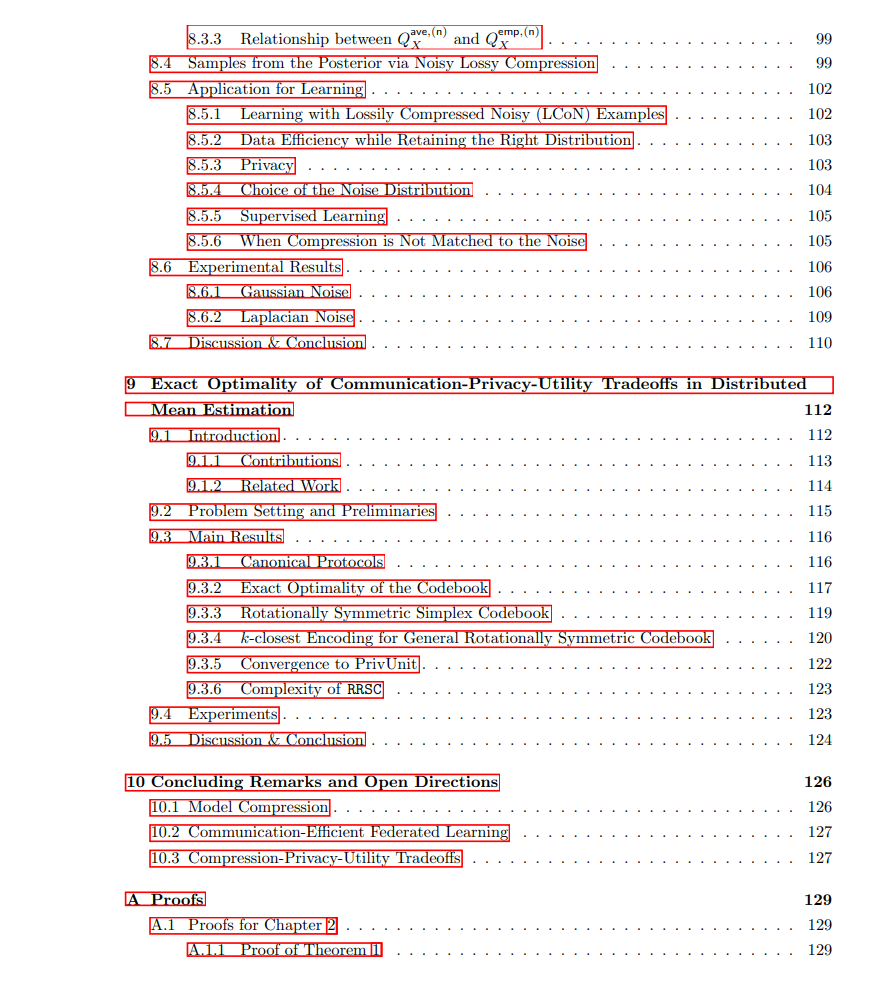

在本论文中,我描述了我的博士研究工作,涵盖了上述高效且可信的机器学习问题。以下是内容的简要概述: 1. 第2章:模型剪枝的信息论依据

本章描述了与Albert No和Tsachy Weissman合作的工作。我们通过率失真理论研究了模型压缩问题,分析了压缩比和模型性能之间的关系。我们选择了一种反映模型压缩对模型输出影响的失真度量,并推导了压缩率与失真的权衡。除了描述模型压缩的理论极限外,这一公式化还表明剪枝(无论是隐式的还是显式的)必须是一个好的压缩算法的一部分。最终,我们提出了一种基于信息论的剪枝策略,并证明其性能优于相关基准。 1. 第3章:用于噪声存储设备的神经网络压缩

本章描述了与Kristy Choi、Xin Zheng、Tsachy Weissman、Stefano Ermon、Philip Wong和Armin Alaghi合作的工作。尽管模型压缩取得了显著进展,但对模型参数的实际物理存储的研究相对较少。我们研究了模拟存储设备作为数字媒体的替代方案,并开发了用于在模拟设备上存储模型权重的多种鲁棒编码策略,并提出了一种联合优化模型压缩和存储资源分配的方法。 1. 第4章:GPT-Zip:微调大语言模型的深度压缩

本章描述了与Hermann Kumbong、Wanyi Ning、Xiaozhe Yao、Sanmi Koyejo和Ce Zhang合作的工作。我们提出了GPT-Zip,用于微调后模型的压缩。GPT-Zip通过量化和稀疏化技术,利用微调模型与预训练基础模型的接近性,显著减少了存储成本。 1. 第5章:rTop-k:分布式SGD的统计估计方法

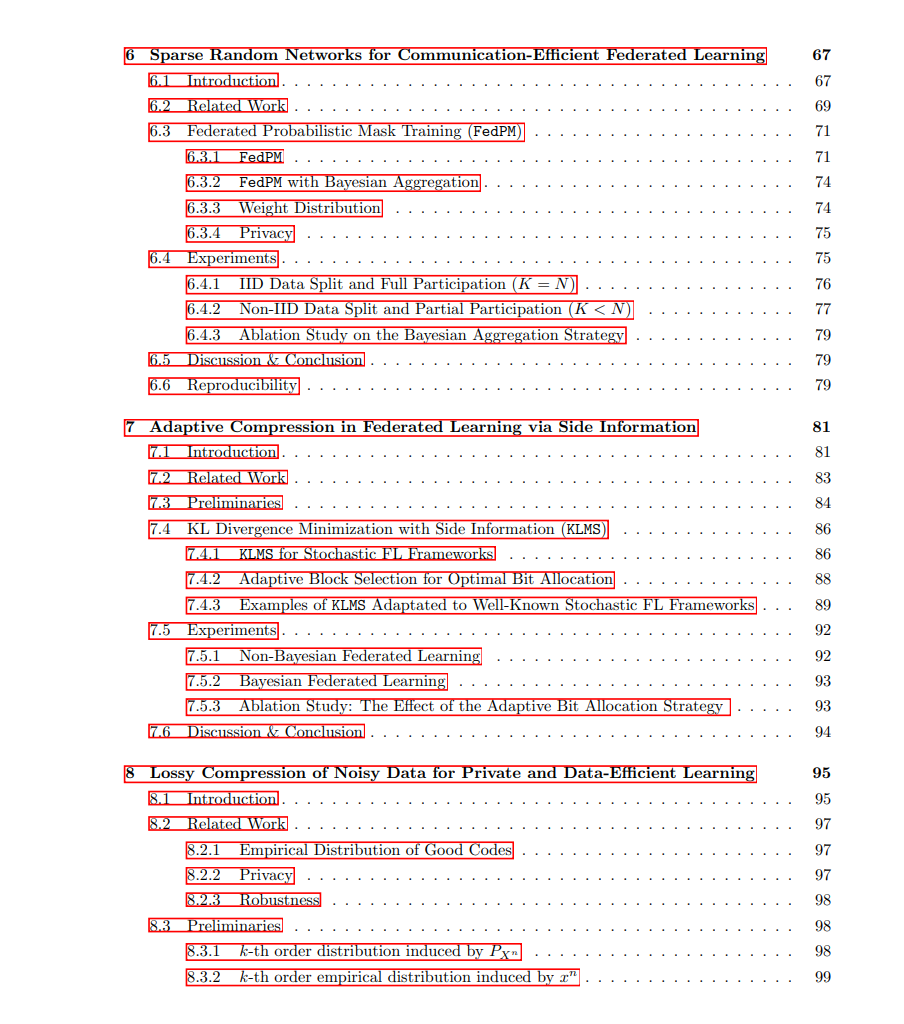

本章描述了与Leighton Pate Barnes、Huseyin Inan和Ayfer Ozgur合作的工作。我们提出了一种新的稀疏化技术,通过结合随机-k和top-k方法,显著降低了分布式SGD中的通信成本。 1. 第6章:用于高效通信的稀疏随机网络在联邦学习中的应用

本章描述了与Francesco Pase、Deniz Gunduz、Tsachy Weissman和Michele Zorzi合作的工作。我们提出了一种冻结初始随机权重,并训练稀疏随机网络以提高性能的新方法,在低比特率条件下展示了显著的改进。 1. 第7章:通过附加信息实现的联邦学习中的自适应压缩

本章描述了与Francesco Pase、Deniz Gunduz、Sanmi Koyejo、Tsachy Weissman和Michele Zorzi合作的工作。我们提出了一种框架,利用服务器上的全局分布信息,显著减少了通信成本。 1. 第8章:用于隐私保护和数据高效学习的有损压缩

本章描述了与Tsachy Weissman合作的工作。我们提出了一种通过噪声注入和有损压缩来减少用户数据存储成本并提供隐私保障的框架。 1. 第9章:分布式均值估计中的通信-隐私-效用权衡的精确最优性

本章描述了与Wei-Ning Chen、Ayfer Ozgur、Tsachy Weissman和Albert No合作的工作。我们研究了在通信和本地差分隐私约束下的均值估计问题,并提出了满足精确最优性的随机旋转单纯形编码方案。