可信任机器学习,34页ppt

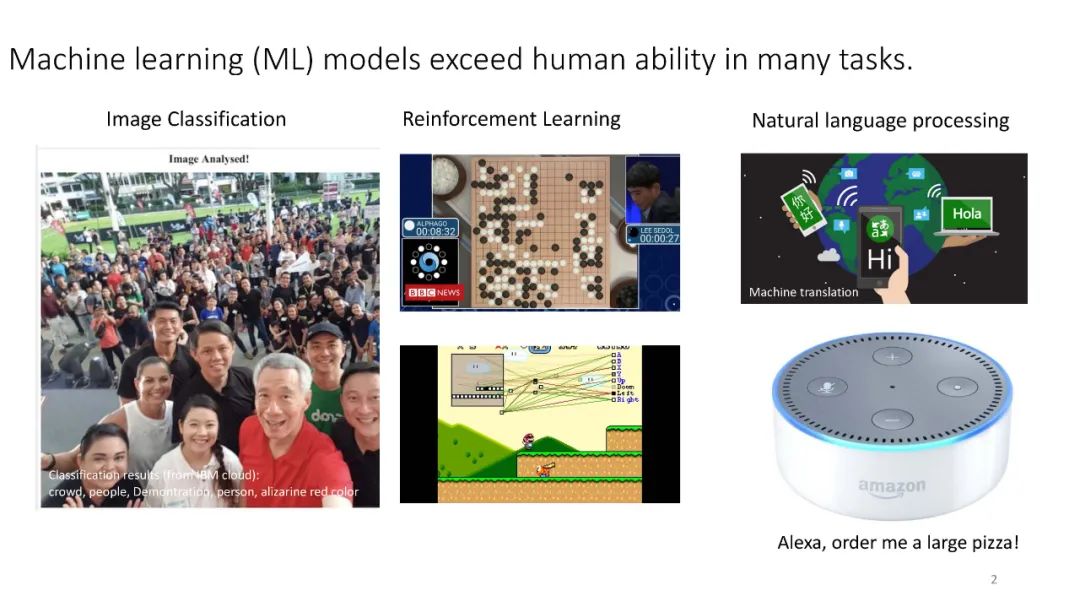

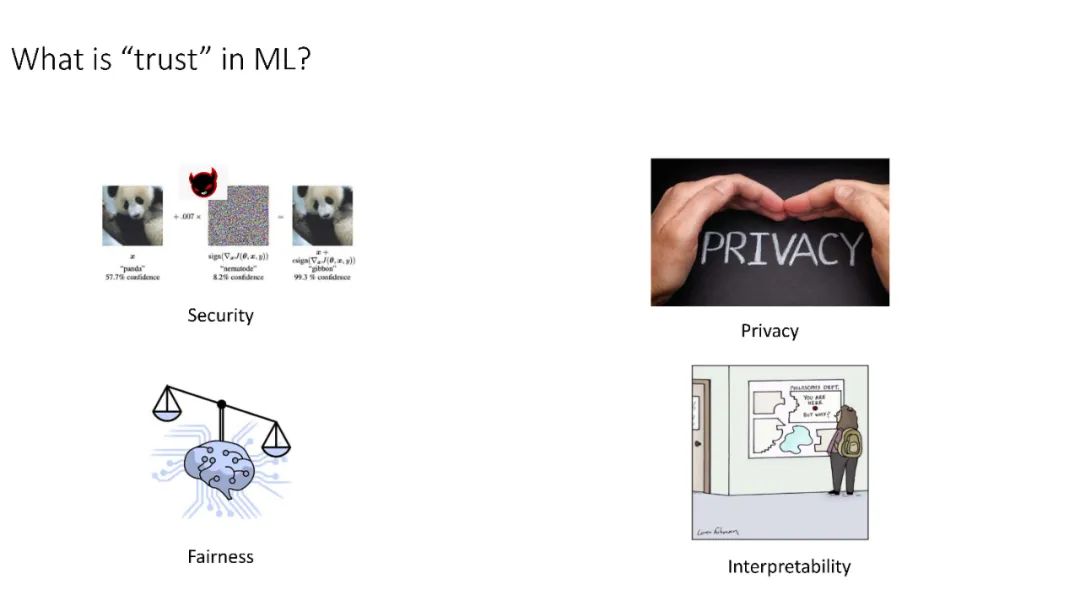

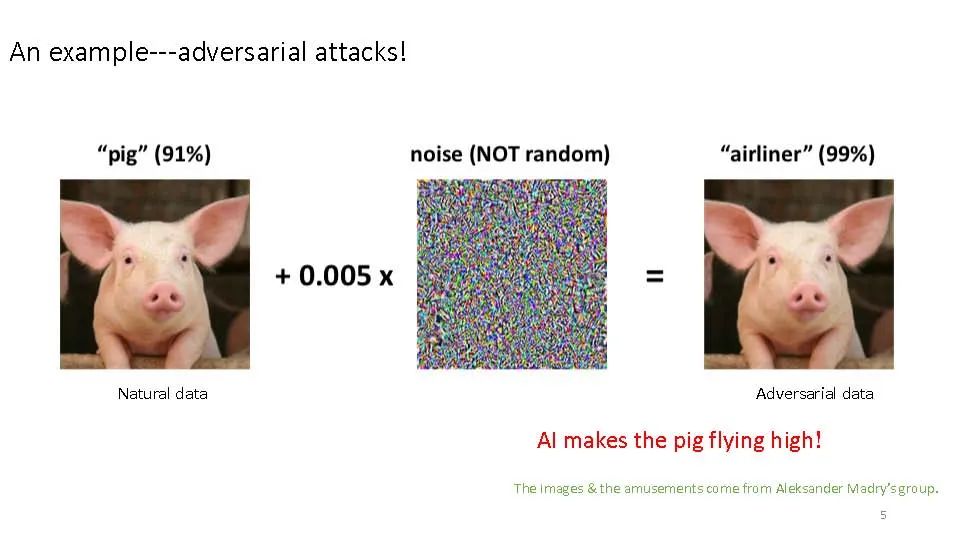

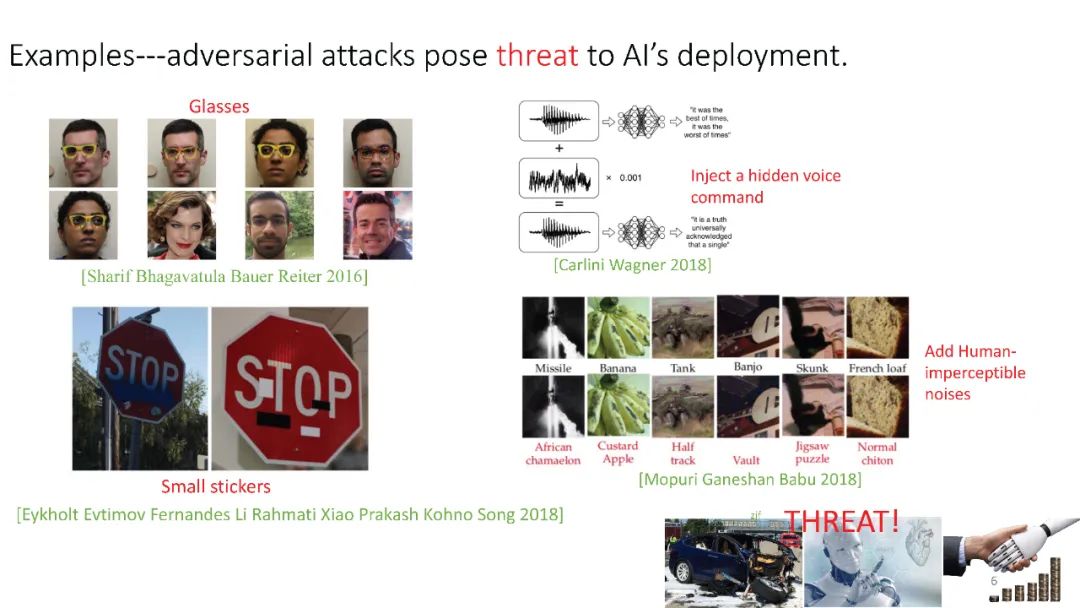

教育评估、信贷、就业、医疗保健和刑事司法等高风险应用的决策越来越受到数据驱动,并由机器学习模型支持。机器学习模型也使关键的信息物理系统,如自动驾驶汽车和机器人手术成为可能。在过去的几年里,机器学习领域取得了惊人的进展。然而,即使这些技术越来越多地融入我们的生活,记者、活动家和学者仍发现了一些侵蚀这些系统可信度的特征。例如,据报道,一个支持法官审前拘留决定的机器学习模型对黑人被告存在偏见。同样,据报道,一个支持在一家大型科技公司进行简历筛选的模型也对女性有偏见。研究表明,用于胸部x光片疾病计算机辅助诊断的机器学习模型更重视图像中的标记,而不是患者的解剖细节。自动驾驶汽车的死亡事故发生在不同寻常的条件下,根本的机器学习算法没有经过训练。简而言之,虽然每天都有机器学习算法在某些任务上取得超人成绩的新故事,但这些惊人的结果只是在一般情况下。我们在所有情况下信任这些算法所需要的可靠性、安全性和透明度仍然是难以捉摸的。因此,越来越多的人希望在这些系统中拥有更多的公平性、健壮性、可解释性和透明度。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“T34” 就可以获取《可信任机器学习,34页ppt》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2023年1月31日

Arxiv

0+阅读 · 2023年1月31日