人工智能为我们提供了自动化任务的能力,从海量数据中提取信息,并合成几乎与真实事物无异的媒体。然而,积极的工具也可以被用于消极的目的。特别是,网络对手可以利用人工智能来加强他们的攻击和扩大他们的活动。虽然攻击性人工智能在过去已经被讨论过,但有必要在组织的背景下分析和理解这种威胁。例如,一个具有人工智能能力的对手是如何影响网络杀伤链的?人工智能是否比防御者更有利于攻击者?今天组织面临的最重要的人工智能威胁是什么,它们对未来的影响是什么?在这项研究中,我们探讨了攻击性人工智能对组织的威胁。首先,我们介绍了背景,并讨论了人工智能如何改变对手的方法、策略、目标和整体攻击模式。然后,通过文献回顾,我们确定了32种攻击性人工智能能力,对手可以利用这些能力来加强他们的攻击。最后,通过横跨工业界、政府和学术界的小组调查,我们对人工智能威胁进行了排名,并提供了对攻击者的洞察力。

引言

几十年来,包括政府机构、医院和金融机构在内的组织一直是网络攻击的目标[1, 2, 3]。这些网络攻击都是由有经验的黑客使用人工方法进行的。近年来,人工智能(AI)的发展蓬勃发展,这使得软件工具的创造有助于实现预测、信息检索和媒体合成等任务的自动化。在整个这一时期,学术界和工业界的成员在改善网络防御[4, 5, 6]和威胁分析[7, 8, 9]的情况下利用了人工智能。然而,人工智能是一把双刃剑,攻击者可以利用它来改善他们的恶意活动。

因此,我们将攻击性人工智能定义为:“使用或滥用人工智能来完成恶意的任务”。

对人工智能的攻击性使用。敌人可以改进他们的战术,发动以前不可能的攻击。例如,通过深度学习,人们可以通过冒充其雇主的脸和声音来进行高效的鱼叉式网络钓鱼攻击[10, 11]。还可以通过使攻击在没有人类监督和帮助的情况下进行(使其自动进行)来提高攻击的隐蔽能力。例如,如果恶意软件可以自行对网络中的主机进行渐进式感染(又称横向移动),那么这将减少指挥和控制(C&C)通信[12, 13]。其他能力包括使用人工智能寻找软件中的零日漏洞,自动进行逆向工程,有效地利用侧面渠道,建立逼真的假人物,并进行更多的恶意活动,提高功效(更多的例子将在后面第3节中介绍)。

对人工智能的攻击性滥用。对抗性机器学习是对人工智能的安全漏洞的研究。已经证明,对手可以通过制作训练样本来改变模型的功能,例如插入后门[14],通过操纵测试样本(例如逃避检测)来获得所需的分类[15],甚至推断出模型[16]或其训练数据的机密信息[17]。由于组织使用人工智能来自动管理、维护、操作和防御他们的系统和服务,因此敌方可以通过在这些系统上使用机器学习来完成他们的恶意目标。 我们注意到,有些攻击是可以不使用或滥用人工智能而实现的。然而,如果攻击者使用人工智能使其自动或半自动运行,他们可以大大减少执行攻击所需的工作。通过减少他们在创建有效策略方面的工作,攻击者可以通过扩大攻击的强度和数量来最大化他们的回报。此外,通过在攻击链的几个阶段同时行动,攻击者可以在攻击的速度和力量上实现协同效应,变得更加危险。另一方面,一些攻击已经被人工智能实现,例如在复杂的社会工程攻击中克隆个人的声音[18]。

1.1 研究综述

在这项工作中,我们对企业安全背景下的攻击性人工智能知识进行了研究。本文的目标是帮助行业界(1)更好地了解攻击性人工智能对组织的当前影响,(2)优先研究和开发防御性解决方案,以及(3)确定在不久的将来可能出现的趋势。这项工作并不是第一次提高对攻击性人工智能的认识。在[19]中,作者警告行业界,人工智能可以被用于不道德的和犯罪的目的,并列举了来自不同领域的例子。在[20]中,举行了一个研讨会,试图确定人工智能在犯罪学中的潜在首要威胁。然而,这两项工作都涉及到了人工智能对社会整体的威胁,而不是专门针对组织及其网络。此外,尽管他们做出了大量工作并取得了初步成果,但这些先前的分析只提供了人工智能如何被用于攻击的例子以及对其风险的可能排序,而我们的研究通过用于识别针对组织的潜在攻击策略的标准方法,给出了攻击性人工智能的结构化观点,得出了与防御这些威胁有关的战略见解。

为了实现这些目标,我们进行了一次文献回顾,以确定具有人工智能能力的对手能力。然后我们进行了一项小组调查,以确定这些能力中哪些代表了实践中最相关的威胁。有35名调查参与者:16名来自学术界,19名来自工业界。来自工业界的参与者来自广泛的组织,如MITRE、IBM、微软、谷歌、空中客车、博世、富士通、日立和华为。

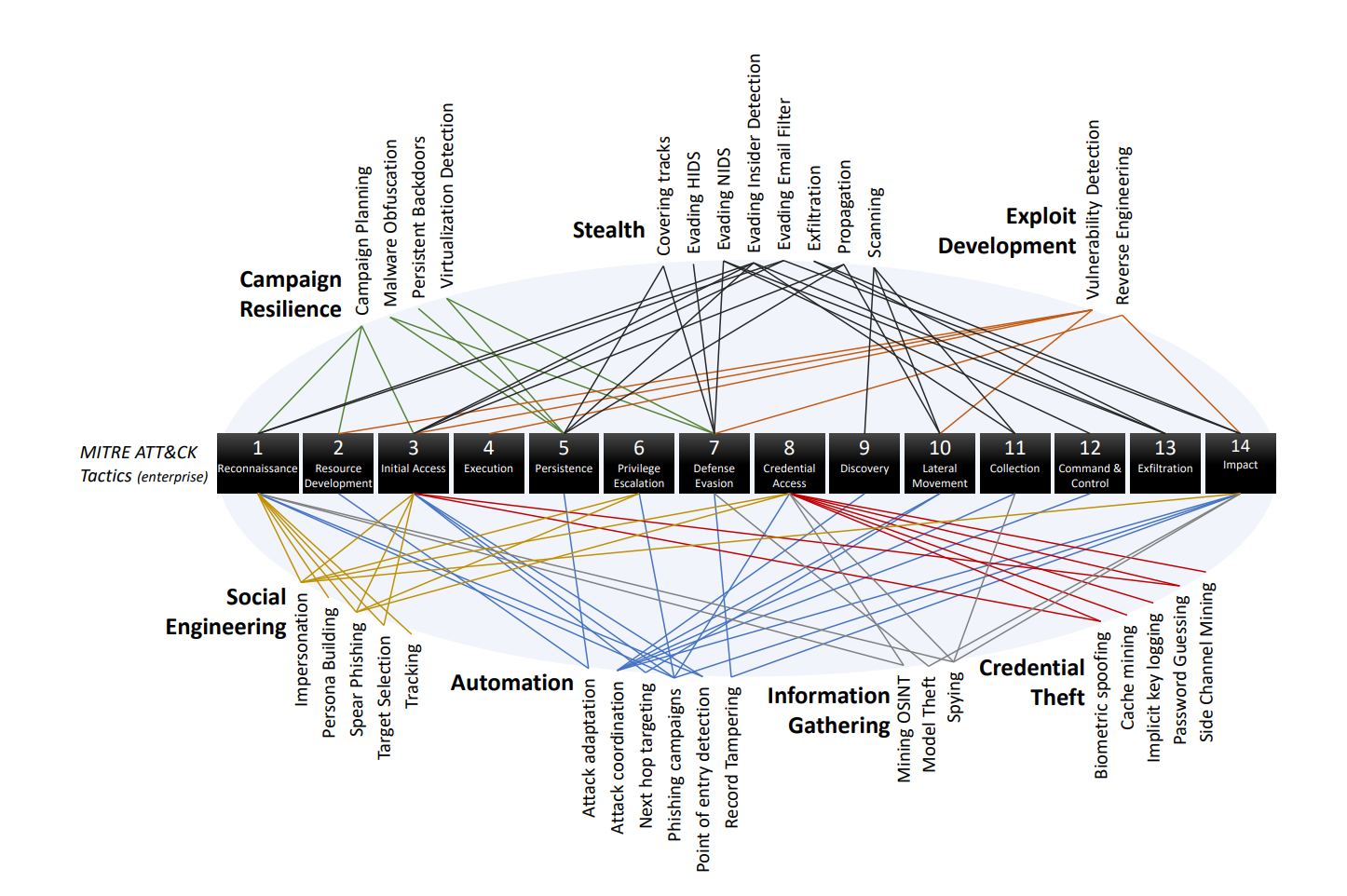

从我们的文献回顾中,我们发现了32种针对组织的攻击性人工智能能力。我们的小组调查显示,最重要的威胁是改善社会工程攻击的能力(例如,使用深层假象来克隆员工的声音)。我们还发现,行业成员最关心的是使攻击者能够窃取知识产权和检测其软件中的漏洞的攻击。最后,我们还发现,现代攻击性人工智能主要影响网络杀伤链的初始步骤(侦查、资源开发和初始访问)。这是因为人工智能技术还不够成熟,无法创造出能够在没有人类监督和帮助下进行攻击的智能体。我们的研究结果的完整清单可以在第5.1节找到。

1.2 本文贡献

在这项研究中,我们做出了以下贡献:

- 概述了人工智能如何被用来攻击组织及其对网络杀伤链的影响(第2.3节)。

- 根据文献回顾和当前事件,列举和描述了32种威胁组织的攻击性人工智能能力(第3节)。这些能力可分为:(1)自动化,(2)活动弹性,(3)凭证盗窃,(4)漏洞开发,(5)信息收集,(6)社会工程,以及(7)隐身。

- 根据对来自学术界、工业界和政府的成员进行的小组调查,对攻击性人工智能如何影响组织提出了威胁排名和见解(第4节)。

- 对人工智能威胁的预测以及由此产生的攻击策略的转变(第5节)。

1.3 文章结构

本文的结构如下:

- 第2节为读者提供了关于对理解文献综述很重要的主题入门知识。该部分介绍了关于人工智能、攻击性人工智能的概念,以及攻击性人工智能如何影响组织的安全。

- 第3节提供了在组织安全背景下的攻击性人工智能的文献回顾。

- 第4节介绍了一项小组调查的结果,以帮助确定攻击性人工智能对组织的最小和最重要的威胁。

- 第5节总结了研究发现,并提供了对问题的看法。

图 1:文献综述中确定的 32 种进攻性 AI 能力 (OAC)。