具身AI系统,包括机器人和自动驾驶车辆,正越来越多地应用于现实世界的场景中,在这些场景中,它们面临着来自环境和系统层面的多种脆弱性。这些脆弱性通过传感器欺骗、对抗攻击以及任务与运动规划的失败等方式表现出来,给稳健性和安全性带来了重大挑战。尽管相关研究日益增多,但现有的综述文章很少专门关注具身AI系统的独特安全与安全性挑战。大多数前期工作要么讨论的是一般性的AI脆弱性,要么关注某些孤立的方面,缺乏一个专门且统一的框架来针对具身AI进行研究。本综述填补了这一关键空白,具体通过以下几方面进行阐述:(1) 将具身AI特有的脆弱性划分为外源性(例如,物理攻击、网络安全威胁)和内源性(例如,传感器故障、软件缺陷)两大类;(2) 系统地分析具身AI中特有的对抗攻击范式,重点探讨其对感知、决策以及具身交互的影响;(3) 研究针对具身系统中的大规模视觉-语言模型(LVLMs)和大规模语言模型(LLMs)的攻击向量,例如越狱攻击和指令误解;(4) 评估具身感知、决策和任务规划算法中的稳健性挑战;(5) 提出针对性的策略,以增强具身AI系统的安全性和可靠性。通过整合这些维度,我们提供了一个全面的框架,用于理解具身AI中脆弱性与安全性之间的相互关系。 附加关键词和短语:大规模视觉语言模型、大规模语言模型、具身AI、对抗攻击。

1 引言

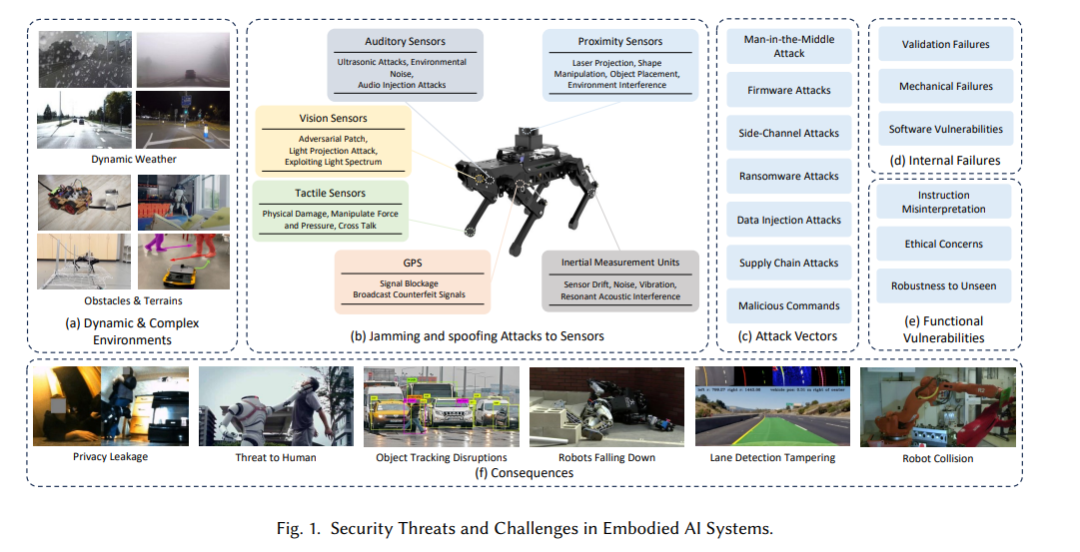

AI的快速发展使得具身AI成为自动驾驶、工业自动化和智能家居等领域的关键技术。通过结合感知、决策和执行,这些系统在处理复杂的现实世界任务方面表现出色。然而,如图1所示,它们对传感器、执行器和算法之间复杂交互的依赖,也使它们暴露于广泛的脆弱性,包括动态复杂的环境、对传感器的干扰和欺骗攻击以及系统故障。这些风险引发了对未经授权操作和声誉损害的担忧,强调了确保它们安全可靠部署的强大安全措施的迫切需求。 我们识别出具身系统稳健性的三个关键特性[27]:自治性、具身性和认知性。自治性指的是系统作出明智、独立决策的能力,使其能够适应动态和不可预测的场景。然而,这种独立性也引入了脆弱性,例如在复杂环境中的决策错误。具身性意味着系统能够与物理环境进行互动,将物理存在与决策过程结合,以实现无缝互动。认知性涵盖了系统理解、推理和解释其行为的能力,确保其行为符合内部目标和外部约束。然而,认知过程也可能通过传感器到模型的攻击或对已学习模型的操控而被利用。 本文的其余部分按系统地讨论具身AI系统中的脆弱性、攻击向量和缓解策略,如图2所示。第二节介绍了具身AI脆弱性的详细分类法,将其分为外源性、内源性和跨维度风险,并进一步探讨了物理攻击(2.1.2)、传感器验证失败(2.2.1)以及互动代理中的伦理挑战(2.3.2)等具体问题。第三节第3.1小节考察了脆弱性与攻击策略之间的关系,包括威胁模型分析(3.2)和详细的攻击分类(3.3),如网络安全威胁(3.4)和传感器欺骗攻击(3.5)。第三节第3.6小节重点讨论了针对大规模语言模型(LLMs)和大规模视觉语言模型(LVLMs)的对抗攻击,突出介绍了基于logits的攻击(3.6.1)、对抗性提示生成(3.6.3)和跨模态攻击(3.6.4)等技术。第四节探讨了具身AI中的挑战和故障模式,包括常见的故障模式(4.2)和算法特有的脆弱性(4.3)。第五节提供了用于评估LLMs和LVLMs的数据集分类法,包括一般数据集(5)、对抗数据集(5)和对齐数据集(5)。最后,第六节总结了关键发现并提出了未来研究的方向。