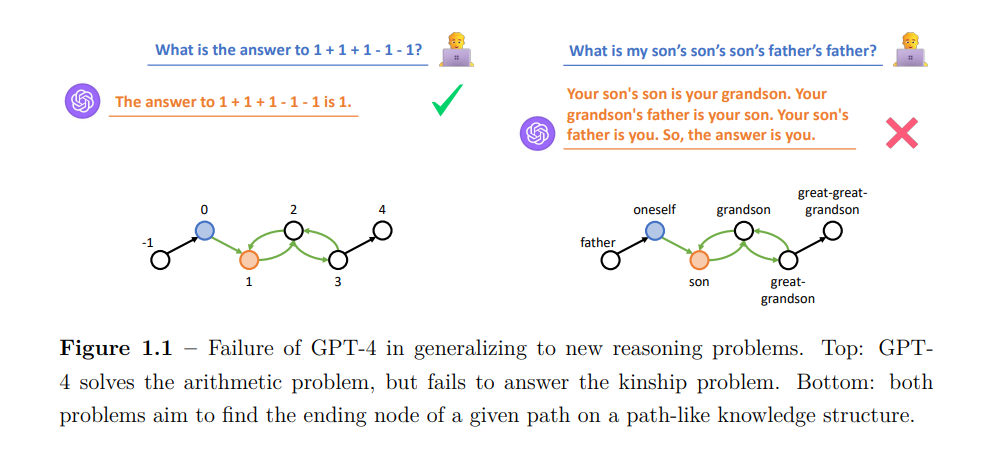

- 跨知识结构的泛化。大多数知识结构随着时间推移而演变,这需要推理模型在同一领域内适应新的知识结构。即使节点和边的语义不同,两个领域的结构也可以相似。特别是,我们研究了能够在不同实体和关系词汇的图之间泛化的模型。

- 跨查询结构的泛化。许多有趣的查询是由多个推理步骤组成的。因此,可能的查询结构数量呈指数级增长,不可能用所有结构来训练模型。因此,我们研究能够泛化到新的或更长步骤组合的模型。 这两个目标对于表示学习模型来说都是相当具有挑战性的,因为表示学习模型通常擅长拟合训练集提供的所有信息,而测试集在某些方面与训练集有所不同。因此,我们需要在模型架构中注入某些归纳偏差,使模型只学习不同结构通用的信息函数。相比之下,符号算法,如个性化PageRank[153]和子图匹配,不论其针对何种训练结构实现,都能完美泛化到未见过的结构。然而,符号算法是由人工设计的,且仅适用于它们为之设计的有限场景,例如完整的知识结构。为了实现跨结构的泛化目标,我们设计了带有符号算法启发式归纳偏差的表示学习模型。这一核心思想贯穿了本论文的各个部分。开发适用于结构的表示学习模型往往非常繁琐,因为现代机器学习框架是为张量而设计和优化的。为了解决这个问题,我们旨在开发一个库,以简化结构化数据上的机器学习开发,并吸引更多开发者进入这一领域。此外,考虑到现实世界中知识结构的巨大规模,我们希望研究适用于流行表示学习方法和我们自己方法的可扩展解决方案,目标是将它们的应用扩展到百万级甚至更大规模的图。总之,本论文解决了跨多种结构的泛化挑战,包括实体词汇、关系词汇以及图和文本模态中的多步查询。我们在本论文中的工作展示了统一各种知识结构和查询结构的可能性,促成了第一个适用于知识图谱上单步和多步查询的基础模型。这些工作改变了长期以来仅学习浅层结构嵌入的传统,开启了推理领域的许多新机遇。我们期待我们的成果和发现能加速向人类级推理模型迈进,并推动人工智能的终极目标。