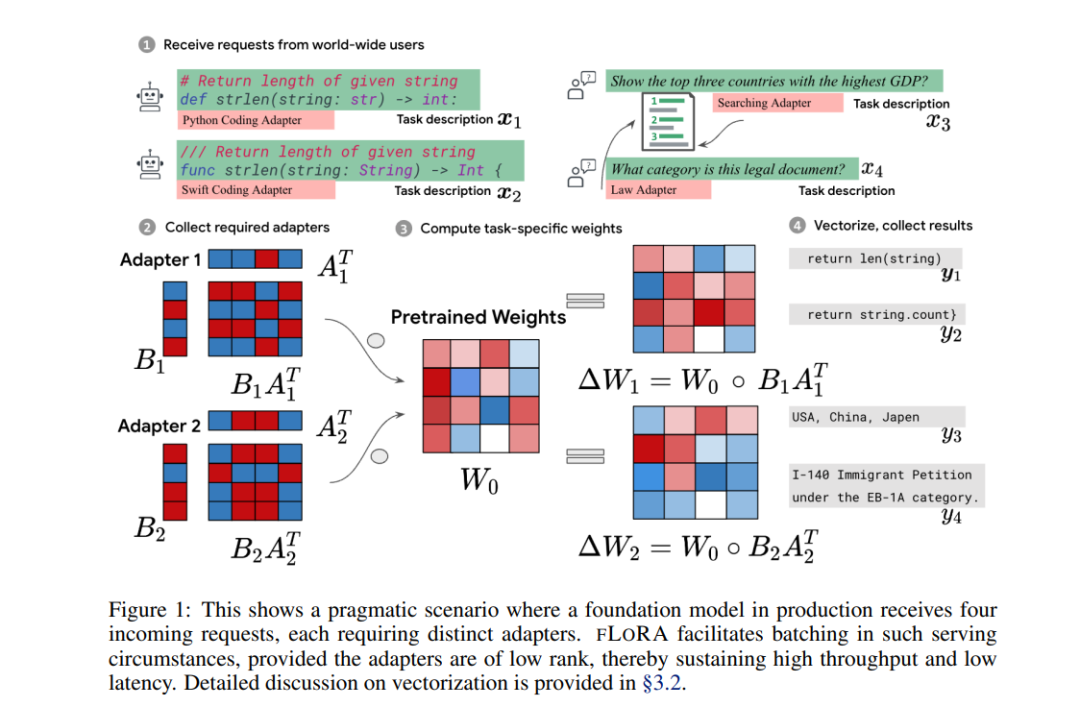

低秩适配(LoRA)近来因将可训练的低秩矩阵纳入微调基础模型而备受关注,从而减少了可训练参数的数量。虽然LoRA提供了许多优势,但由于其无法高效处理多个特定任务适配器,因此其在实时为多样化和全球用户群提供服务方面的适用性受到了限制。这在需要为每个传入请求进行个性化的特定任务适应的情况下,会产生性能瓶颈。

为了缓解这一限制,我们引入了Fast LoRA(FLORA),这是一个框架,在其中每个小批量中的每个输入示例都可以与其独特的低秩适应权重相关联,从而实现了对异构请求的高效批处理。我们经验性地证明,FLORA保留了LoRA的性能优点,并在涵盖8种语言的MultiPL-E代码生成基准测试和跨6种语言的多语音识别任务中展示出竞争力的结果。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2024年3月1日

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日