自人工智能早期以来,构建可以与人类自然对话的对话智能体的目标一直是研究人员的一个长期梦想。著名的图灵测试(Turing Test)提出根据人工智能智能体与人类对话的不可区分性来判断其最终有效性。毫无疑问,构建人类级别的对话系统非常具有挑战性。但是,虽然基于规则的系统的早期努力取得了有限的成功,但深度学习的出现使这一主题取得了巨大的进展。

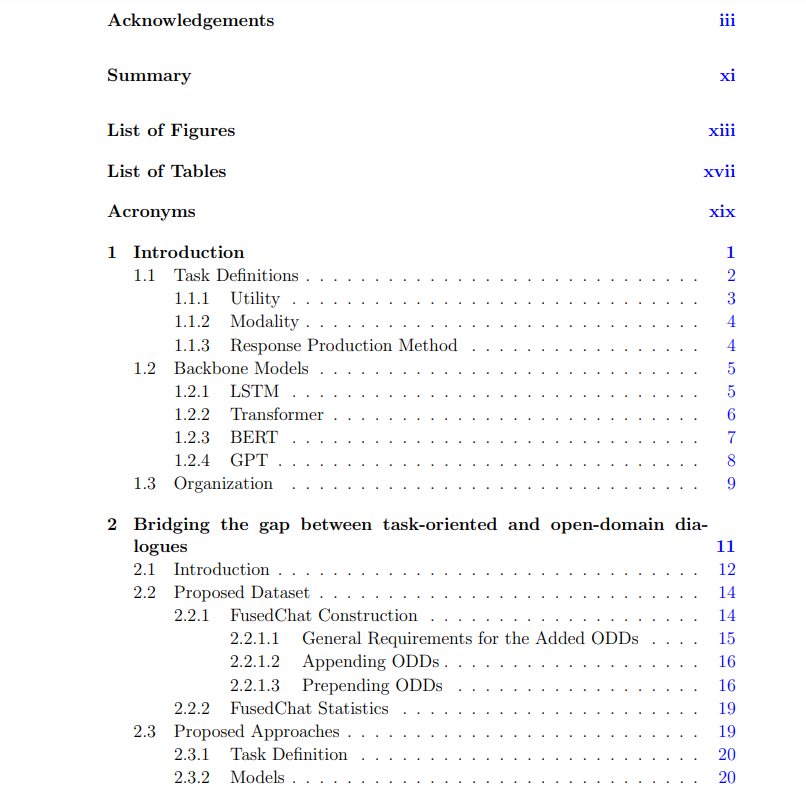

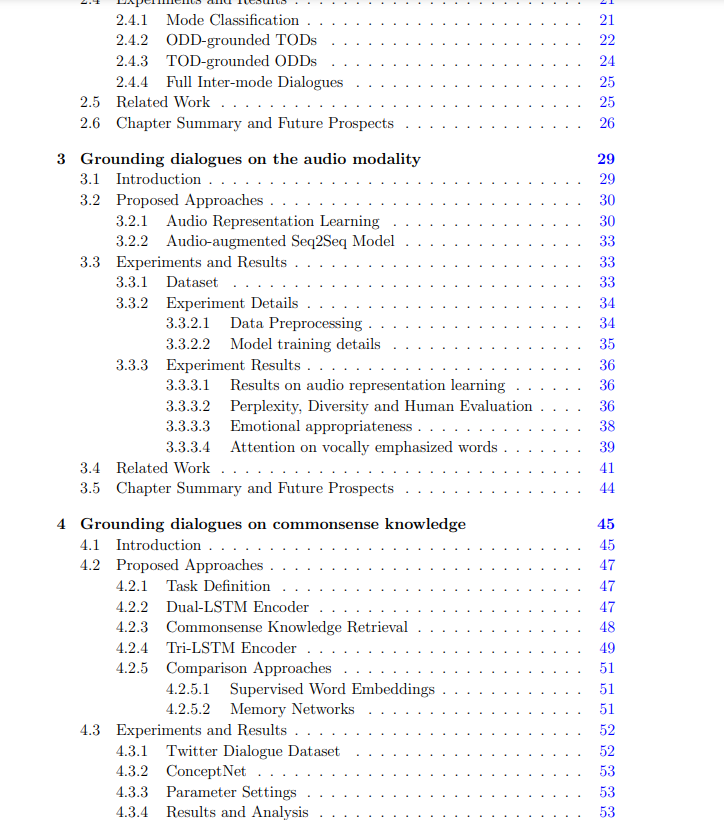

本文专注于解决许多问题的方法,这些问题一直在人工对话智能体和人类级别的对话者之间造成差距。这些方法是在通用的最先进的人工智能方法的启发下提出和实验的。但他们也针对对话系统所具有的特征。首先,扩展了对话系统可以依赖的信息的多样性。在其最简单和最常见的形式中,对话由回应和它们的前面的文本上下文组成。然而,与现实世界的人类对话相比,这种表示并不理想,后者往往依赖于其他模态和特定的知识库。为了将对话条件化为更多模态,本文探索了由输入的音频表示增强的对话生成。设计了一个辅助的响应分类任务,为对话生成目标学习合适的音频表示。我们使用词级模态融合将音频特征集成到序列到序列学习框架中。该模型可以产生与音频中表达的情感和重点相对应的适当响应。常识知识必须有效地集成到对话系统中,以便以一种有趣和参与的方式回应人类的话语。作为首次尝试将大型常识知识库整合到端到端的会话模型中,本文提出了一种联合考虑上下文及其相关常识知识的模型来选择合适的响应。本文证明了知识增强模型优于无知识模型。

虽然上述两个方向都致力于将对话建立在各种新信息的基础上,但它们并不是对话系统面临的唯一挑战。传统上,构建智能对话系统的目标在很大程度上是在两种范式下分别追求的:任务导向型对话系统(执行特定任务的功能)和开放域对话系统(专注于非目标导向型对话)。这两种对话模式可以在同一对话中无缝地交织在一起,就像友好的人类助手很容易做到的那样。本文还对多轮对话中两种对话模式的融合问题进行了研究。构建了一个新的数据集FusedChat,其中包含包含来自两种对话模式的对话会话,具有模式间上下文依赖。本文提出了两个基线模型,并分析了它们的准确性。

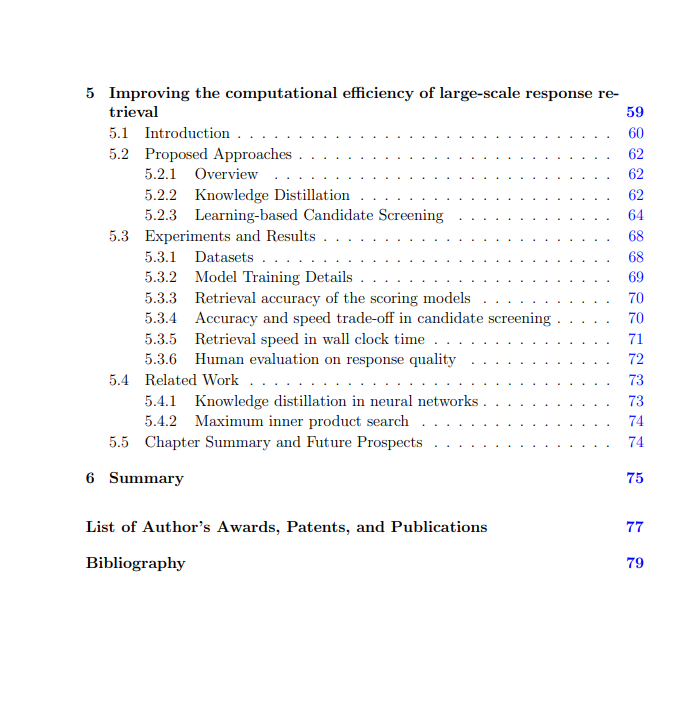

最后但并非最不重要的是,我们展示了我们在解决大规模基于检索的对话系统面临的计算效率问题上的努力。基于大型自然候选集的强检索对话系统可以产生多样化和可控的响应。然而,一个大的候选集可能是计算成本很高的。我们提出了支持快速和准确的响应检索系统的方法。为了提高准确性,我们采用了一种知识蒸馏方法,其中使用了一个非常强大但计算成本很高的联合编码模型来促进编码器的训练。然后,我们采用基于学习的候选筛选方法来提高检索速度,进一步减少推理时间。我们证明了我们的模型在检索精度和速度权衡方面表现强劲。综上所述,本文系统地展示了我们在创新对话系统方面所做的努力。我们相信,我们所关注的研究问题是最终将自动对话代理提高到人类水平的重要方面。随着我们在过去4年里不断创新对话系统的努力,以及最先进的NLP模型逐年快速发展,我们注意到我们早期工作中使用的一些模型(例如LSTMs)无法与今天可用的最先进的模型(例如GPT3)竞争。在这种情况下,我们简要而系统地解释以下工作(当前最先进的技术),这些工作源于我们工作中展示的方法。