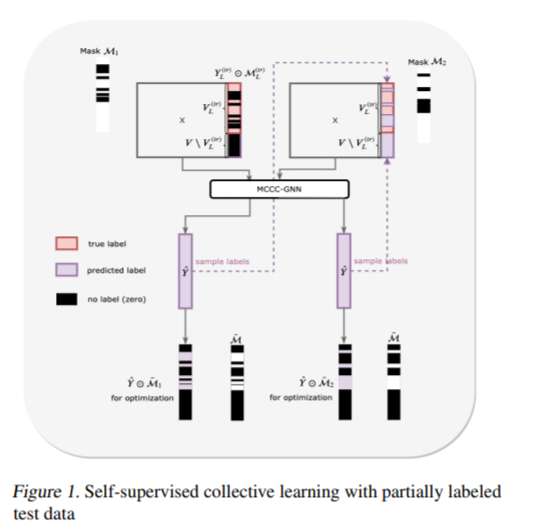

图神经网络(GNNs)最近被成功地用于节点和图的分类任务中,但GNNs对邻近节点属性之间的依赖关系建模,而不是对观察到的节点标签之间的依赖关系建模。在这项工作中,我们考虑了在监督和半监督设置中使用GNNs进行归纳节点分类的任务,其目标是合并标签依赖项。因为当前的GNN不是通用的。为了提高现有GNN的表达能力,我们提出了一种通用的集体学习方法。我们的框架结合了集体分类和自监督学习的思想,并使用蒙特卡罗方法来采样嵌入图的归纳学习。我们评估了5个真实网络数据集的性能,并证明了在各种最先进的GNN中,节点分类精度的一致性和显著提高。

成为VIP会员查看完整内容

相关内容

专知会员服务

60+阅读 · 2020年6月28日

Arxiv

44+阅读 · 2020年2月5日

Arxiv

4+阅读 · 2019年2月11日

Arxiv

21+阅读 · 2018年12月25日