GPT-4V面世后,具备多模态能力的大语言模型(Multi-modal Large Language Models, MLLMs)再次受到广泛关注。然而幻觉问题一直困扰着使用者,即使是被认为MLLMs天花板的GPT-4V,在很多场景下也会产生幻觉(如图1中的高亮字体)。无论作为开发者还是用户,相信谁也不想在实际应用场景下遇到一个会“欺骗人类”的模型,因此幻觉问题得到广泛重视。

图1 想要消除幻觉,首先要了解幻觉,因此评估MLLMs的幻觉成为了整个工作的第一步。然而现有的MLLMs幻觉评估方法都存在限制。这些工作要么评估的角度不够全面,只能评估一部分幻觉;要么需要借助人类判断或反复调用GPT-4,不仅耗费很多资金,评估效率也难以保证。相信很多工作者也很想知道自己训练的MLLMs的幻觉程度,但又看着片面的评估结果或高额的成本望而却步。 最近,一个叫做AMBER的benchmark问世,专门用于评估MLLMs的幻觉。AMBER全称An LLM-free Multi-dimensional Benchmark for MLLMs Hallucination Evaluation,是一个不需要依赖任何模型并且具有多种维度幻觉评估的benchmark。更重要的是,AMBER几乎没有任何使用门槛,只需几分钟就可以完成评估。下面带大家了解一下具体内容。 论文:

https://arxiv.org/abs/2311.07397 Github:

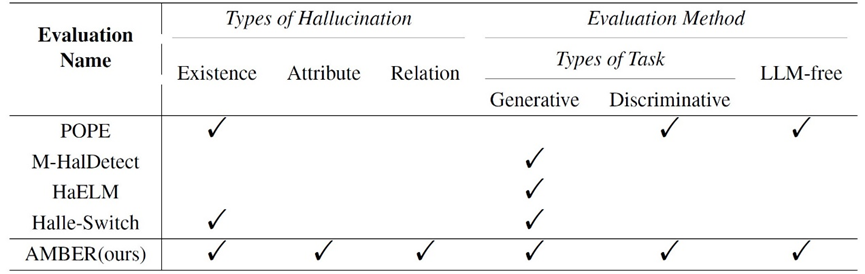

https://github.com/junyangwang0410/AMBER 表1展示了现有benchmark和AMBER的对比,可以明显看出AMBER具备明显的优势。首先是多维度的特点,主要展现在两个方面。其一是评估的幻觉类型,现有工作只关注了存在幻觉,而AMBER首次将评估扩展到属性幻觉和关系幻觉上;其二是评估的任务类型,现有benchmark只能在生成式任务或判别式任务上二选一,但是AMBER可以一起评估。其次是LLM-free的特点。相比于现有工作极大地依赖GPT-4,AMBER不仅可以省去调用GPT-4接口的成本,整个评估流程也只需要几分钟。

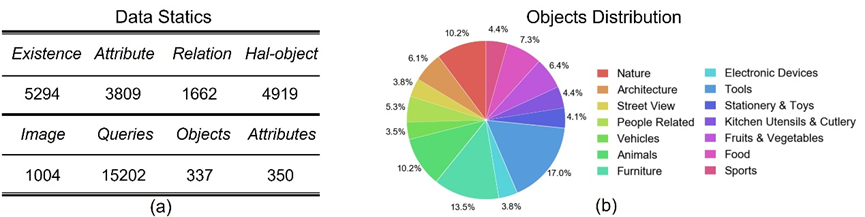

表1 AMBER由图片、指令和对应的标注构成。为了更全面准确地评估,AMBER将评估范围再次扩大,如表2所示,AMBER覆盖了超过300种物体,而现有的benchmark最多只有80种。除此之外,在物体的分布上也几乎做到了全面覆盖,这下再也不用担心评估的结果片面了。

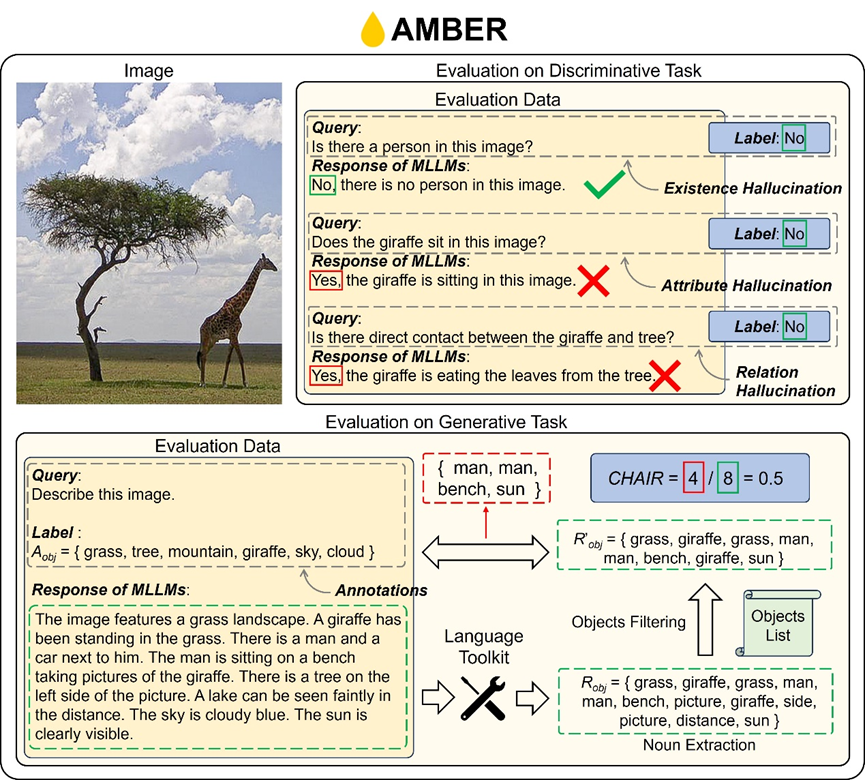

表2 图2展示了AMBER的具体标注内容和评估过程。对于判别式任务,AMBER分别从存在、属性和关系三个角度构造prompt,并且提供正确的回答。这样只需要将输入数据送给MLLMs得到“yes”或“no”的回复,就可以直接得到评估结果了。 对于生成式任务,则需要略微复杂一点的流程。首先对模型的回复进行目标提取,这个过程还需要通过一个词表筛选出有效地目标。最终回复中的有效目标和标注的真实目标进行匹配,从而得到模型生成的不匹配于真实标注的目标。 在指标的设计上,除了图2中展示的准确率和CHAIR之外,我们还利用标注设计了多种其他指标。这些指标不仅能评估幻觉,还能评估生成内容的质量。

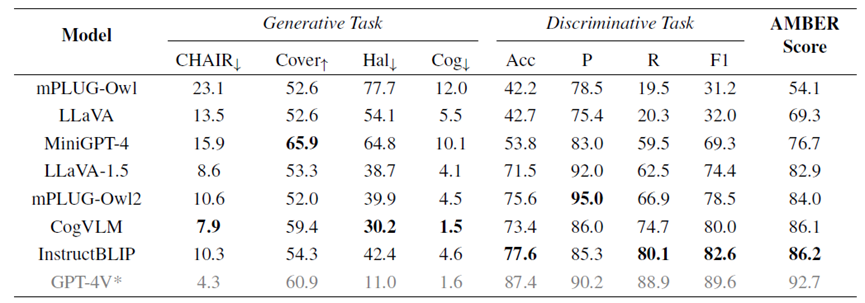

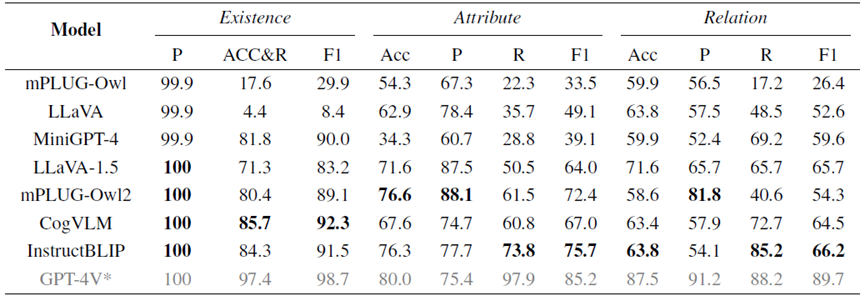

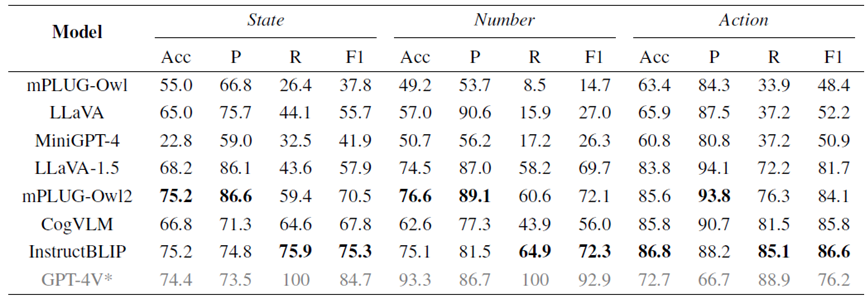

图2 在评估维度上,AMBER可以从多种幻觉角度得到MLLMs的性能,从而帮助模型设计者更全面具体地分析模型的幻觉。表3、4、5分别展示了目前主流的MLLMs在不同维度上的表现。

表3:整体的幻觉评估结果

表4:不同幻觉类型上的评估结果

表5:属性幻觉中不同方面的评估结果 如果你正在为如何低成本并全面的评估一个多模态大语言模型幻觉表现而发愁,那么你可以花几分钟在AMBER上得到一个全面的评估结果。AMBER的全套数据和评估代码即将开源。如果对于更多细节感兴趣,欢迎关注我们的技术报告!