多模态学习是人工智能领域中一个快速发展的方向,旨在通过整合和分析多种类型的数据(包括文本、图像、音频和视频),构建更具多样性和鲁棒性的系统。受到人类通过多感官获取信息能力的启发,这种方法使得文本到视频转换、视觉问答和图像描述等应用成为可能。本文综述了支持多模态语言模型(MLLM)的数据集的最新发展。大规模多模态数据集至关重要,因为它们为这些模型提供了全面的测试和训练。本文重点讨论了多个数据集的贡献,包括用于训练、领域特定任务和现实世界应用的数据集。还强调了基准数据集在评估模型在不同场景中的表现、可扩展性和适用性方面的重要性。由于多模态学习始终在不断发展,克服这些挑战将有助于推动人工智能研究和应用达到新的高度。

关键词:多模态 · LMM · LLM · 视频 · 音频 · VLM

1 多模态学习与大语言模型概述

多模态学习是人工智能领域一个不断发展的方向,旨在整合和处理多种数据类型,如文本、图像和音频,目标是模仿人类认知,后者自然地将感官输入结合起来。这种方法相比单模态方法,可以构建出更具鲁棒性和智能性的系统。 大语言模型(LLMs),如GPT-3、BERT和T5,在文本相关任务中表现出色,如问答和摘要[36]。然而,它们在处理非文本数据时面临挑战,这也推动了多模态大语言模型(MLLMs)的研究,后者将LLM的语言能力与计算机视觉的优势结合起来。MLLMs在图像描述和视觉问答等任务中取得了最先进的成果[18]。然而,仍然存在一些挑战,包括高质量数据集的匮乏、高计算成本以及偏见和隐私等伦理问题[28]。尽管如此,MLLMs在医疗、教育和研究等领域具有变革潜力,成为推动人工智能发展的关键焦点。

1.1 多模态学习:基础与概念

1 多模态学习与大语言模型概述

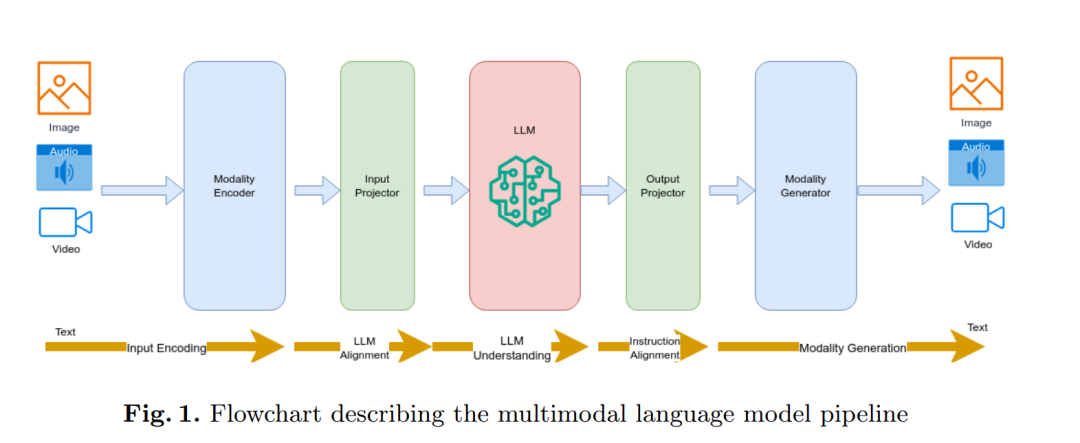

多模态学习是人工智能领域一个不断发展的方向,旨在构建能够处理和结合多种数据模态(如文本、图像、音频和视频)的模型。这是因为现实世界的经验本质上是多模态的,不同模态所携带的信息提供了一种更加全面地理解复杂环境的方式[28]。 多模态学习结合了多种数据类型:文本、图像、音频和视频。这些数据创建了每种模态独特的表示。鉴于各种数据类型的多样性,传统上使用不同的方法来捕捉它们的特征。例如,文本通常通过词嵌入来表示,重点强调意义和结构[3],而图像数据则通常依赖于卷积神经网络(CNN)来提取视觉场景中的细节。同样,音频数据通常被转化为声谱图或梅尔频率倒谱系数(MFCC)以捕捉时间和频率上的模式[41]。一个典型的大型多模态模型(MLLM)处理管道如图1所示,首先通过模态编码器处理输入,统一其表示。然后通过输入投影器进行细化,并传入大语言模型(LLM)进行更深入的对齐和理解。最后,输出投影器和模态生成器将模型的结果转化为有意义的输出,支持诸如生成多模态内容或在不同数据类型之间进行转换的任务。

模态表示的融合是多模态学习中的关键焦点。常用的方法包括早期融合,在处理的初期阶段通过连接或组合表示[38],以及晚期融合,其中模态特定的表示在过程的后期结合,通常通过注意力机制或门控机制进行[38]。

除了表示和融合之外,多模态学习还面临更多挑战,如对齐、翻译和共学习。对齐使得跨模态的时间或语义同步成为可能,这是视频理解或视听语音识别等任务的基本任务[5]。翻译帮助实现模态转换,例如从文本生成图像[57]。共学习则允许在某些数据模态不可用或损坏的情况下学习,通过从可用模态转移知识[41]。 最近,LLM的进展,如BERT、GPT和DALL-E,显著加速了多模态学习的进展。这些模型在理解和生成文本方面表现出色,它们扩展到多种数据类型,使得回答图像相关问题、创建图像描述甚至基于文本生成图像成为可能[32]。

简而言之,多模态学习在发展能够有效处理和整合来自不同来源的信息的智能系统中扮演着至关重要的角色。多模态的互补优势确保了这一领域在自然语言处理(NLP)、计算机视觉和机器人等领域不断创造创新,应用和研究方向也在不断扩展。

1.2 多模态大语言模型:机遇与挑战

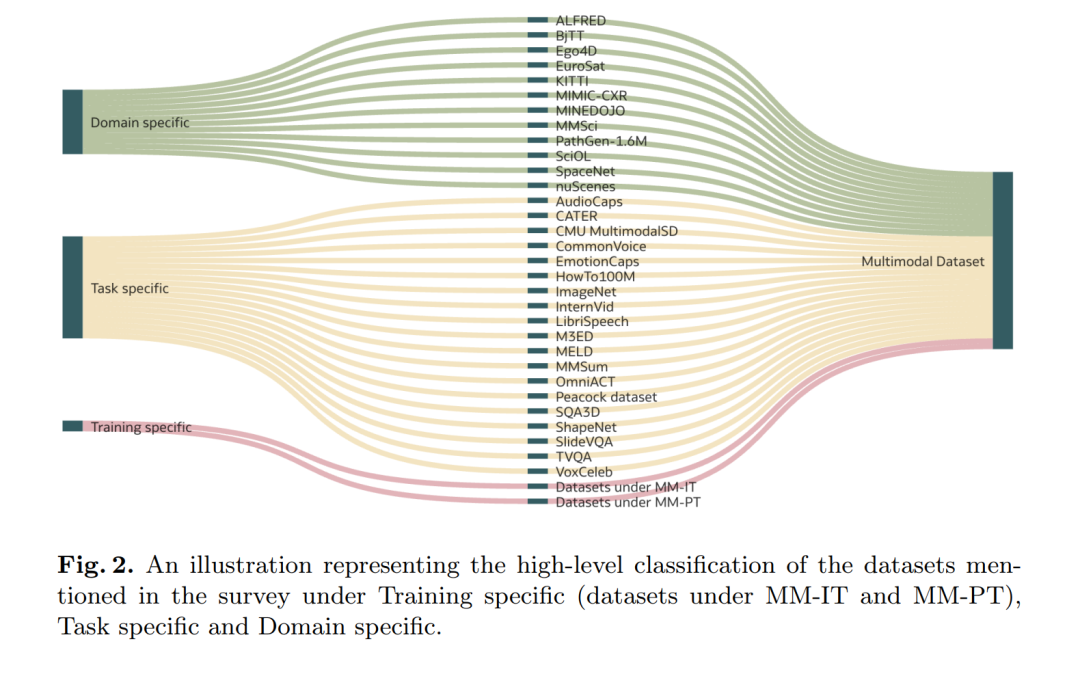

最近在LLM方面的进展为多模态大语言模型(MLLMs)铺平了道路,这些模型结合了跨模态的数据,如文本、图像、音频和视频[59]。MLLMs通过结合不同模态的数据,提升理解和表示能力,具有改变多个领域的潜力。 MLLMs将LLM的能力扩展到传统文本模型之外的任务。这类模型在图像描述、视觉问答和文本到视频生成等任务中表现出色——这些任务都需要深入理解语言与视觉的关系[63]。多模态数据的整合为科学研究和领域特定应用提供了更大的空间,通过推动边界的扩展,开辟了更多可能性。一些关键领域,如医学影像、自动驾驶和地理空间智能,结合了文本、视觉和传感器数据,从而实现了更现实的决策过程。 尽管MLLMs具有巨大的潜力,但它们的开发仍面临重要挑战。其中主要问题之一是缺乏大规模高质量的多模态数据集[49]。覆盖现实复杂性的无偏数据是训练强大MLLMs的必要条件[28]。 另一个挑战是集成这些不同模态所带来的计算需求和复杂性。训练和部署MLLMs需要大量资源,因此需要开发新的模型架构、高效的训练策略和硬件能力[28]。 最后,确保MLLMs的可靠性、可解释性和伦理对齐性至关重要。随着这些模型的日益复杂化,越来越需要提供其决策过程的见解,以减少偏见并使其与人类价值观更紧密地对齐。开发强大的评估框架和可解释性工具是建立对MLLMs信任的必要条件[45]。 尽管如此,MLLMs的前景仍然广阔。通过融合多模态数据,这些模型为更好地理解复杂场景开辟了道路,从而诞生了新的应用并推动了相关科学研究。此外,未来的跨学科合作和对伦理问题的关注将是推动MLLMs转型的关键因素[28]。 在接下来的章节中,我们将对MLLMs所需的关键数据集进行分类,分为三大类:训练特定数据集、任务特定数据集和领域特定数据集,如图2所示。 **