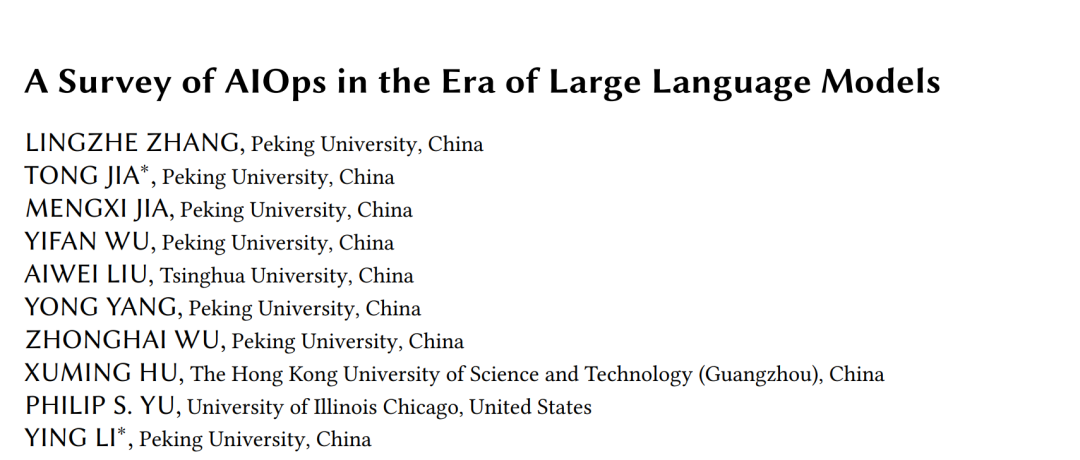

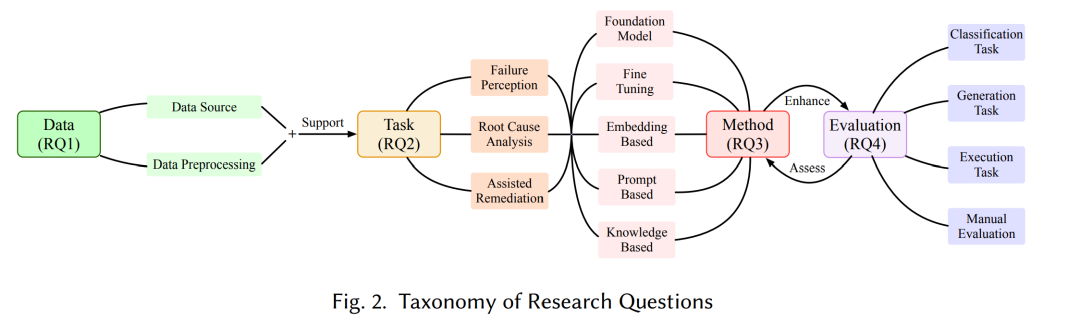

随着大语言模型(LLMs)的不断发展与广泛应用,其在各类AIOps(人工智能运维)任务中的潜力正引发越来越多的关注。然而,关于LLMs在AIOps中的影响、潜能与局限性的系统性理解仍处于初级阶段。为填补这一研究空白,我们开展了一项关于LLM4AIOps的详尽综述,重点探讨LLMs如何优化运维流程并提升任务效果。我们分析了2020年1月至2024年12月间发表的183篇相关研究论文,围绕四个核心研究问题(RQ)展开探讨。 在RQ1中,我们考察了所使用的多样化故障数据来源,涵盖对遗留数据的LLM驱动处理技术以及LLMs所支持的新型数据源的引入。RQ2聚焦AIOps任务的发展演变,突出展示了新兴任务的涌现及其研究发布趋势。RQ3探讨了用于应对AIOps挑战的各类LLM方法。最后,RQ4审视了专门用于评估融合LLMs的AIOps方案的评估方法体系。

基于上述分析,我们总结了当前的研究进展与发展趋势,识别了现有工作中的关键空白,并提出了未来值得深入探索的研究方向。

1 引言

现代软件系统日益复杂,通常面向数十亿规模的用户群体提供服务【55, 160】。即使是微小的软件故障,也可能由于服务中断或性能下降而造成巨大的经济损失与声誉损害【26】。因此,大规模分布式系统必须实现全天候(24/7)持续运行,对可用性与可靠性提出了极高要求。然而,由于系统规模庞大、逻辑复杂,故障不可避免且难以检测、定位与诊断;一旦发生故障,其分析与恢复的难度更是倍增。因此,AIOps 的有效性——包括快速故障检测、高效诊断、准确根因定位以及及时修复——已成为保障系统可靠性与可用性的关键。 本文中的 AIOps 范畴。 AIOps(Artificial Intelligence for IT Operations,智能运维)最早由 Gartner 于 2016 年提出【104】。AIOps 指利用机器学习(ML)和深度学习(DL)技术处理由运维工具和基础设施产生的大量数据,实现对系统问题的实时检测、诊断与修复,从而显著提升 IT 运维的自动化与智能化水平。现有文献多数采用这一范畴,将 AIOps 聚焦于系统可靠性保障和故障管理【17, 97, 108, 121, 134】。但也有部分工作将 AIOps 扩展至 AI 运维(Ops for AI)与网络安全等方向【21, 96】。尽管这些研究方向同样具有价值,但超出了本文的讨论范围。本文专注于 AIOps 在应对大规模分布式系统运行时软件故障中的作用。

1.1 为什么 LLMs 有助于 AIOps?

随着人工智能(AI)的快速发展,基于机器学习(ML)和深度学习(DL)的传统 AIOps 方法在实现软件故障自动化管理方面发挥了关键作用【17, 21, 97, 108, 134】。然而,在实际应用中,这些方法仍面临诸多挑战: * 特征工程复杂。 传统方法通常依赖大量的预处理与特征工程,才能从原始数据中提取有用信息,且在理解与处理如日志和调用追踪等非结构化数据方面能力有限。 * 缺乏跨平台泛化能力。 这些模型往往针对特定软件系统进行调优和训练,一旦换用不同系统,或原有系统发生哪怕细微变动,其性能便会显著下降,即使任务本身没有变化。 * 缺乏跨任务灵活性。 传统模型通常只能执行单一任务。例如,在根因分析(Root Cause Analysis, RCA)中,有些工作侧重于识别问题原因【73, 122, 147】,而另一些则关注于定位涉及的软件组件【46, 92, 130】。现实场景中往往需要多个模型协同运行以完成完整的 RCA 任务。 * 模型适应性有限。 软件系统发生变更后,基于深度学习的方法通常需要频繁重新训练与更新模型,以适应新数据与新环境。尽管已有许多在线学习方法【1, 37, 69, 82】试图缓解此问题,但这一过程仍耗时费力,且在应对突发事件时可能导致响应滞后。 * 自动化程度受限。 当前基于深度学习的方法在自动化操作与智能决策方面能力仍较弱。尽管已有一定程度的自动化,但仍需大量人工干预与配置。尤其在自动修复(Auto Remediation)方面,目前多停留在事件分流(Incident Triage)【148】或方案推荐(Solution Recommendation)【131, 175】的阶段。

大语言模型(LLMs)作为在自然语言理解任务上预训练的模型,为解决上述问题提供了新思路: 1. 得益于其强大的自然语言处理能力,LLMs 能够高效处理和理解非结构化数据,往往无需显式的特征工程。 1. LLMs 在大规模跨平台数据上训练,具备良好的泛化能力与逻辑推理能力。 1. 以自然语言为输出形式,LLMs 具备极强的任务灵活性,能够同时完成多个 AIOps 任务,如识别问题原因与相关软件组件。 1. 基于预训练,LLMs 具备较强的适应能力,结合检索增强生成(Retrieval-Augmented Generation, RAG)等技术,往往可在无需重新训练的情况下引入外部知识。 1. 依托其强大的脚本生成能力和自动调用外部工具的能力,LLMs 能实现更高级别的自动化。

1.2 为什么要开展 LLM 时代的 AIOps 综述?

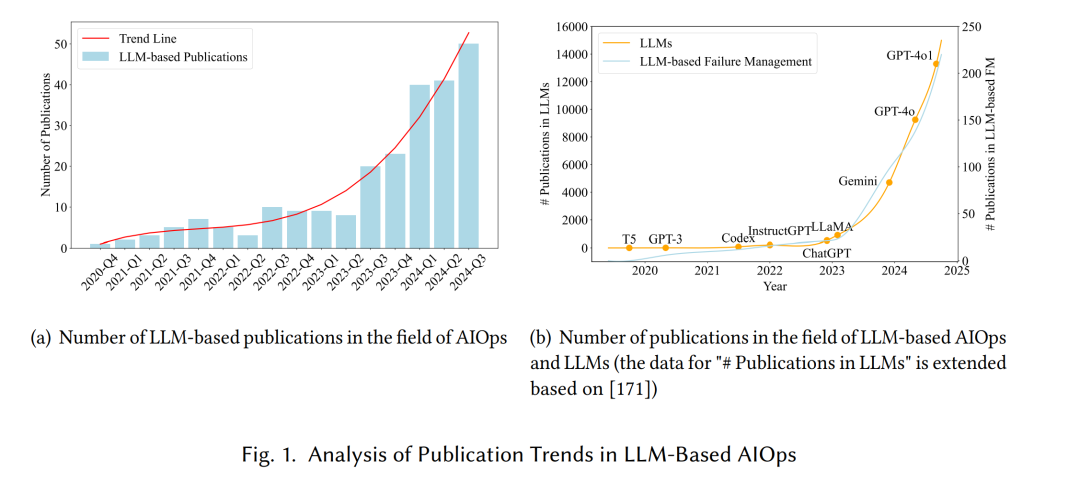

由于大语言模型的上述优势,越来越多的 AIOps 研究开始引入 LLMs,如图 1(a) 所示。此外,LLMs 的迅猛发展催生出一个蓬勃发展的基于 LLM 的 AIOps 研究生态,如图 1(b) 所示。特别是随着 ChatGPT 的推出,基于 LLM 的 AIOps 研究热度显著上升。总的来看,随着时间推移,采用 LLM 的相关研究数量持续增长,且在未来仍将加速。因此,亟需对 LLM 时代的 AIOps 演进趋势进行全面梳理。 事实上,近年来已有多篇综述总结了 AIOps 相关研究。如表 1 所示,这些工作要么侧重于基于传统机器学习或深度学习算法的方法【17, 97, 108, 134】,未涉及 LLM 相关方法;要么未对 AIOps 全流程中所涉及的各类任务做出系统性总结【121】。因此,当前尚缺乏一份关于 LLM 时代 AIOps 的系统性综述。 本研究首次系统梳理了在大语言模型背景下 AIOps 全流程相关研究,旨在帮助研究者深入理解基于 LLM 的 AIOps 方法,横向对比不同策略,厘清研究脉络。同时,本综述也为有意采用 LLM 技术进行智能运维的工程实践者提供参考,帮助其在不同应用场景中选择合适的算法与方案。

1.3 研究问题

随着大量基于 LLM 的 AIOps 方法的迅速涌现,以及这一趋势在未来的持续升温,对 LLM 时代 AIOps 的全面调研已成为一个及时而必要的任务。本综述的核心目标是系统性分析基于 LLM 的 AIOps 研究中出现的新趋势与面临的挑战,从而为产业应用提供指导,为学术研究提供有价值的参考。 为此,本文围绕以下四个关键研究问题展开,每个问题聚焦于大语言模型如何重塑 AIOps 的某一核心方面: * RQ1:LLMs 的引入如何改变了 AIOps 中的数据来源及预处理方法?

RQ2:AIOps 的任务体系在 LLMs 出现后经历了怎样的演化?

RQ3:当前有哪些利用 LLM 的方法被应用于 AIOps?

RQ4:在引入 LLM 后,AIOps 的评估方法体系发生了哪些变化?

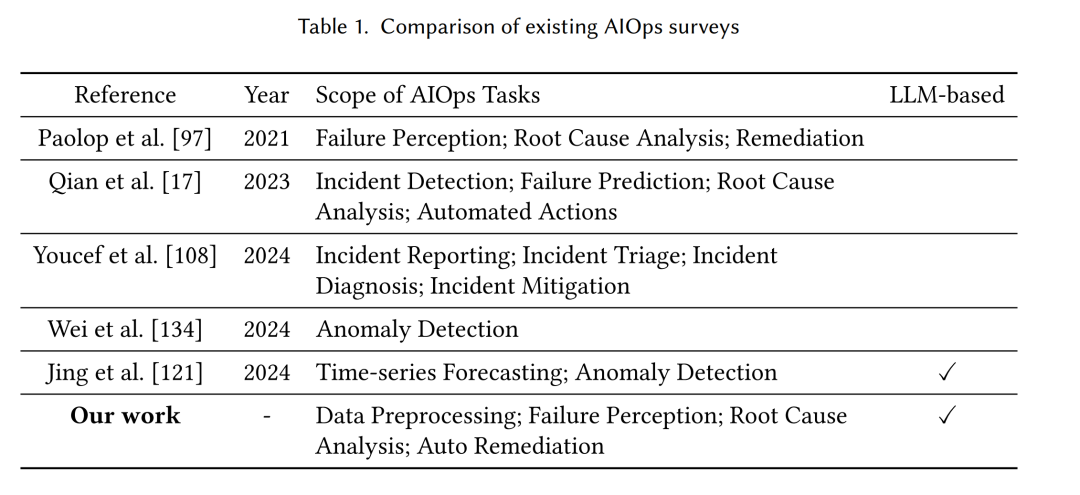

图 2 展示了上述研究问题的结构化分类体系:其中,RQ1 关注数据来源与预处理技术,构成了后续 AIOps 各类任务(RQ2)的基础;这些任务由 RQ3 所述的 LLM 方法提供支撑;而 RQ4 则分析这些方法的评估方式。值得注意的是,LLM 方法不仅需要被评估,也可能在评估体系中发挥积极作用,从而形成一个不断增强 AIOps 性能的反馈闭环。

1.4 本文结构

本文结构安排如下:第 2 节介绍系统性综述所采用的方法与文献搜索策略;第 3 至第 6 节分别对应四个研究问题展开分析与总结;第 7 节讨论当前面临的挑战与未来研究方向;第 8 节给出全文总结与展望。