项目概述

本研究报告是联合国裁研所人工智能建立信任措施项目的一部分。该项目旨在促进在国际和平与安全背景下就人工智能建立信任措施开展多边讨论,并探讨建立信任措施的备选方案,这些方案应现实、可行,并能提高人工智能开发和使用过程中的整体信任度和透明度。

建立信任措施是灵活的工具,旨在减少国家间的模糊和不信任,或防止升级。它们由共同利益决定,可以采取各种形式。从历史上看,各种手段都是建立信任措施工具箱的一部分,如核查措施、军事限制或信息交流。

人工智能领域的进步,加上该技术的可扩展性以及与其他技术领域的融合,给国际社会带来了新的风险,包括对国际和平与安全的风险。建立信任措施可在应对技术风险方面发挥重要作用,并为人工智能技术的未来发展和部署形成共同规范。

该项目包括两个主要阶段:

1.绘制风险图,对风险进行分类,目的是全面概述与人工智能技术有关的主要风险领域。本研究报告有效地实现了项目第一阶段的目标;

2.在第一阶段研究成果的基础上,通过多方利益相关者的参与,探索建立信任措施的发展路径。

执行总结

本研究报告阐述了国际和平与安全背景下的人工智能风险分类。它是联合国裁军研究所 "人工智能建立信任措施 "项目的一部分,旨在绘制该技术的风险图,为今后讨论和阐明建立信任措施提供参考。

该分类法将风险分为两大类:

1.人工智能技术的风险,包括安全风险(人工智能系统固有的脆弱性和局限性)、安全风险(旨在破坏人工智能系统学习或行动方式的蓄意攻击)、人机交互风险(由于人类操作人工智能系统或与人工智能系统一起工作的复杂动态,导致人工智能系统使用不当);以及 2.

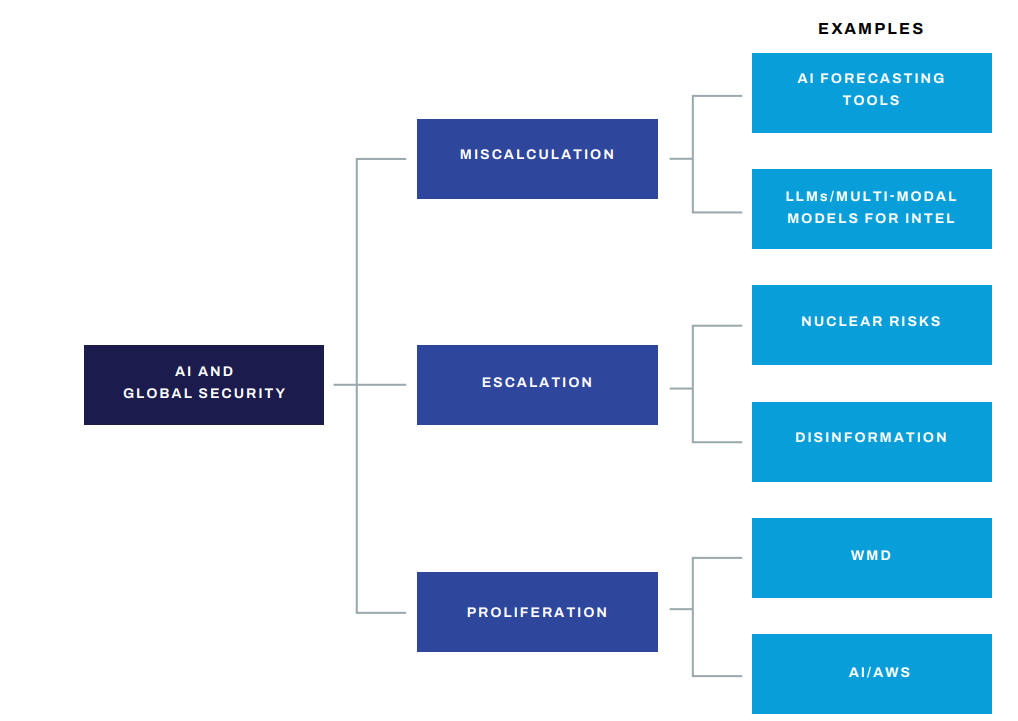

2.人工智能对全球安全的风险,包括三大类风险:误判(人工智能的使用和应用可能损害使用武力的决定或为国际关系恶化开辟道路)、升级(人工智能技术可能导致冲突有意或无意升级)和扩散(人工智能被滥用于扩散新武器,包括大规模毁灭性武器的风险)。

当然,风险是相互关联、相辅相成的。例如,人工智能系统的稳健性和复原力不足会迅速转化为故障,为国家间的误判和升级开辟道路。对人工智能系统的边界和能力的不正确使用或理解会导致对系统的过度依赖或依赖不足,从而进一步引发负面或升级后果。

本报告对不同类别的风险进行了技术说明,并对其对全球安全的潜在影响进行了背景分析。在现阶段,它并没有为未来建立信任措施的讨论提供备选方案,也不是为了围绕具体风险确定优先领域的范围。建立信任措施最终将由相关利益攸关方制定和阐述。本报告为了解风险提供了指南,可作为未来讨论的基础。