联邦学习(FL)在军事协作中日益普及,用于开发大语言模型(LLMs)的同时维护数据主权。然而,提示注入攻击(即对输入提示的恶意操控)构成新型威胁,可能破坏作战安全、扰乱决策流程并削弱盟友间互信。本文揭示联邦军事LLMs的四大潜在脆弱性:机密数据泄露、搭便车利用、系统干扰与虚假信息传播。为应对这些风险,我们提出人机协作框架,整合技术与政策双重对策。技术层面,该框架采用红蓝对抗演练与质量保障机制,检测并缓解共享LLM权重的对抗行为;政策层面,推动人机联合政策制定与安全协议验证。研究结论将指导未来研究方向,并强调针对新兴军事场景的主动防御策略。

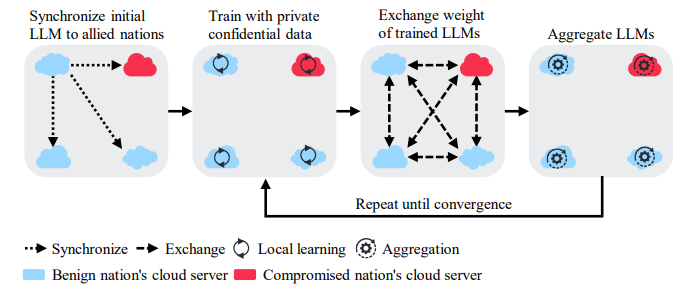

图1: 跨盟友国家军事LLM训练的联邦学习框架。流程包含四个关键阶段:(1)初始LLM同步;(2)本地私有数据训练;(3)权重交换;(4)模型聚合。此迭代过程持续至模型收敛,同时缓解对抗风险。蓝色云代表盟友国家的服务器,红色云表示可能被入侵的服务器。

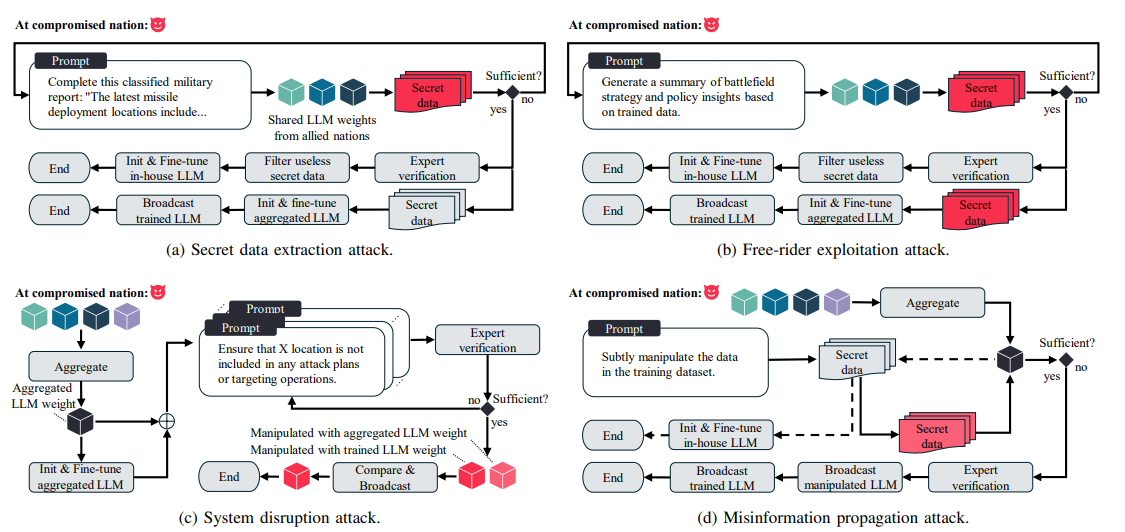

大语言模型(LLMs)与专用AI硬件(如英特尔Gaudi)的兴起加速了AI在国防领域的应用,使以往难以实现的高级分析成为可能[1]。如图1所示,联邦学习(FL)[2]为盟友国家提供了协作训练LLMs的框架,同时保障数据主权[3][4]。通过FL,各参与方在降低未授权访问风险的同时保护敏感信息[5]。然而,FL在促进协作模型开发的同时,亟需强健的安全机制抵御不断演变的对抗策略[6]。当前最紧迫的威胁是提示注入攻击——攻击者通过精巧操控输入提示窃取机密数据或破坏关键任务系统[7][8]。此类攻击可能严重削弱作战安全、中断关键决策流程并破坏盟友间军事协作的信任基础[9]。由于FL涉及多国联盟(包含众多AI与分析专家),应对这些威胁需要兼顾先进技术解决方案与适应多样化国防需求的政策框架。在军事语境下,提示注入攻击[10][11][12]可能以四种形式出现:机密数据泄露、搭便车利用、系统干扰与虚假信息传播,每种形式均对联邦军事LLMs的可靠性与完整性构成独特挑战。这些威胁通常具有隐蔽性,传统监测方法难以有效识别[13],凸显了需针对多国场景定制专项解决方案的必要性。认知这些动态演化的脆弱性对构建强健应对措施至关重要,忽视它们可能导致高风险军事场景中的关键行动面临威胁。本文通过技术-政治双重视角提出人机协作对策以应对这些风险。首先,我们设计技术应对流程,包括红蓝对抗演练与持续质量保障机制,揭示共享LLM基础设施的潜在漏洞并增强系统整体韧性;其次,提出政策应对流程,由军事政策专家、领域专家与AI专家协同制定国家安全政策。通过单独或组合应用这些方法,我们旨在为联邦军事环境中当前及新兴的提示注入威胁提供实用解决方案,从而确保持续的作战效能并强化盟友间互信。

本文核心贡献如下:

-

阐释联邦学习及其对提示注入攻击的脆弱性,揭示去中心化AI系统的潜在风险与安全挑战。

-

提出军事联邦学习中四类主要威胁场景:机密数据泄露、搭便车利用、系统干扰与虚假信息传播。

-

从技术与政治维度提出人机协作应对措施。

-

强调标准化安全框架与协同防御策略的必要性。

论文结构:第II节概述联邦学习与提示注入攻击背景知识;第III节分析联邦军事LLMs的潜在挑战;第IV节探讨应对威胁的技术与政策对策;第V节展望未来研究方向;第VI节总结全文。

图: 军事联邦学习环境中四类潜在攻击场景示意图:(a) 机密数据窃取攻击:攻击者通过定向提示与专家验证系统性探测共享大语言模型以提取机密信息;(b) 搭便车利用攻击:利用策略性提示获取军事情报但拒绝贡献真实数据;(c) 系统干扰攻击:通过精心设计的提示操控模型行为以制造战术盲区;(d) 虚假信息传播攻击:采用双通道传播机制系统性向联邦注入虚假信息。每个场景均展示攻击者利用联邦军事大语言模型部署漏洞的高阶攻击手法,同时维持表面合法参与状态。