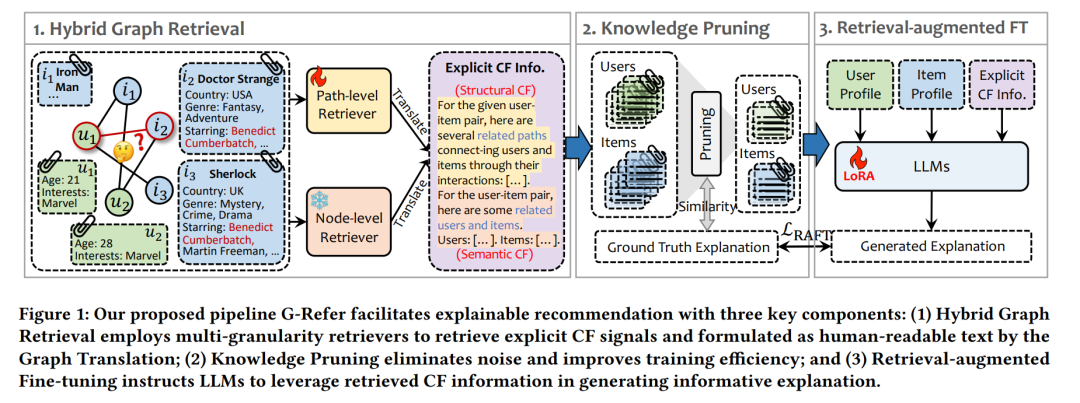

可解释推荐在帮助用户理解推荐逻辑方面展现出显著优势,从而提升了推荐系统的透明性、有效性与可信度。为提供个性化且具可解释性的推荐解释,现有研究通常将大型语言模型(Large Language Models, LLMs)的生成能力与协同过滤(Collaborative Filtering, CF)信息相结合。由用户-物品交互图中提取的CF信息能够有效捕捉用户行为与偏好,对于生成具有信息价值的推荐解释至关重要。 然而,由于图结构本身的复杂性,从图中有效提取CF信息仍然面临挑战。此外,现有方法在将提取到的CF信息与LLMs集成时也存在困难,主要受限于CF信息的隐式表示形式及图结构与自然语言之间存在的模态差异(modality gap)。 为解决上述问题,我们提出了一种新框架——G-Refer,即基于图检索增强的大型语言模型用于可解释推荐。具体而言,我们首先设计了一种混合图检索机制,从结构与语义两个角度联合检索出显式的CF信号。随后,提出的图翻译模块将检索得到的CF信息转化为人类可理解的自然语言文本,为LLMs生成推荐解释提供基础信息支撑。 为了进一步缩小模态差异,我们引入了知识剪枝机制与检索增强微调(Retrieval-Augmented Fine-Tuning)策略,增强LLMs在处理和利用CF信息生成高质量解释方面的能力。 大量实验证明,G-Refer在可解释性与稳定性方面均优于现有主流方法,表现出更强的泛化能力和用户可接受性。 项目代码与数据已开源,地址为:https://github.com/Yuhan1i/G-Refer

成为VIP会员查看完整内容

相关内容

Arxiv

204+阅读 · 2023年4月7日

Arxiv

20+阅读 · 2023年3月21日