本综述提供了对多轮对话系统研究的全面回顾,特别关注基于大型语言模型(LLMs)的多轮对话系统。本文旨在:(a) 总结现有LLMs及其适配到下游任务的方法;(b) 阐述多轮对话系统的近期进展,涵盖基于LLM的开放领域对话(ODD)和任务导向对话(TOD)系统,以及数据集和评估指标;(c) 讨论由LLMs的发展和对多轮对话系统日益增长的需求引起的一些未来重点和近期研究问题。 引言

1.1 什么是多轮对话系统? 能够生成自然且有意义的响应以与人类通信的多轮对话系统是人工智能(AI)的长期目标。这种人机交互任务由于其潜在的影响力和吸引人的商业价值,吸引了学术界和工业界日益增长的关注。多轮对话任务可以被视为一个序列到序列的任务,它从用户消息U = (u1, u2, ...ut)生成系统响应S = (s1, s2, ...st),其中ut和st分别是第t轮的用户消息和系统响应。多轮对话系统可以分为任务导向对话(TOD)系统和开放领域对话(ODD)系统。TOD系统帮助用户处理特定领域内的任务,如酒店预订、餐厅推荐等,而ODD系统则在没有领域限制的情况下与用户聊天。TOD任务和ODD任务并不完全独立,一旦对话系统检测到特定用户需求,一个ODD任务可以转换为TOD任务。 传统的对话系统主要依赖基于规则的方法和基于检索的方法。基于规则的对话系统[1–3]通过为特定场景预定义对话流程来生成响应。基于检索的对话系统[4–6]依赖预定义的模板,使它们比基于规则的系统更灵活。然而,基于检索的对话系统的应用范围仍然受限,因为生成的响应基于预定义的模板。随着深度学习方法的发展,提出了许多基于深度神经网络的多轮对话系统[7–9]。最近,预训练的LLMs的出现显著提高了多轮对话系统的性能。 1.2 为什么要进行基于LLM的多轮对话系统的综述? Arora等[10]提供了对话系统的概述,并介绍了各种对话系统框架。然而,这个综述将对话系统视为一个通用系统,而不是将其分类为TOD和ODD系统,并且没有包括深度学习模型。Chen等[11]将对话系统分类为TOD和ODD系统,讨论了深度学习技术在这两种类型的对话系统中的应用。尽管如此,这个综述没有深入探讨基于预训练LLMs的多轮对话系统。Ni等[12]的综述涵盖了基于预训练LLMs的多轮对话系统,但这项研究没有提供关于LLMs和将它们适配到下游子任务的详细见解。相比之下,Qin等[13]提供了对预训练LLMs在特定目标对话场景中应用的更全面探索。然而,这篇论文的焦点主要集中在端到端的任务导向多轮对话系统上。 我们的论文旨在提供基于LLM的多轮对话系统的最新概述,在此之前,我们将提供现有预训练LLMs及其适配到下游任务的方法的全面阐述。这项调查预计将吸引学术界和工业界的广泛受众,包括研究人员和实践者。 1.3 本综述的贡献 在本文中,我们提供了基于LLM的多轮对话的方法、评估指标和数据集的全面综述。我们论文的贡献可以总结如下:(1) 对LLMs及其适配到不同子任务的方法,以及最新的基于LLM的多轮对话系统进行彻底综述;(2) 对最新的多轮对话数据集和评估指标进行详细阐述。(3) 讨论一些由对话系统日益增长的需求和LLMs的发展引起的未来重点和近期研究问题。本综述的其余部分如下组织。在第2节,我们提供了流行LLMs的详细阐述。从第3节到第4节,我们将全面介绍将LLMs适配到下游任务的方法。在第5节,我们介绍了TOD的重要方法,包括基于流水线的方法和端到端的方法。最先进的ODD方法在第6节提出。在第7节和第8节,我们介绍了一些相关的数据集和评估指标。此外,在第9节提出了一些基于LLM的多轮对话的问题和挑战。最后,我们在第10节总结了我们的综述。

**通用方法 **

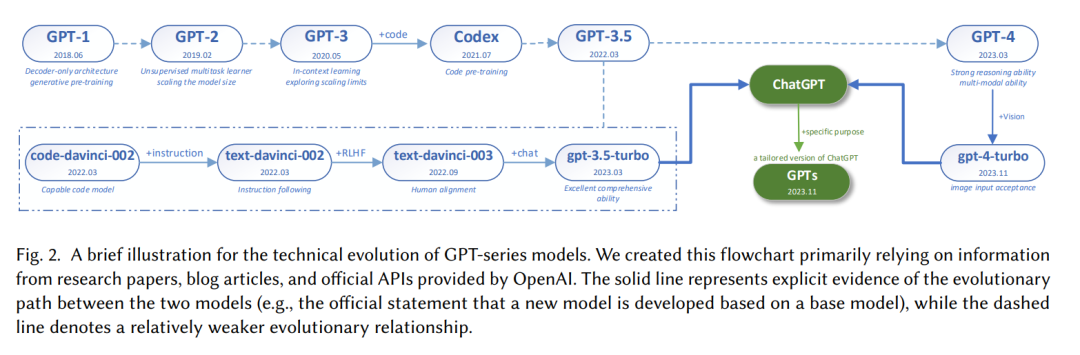

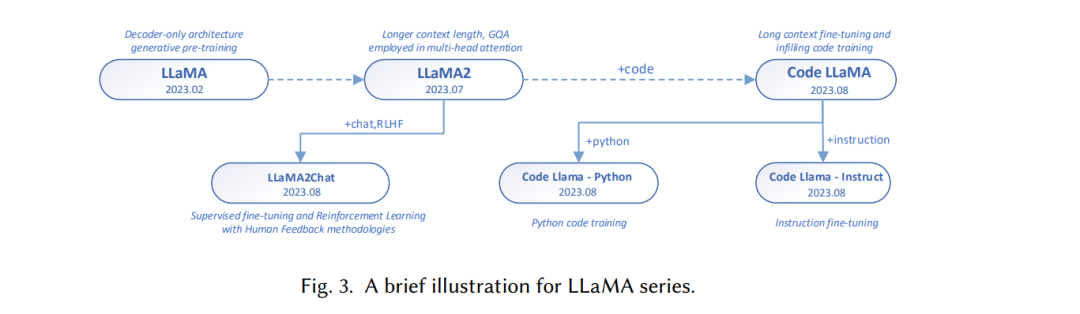

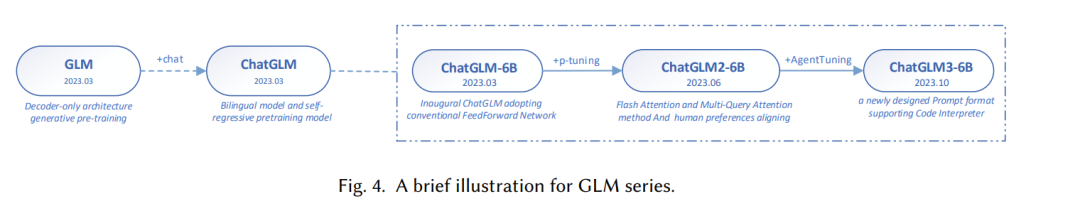

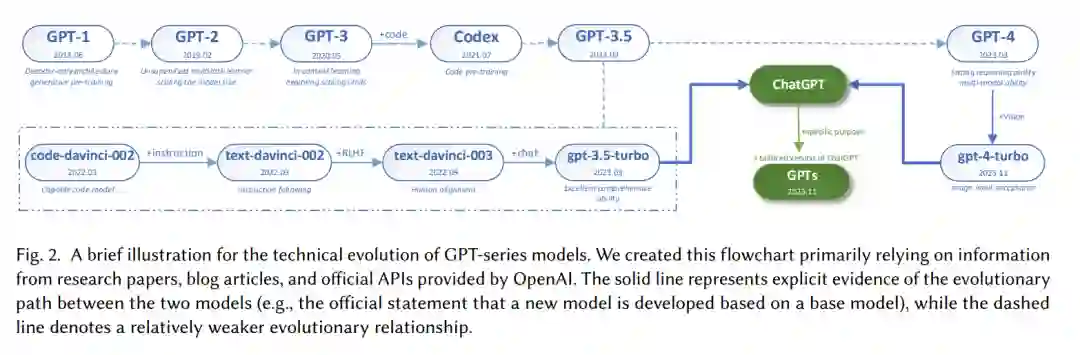

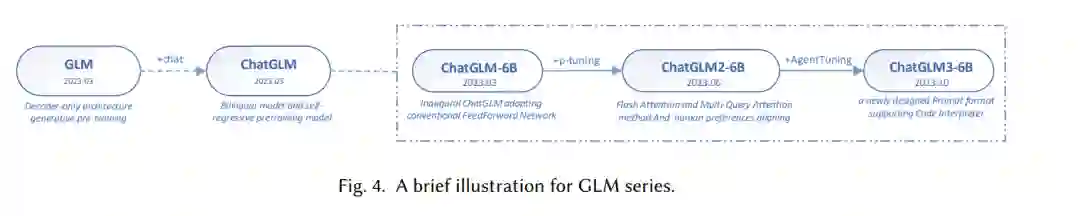

大型语言模型(LLMs)是一类具有数十亿参数的庞大人工智能模型[14]。扩大LLMs的规模使它们能够学习更复杂和准确的语言表示,从而在各种下游自然语言处理(NLP)任务中提高性能,特别是在自然语言生成(NLG)挑战中表现出色[15, 16]。提到的不同LLMs结构的简要比较可以在表1中看到。

**全面微调 **

全面微调(FFT)是神经网络适应领域的基石技术,它涉及优化所有模型参数,以将特定任务的知识整合到在预训练期间获得的基础架构中。FFT在为特定应用量身定制这些模型方面起着至关重要的作用,范围从细微的语言理解到特定领域的任务。 提示工程 提示工程在帮助预训练语言模型(PLMs)理解给定任务的领域中获得了显著关注。提示工程可以分为两种方法:提示调整和无需调整的提示,这将在本节中讨论。 **基于LLM的任务导向对话系统 **

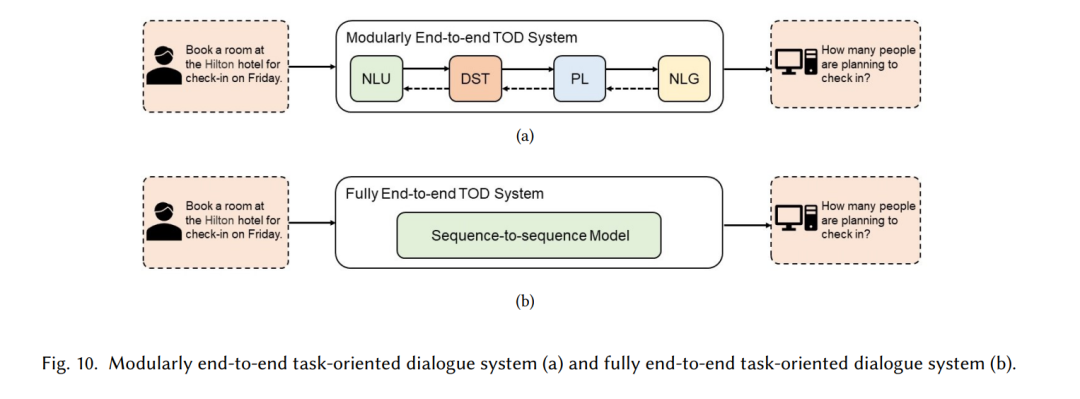

任务导向对话(TOD)系统通过交互式对话帮助用户实现特定领域相关的目标,例如酒店预订或餐厅查询。由于其显著的实用性,这项技术近年来受到了研究人员越来越多的关注。一般来说,TOD可以分为基于流水线的TOD和端到端TOD。在本节中,我们将全面介绍基于LLM的TOD。 如图9所示,基于流水线的TOD系统包括四个相连的模块:(1) 自然语言理解(NLU),用于提取用户意图和填充槽位;(2) 对话状态跟踪(DST),基于流水线的TOD中的一个关键模块,用于根据NLU模块的输出和对话的历史输入来跟踪当前轮次的对话状态;(3) 策略学习(PL),根据DST模块生成的对话状态确定后续行动;(4) 自然语言生成(NLG),基于流水线的TOD系统中的最后一个模块,将PL模块生成的对话行动转换为易于理解的自然语言。对话管理器(DM)是基于流水线的TOD系统的中心控制器,由DST模块和PL模块组成。

**基于LLM的开放领域对话系统 **

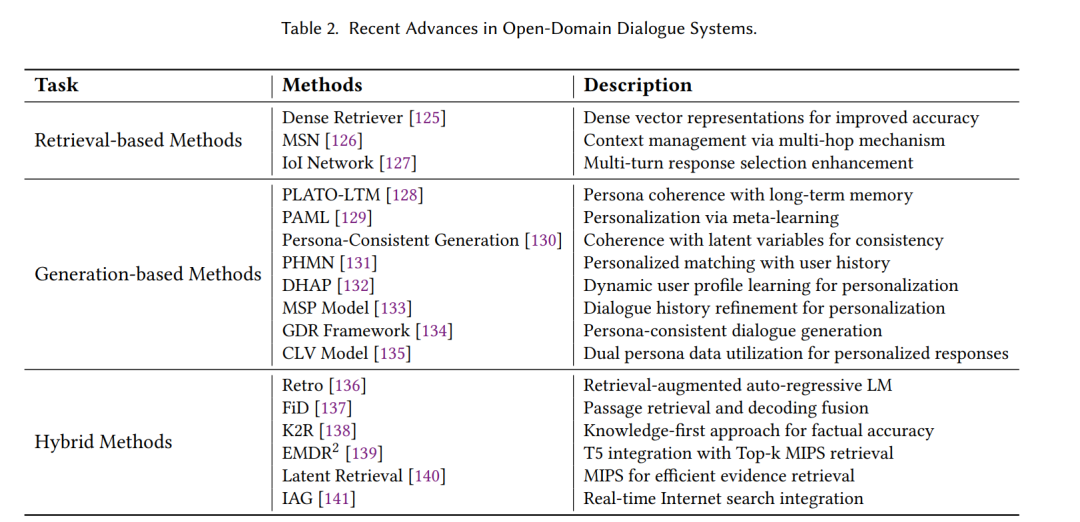

开放领域对话(ODD)系统旨在不针对特定任务或目标的情况下,就广泛的话题与用户进行对话。虽然任务导向对话(TOD)专注于完成特定任务,ODD旨在提供连贯且与上下文相关的响应,覆盖用户提出的任何话题。ODD主要分为三种方法:基于检索的方法,从预定义的集合中选择响应;基于生成的方法,动态生成响应;以及混合方法,结合检索和生成以优化对话结果。表2展示了这三种方法在ODD系统领域内的最新进展。

**结论 **

近年来,大型语言模型(LLMs)的迅速发展将多轮对话任务推向了自然语言处理研究的前沿。本文深入探讨了基于LLM的多轮对话系统的研究。它首先根据模型结构对常见的LLMs进行分类,并介绍了将LLMs适配到各种子任务的方法,包括微调和提示工程。随后,它讨论了基于LLM的多轮对话系统的两个主要类别:基于LLM的TOD系统和基于LLM的ODD系统。接着,本文概述了从多轮对话系统输出中得到的评估指标,这些指标有助于评估和理解LLMs的对话能力。此外,它还突出了近年来在TOD和OOD系统中广泛使用的数据集。最后,本文提出了一些开放问题,指出了基于LLM的多轮对话系统面临的主要挑战和未来研究方向。