在人工智能(AI)的发展历程中,高质量数据对于各种深度学习模型(如 ImageNet 对 AlexNet 和 ResNet)起到了重要的推动作用。近年来,相较于设计更为复杂的神经网络结构(model-centric),人工智能社区的关注点逐渐转向了以数据为中心的方法(data-centric)。这一方法注重更有效地处理数据,以增强神经模型的性能。与此同时,图机器学习领域也取得了显著的进展。然而,对于图数据的内在特性,包括质量、多样性、安全性等方面的研究却相对较少。

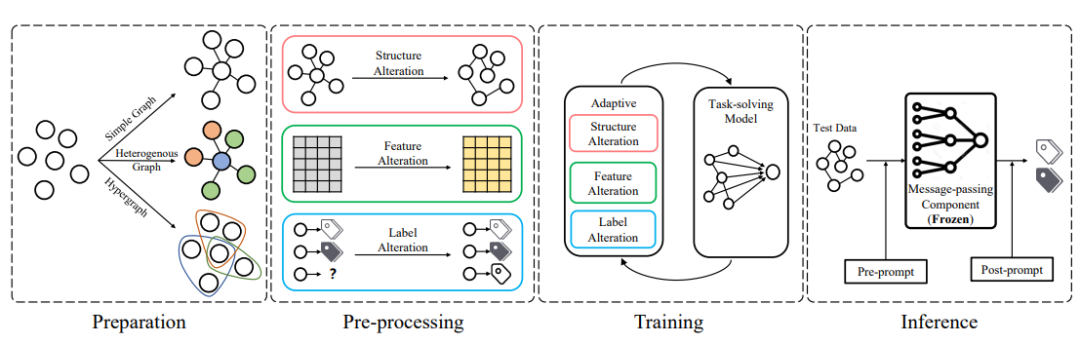

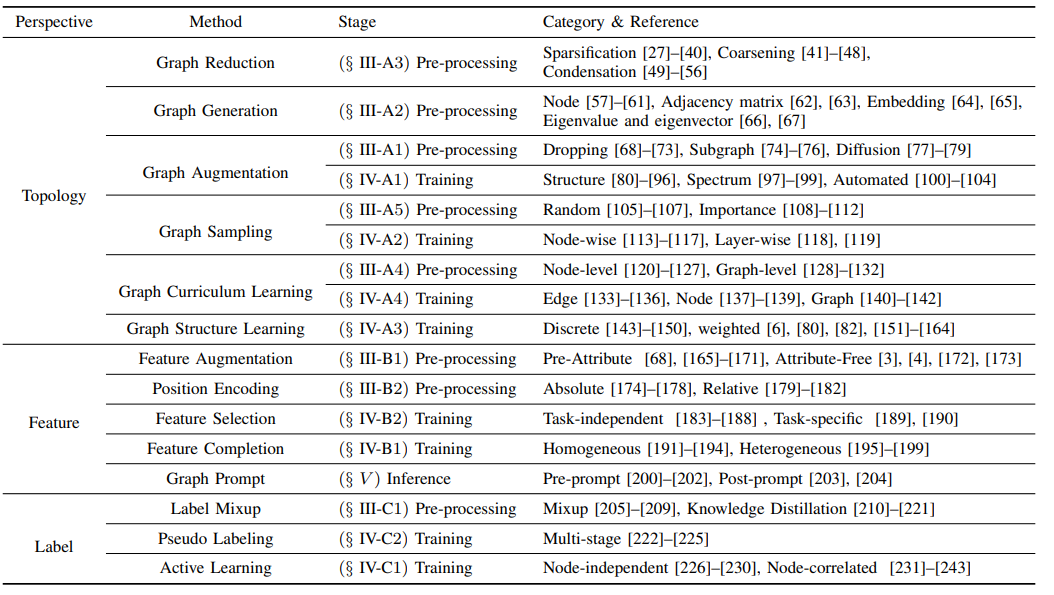

近日,北邮GAMMA Lab师生发布了一篇名为“Data-centric Graph Learning: A Survey”的文章,从数据中心的视角全面回顾了图学习方法,并旨在回答三个关键问题:(1) 何时修改图数据,(2) 需要修改图数据的哪部分来充分发挥各种图模型的潜力,以及(3) 如何保护图模型免受有问题的数据影响。

标题:Data-centric Graph Learning: A Survey 作者:Yuxin Guo*, Deyu Bo*, Cheng Yang†, Zhiyuan Lu, Zhongjian Zhang, Jixi Liu, Yufei Peng, Chuan Shi† 链接:https://arxiv.org/pdf/2310.04987.pdf 简介:在过去的十年里,与图相关的研究取得了显著的进展,这得益于图模型方面的创新,包括从图核到图嵌入的多种方法,及以图神经网络为代表的最新技术。但相反,很少有研究关注图数据的内在特性,包括质量、多样性、安全性等。 人工智能的革命一般是由大量高质量数据的可用性引发的,随后才是强大的模型。一个典型的例子是ImageNet的成功,对深度卷积神经网络如AlexNet的发展产生了重大贡献。随着对数据重要性认识的不断提升,最近,人工智能社区的关注重心从以模型为中心(model-centric)的方法转向了以数据为中心(data-centric)的方法。新兴的以数据为中心的人工智能强调产生适当的数据以提高给定模型的性能。 那么,如何处理图数据才能释放图模型的全部潜力?一个好的答案可以帮助我们理解图数据与图模型之间的关系。然而,与图像和文字等欧几里得数据不同,图的不规则性质对以数据为中心的图学习提出了几个问题: 首先,我们应该何时修改图数据以使图模型受益?图数据修改可能发生在图学习的不同阶段。例如,在训练之前,我们可以启发式地扰动边,而在训练过程中,我们还可以从节点表示中估计新的图结构。其次,我们应该修改图数据的哪一部分?图数据涉及各种结构,包括边、节点、特征和标签,这些部分都在图表示学习中发挥着重要作用。最后,我们应该如何防止图模型受到有问题的图数据的影响?由于手动定义的关系和特征,图数据不可避免地会引入噪音和偏差,使得模型变得不可靠。