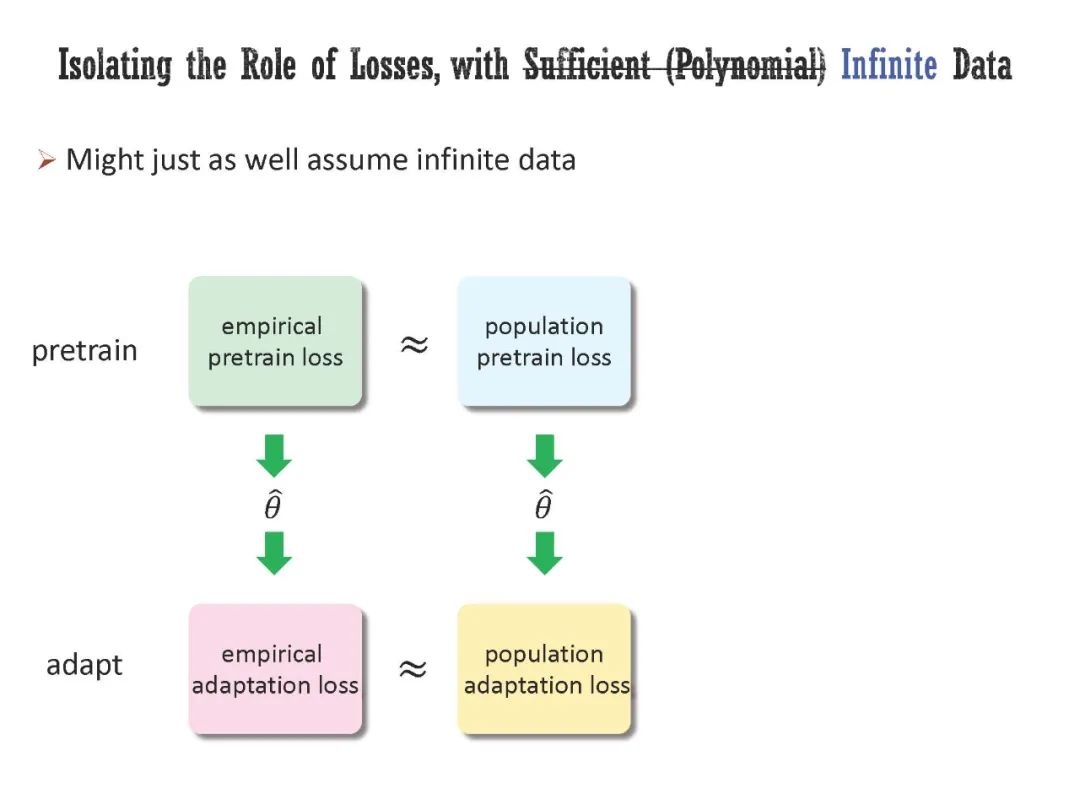

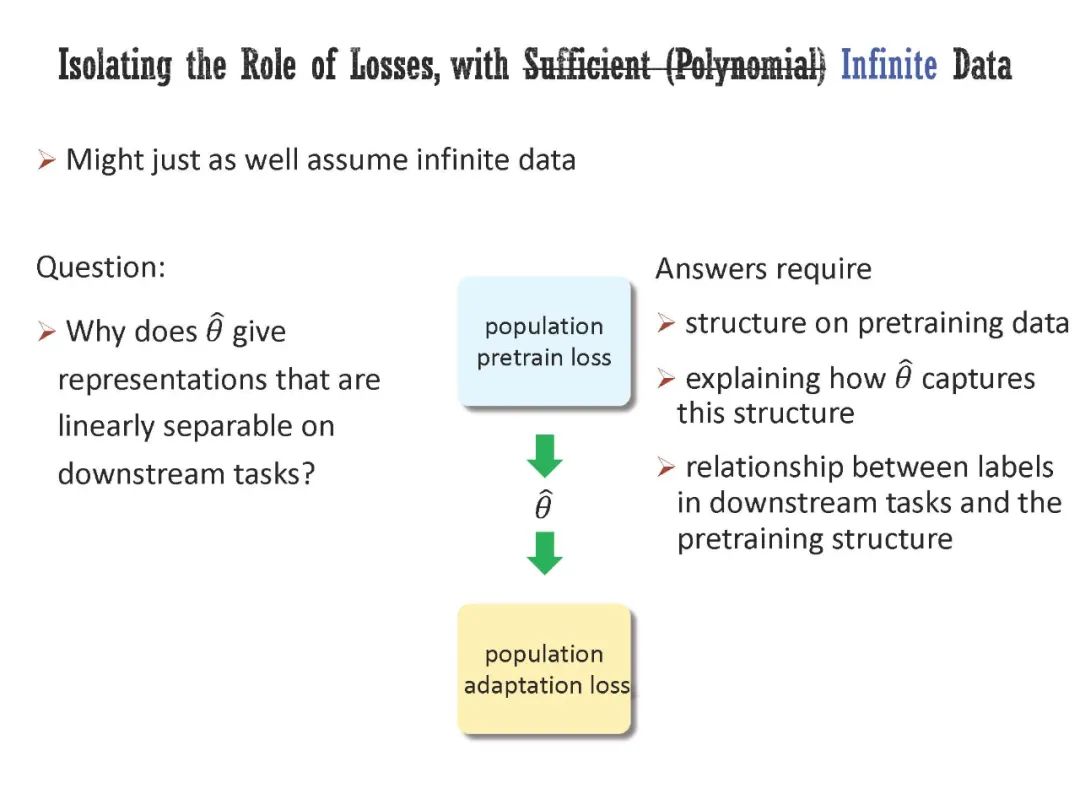

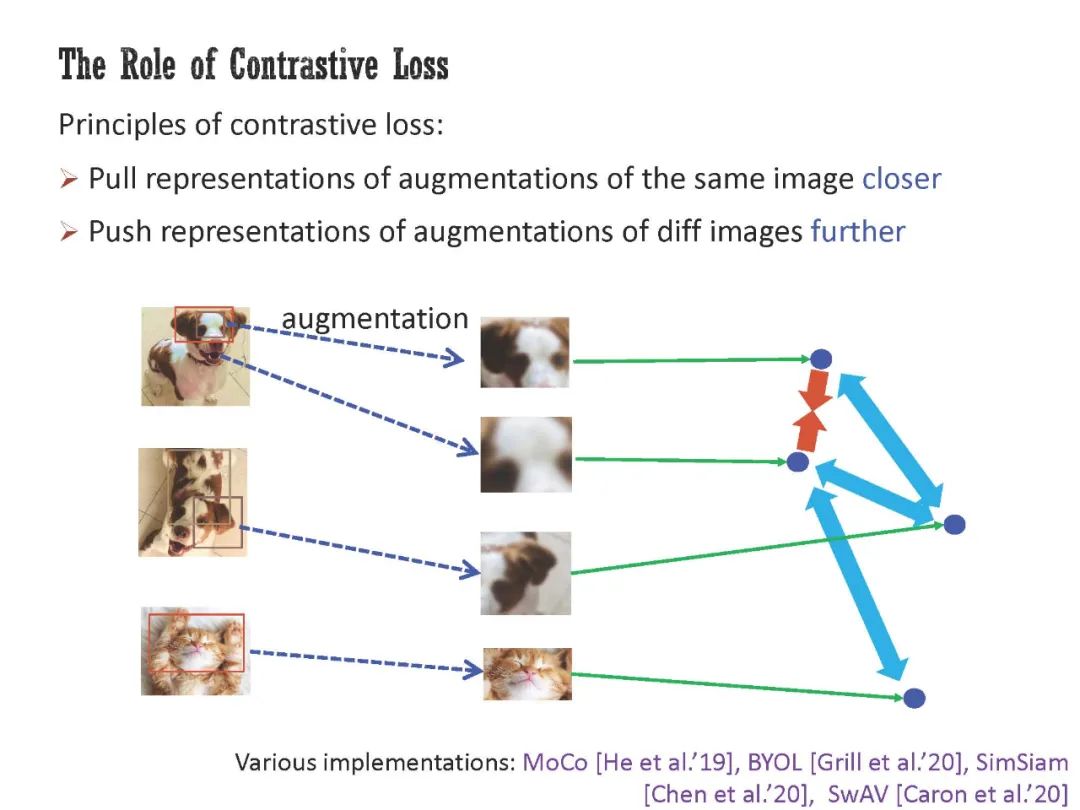

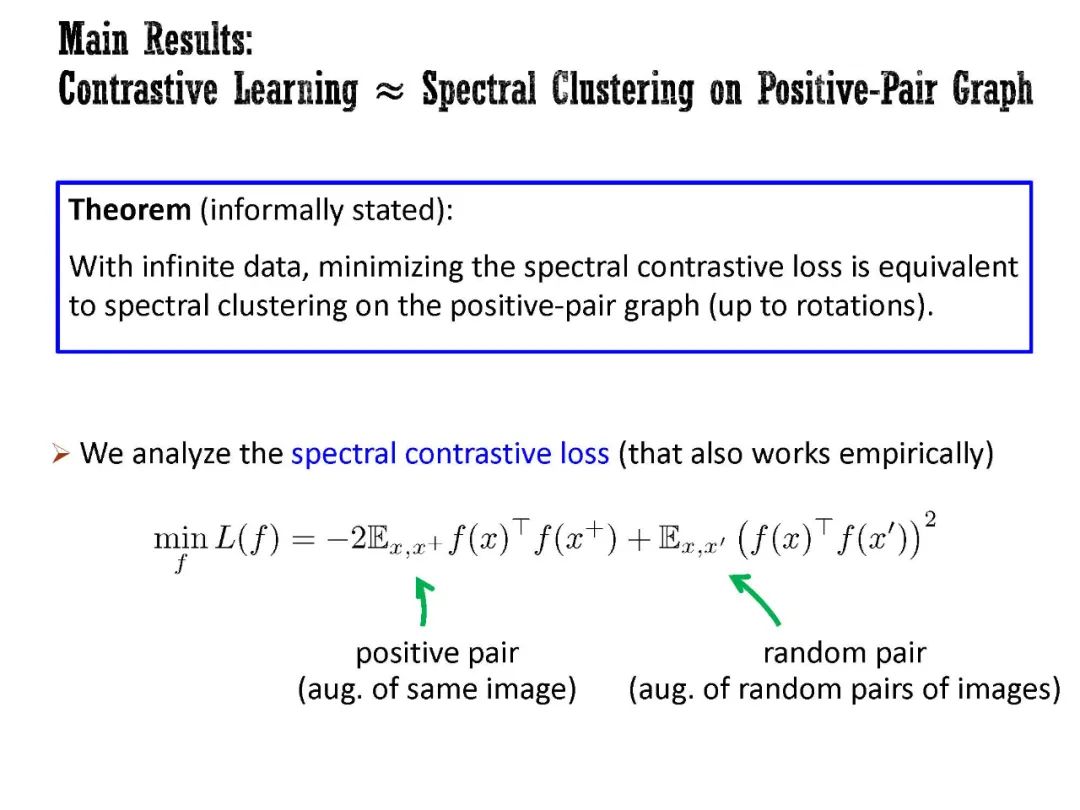

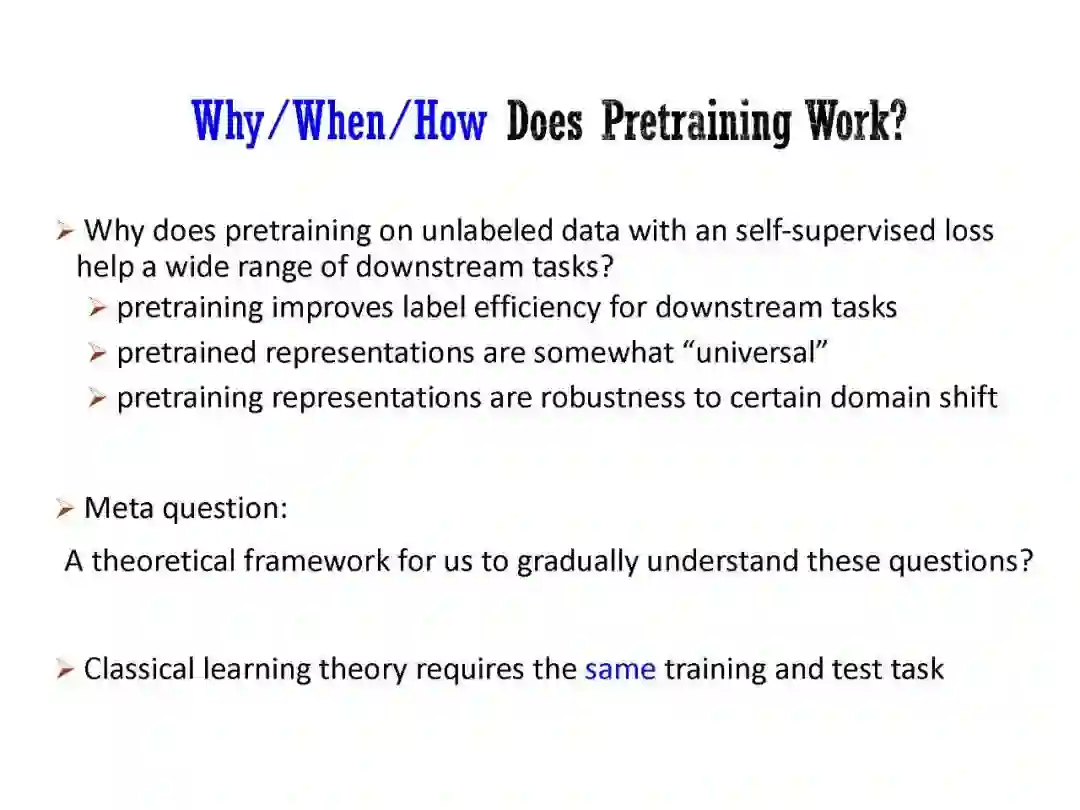

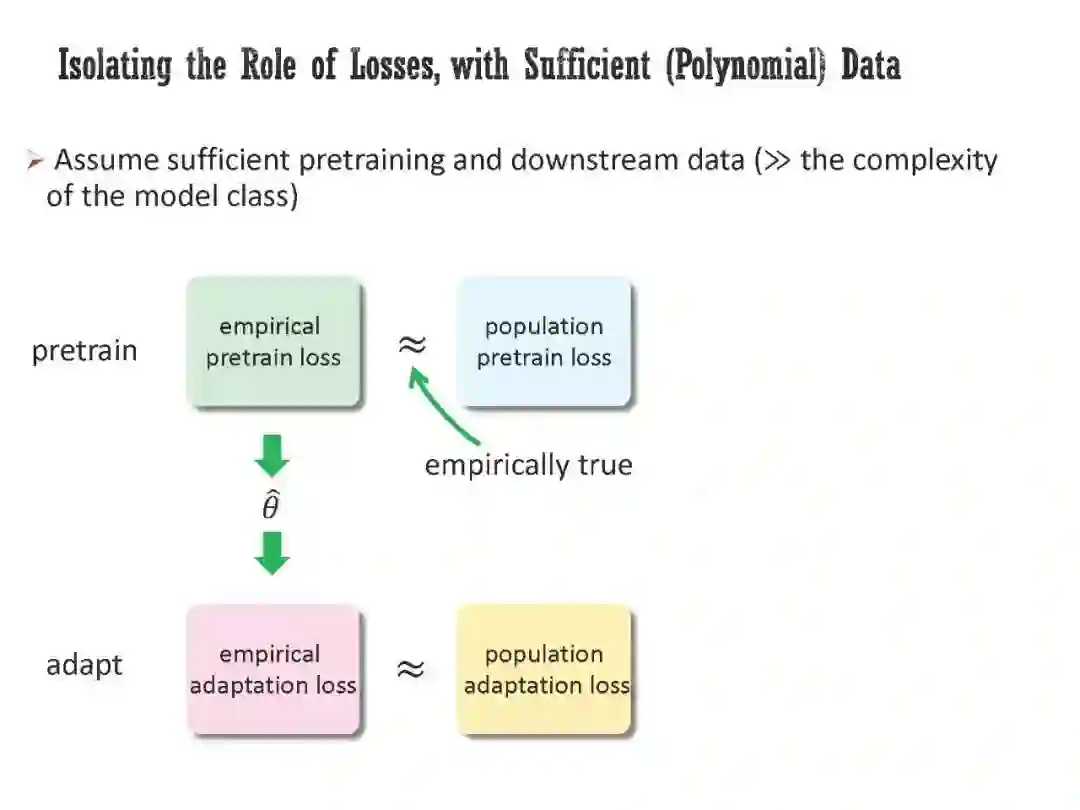

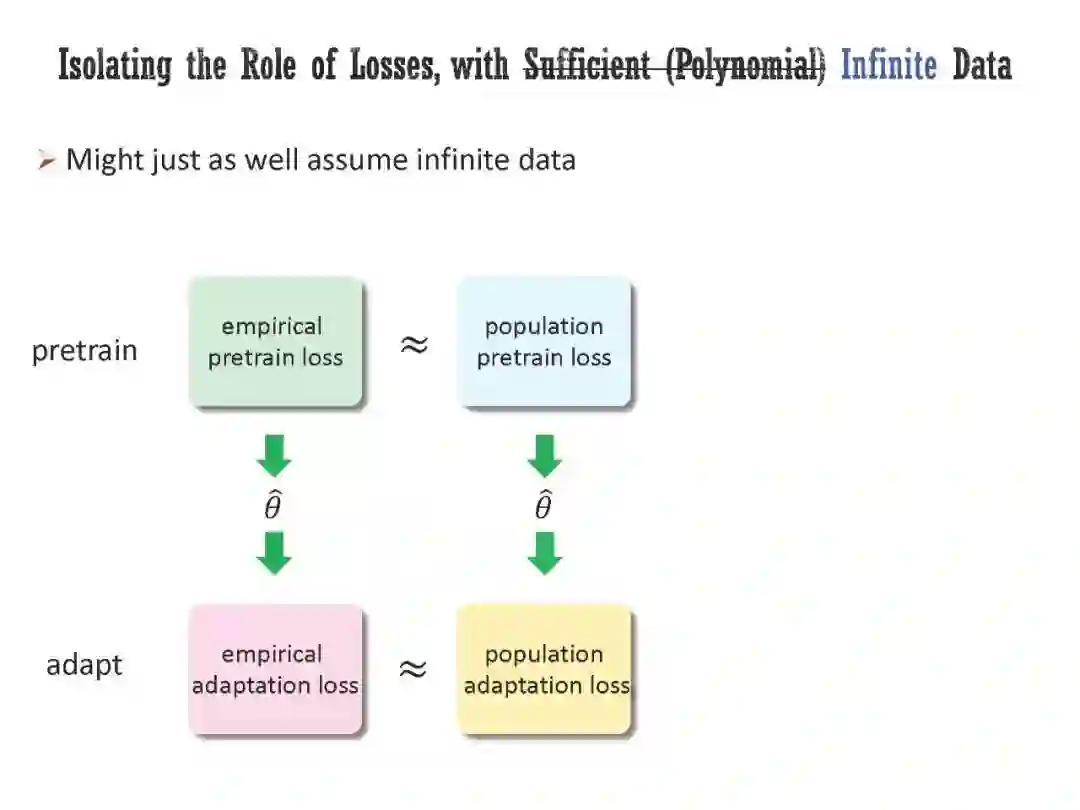

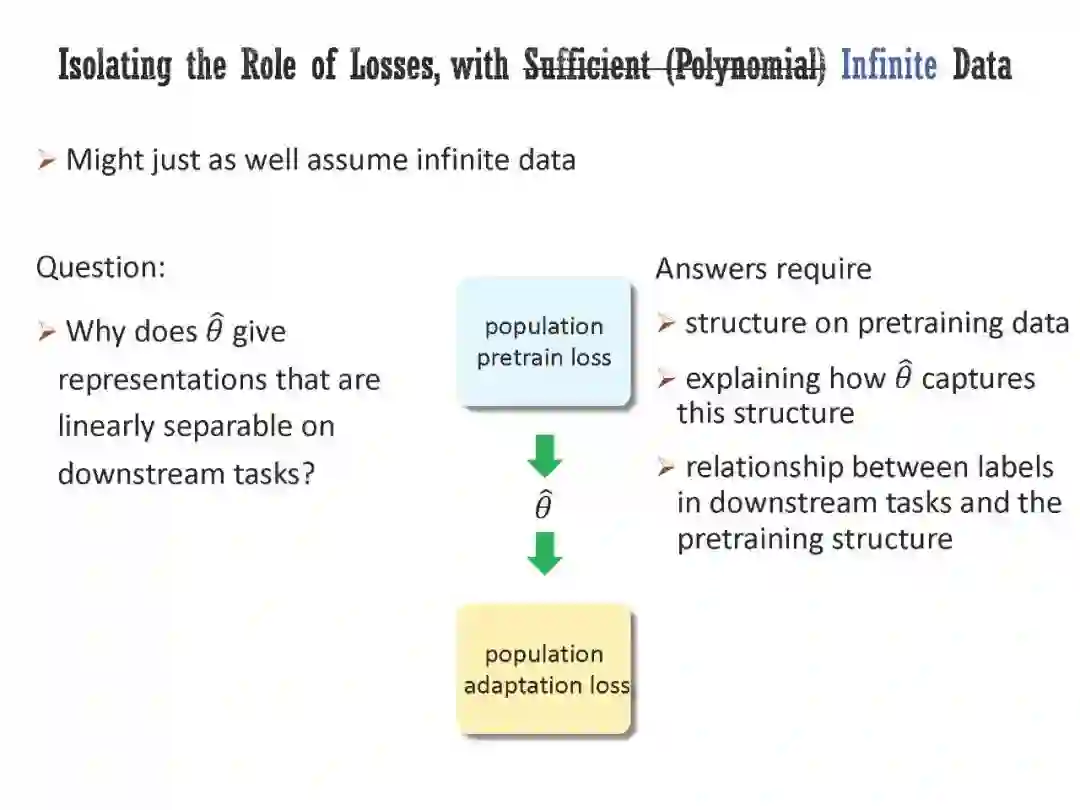

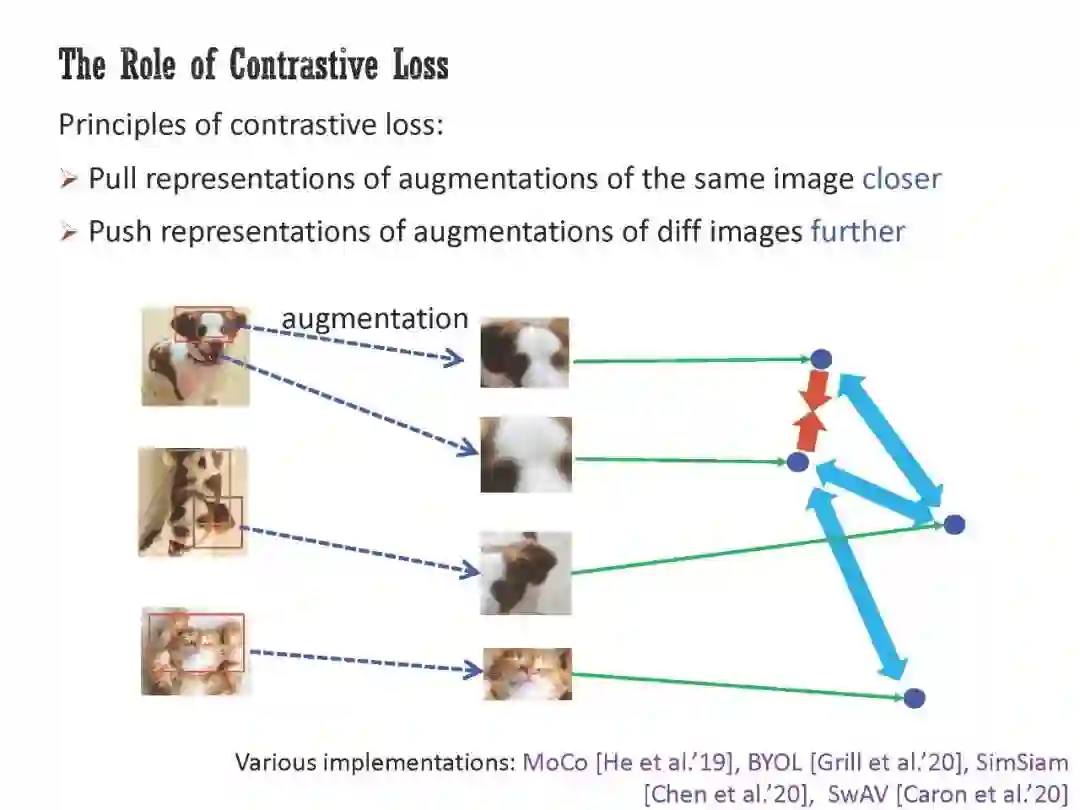

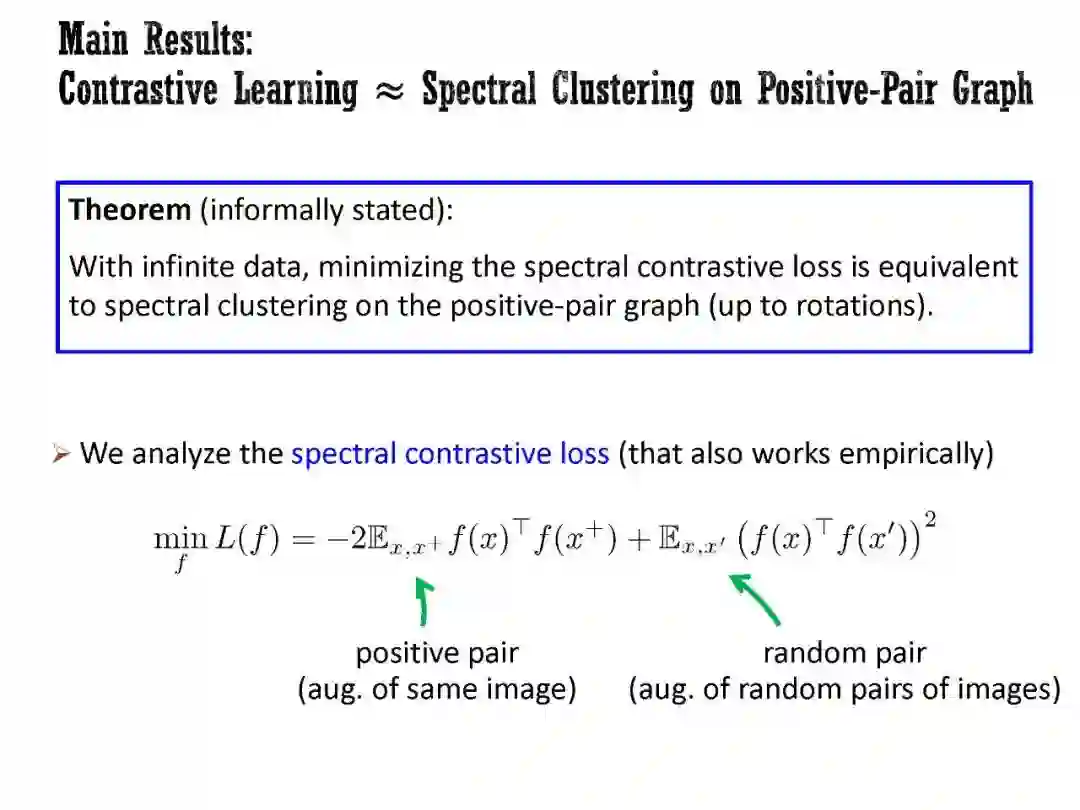

工智能正在经历范式转变,一些经过自监督预训练、然后适应广泛下游任务的模型正在兴起。然而,它们的工作原理在很大程度上仍然是个谜;经典的学习理论无法解释为什么对无监督任务的预训练可以帮助许多不同的下游任务。本次演讲将首先研究预训练损失在从未标记数据中提取有意义的结构信息方面的作用,特别是在无限数据状态下。具体来说,我将展示对比损失可能产生的嵌入,其欧氏距离捕获了原始数据之间的流形距离(或者更一般地说,所谓的正对图的图距离)。此外,嵌入空间中的方向对应于正对图中簇之间的关系。然后,我将讨论对实际预训练模型的行为进行清晰解释所必需的另外两个元素:体系结构的归纳偏差和优化器的隐式偏差。我将介绍两个最近正在进行的项目,其中我们(1)通过纳入体系结构的归纳偏差来加强之前的理论框架,(2)从经验和理论上证明优化器在预训练中的隐式偏差,即使使用无限的预训练数据。

马腾宇,2012届姚班校友,于普林斯顿大学获得博士学位,现为斯坦福大学计算机科学与统计学的助理教授。研究兴趣包括机器学习和深度学习,深度强化学习和高维统计。曾获得NIPS'16最佳学生论文奖,COLT'18最佳论文奖、ACM博士论文奖荣誉奖和2021斯隆研究奖。

成为VIP会员查看完整内容

相关内容

斯坦福大学(StanfordUniversity)位于加利福尼亚州,临近旧金山,占地35平方公里,是美国面积第二大的大学。它被公认为世界上最杰出的大学之一,相比美国东部的常春藤盟校,特别是哈佛大学、耶鲁大学,斯坦福大学虽然历史较短,但无论是学术水准还是其他方面都能与常春藤名校相抗衡。斯坦福大学企业管理研究所和法学院在美国是数一数二的,美国最高法院的9个大法官,有6个是从斯坦福大学的法学院毕业的。