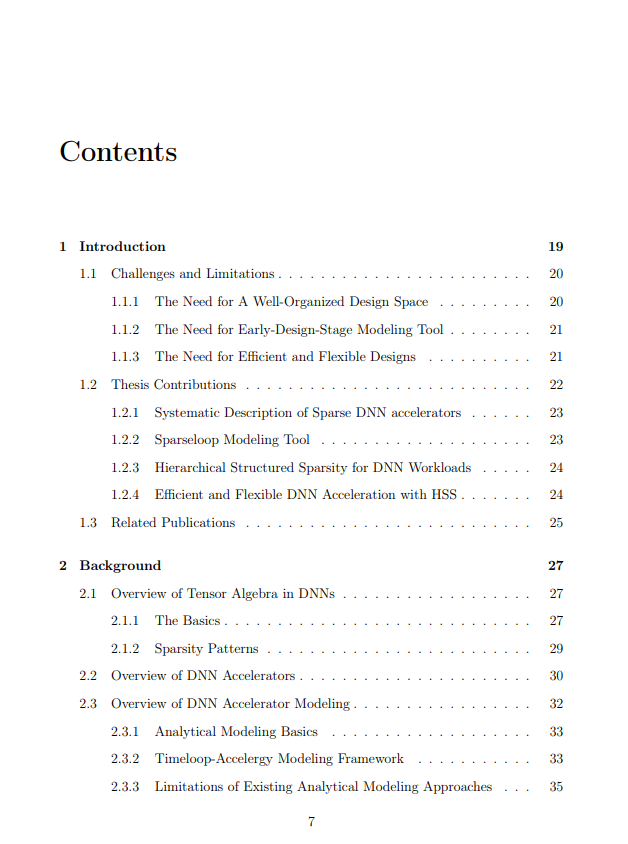

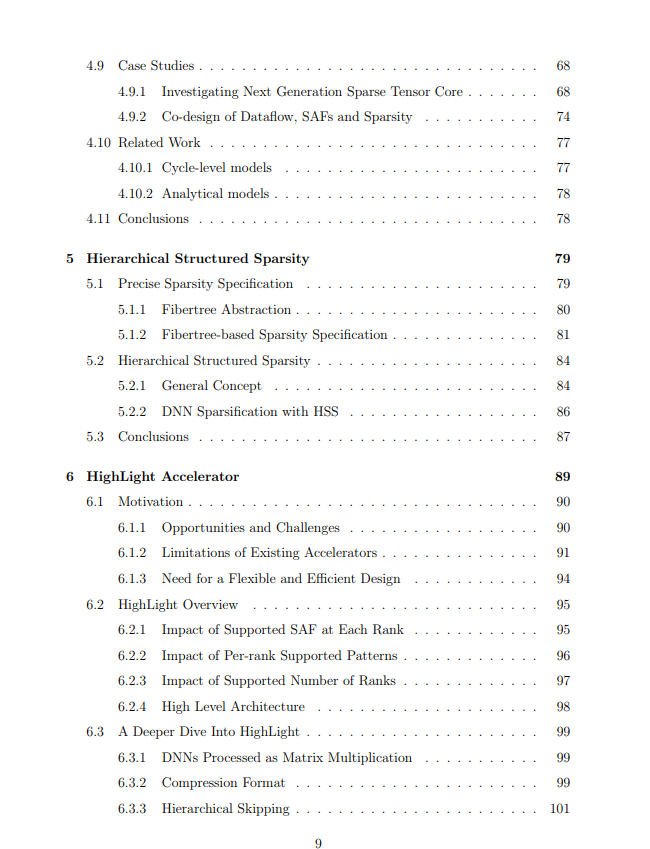

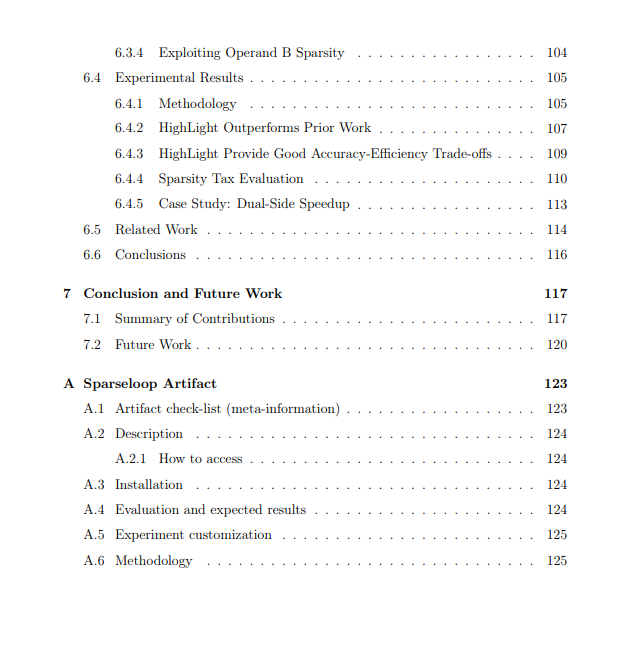

稀疏深度神经网络 (DNNs) 在许多数据和计算密集型应用中是一个重要的计算核心(例如,图像分类、语音识别和语言处理)。这些核心中的稀疏性激发了许多稀疏DNN加速器的发展。然而,尽管已经有大量的提议,但还没有一个系统的方法来理解、建模和开发各种稀疏DNN加速器。为了解决这些限制,这篇论文首先提出了一个稀疏性相关加速特性的分类法,以系统地理解稀疏DNN加速器的设计空间。基于这个分类法,它提出了Sparseloop,这是第一个用于稀疏DNN加速器的快速、准确和灵活评估的分析建模工具,使得在早期阶段可以探索庞大和多样的稀疏DNN加速器设计空间。在代表性的加速器设计和工作负载中,Sparseloop比周期级模拟实现了超过2000倍的建模速度,保持了相对的性能趋势,并达到了≤ 8%的平均建模误差。利用Sparseloop,这篇论文研究了设计空间,并提出了HighLight,一个高效且灵活的稀疏DNN加速器。具体来说,HighLight通过一个新的稀疏模式,称为分层结构稀疏性,来加速DNNs,关键的洞见是我们可以通过分层地组合简单的稀疏模式来高效地加速各种程度的稀疏性(包括密集型)。与现有的工作相比,HighLight在具有不同稀疏度的工作负载中实现了高达6.4倍的能量延迟乘积 (EDP) 改进,并且始终位于代表性DNNs的EDP-准确性帕累托前沿。

成为VIP会员查看完整内容

相关内容

麻省理工学院(Massachusetts Institute of Technology,MIT)是美国一所研究型私立大学,位于马萨诸塞州(麻省)的剑桥市。麻省理工学院的自然及工程科学在世界上享有极佳的盛誉,该校的工程系曾连续七届获得美国工科研究生课程冠军,其中以电子工程专业名气最响,紧跟其后的是机械工程。其管理学、经济学、哲学、政治学、语言学也同样优秀。

Arxiv

0+阅读 · 2023年9月28日

Arxiv

0+阅读 · 2023年9月27日

Arxiv

223+阅读 · 2023年4月7日