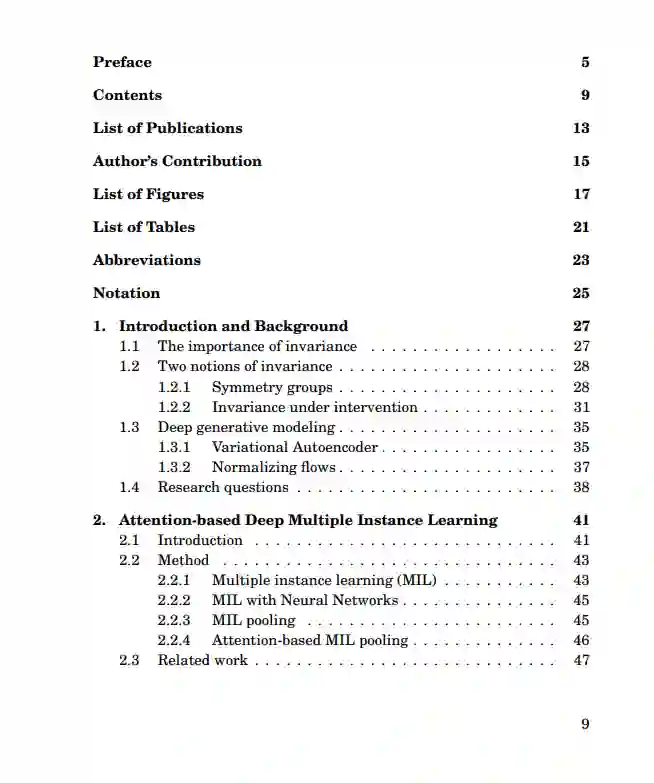

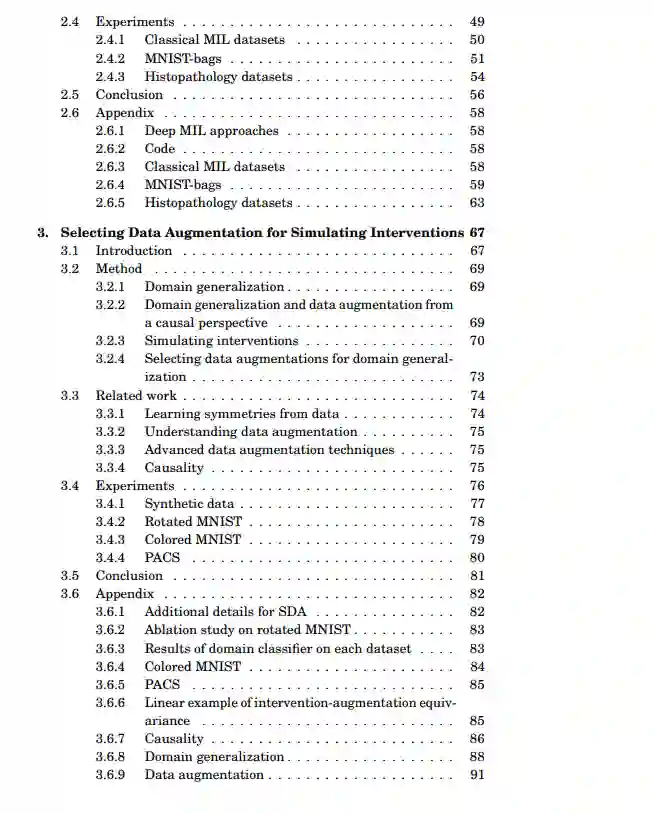

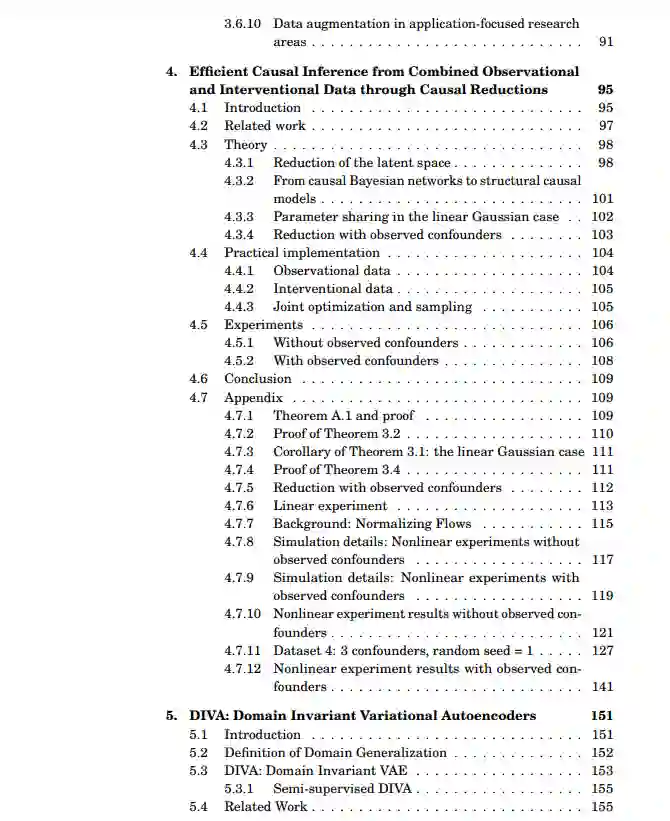

在这篇论文中,深度表示中的不变性,我们对学习不变性表示的问题提出了新的解决方案。我们采用两种不同的不变性概念。一个根植于对称群体,另一个根植于因果关系。最后,尽管它们是相互独立发展的,我们的目标是迈出统一这两个不变性概念的第一步。我们提出了一个基于神经网络的排列不变聚合算子,它对应于注意机制(第2节)。我们开发了一种新的集合分类方法。值得注意的是,所提出的基于注意力的算子的应用可以深入了解每个元素对集合标签的贡献。我们发现面向应用的研究领域,如医学成像或机器人,数据增强技术用于学习域不变特征。通过描述因果概念如何削弱观察到的域和任务标签之间的伪相关(第3节),我们演示了因果概念可以用来解释数据增强的成功。我们演示了数据增强可以作为模拟介入数据的工具。我们利用这些理论见解来推导一个简单的算法,它能够选择数据增强技术,从而导致更好的领域泛化。我们提出了一种新颖的因果减少方法(第4节),将任意数量的可能高维潜在混杂物替换为与治疗变量位于同一空间的单个潜在混杂物,而不改变因果模型所包含的观察和介入分布。在简化之后,我们使用一种灵活的转换类参数化简化的因果模型,称为规范化流。我们提出了一种从观测数据和介入数据联合估计参数化简化模型的学习算法。我们提出了域不变变分自动编码器(第5节),这是一种生成模型,通过学习三个独立的潜在子空间来解决域移位问题,一个用于域,一个用于类,一个用于任何残留变化。我们表明,由于我们的模型的生成特性,我们也可以合并来自已知或以前未见领域的未标记数据。

成为VIP会员查看完整内容

相关内容

阿姆斯特丹大学(荷兰文:Universiteit van Amsterdam,缩写为 UvA),成立于1632年,坐落在荷兰首都阿姆斯特丹市中心。阿姆斯特丹大学是历史悠久的著名世界百强学府,也是欧洲最大的综合性大学之一,拥有众多国际学生交流项目和优良的国际声誉。它同时是Universitas 21大学联盟、欧洲大学协会、欧洲研究型大学联盟与欧洲首都大学联盟成员之一。[1] 阿姆斯特丹大学有高质量的研究生和世界前沿的研究培训,同时本科教育也是世界最优秀的之一。它产生过6名诺贝尔奖得主,其中诺贝尔物理学家得主3名,和平、医学和化学奖得主各一名。

如今,作为研究型大学的阿姆斯特丹大学有超过30000名学生,5000名员工和285个研究项目(学士和硕士项目),其中许多都是用英语授课的。阿姆斯特丹大学拥有超过6亿欧元的预算,大学学院星罗棋布地分布在阿姆斯特丹城市的各个角落,目前该校设有七个学院:人文学院、社会与行为科学学院、商学院、法学院、理学院、医学院和牙医学院。

阿姆斯特丹大学的声誉享誉全球,被誉为“欧洲的哈佛”。在2020年度USNEWS世界大学排名中,位列世界第四十位,欧盟区位列前三。

Arxiv

37+阅读 · 2021年5月28日