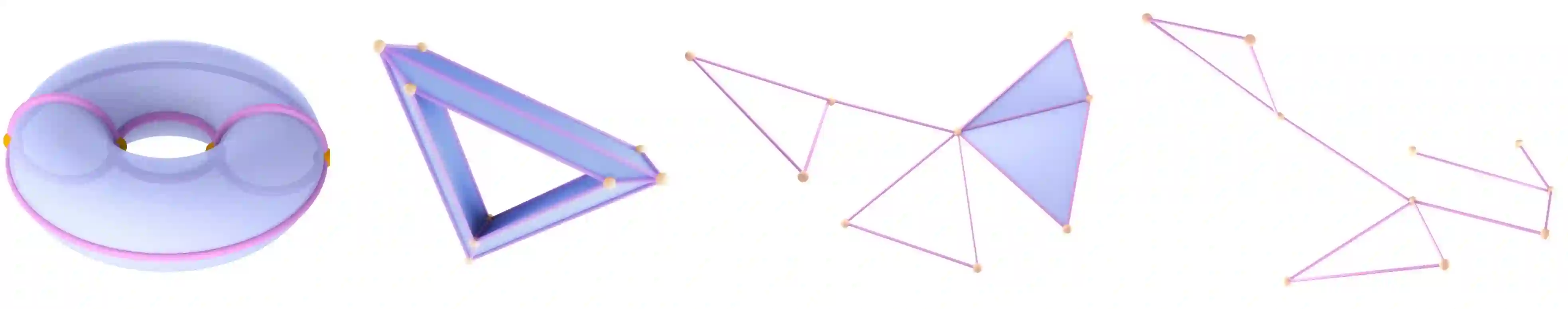

This paper introduces higher-order attention networks (HOANs), a novel class of attention-based neural networks defined on a generalized higher-order domain called a combinatorial complex (CC). Similar to hypergraphs, CCs admit arbitrary set-like relations between a collection of abstract entities. Simultaneously, CCs permit the construction of hierarchical higher-order relations analogous to those supported by cell complexes. Thus, CCs effectively generalize both hypergraphs and cell complexes and combine their desirable characteristics. By exploiting the rich combinatorial nature of CCs, HOANs define a new class of message-passing attention-based networks that unifies higher-order neural networks. Our evaluation on tasks related to mesh shape analysis and graph learning demonstrates that HOANs attain competitive, and in some examples superior, predictive performance in comparison to state-of-the-art neural networks.

翻译:本文介绍更上层关注网络(HOANs),这是在一般的更上层关注领域界定的新型神经网络,称为组合式神经网络(CC)。与高音相类似,CCs也承认在一系列抽象实体之间建立任意的类似关系。与此同时,CCs允许建立类似于细胞综合体所支持的更高层次关系。因此,CCs有效地将高音和细胞综合体统统化,并结合其理想特征。HOANs通过利用CCs丰富的组合性质,定义了一种新的基于信息传递关注的网络,统一了更上层神经网络。我们对与网形形状分析和图表学习有关的任务的评估表明,HOANs取得了竞争力,在某些例子中,与最先进的神经网络相比,预测性业绩优异。