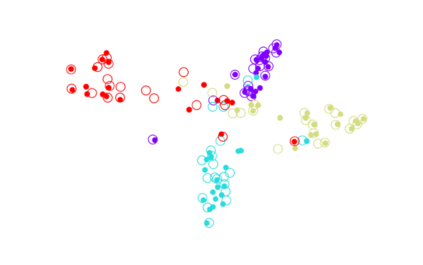

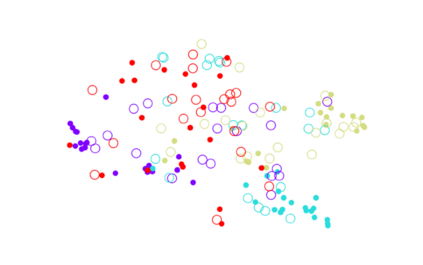

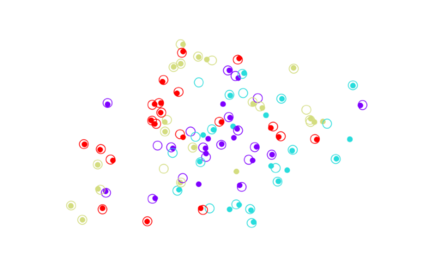

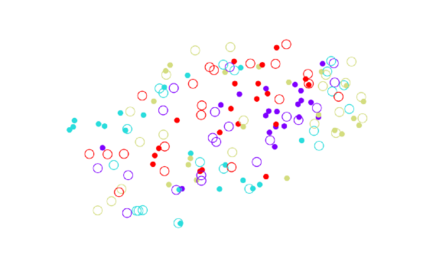

Classical theories of memory consolidation emphasize the importance of replay in extracting semantic information from episodic memories. However, the characteristic creative nature of dreams suggests that memory semantization may go beyond merely replaying previous experiences. We propose that rapid-eye-movement (REM) dreaming is essential for efficient memory semantization by randomly combining episodic memories to create new, virtual sensory experiences. We support this hypothesis by implementing a cortical architecture with hierarchically organized feedforward and feedback pathways, inspired by generative adversarial networks (GANs). Learning in our model is organized across three different global brain states mimicking wakefulness, non-REM (NREM) and REM sleep, optimizing different, but complementary objective functions. We train the model in an unsupervised fashion on standard datasets of natural images and evaluate the quality of the learned representations. Our results suggest that adversarial dreaming during REM sleep is essential for extracting memory contents, while perturbed dreaming during NREM sleep improves robustness of the latent representation to noisy sensory inputs. The model provides a new computational perspective on sleep states, memory replay and dreams and suggests a cortical implementation of GANs.

翻译:古老的记忆整合理论强调,在从偶发记忆中提取语义信息时,必须重新弹出语义信息。然而,典型的梦想的创造性性质表明,记忆的语义化可能不仅仅是重复以往的经验。我们建议,快速眼移动(REM)梦想对于通过随机结合相近记忆来创造新的、虚拟感官体验来高效的记忆解析至关重要。我们支持这一假设,在基因化对抗网络(GANs)的启发下,实施由分级组织进料进料和反馈路径组成的皮质结构。我们模型中的学习是由三个不同的全球大脑国家组织起来的,它们模仿醒悟性、非REM(NEM)和REM睡眠,优化不同但互补的目标功能。我们建议,在自然图像的标准数据集上以不受监督的方式对模型进行培训,并评价所学的表述质量。我们的结果表明,在REM睡眠期间的对抗性梦对于提取记忆内容至关重要,同时在NERM睡眠中进行纠缠的梦想改善潜在代表对感官感官投入的稳性。模型提供了一种新的计算视角,建议GAN的记忆力和梦境中的新思维。