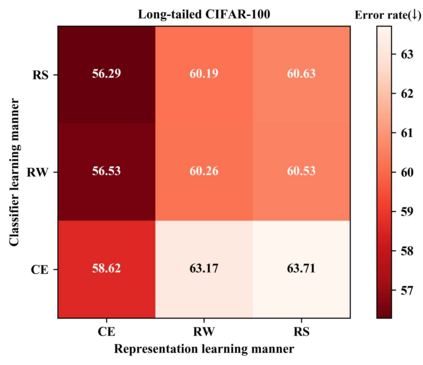

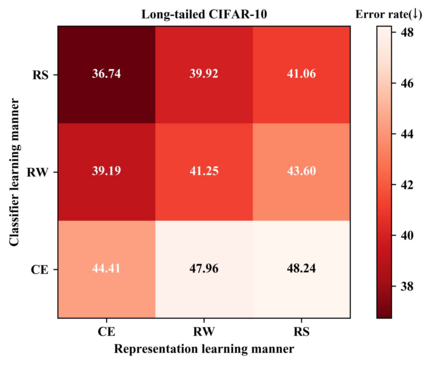

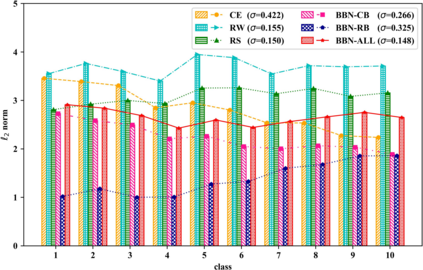

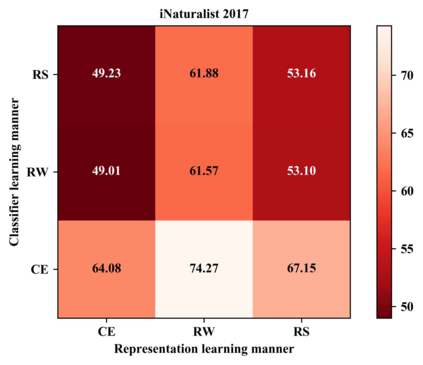

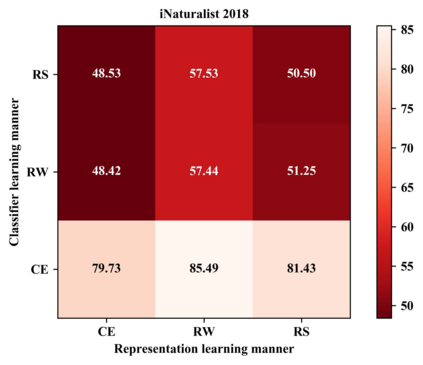

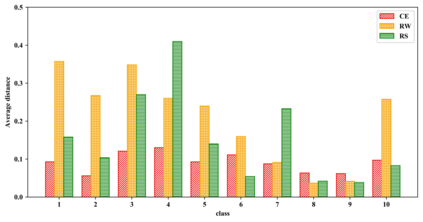

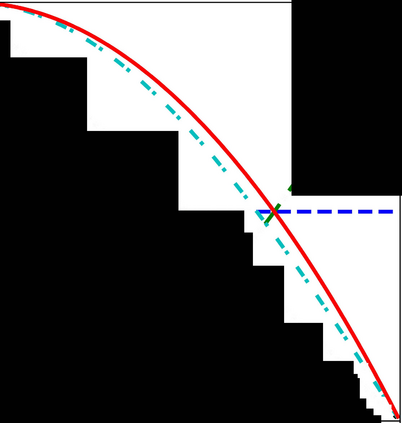

Our work focuses on tackling the challenging but natural visual recognition task of long-tailed data distribution (i.e., a few classes occupy most of the data, while most classes have rarely few samples). In the literature, class re-balancing strategies (e.g., re-weighting and re-sampling) are the prominent and effective methods proposed to alleviate the extreme imbalance for dealing with long-tailed problems. In this paper, we firstly discover that these re-balancing methods achieving satisfactory recognition accuracy owe to that they could significantly promote the classifier learning of deep networks. However, at the same time, they will unexpectedly damage the representative ability of the learned deep features to some extent. Therefore, we propose a unified Bilateral-Branch Network (BBN) to take care of both representation learning and classifier learning simultaneously, where each branch does perform its own duty separately. In particular, our BBN model is further equipped with a novel cumulative learning strategy, which is designed to first learn the universal patterns and then pay attention to the tail data gradually. Extensive experiments on four benchmark datasets, including the large-scale iNaturalist ones, justify that the proposed BBN can significantly outperform state-of-the-art methods. Furthermore, validation experiments can demonstrate both our preliminary discovery and effectiveness of tailored designs in BBN for long-tailed problems. Our method won the first place in the iNaturalist 2019 large scale species classification competition, and our code is open-source and available at https://github.com/Megvii-Nanjing/BBN.

翻译:我们的工作重点是应对长期数据分发具有挑战性但自然视觉识别的任务(即,少数类占据了大部分数据,而大多数类则很少有样本),在文献中,班级再平衡战略(例如,重新加权和再抽样)是缓解处理长期问题极端不平衡现象的突出而有效的方法。在本文中,我们首先发现这些重新平衡方法之所以能够达到令人满意的确认准确度,是因为它们能够大大促进深度网络的分类学。但与此同时,它们会意外地损害所学到的深度特征的代表性能力。因此,我们提议建立一个统一的双边-班奇网络(BBN),同时关注代表性学习和分类学习(例如,重排重标),每个分支都单独履行自己的职责。特别是,我们的BNB模型还进一步配备了一种新的累积学习战略,目的是首先了解普遍模式,然后逐渐关注尾部数据。在四个基准数据集上进行广泛的实验,包括大型的i-Natriblic 和大规模IMI-I-I-I-I-I-IAR-IAR-I-I-I-IL 初步测试方法,可以明显地证明我们提出的大规模进行B-IL-IL-IL-IL-IL-I-I-I-IL-I-I-IL-IL-IL-IL-IL-I-I-I-I-I-IL-I-I-I-I-I-I-I-I-ID-I-I-I-I-I-IL-I-IL-ID-I-I-I-I-I-ID-I-I-Id-Id-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-