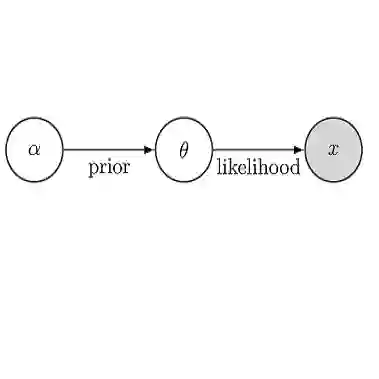

The l1-regularization is very popular in high dimensional statistics -- it changes a combinatorial problem of choosing which subset of the parameter are zero, into a simple continuous optimization. Using a continuous prior concentrated near zero, the Bayesian counterparts are successful in quantifying the uncertainty in the variable selection problems; nevertheless, the lack of exact zeros makes it difficult for broader problems such as the change-point detection and rank selection. Inspired by the duality of the l1-regularization as a constraint onto an l1-ball, we propose a new prior by projecting a continuous distribution onto the l1-ball. This creates a positive probability on the ball boundary, which contains both continuous elements and exact zeros. Unlike the spike-and-slab prior, this l1-ball projection is continuous and differentiable almost surely, making the posterior estimation amenable to the Hamiltonian Monte Carlo algorithm. We examine the properties, such as the volume change due to the projection, the connection to the combinatorial prior, the minimax concentration rate in the linear problem. We demonstrate the usefulness of exact zeros that simplify the combinatorial problems, such as the change-point detection in time series, the dimension selection of mixture model and the low-rank-plus-sparse change detection in the medical images.

翻译:在高维统计中,I1常规化非常受欢迎 -- -- 它改变了选择哪个子子参数为零的组合问题,变成了简单的连续优化。使用连续的先前浓度接近于零,巴伊西亚对应方成功地量化了变量选择问题的不确定性;然而,缺乏精确的零使得很难解决更广泛的问题,如改变点检测和排名选择等。由于I1常规化的双重性限制了对l1球的制约,我们提出一个新的先期问题,将连续的分布投到l1球上。这在球的边界上创造了一个正概率,球的边界包括连续元素和精确的零。与前的加点不同,这一I1球预测是连续的,几乎可以区分的,使事后估计与汉密尔顿蒙特卡洛算法相适应。我们研究了各种特性,例如预测导致的数量变化,与先前的组合,线性问题中的微缩成集集率集中率。我们展示了精确的零的实用性,即简化组合式的组合式问题,例如混合物检测阶段的测序中测序中测序的微图像。

相关内容

Source: Apple - iOS 8