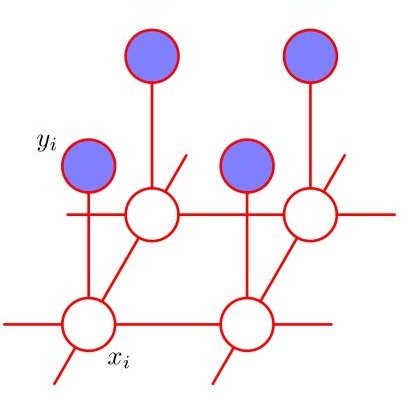

This paper presents a convex-analytic framework to learn sparse graphs from data. While our problem formulation is inspired by an extension of the graphical lasso using the so-called combinatorial graph Laplacian framework, a key difference is the use of a nonconvex alternative to the $\ell_1$ norm to attain graphs with better interpretability. Specifically, we use the weakly-convex minimax concave penalty (the difference between the $\ell_1$ norm and the Huber function) which is known to yield sparse solutions with lower estimation bias than $\ell_1$ for regression problems. In our framework, the graph Laplacian is replaced in the optimization by a linear transform of the vector corresponding to its upper triangular part. Via a reformulation relying on Moreau's decomposition, we show that overall convexity is guaranteed by introducing a quadratic function to our cost function. The problem can be solved efficiently by the primal-dual splitting method, of which the admissible conditions for provable convergence are presented. Numerical examples show that the proposed method significantly outperforms the existing graph learning methods with reasonable CPU time.

翻译:本文展示了一个从数据中学习稀有图形的解析框架。 虽然我们的问题配方是由使用所谓的组合图形 Laplacian 框架来扩展图形 lasso 的扩展所启发的, 但关键区别在于使用 $\ ell_ 1$ 标准的非convex 替代 $\ ell_ 1$ 标准, 以更好的解释性达到图形。 具体地说, 我们使用微弱的 convex 迷你形群( $\ ell_ 1$ 标准与 Huber 函数之间的差额) 来保证总体的共性。 问题可以通过原始分解法来有效解决, 其估计偏差低于$\ ell_ 1$ 。 在我们的框架中, Laplacian 图形在优化中被与其上三角部分相对应的矢量的线性变换所取代。 我们通过重新配置依靠 Moreau 的分解功能来保证整体的共性。 我们用原始分解法来有效解决问题, 问题可以通过原始分解法来有效解决,, 其中显示可被接受的趋同的条件。 。 Nmericalal exical exual expecal ex exol exm exol ex exmol ex exmol ex exmol exmol lections