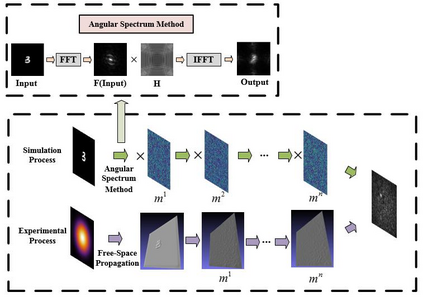

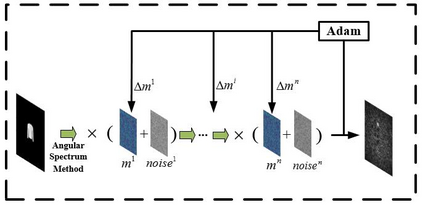

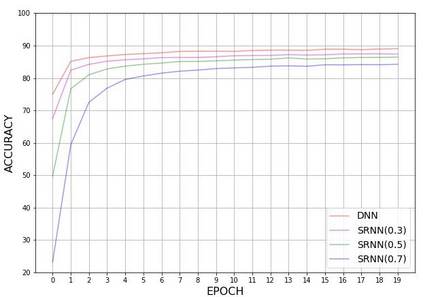

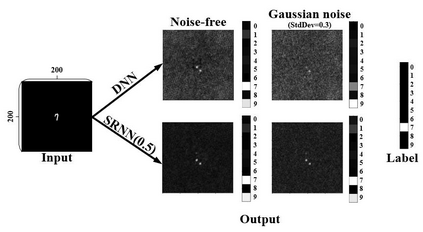

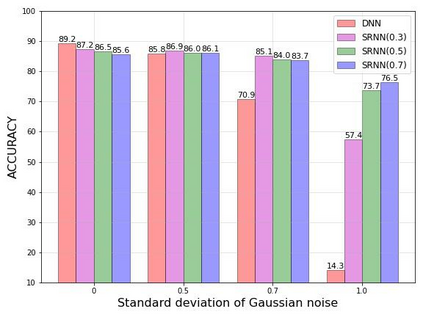

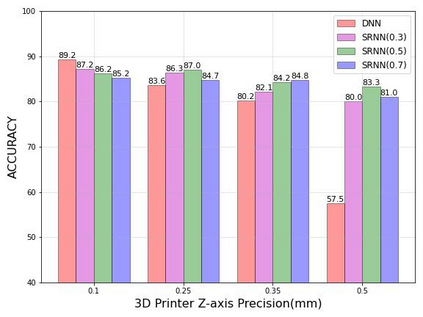

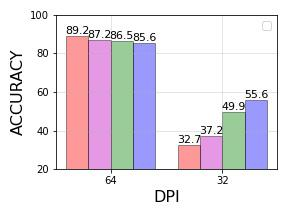

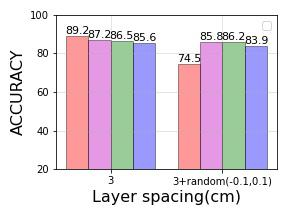

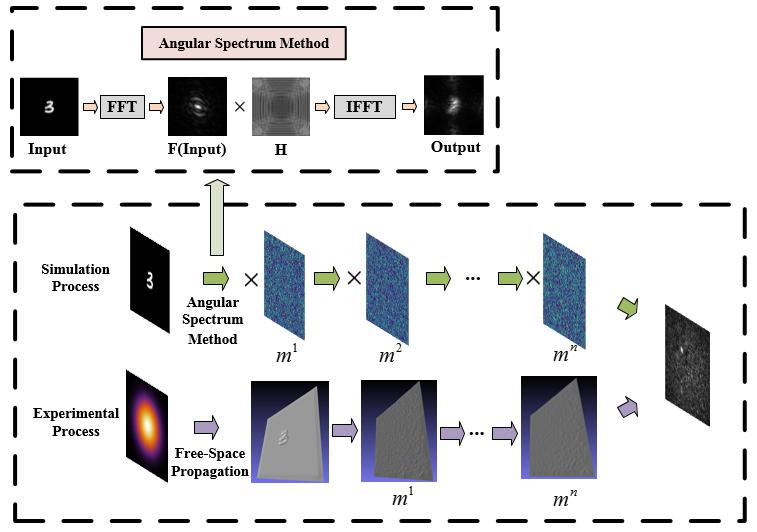

We propose a diffractive neural network with strong robustness based on Weight Noise Injection training, which achieves accurate and fast optical-based classification while diffraction layers have a certain amount of surface shape error. To the best of our knowledge, it is the first time that using injection weight noise during training to reduce the impact of external interference on deep learning inference results. In the proposed method, the diffractive neural network learns the mapping between the input image and the label in Weight Noise Injection mode, making the network's weight insensitive to modest changes, which improve the network's noise resistance at a lower cost. By comparing the accuracy of the network under different noise, it is verified that the proposed network (SRNN) still maintains a higher accuracy under serious noise.

翻译:根据我们所知,这是第一次在训练期间使用注射重力噪音来减少外部干扰对深学推断结果的影响。在拟议方法中,差异性神经网络学习输入图像与Wightnoise注射模式标签之间的映射,使网络的重量对微小变化不敏感,这些变化以较低的成本提高了网络的噪音抵抗力。通过比较不同噪音下网络的准确性,可以核实拟议的网络(SRNNN)在严重噪音下仍然保持更高的准确性。