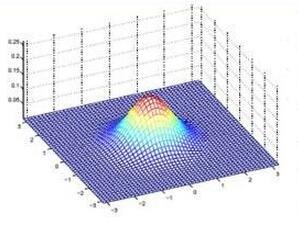

Despite AI's significant growth, its "black box" nature creates challenges in generating adequate trust. Thus, it is seldom utilized as a standalone unit in IoT high-risk applications, such as critical industrial infrastructures, medical systems, and financial applications, etc. Explainable AI (XAI) has emerged to help with this problem. However, designing appropriately fast and accurate XAI is still challenging, especially in numerical applications. Here, we propose a universal XAI model named Transparency Relying Upon Statistical Theory (TRUST), which is model-agnostic, high-performing, and suitable for numerical applications. Simply put, TRUST XAI models the statistical behavior of the AI's outputs in an AI-based system. Factor analysis is used to transform the input features into a new set of latent variables. We use mutual information to rank these variables and pick only the most influential ones on the AI's outputs and call them "representatives" of the classes. Then we use multi-modal Gaussian distributions to determine the likelihood of any new sample belonging to each class. We demonstrate the effectiveness of TRUST in a case study on cybersecurity of the industrial Internet of things (IIoT) using three different cybersecurity datasets. As IIoT is a prominent application that deals with numerical data. The results show that TRUST XAI provides explanations for new random samples with an average success rate of 98%. Compared with LIME, a popular XAI model, TRUST is shown to be superior in the context of performance, speed, and the method of explainability. In the end, we also show how TRUST is explained to the user.

翻译:尽管AI的大幅增长,它的“黑盒子”性质在培养充分信任方面带来了挑战。 因此,它很少被用作IOT高风险应用的独立单位,例如关键工业基础设施、医疗系统和金融应用等。 可解释的AI(XAI)已经出现,以帮助解决这一问题。然而,设计适当快速和准确的XAI仍然具有挑战性,特别是在数字应用方面。在这里,我们提议一个名为“透明依赖统计理论(TRust)”的通用XAI模型,它是模型性能、高性能和适合数字应用的。简而言之,TRust XAI模拟AI输出在AI系统中的统计行为。用系数分析将输入特性转换成一套新的潜在变量。我们使用相互的信息来排列这些变量,只挑选最有影响力的 XAI,并称之为“代表” 。然后我们使用多模式的大众分布来确定属于每一类的任何新样本的最终可能性。我们用TRIA模型来展示TRAI 的统计方法的有效性, 与II 的比较性能解释性能解释性能的精确性能是 X 。在IT II 的案例研究中, 展示了对II 的精确性电子安全数据样本中, 展示了 X 的精确数据, 的精确数据样本中, 展示了 X。