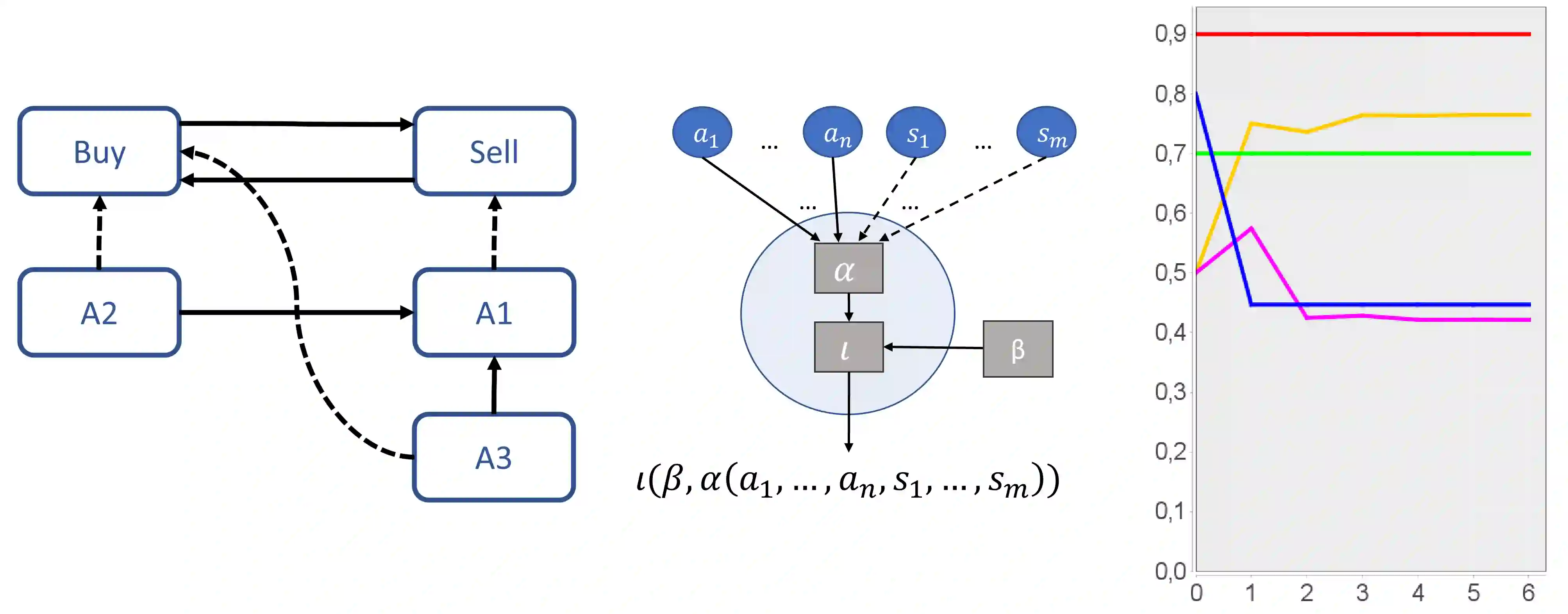

Gradual argumentation frameworks represent arguments and their relationships in a weighted graph. Their graphical structure and intuitive semantics makes them a potentially interesting tool for interpretable machine learning. It has been noted recently that their mechanics are closely related to neural networks, which allows learning their weights from data by standard deep learning frameworks. As a first proof of concept, we propose a genetic algorithm to simultaneously learn the structure of argumentative classification models. To obtain a well interpretable model, the fitness function balances sparseness and accuracy of the classifier. We discuss our algorithm and present first experimental results on standard benchmarks from the UCI machine learning repository. Our prototype learns argumentative classification models that are comparable to decision trees in terms of learning performance and interpretability.

翻译:渐进参数框架在加权图中代表参数及其关系。它们的图形结构和直观语义使它们成为解释机器学习的潜在有趣工具。最近人们注意到,它们的机械与神经网络密切相关,通过标准的深层次学习框架从数据中学习权重。作为概念的第一个证明,我们建议采用遗传算法,同时学习参数分类模型的结构。为了获得一个可以很好解释的模型,健身功能平衡了分类器的分散性和准确性。我们讨论我们的算法,并首次根据UCI机器学习库的标准基准提出实验结果。我们的原型在学习性能和可解释性方面可以与决策树相比的参数分类模型。