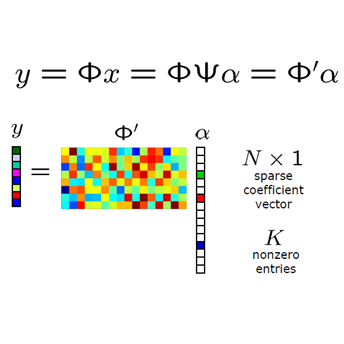

Mapping optimization algorithms into neural networks, deep unfolding networks (DUNs) have achieved impressive success in compressive sensing (CS). From the perspective of optimization, DUNs inherit a well-defined and interpretable structure from iterative steps. However, from the viewpoint of neural network design, most existing DUNs are inherently established based on traditional image-domain unfolding, which takes one-channel images as inputs and outputs between adjacent stages, resulting in insufficient information transmission capability and inevitable loss of the image details. In this paper, to break the above bottleneck, we first propose a generalized dual-domain optimization framework, which is general for inverse imaging and integrates the merits of both (1) image-domain and (2) convolutional-coding-domain priors to constrain the feasible region in the solution space. By unfolding the proposed framework into deep neural networks, we further design a novel Dual-Domain Deep Convolutional Coding Network (D3C2-Net) for CS imaging with the capability of transmitting high-throughput feature-level image representation through all the unfolded stages. Experiments on natural and MR images demonstrate that our D3C2-Net achieves higher performance and better accuracy-complexity trade-offs than other state-of-the-arts.

翻译:向神经网络绘图优化算法,深入发展的网络(DUNs)在压缩遥感方面取得了令人印象深刻的成功。从优化的角度来看,DUNs继承了一个由迭接步骤组成的定义明确和可解释的结构。然而,从神经网络设计的观点来看,大多数现有的DUNs是建立在传统的图像-域域的内在基础上,将一个通道图像作为相邻阶段之间的投入和产出,造成信息传输能力不足和图像细节不可避免地丧失。在本文件中,为了打破上述瓶颈,我们首先提出一个普遍的双成像双成像框架,这个框架一般用于反向成像,并结合(1)图像-主控和(2)革命-编码-域的优点,以限制解决方案空间中可行的区域。通过将拟议的框架发展到深神经网络,我们进一步设计了一个新的两流深层深层电磁共联网(D3C2-Net)成像,以便通过所有正在展开的阶段传播高通量地貌图像显示的能力。对自然和MDC-C-Net的图像进行实验,表明我们贸易的准确性比D-C-C-C-comfrental-real-lax the the d State-dal-stalfilations-dal-daltravelys-ds-dalations-dal-dal-dal-dal-dals-dals-dals-d-d-daldals-daldaldals-dals-dals3-dals-daldals3xxxxxxxx。