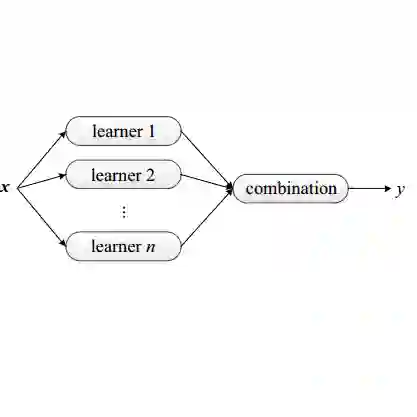

Deep Learning (DL) and specifically CNN models have become a de facto method for a wide range of vision tasks, outperforming traditional machine learning (ML) methods. Consequently, they drew a lot of attention in the neuroimaging field in particular for phenotype prediction or computer-aided diagnosis. However, most of the current studies often deal with small single-site cohorts, along with a specific pre-processing pipeline and custom CNN architectures, which make them difficult to compare to. We propose an extensive benchmark of recent state-of-the-art (SOTA) 3D CNN, evaluating also the benefits of data augmentation and deep ensemble learning, on both Voxel-Based Morphometry (VBM) pre-processing and quasi-raw images. Experiments were conducted on a large multi-site 3D brain anatomical MRI data-set comprising N=10k scans on 3 challenging tasks: age prediction, sex classification, and schizophrenia diagnosis. We found that all models provide significantly better predictions with VBM images than quasi-raw data. This finding evolved as the training set approaches 10k samples where quasi-raw data almost reach the performance of VBM. Moreover, we showed that linear models perform comparably with SOTA CNN on VBM data. We also demonstrated that DenseNet and tiny-DenseNet, a lighter version that we proposed, provide a good compromise in terms of performance in all data regime. Therefore, we suggest to employ them as the architectures by default. Critically, we also showed that current CNN are still very biased towards the acquisition site, even when trained with N=10k multi-site images. In this context, VBM pre-processing provides an efficient way to limit this site effect. Surprisingly, we did not find any clear benefit from data augmentation techniques. Finally, we proved that deep ensemble learning is well suited to re-calibrate big CNN models without sacrificing performance.

翻译:深度学习(DL)和具体地说,CNN模型已成为视觉任务范围广泛的事实标准方法,优于传统的机器学习(ML)方法。因此,在神经影像学领域,它们尤其引起了人们的关注,特别是对于表型预测或计算机辅助诊断。然而,大多数当前的研究通常处理小的单一位置队列,以及特定的预处理管道和自定义CNN体系结构,这使得它们难以进行比较。我们提出了对最近的最先进(SOTA)3D CNN的广泛基准测试,也评估了数据增强和深度集成学习的益处,同时评估了基于体素的形态学(VBM)预处理和准生数据的性能。实验是在一个包含10k个扫描样本的大型多站点3D脑解剖MRI数据集上进行的,包括3个具有挑战性的任务:年龄预测,性别分类和精神分裂症诊断。我们发现,所有模型在VBM图像上提供了显着更好的预测结果,而不是准生数据。随着训练集逐渐接近10k样本,这一发现也演变为准生数据几乎达到VBM的性能。此外,我们发现线性模型在VBM数据上表现与SOTA CNN相当。我们还证明了DenseNet和我们提出的轻量级版本tiny-DenseNet在所有数据制度上提供了很好的性能平衡。因此,我们建议将它们作为默认体系结构。关键是,我们还表明,即使用N = 10k多站点图像进行训练,当前的CNN仍然存在很强的获取位置倾向。在这种情况下,VBM预处理提供了一种有效的限制位置效果的方法。令人惊讶的是,我们发现没有从数据增强技术中获得明显的好处。最后,我们证明了深度集成学习适合对大型CNN模型进行重新校准而不损害性能。