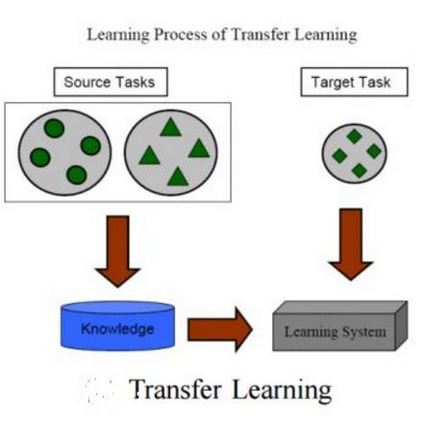

The availability of abundant labeled data in recent years led the researchers to introduce a methodology called transfer learning, which utilizes existing data in situations where there are difficulties in collecting new annotated data. Transfer learning aims to boost the performance of a target learner by applying another related source data. In contrast to the traditional machine learning and data mining techniques, which assume that the training and testing data lie from the same feature space and distribution, transfer learning can handle situations where there is a discrepancy between domains and distributions. These characteristics give the model the potential to utilize the available related source data and extend the underlying knowledge to the target task achieving better performance. This survey paper aims to give a concise review of traditional and current transfer learning settings, existing challenges, and related approaches.

翻译:近年来大量标签数据的存在导致研究人员采用了一种称为转让学习的方法,这种方法在难以收集新的附加说明数据的情况下利用现有数据。转让学习的目的是通过应用另一个相关来源数据提高目标学习者的业绩。与传统的机器学习和数据挖掘技术不同,传统机器学习和数据挖掘技术假定培训和测试数据来自同一特点的空间和分布,转让学习可以处理领域和分布之间存在差异的情况。这些特点使模型有可能利用现有的相关源数据,并将基本知识扩大到实现更好业绩的目标任务。本调查文件旨在简要审查传统和当前转让学习环境、现有挑战和相关方法。