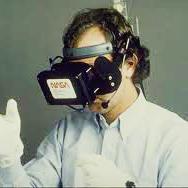

Advancements in heterogeneous computing technologies enable the significant potential of virtual reality (VR) applications. To offer the best user experience (UX), a system should adopt an untethered, wireless-network-based architecture to transfer VR content between the user and the content generator. However, modern wireless network technologies make implementing such an architecture challenging, as VR applications require superior video quality -- with high resolution, high frame rates, and very low latency. This paper presents OpenUVR, an open-source framework that uses commodity hardware components to satisfy the demands of interactive, real-time VR applications. OpenUVR significantly improves UX through a redesign of the system stack and addresses the most time-sensitive issues associated with redundant memory copying in modern computing systems. OpenUVR presents a cross-layered VR datapath to avoid redundant data operations and computation among system components, OpenUVR customizes the network stack to eliminate unnecessary memory operations incurred by mismatching data formats in each layer, and OpenUVR uses feedback from mobile devices to remove memory buffers. Together, these modifications allow OpenUVR to reduce VR application delays to 14.32 ms, meeting the 20 ms minimum latency in avoiding motion sickness. As an open-source system that is fully compatible with commodity hardware, OpenUVR offers the research community an opportunity to develop, investigate, and optimize applications for untethered, high-performance VR architectures.

翻译:多种计算机技术的进步使得虚拟现实应用具有巨大的潜力。 为了提供最佳用户经验(UX),一个系统应该采用一个不接合的、无线的网络基础架构,在用户和内容生成器之间传输VR内容。然而,现代无线网络技术使得这种架构的实施具有挑战性,因为VR应用需要高分辨率的视频质量,高框架率和非常低的悬浮。本文介绍了OpenUVR,这是一个开放源框架,使用商品硬件组件满足互动式实时VR应用程序的需求。OpenUVR通过系统应用程序的重新设计大大改进UX,并解决与在现代计算机系统中复制冗余记忆复制内容相关的最具有时间敏感性的问题。OpenUVR提供跨层次的VR数据路径,以避免系统各组成部分之间重复的数据操作和计算;OpenUVR定制网络堆,以消除因各层数据格式错配对数据格式而产生的不必要的记忆操作;OpenUR使用移动设备的反馈消除记忆缓冲。加,这些修改使OpenUR能够减少VR应用在现代计算机系统上重复性运动至14.32的频率。