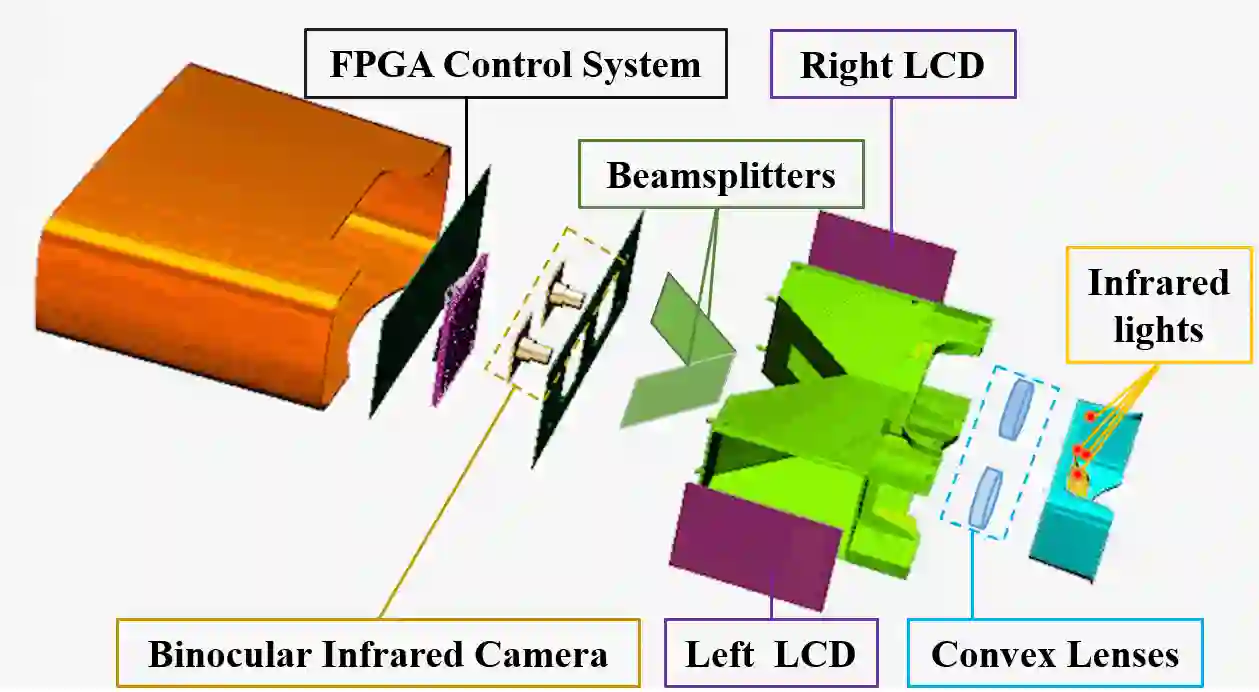

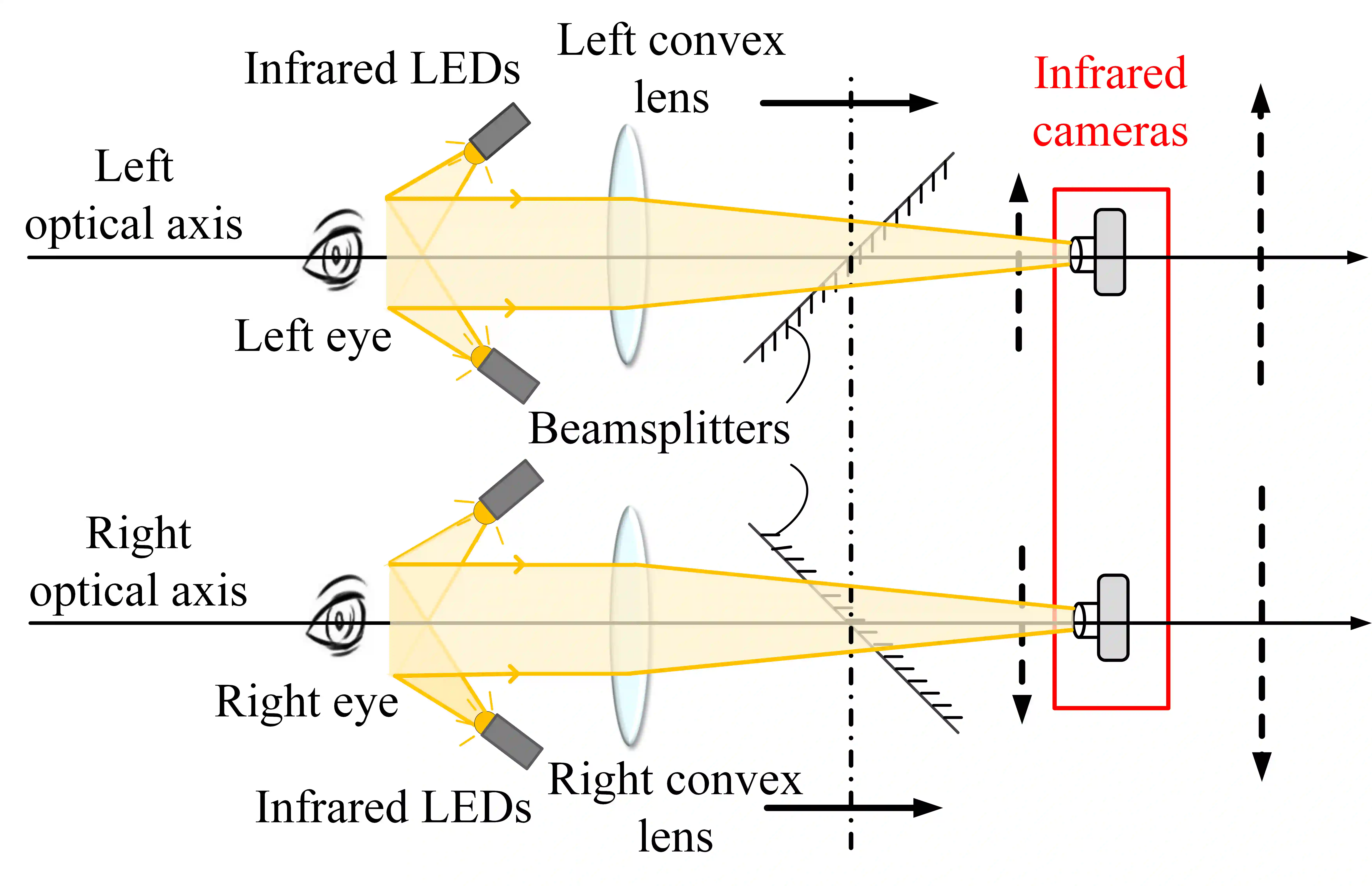

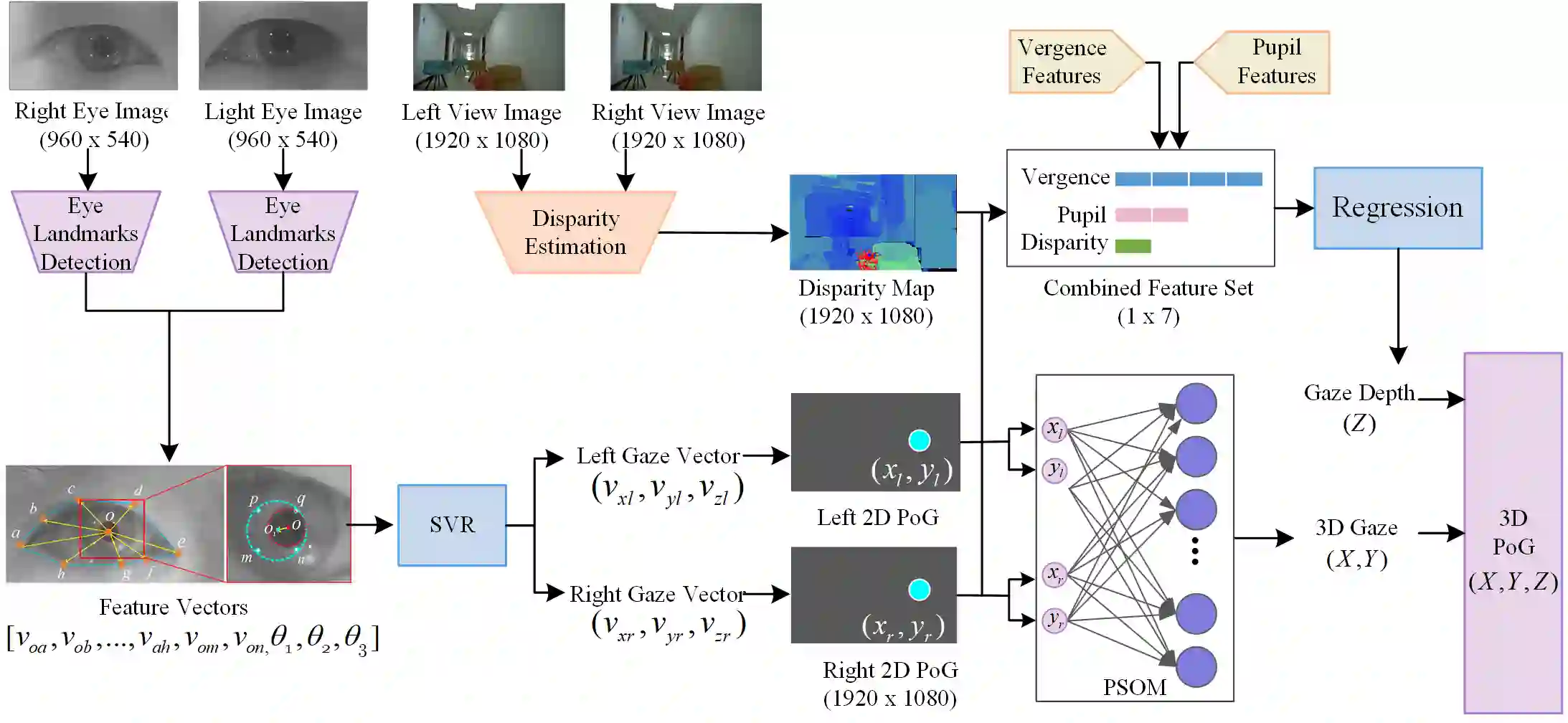

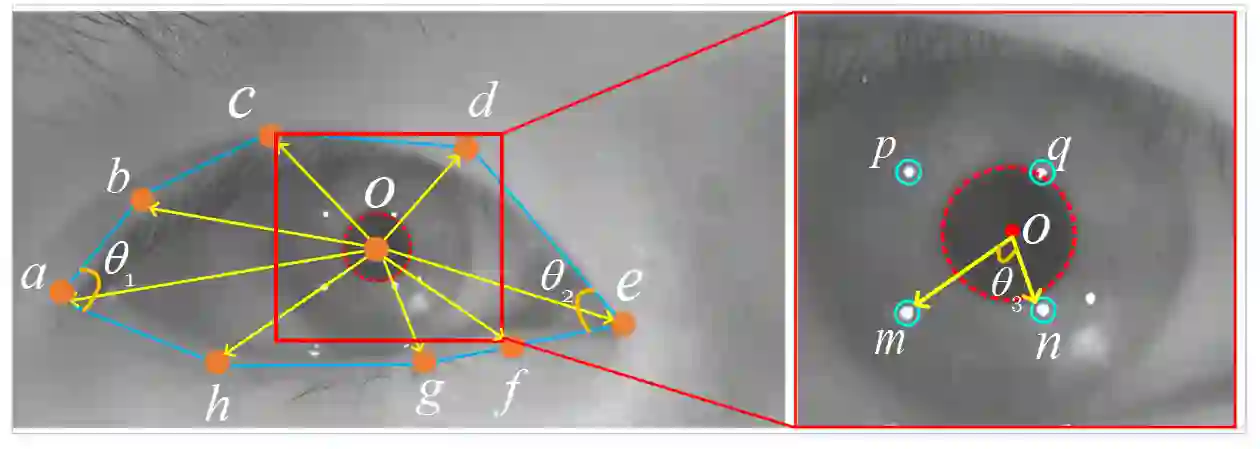

Eye-tracking technologies have been widely used in applications like psychological studies and human computer interactions (HCI). However, most current eye trackers focus on 2D point of gaze (PoG) estimation and cannot provide accurate gaze depth.Concerning future applications such as HCI with 3D displays, we propose a novel binocular eye tracking device with stereo stimuli to provide highly accurate 3D PoG estimation. In our device, the 3D stereo imaging system can provide users with a friendly and immersive 3D visual experience without wearing any accessories. The eye capturing system can directly record the users eye movements under 3D stimuli without disturbance. A regression based 3D eye tracking model is built based on collected eye movement data under stereo stimuli. Our model estimates users 2D gaze with features defined by eye region landmarks and further estimates 3D PoG with a multi source feature set constructed by comprehensive eye movement features and disparity features from stereo stimuli. Two test stereo scenes with different depths of field are designed to verify the model effectiveness. Experimental results show that the average error for 2D gaze estimation was 0.66\degree and for 3D PoG estimation, the average errors are 1.85~cm/0.15~m over the workspace volume 50~cm $\times$ 30~cm $\times$ 75~cm/2.4~m $\times$ 4.0~m $\times$ 7.9~m separately.

翻译:在心理研究和人类计算机互动(HCI)等应用中,广泛使用了眼跟踪技术。然而,大多数眼跟踪器目前都侧重于2D眼视点(PoG)估计,无法提供准确的眼深。在使用3D显示器的未来应用中,我们提议使用一个具有立体立体模拟功能的新颖双目眼跟踪装置,以提供高度准确的3DPoG估计。在我们的设备中,3D立体成像系统可以向用户提供友好和隐蔽的3D视觉体验,而不穿戴任何附件。眼观察捕捉系统可以直接记录3D模uli下的用户眼睛运动,而不会受到干扰。基于立体模拟下收集的3D眼观察跟踪模型是建立在收集的眼视运动数据基础上的。我们模型估计用户2D眼视,具有按眼区域地标和进一步估计的3DPoG的多源特征,由立体眼运动特征和立体悬殊特征构成。两个具有不同深度的测试立体测试立体图像显示模型有效性。实验结果表明,2D眼影测算的平均误差值为0.06/M美元;1M_空间估测值为30美元。