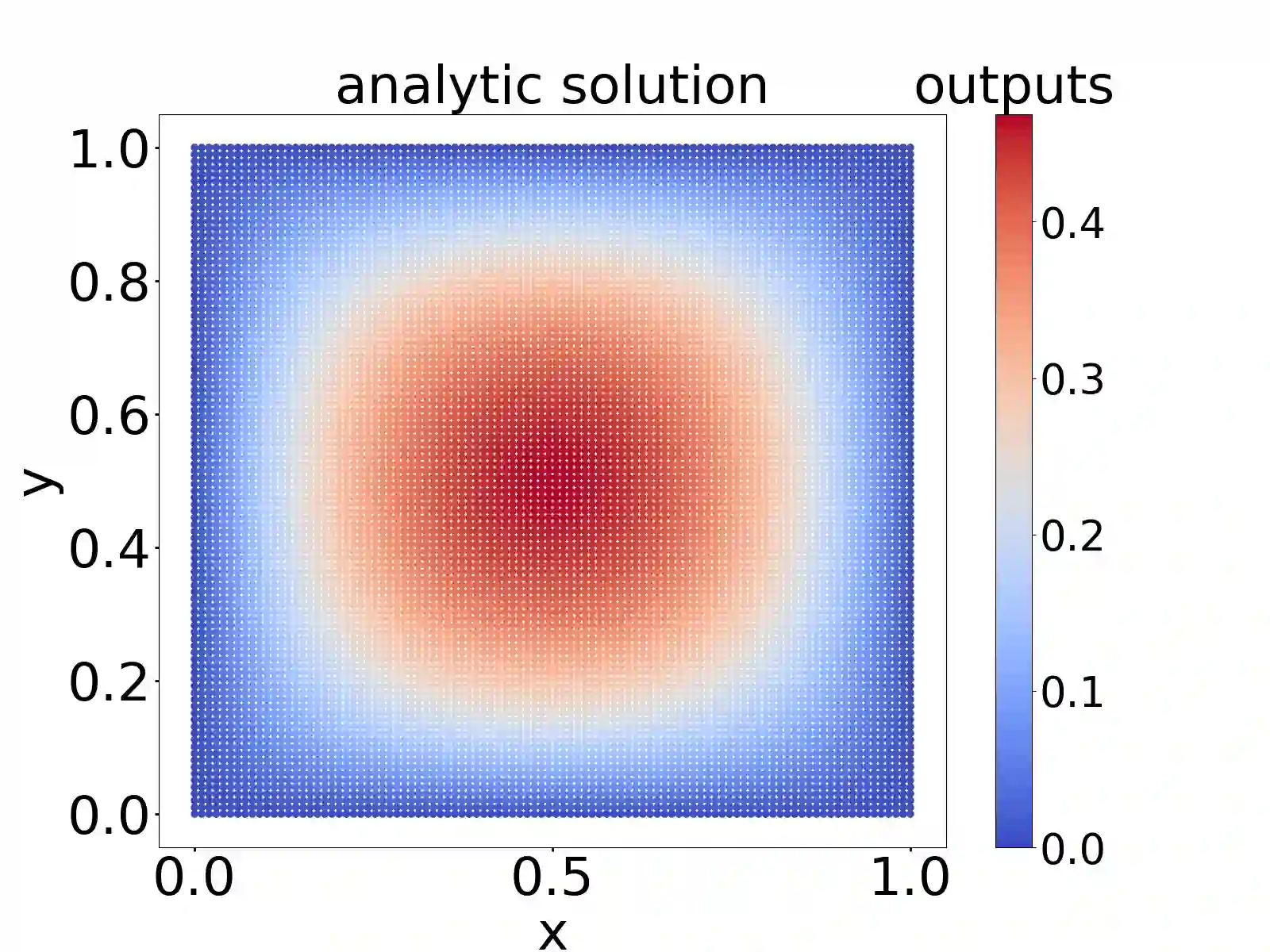

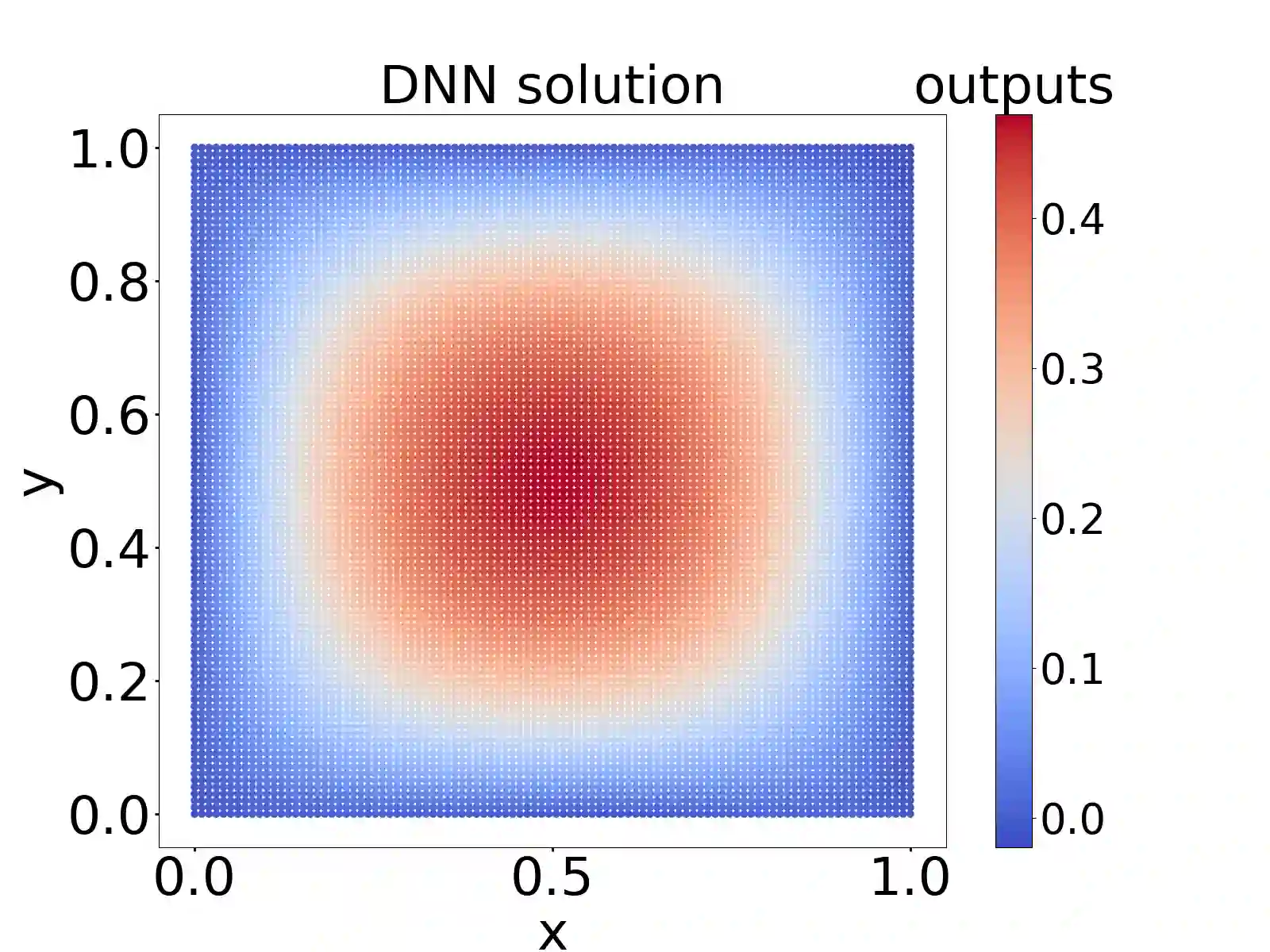

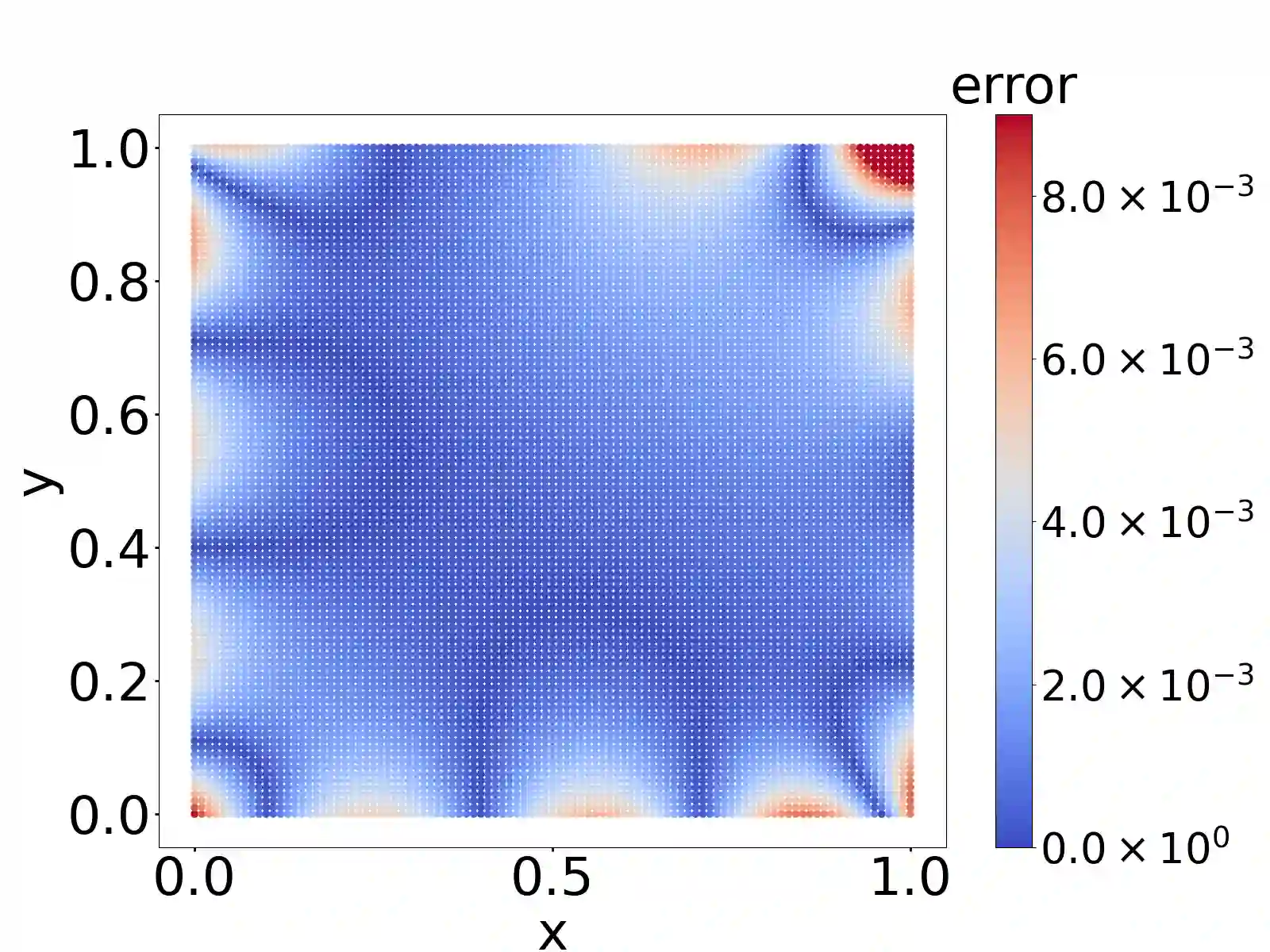

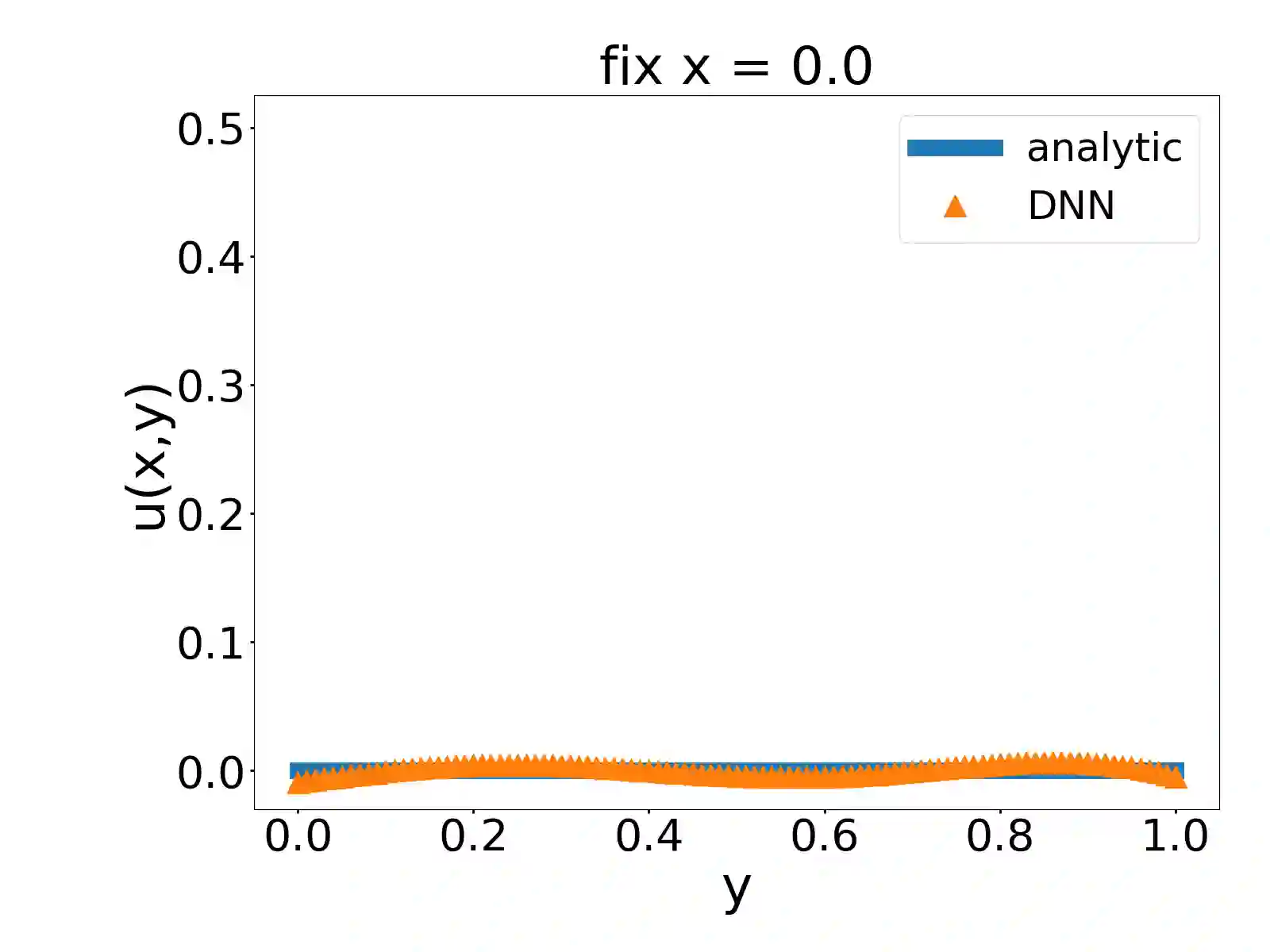

In this paper, we propose a model-operator-data network (MOD-Net) for solving PDEs. A MOD-Net is driven by a model to solve PDEs based on operator representation with regularization from data. In this work, we use a deep neural network to parameterize the Green's function. The empirical risk consists of the mean square of the governing equation, boundary conditions, and a few labels, which are numerically computed by traditional schemes on coarse grid points with cheap computation cost. With only the labeled dataset or only the model constraints, it is insufficient to accurately train a MOD-Net for complicate problems. Intuitively, the labeled dataset works as a regularization in addition to the model constraints. The MOD-Net is much efficient than original neural operator because the MOD-Net also uses the information of governing equation and the boundary conditions of the PDE rather than purely the expensive labels. Since the MOD-Net learns the Green's function of a PDE, it solves a type of PDEs but not a specific case. We numerically show MOD-Net is very efficient in solving Poisson equation and one-dimensional Boltzmann equation. For non-linear PDEs, where the concept of the Green's function does not apply, the non-linear MOD-Net can be similarly used as an ansatz for solving non-linear PDEs.

翻译:在本文中, 我们提出一个用于解决 PDE 的模型- 操作者数据网络( MOD- Net) 。 MOD- Net 被一个模型驱动, 以基于操作员的演示来解决 PDE 。 在这项工作中, 我们使用一个深神经网络来参数化 Green 的函数。 实验风险包括治理方程式的平均值方程式、 边界条件 和几个标签, 由具有廉价计算成本的粗化网格点的传统办法进行数字计算。 由于只有标签数据集或只有模型限制, 它不足以准确训练一个 MOD- 网络来解决复杂的问题。 直观地说, 标签数据集除了模型限制外, 还能起到规范化作用。 MOD- Net 比原始的神经操作员效率要高得多, 因为 MOD- Net 也使用管理方程式和边界条件的信息, 而不是纯粹昂贵的标签。 由于 MOD- Net 学会了PDE 的功能, 它解决了一种PDE 的种类, 而不是一个非特定的例子。 我们用数字显示 MOD- 数字- 的 PD- 平方程式, 的不使用 等式 。