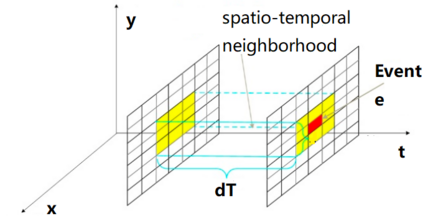

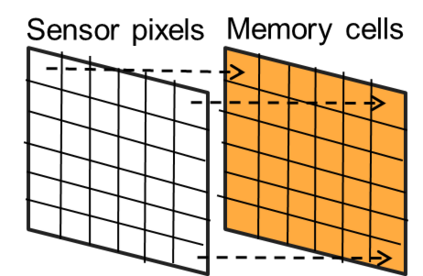

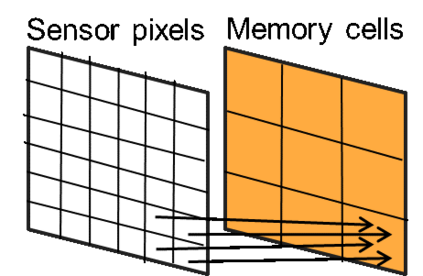

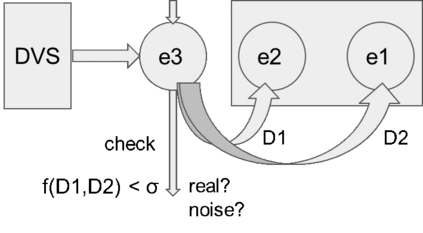

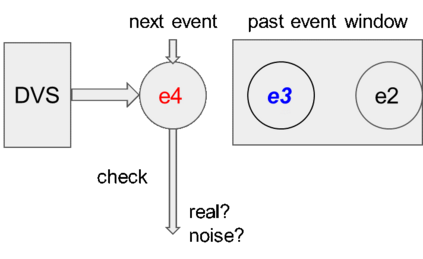

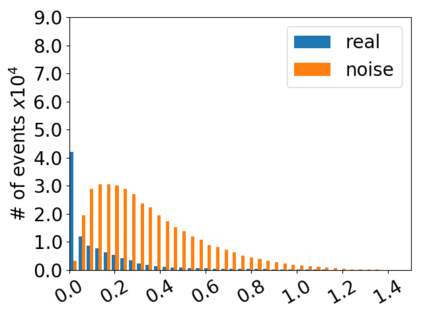

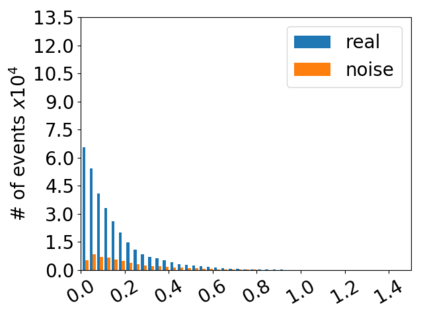

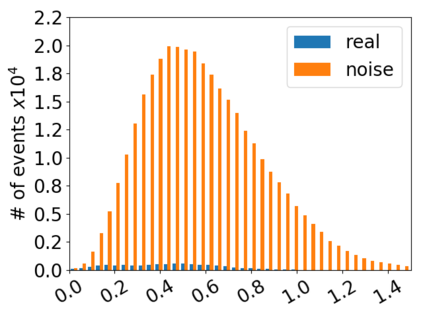

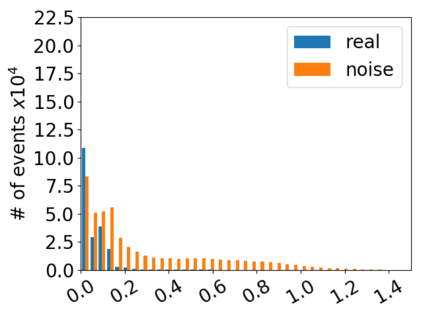

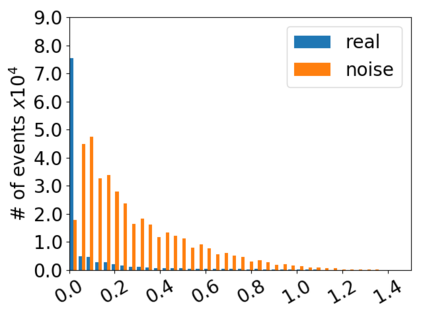

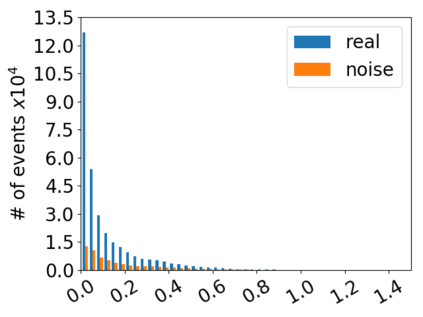

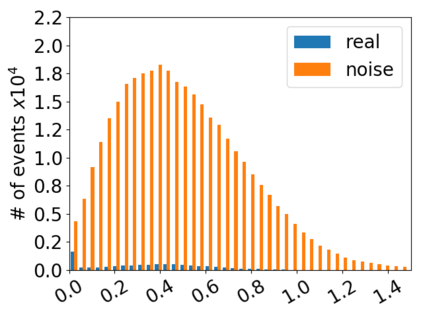

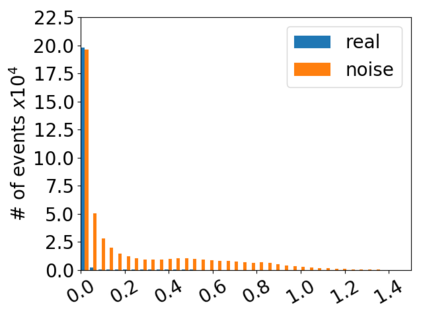

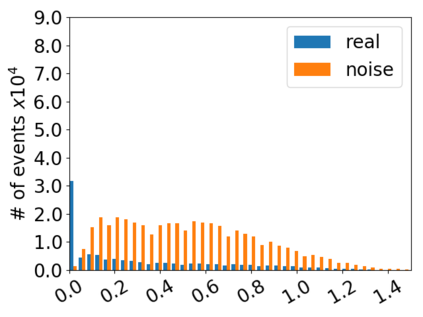

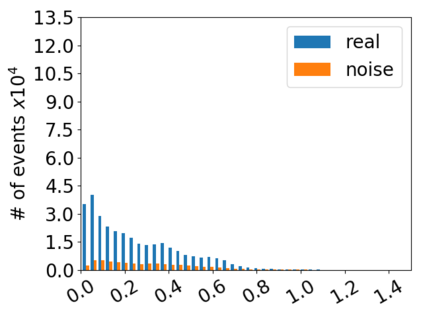

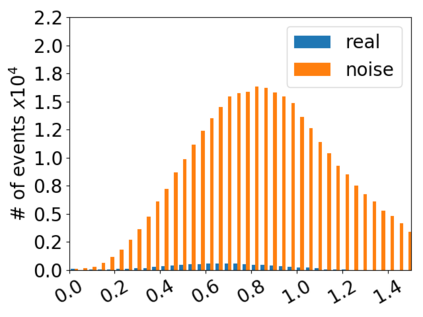

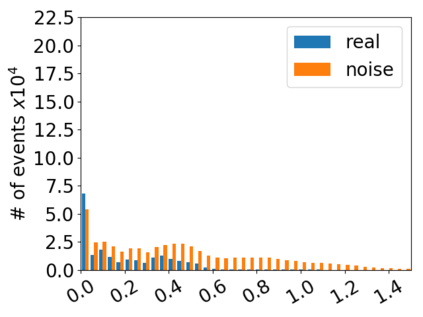

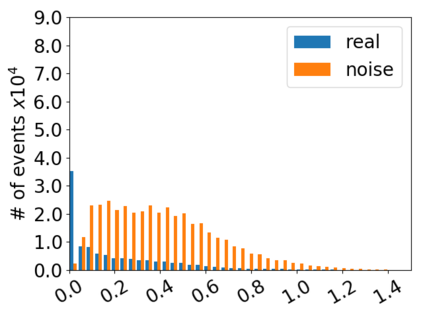

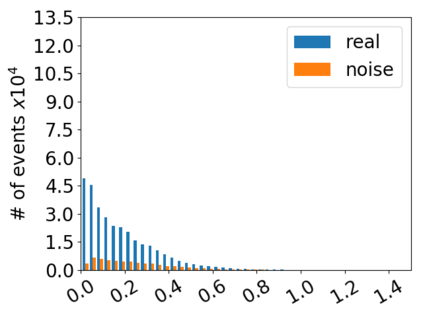

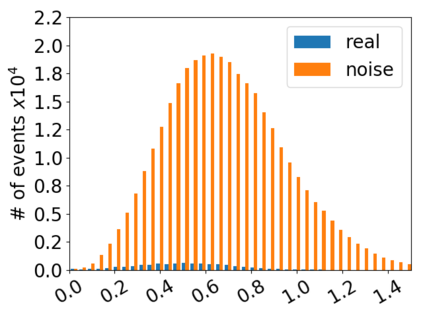

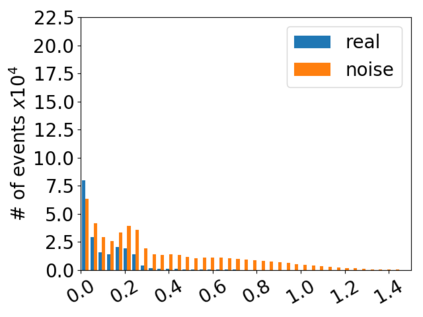

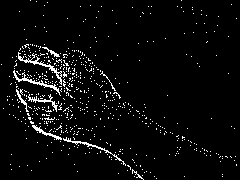

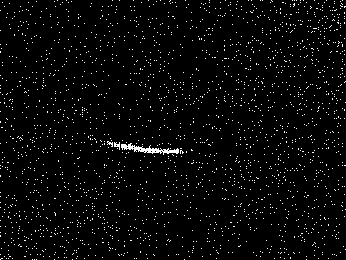

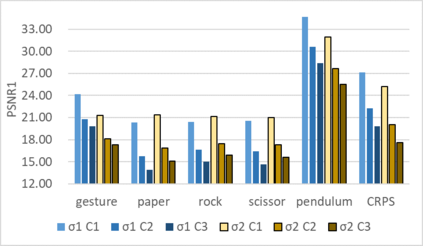

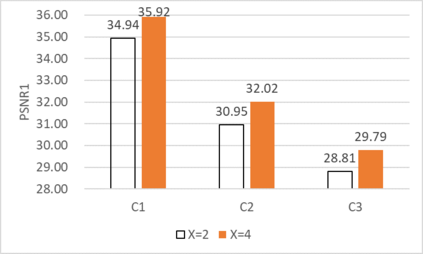

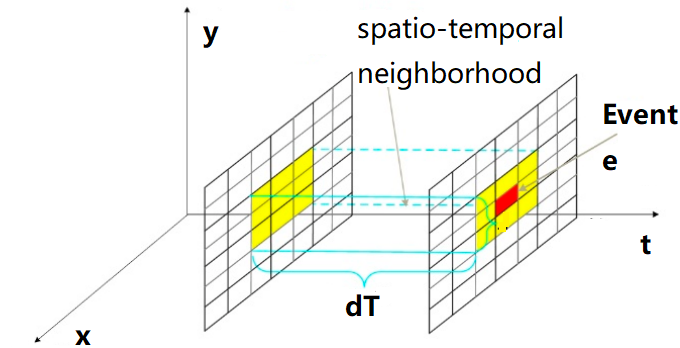

Neuromorphic event-based dynamic vision sensors (DVS) have much faster sampling rates and a higher dynamic range than frame-based imaging sensors. However, they are sensitive to background activity (BA) events that are unwanted. There are some filters for tackling this problem based on spatio-temporal correlation. However, they are either memory-intensive or computing-intensive. We propose \emph{SeqXFilter}, a spatio-temporal correlation filter with only a past event window that has an O(1) space complexity and has simple computations. We explore the spatial correlation of an event with its past few events by analyzing the distribution of the events when applying different functions on the spatial distances. We find the best function to check the spatio-temporal correlation for an event for \emph{SeqXFilter}, best separating real events and noise events. We not only give the visual denoising effect of the filter but also use two metrics for quantitatively analyzing the filter's performance. Four neuromorphic event-based datasets, recorded from four DVS with different output sizes, are used for validation of our method. The experimental results show that \emph{SeqXFilter} achieves similar performance as baseline NNb filters, but with extremely small memory cost and simple computation logic.

翻译:内空事件动态视觉传感器(DVS)的取样率要快得多,动态范围比基于框架的成像传感器(DVS)的动态范围要高得多。但是,它们对于背景活动(BA)事件是不必要的,是不需要的。有些过滤器可以基于时空关系来解决这个问题。但是,它们不是记忆密集型的,就是计算密集型的。我们建议,它们可以将真实事件和噪音事件区分开来。我们不仅给过滤器带来视觉分解效果,而且用两个衡量尺度来对过滤器的性能进行定量分析。我们通过在空间距离上应用不同功能时分析事件分布来探索一个事件与过去少数事件的空间相关性。我们找到最佳功能来检查 motio-时空相关性。我们用四个 DVS\BS 来记录的事件的分布。我们用不同的直观性能测试, 使用相同的直径的直径的直径镜性能, 用于模拟的实验性能, 以相同的直径的直径的直径直径。