深度生成模型综述

受益于当前计算机性能的快速提升, 学习可观测样本的概率密度并随机生成新样本的生成模型成为热点. 相比于需要学习条件概率分布的判别模型, 生成模型的训练难度大、模型结构复杂, 但除了能够生成新样本外, 生成模型在图像重构、缺失数据填充、密度估计、风格迁移和半监督学习等应用领域也获得了巨大的成功. 当前可观测样本的数量和维数都大幅度增加, 浅层的生成模型受到性能瓶颈的限制而无法满足应用需求, 从而被含有多个隐藏层的深度生成模型替代, 深度生成模型能够学习到更好的隐表示, 模型性能更好. 本文对有重要意义的深度生成模型进行全面的分析和讨论, 对各大类模型的结构和基本原理进行梳理和分类. 本文第1节介绍深度生成模型的概念和分类; 第2节介绍受限玻尔兹曼机和以受限玻尔兹曼机为基础模块的几种深度生成模型, 重点内容是各种模型的不同训练算法; 第3节介绍变分自编码器的基本结构、变分下界的推理和重参数化方法; 第4节介绍生成对抗网络, 主要内容为模型原理、训练方法和稳定性研究, 以及两种重要的模型结构; 第5节总结了流模型的结构, 详细介绍了流模型的技术特点; 第6节分析了自回归模型的模型结构以及几种重要分支的研究进展; 第7节将介绍生成模型中的两个小分支: 矩阵匹配模型和随机生成模型; 第8节对深度生成模型存在的问题进行分析讨论, 并对未来的研究方向和发展趋势做出了展望.

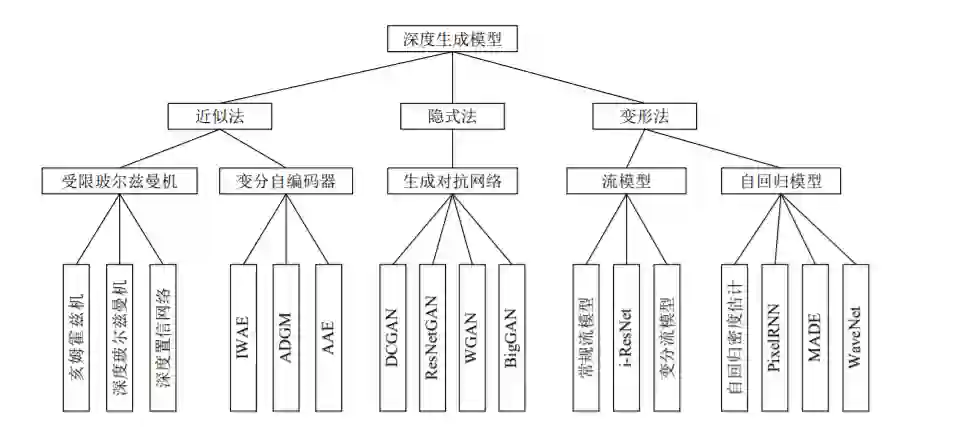

深度生成模型的目标函数是数据分布与模型分布之间的距离, 可以用极大似然法进行求解. 从处理极大似然函数的方法的角度, 可将深度生成模型分成如下三种, 分类内容如图1所示. 具体分类方式如下:

图 1 深度生成模型分类

第一种方法是通过变分或抽样的方法求似然函数的近似分布, 这种方法可称为近似方法, 主要包括受限玻尔兹曼机[1]和变分自编码器[2]. 用抽样方法近似求解似然函数的受限玻尔兹曼机属于浅层模型, 以该模型为基础模块的深度生成模型。

包括深度玻尔兹曼机和深度置信网络两种; 变分自编码器用似然函数的变分下界作为目标函数, 这种使用变分下界替代似然函数的近似方法的效率比受限玻尔兹曼机的抽样方法高很多, 实际效果也更好, 变分自编码器具有代表性的模型包括重要性加权自编码、辅助深度生成模型等.

第二种方法是避开求极大似然过程的隐式方法, 其代表模型是生成对抗网络[3]. 生成对抗网络利用神经网络的学习能力来拟合两个分布之间的距离, 巧妙地避开了求解似然函数的难题, 是目前最成功、最有影响力的生成模型, 其具有代表性的模型很多, 例如深度卷积生成对抗网络、WGAN和当前生成能力最好的BigGAN; 另外利用参数化马尔科夫过程代替直接参数化似然函数的生成随机网络[4]也属于此类方法.

第三类方法是对似然函数进行适当变形, 变形的目的是为了简化计算, 此类方法包括流模型[5]和自回归模型[6]两种模型. 流模型利用可逆网络构造似然函数之后直接优化模型参数, 训练出的编码器利用可逆结构的特点直接得到生成模型. 流模型包括常规流模型、变分流模型和可逆残差网络三种; 自回归模型将目标函数分解为条件概率乘积的形式, 这类模型有很多, 具有代表性的包括像素循环神经网络、掩码自编码器以及成功生成逼真的人类语音样本的WaveNet等.

受限玻尔兹曼机

玻尔兹曼机 (Boltzmann machines, BM) 是由 能量函数定义的结构化无向图概率模型, 用于学习 二值向量上的任意概率分布, 广义上把基于能量的 模型都称作 BM. BM 层内各单元之间和各层之间 均为全连接关系, 权值大小表示单元之间的相互作 用关系. BM 变种的流行程度早已超过了该模型本 身, 其中最主要的衍生模型是属于生成模型的受限 玻尔兹曼机[1] (Restricted Boltzmann machines, RBM) 和以 RBM 为基础模块的深度置信网络 (Deep belief network, DBN) 和深度玻尔兹曼机 (Deep Boltzmann machines, DBM) 等深度生成模 型, 是深度学习中的典型代表, 曾受到广泛研究, 国 内外均有关于该模型的综述文章[7−8] . 这类模型能够 学习高维特征和高阶概率依赖关系并成功应用在降 维、特征提取等领域, 是最早出现的深度生成模型. 本节将详细介绍训练过程中存在的问题以及解 决方法; 然后, 以该模型为基础分别介绍 DBN 和 DBM 的结构和相关算法; 最后, 总结近些年来重要 的相关模型和算法改进.

变分自编码器

变分自编码器[2] (Variational auto-encoder, VAE) 是以自编码器结构为基础的深度生成模型. 自编码器在降维和特征提取等领域应用广泛, 基本 结构是通过编码 (Encoder) 过程将样本映射到低维 空间的隐变量, 然后通过解码 (Decoder) 过程将隐 变量还原为重构样本. VAE 模型的基本结构与自 编码器相似, 两者的区别可以总结为如下三点:

1)有生成能力, 为了使解码过程 (生成模型) 具有生成 能力而不是唯一的映射过程, VAE 假设隐藏变量 为服从正态分布的随机变量.

2) 构造似然函数的变分下界. 变分自编码器的 目标函数是使输入样本的概率分布和重构样本的概 率分布尽量接近, 但输入样本的概率是未知的, 因 此引入建议分布, 用变分下界将数据概率分布的数 学期望转化为建议分布的数学期望.

3) 重参数化. 变分下界的计算需要在后验分布 中抽样, 但直接抽样得到的是离散变量, 无法进行 反向传播. VAE 对编码器输出的均值和方差进行 线性变换, 解决了训练过程的最后一个障碍. 本节主要介绍 VAE 的模型结构和基本原理, 包括变分下界的不同推导方式、重参数化方法以及 模型的不足, 然后介绍几种有重要意义的扩展模型.

GAN 模型

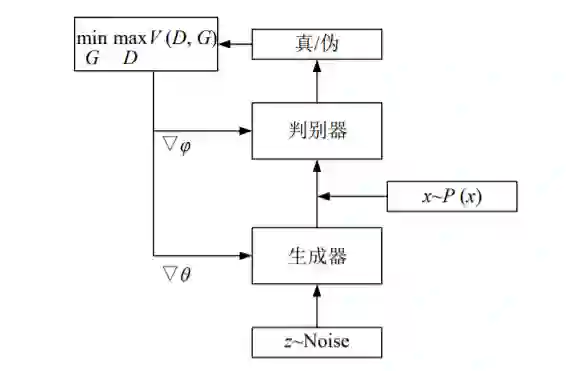

GAN 中的博弈方是一个生成器和一个判别器, 生成器的目标是生成逼真的伪样本让判别器无法判 别出真伪, 判别器的目标是正确区分数据是真实样本还是来自生成器的伪样本, 在博弈的过程中, 两 个竞争者需要不断优化自身的生成能力和判别能 力, 而博弈的结果是找到两者之间的纳什均衡, 当 判别器的识别能力达到一定程度却无法正确判断数 据来源时, 就获得了一个学习到真实数据分布的生成器, GAN 的模型结构如图 11 所示.

流模型

主流深度生成模型中, VAE 推导出了似然函 数的变分下界, 但用容易求解的变分下界代替真实 的数据分布属于近似方法, 得到的近似模型无法得 到最好的生成效果; GAN 虽然用模型对抗和交替 训练的方法避免了优化似然函数, 保留了模型的精 确性, 但在训练过程会出现各种问题, 因此研究一 种既能保证模型精度又容易训练的深度生成模型是有意 义的. 流模型的基本思想是: 真实数据分布一定可以 由转换函数映射到人为给定的简单分布, 如果该转 换函数是可逆的且可求出该转换函数的形式, 则这 个简单分布和转换函数的逆函数就能够构成一个深 度生成模型. 可逆函数的性质说明 Flow 模型是一 个精确模型, 有希望生成质量足够好的样本. Flow 模型的相关论文较少, 重要的论文中存在 很多必须了解的基本结构, 因此本节首先介绍 Flow 的基础框架, 然后详细说明 NICE、Real NVP 和 Glow 等常规流、i-ResNet 以及变分流等模型的结构

自回归网络

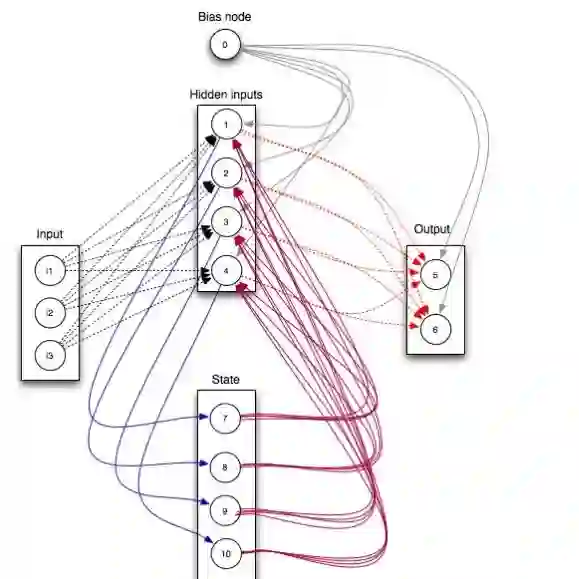

自回归是统计学中处理时间序列的方法, 用同 一变量之前各个时刻的观测值预测该变量当前时刻 的观测值. 用条件概率表示可见层数据相邻元素的 关系, 以条件概率乘积表示联合概率分布的模型都 可以称为自回归网络. 自回归网络中最有影响力的模型是神经自回归 分布估计, 该模型起源于受限玻尔兹曼机 RBM, 将 其中的权重共享和概率乘积准则与自回归方法结 合, 该模型的前向传播等同于假设隐藏变量服从平 均场分布的 RBM, 且更灵活、更容易推理, 模型性 能也更好.

未来趋势及发展方向

深度生成式模型试图把概率论与数理统计的知 识与强有力的深度神经网络的表示学习能力相结 合, 在最近几年取得了显著进步, 是当前主流的深 度学习方向. 本文对深度生成式模型的主要类型进 行了梳理, 给出了模型的构造过程、优缺点以及模 型存在的问题. 深度生成式模型虽然大有潜力, 但 也存在很多挑战:

1) 评估指标与评估系统 和判别式模型、基于 矩阵与线性代数的模型、基于几何的模型相比, 深 度生成模型存在训练过程复杂、结构不易理解和使 用、训练速度慢等问题, 在大规模数据上学习模型 很困难, 在不同的应用领域应该有相应的有效评估 指标和实用的评估系统是急需研究的问题.

2) 不确定性 深度生成模型的动机和构造过程 通常有严格的数学推导, 但在实际过程往往限于求 解的难度不得不进行近似和简化, 使模型偏离原来 的目标. 训练好的模型难以在理论上分析透彻, 只 能借助实验结果反向判断调整方法, 对生成模型的 训练造成很大困扰, 是限制模型进一步发展的重要 因素. 因此了解模型的近似和简化对模型性能、误 差和实际应用的影响是发展生产模型的重要方向

3) 样本多样性 如何使深度生成模型生成的图 像、文本和语音等样本具有多样性是一个值得研究 的问题. 度量多样性最基本的标准是熵, 因而把生 成模型与最大互信息结合的 Info-VAE 和 Info-GAN[121] 等模型既能限制生成模型的灵活性又能提升样本的 多样性; 把训练样本看作多个概率分布的噪声混合 后的随机变量, 提取不同噪声的特征表示, 得到不 同层次的特征表示, 在训练目标函数里显式地引入 不同的归纳偏置.

4) 泛化能力 机器学习理论认为好的模型要具 有更好的泛化能力. 重新思考深度学习的泛化能力, 从模型复杂性、偏差-方差权衡等观点, 理论上讨论 各种深度生成模型的学习机制, 丰富模型的理论基 础, 从而真正确立深度生成模型在深度学习中的显 著地位是值得思考的问题.

5) 更高效的模型结构和训练方法 代表着最先 进的一批生成模型如 BigGAN、Glow 和 VQ-VAE[60−61] 等已经可以生成足够清晰的图片样本, 但这样的大 型模型背后是远超常规的计算量, 是所有大型生成 模型的弊端: 高昂的计算机硬件设备以及长时间的 训练让很多人难以进入该领域的前沿研究, 所以更 加高效的模型结构和训练方法是未来发展方向之一.

6) 应用领域扩展 深度生产模型的应用范围相 对较小, 如何将其他深度生成模型的思想以及成果 运用在常见场景中、如何加速与这些领域的融合, 是未来进一步发展深度生成模型的关键方向, 如智 能家居物联网和自动驾驶等领域都有待深度生成模 型的使用. 目前生成模型通常用于传统机器学习和 人工智能专属领域, 对于工业生产等其他领域的应 用也有待进一步开发.

7) 生成离散数据 如 GAN 等深度生成模型的 训练依赖于参数的完全可微, 因此无法直接生成如 独热编码等离散数据. 这个问题限制了此类深度生 成模型在 NLP 领域的应用, 目前已经有初步的解 决办法, 例如使用 Gumbel-softmax[148]、用连续函数 近似[149] 等, 但效果有待进一步提升. 因此研究深度 生成模型生成离散数据是提高文本生成能力的关键 问题, 是值得深入研究的领域.

8) 度量方法 生成模型可以使用不同的度量方法, 例如 GAN 使用的是 KL 散度和 JS 散度, WGAN 使用 Wasserstein 距离替换了原来的散度, 可以提 升模型的生成能力和训练稳定性. 因此通过理论分 析, 使用新的度量方法可能会进一步提高模型性能。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DGMS” 就可以获取《深度生成模型综述》专知下载链接