ACL 2019论文提交数暴增81%,史上最大规模NLP会议即将诞生!

新智元原创

新智元原创

编辑:金磊

编辑:金磊

【新智元导读】ACL今年要火了!根据ACL19机器学习领域主席王威廉(William Wang)的推文,今年论文提交数量将在2800左右。相比去年论文提交数量,暴增81%——史上最大规模NLP会议诞生了!

历史上最大规模NLP会议要来了!

3月4日是ACL 2019论文提交截止日期:

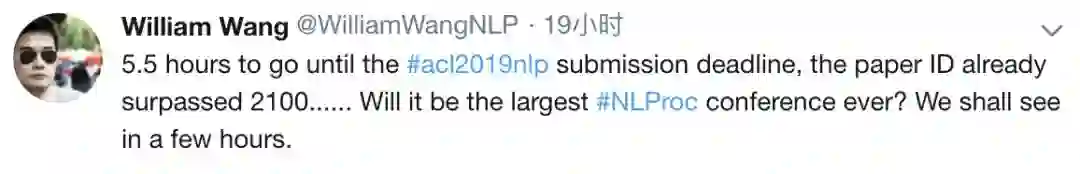

而在离截止时间仅剩5.5小时的时候,ACL 2019机器学习领域主席、加州大学圣塔芭芭拉计算机科学系王威廉(Wliiliam Wang)老师发出推特表示:

离ACL 2019提交论文截止时间仅剩5.5小时了,论文ID已经超过了2100。本次大会将会是史上规模最大的一次吗?就剩几个小时了,让我们拭目以待。

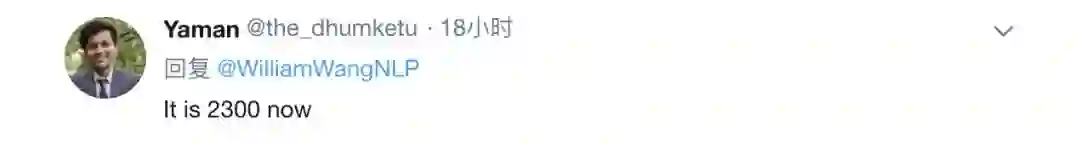

而就在这条推特发出1小时后,网友回复说:

现在已经2300了!

最后,王威廉老师再次发推文表示:

今年ACL论文编号应该到了2800篇左右。

今年ACL的论文提交数,又将打破历史记录!

ACL 2018的论文提交数为1544篇,而今年若是超过了2800篇,那么增量将超过81%。

无疑将成为近年来最火、规模最大的一次NLP会议。

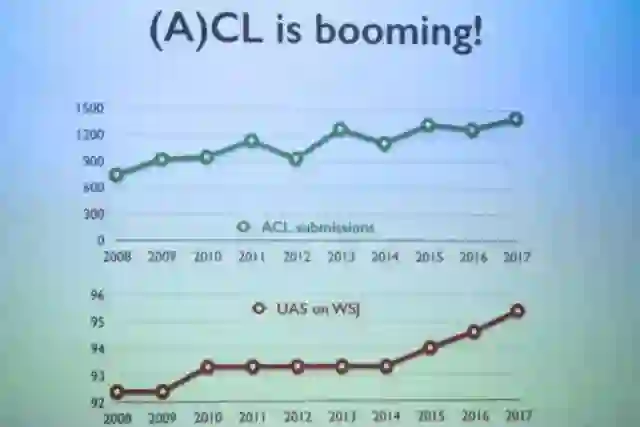

而“增长”趋势不仅仅是体现在今年:

从上面的折线图来看,ACL近几年投稿量从大体发展呈现出增长趋势。而较高的投稿量也反映了自然语言处理领域在人工智能浪潮下的火热。

2017年共收到1419篇投稿(包括829篇长文投稿和590篇短文投稿),录用长文195篇、短文149篇,长文录用率为23.5%。

2018年共收到投稿1544篇,最终录用381篇,其中长文256篇,短文125篇,长文录取率为25.1%。

从长文录取率上来看,近两年也是呈现增长趋势。相信ACL 2019的录取率应该也会保持上升态势。

每年ACL基本上都会对进行词云分析:

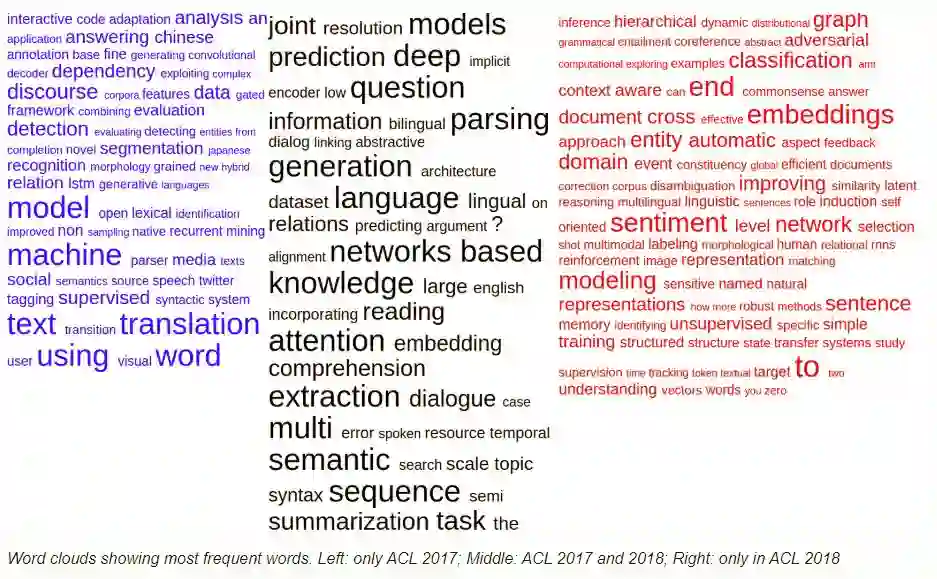

接收论文标题关键词(左:ACL 2017独有,中:ACL 2017和ACL 2018共有,右:ACL 2018独有)

根据对接收论文标题的词云分析,在ACL 2017和2018上持续热门的关键词有:

注意力机制(attention)

网络(network)

知识(knowledge)

序列(sequence)

语言(language)

而在2018的ACL中:

句子(sentence)

词嵌入(embedding)

情感(sentiment)

受到了更多的关注。

交叉(cross)、领域(domain)、无监督(unsupervised)等关键词也在去年上榜,可以看到17-18年,业界有更多的人着手不同领域之间的交叉迁移,以及无监督学习的工作。

而2018-2019年,应该属于NLP的大年。

NLP领域大事不断:

谷歌提出BERT模型:证明了一个非常深的模型可以显著提高NLP任务的准确率,而这个模型可以从无标记数据集中预训练得到;

OpenAI提出GPT-2模型:号称史上最强通用NLP模型,狂揽7大数据集最佳纪录。

......

未来两年,NLP可能会不断爆出类似的刷屏新闻,真的进入一个技术快速发展期。这是NLP研发者的黄金期,这种时期最容易出好的成果。

当然,除了上述两个最醒目的模型外,爱尔兰的NLP研究科学家Sebastian Ruder对2018年NLP领域令人激动的十大想法进行了大盘点。

总结一下便是:

⑴无监督的机器翻译翻译(Unsupervised MT)

代表论文:

《基于短语和神经的无监督机器翻译》(EMNLP 2018)

https://arxiv.org/abs/1804.0775

⑵预训练的语言模型(Pretrained language models)

代表论文:

《深度的语境化词语表示》(NAACL-HLT 2018)

https://arxiv.org/abs/1802.05365

⑶常识推理数据集(Common sense inference datasets)

代表论文:

《视觉常识推理》(arXiv 2018)

http://visualcommonsense.com/

⑷元学习(Meta-learning)

代表论文:

《低资源神经机器翻译的元学习》(EMNLP 2018)

http://aclweb.org/anthology/D18-1398

⑸稳健的无监督方法(Robust unsupervised methods)

代表论文:

《用于完全无监督的跨语言词向量的稳健自学习方法》(ACL 2018)

http://www.aclweb.org/anthology/P18-1073

⑹理解表示(Understanding representations)

代表论文:

《语境化词向量解析:架构和表示》(EMNLP 2018)

http://aclweb.org/anthology/D18-1179

⑺巧妙的辅助任务(Clever auxiliary tasks)

代表论文:

《语义结构的句法框架》(EMNLP 2018)

http://aclweb.org/anthology/D18-1412

⑻半监督学习和迁移学习相结合(Combining semi-supervised learning with transfer learning)

代表论文:

《基于交叉视点训练的半监督序列建模》(EMNLP 2018)

http://aclweb.org/anthology/D18-1217

⑼大型文档的问答和推理(QA and reasoning with large documents)

代表论文:

《叙述答阅读理解挑战》(TACL 2018)

http://aclweb.org/anthology/Q18-1023

⑽归纳偏差(Inductive bias)

代表论文:

《基于人类注意力的序列分类》(CoNLL 2018)

http://aclweb.org/anthology/K18-1030

《语义角色标注的语言学信息的自我注意力》(EMNLP 2018)

http://aclweb.org/anthology/D18-1548

今年热夏,史上最大规模NLP顶会——ACL,即将拉开序幕。那么你觉得今年的关键词会是哪些呢?

推文地址:

https://twitter.com/WilliamWangNLP/status/1102908890331545601

更多阅读

【加入社群】

新智元AI技术+产业社群招募中,欢迎对AI技术+产业落地感兴趣的同学,加小助手微信号:aiera2015_2 入群;通过审核后我们将邀请进群,加入社群后务必修改群备注(姓名 - 公司 - 职位;专业群审核较严,敬请谅解)