CVPR2019 | ASRCF:基于自适应空间加权相关滤波的视觉跟踪研究(即将开源)

加入极市专业CV交流群,与6000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!更有机会与李开复老师等大牛群内互动!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。点击文末“阅读原文”立刻申请入群~

作者 | 飘哥

来源 | https://zhuanlan.zhihu.com/p/65361961

论文标题:Visual Tracking via Adaptive Spatially-Regularized Correlation Filters(基于自适应空间加权相关滤波的视觉跟踪研究)

论文下载:https://pan.baidu.com/s/1sD-w1tHfA5ZwIbrnCtUI2Q

论文代码:

https://github.com/Daikenan/ASRCF(代码7月上传)

论文摘要

本文提出自适应空间约束相关滤波算法来同时优化滤波器权重及空间约束矩阵。首先,本文所提出的自适应空间约束机制可以高效地学习得到一个空间权重以适应目标外观变化,因此可以得到更加鲁棒的目标跟踪结果。其次,本文提出的算法可以通过交替迭代算法来高效进行求解,基于此,每个子问题都可以得到闭合的解形式。再次,本文所提出的跟踪器使用两种相关滤波模型来分别估计目标的位置及尺度,可以在得到较高定位精度的同时有效减少计算量。大量的在综合数据集上的实验结果证明了本文所提出的算法可以与现有的先进算法取得相当的跟踪结果,并且达到了实时的跟踪速度。

论文作者

Kenan Dai, Dong Wang, Huchuan Lu, Chong Sun, Jianhua Li

戴可南、王栋(大连理工智能图像分析实验室IIAU-Lab成员)、卢湖川(大连理工大学智能图像分析实验室(IIAU-Lab)负责人)、孙冲(智能图像分析实验室IIAU-Lab成员)、李建华

智能图像分析实验室(IIAU-Lab)出品论文

《Visual Tracking via Adaptive Spatially-Regularized Correlation Filters》CVPR 2019

《ROI Pooled Correlation Filters for Visual Tracking》 CVPR 2019, Accepted

《Multi-source weak supervision for saliency detection》CVPR 2019

《A Mutual Learning Method for Salient Object Detection with intertwined Multi-Supervision》CVPR2019

《CapSal: Leveraging Captioning to Boost Semantics for Salient Object Detection》 CVPR 2019

《Attentive Feedback Network for Boundary-Aware Salient Object Detection》CVPR2019

《Enhancing Diversity of Defocus Blur Detectors via Cross-Ensemble Network》CVPR2019

《Salient Object Detection with Lossless Feature Reflection and Weighted Structural Loss》IEEE Transaction on Image Processing, 2019, Accepted

论文背景

目标跟踪面临的挑战

视觉跟踪由于从3D世界映射到2D图像导致信息遗失,图像中的噪声、复杂背景、目标复杂运动、局部或全局遮挡、光照变化以及图像实时处理要求等等使其成为一大挑战。早些年,几乎所有视觉跟踪方法都假设目标的运动是流畅的且无外观突变,但是近几年已经有巨大的进展。一些算法可以处理外观突变、从场景中移出和漂移等问题。要建立一个性能良好的跟踪系统,需考虑以下一些要求。

1) 鲁棒性:鲁棒意味着即使在复杂环境,跟踪算法也能够追踪感兴趣的目标。跟踪难点可能是复杂背景、局部或整体光线变化、遮挡或复杂目标运动。

2) 自适应性:目标位于各种各样变化的环境中,目标本身也在经历变化,这就需要跟踪算法对实际的目标外观具有一个稳定的适应性机制。

3) 实时处理:一个处理实时视频流的系统必须有高处理速度,因此算法的选择,快速且优化实现和高性能一样是必须的。处理速度取决于目标的检测速度,但是为了给人眼呈现一个流畅的视频输出效果,必须建立一个不低于15帧每秒的帧率。

这些要求是很难同时满足的,通常进行某种折衷,以达到良好的整体性能,同时判断一个跟踪系统性能需要结合其应用场合来判断。

目标跟踪的三个阶段:

从早期的Meanshift算法、卡尔曼滤波,粒子滤波等,到后来的在线学习机制,吸收表示,到现在的相关滤波和深度学习。各阶段如下:

2005年之前:

Meanshift:是一种基于概率密度分布的跟踪方法,使目标的搜索一直沿着概率梯度上升的方向,迭代收敛到概率密度分布的局部峰值上。首先 Meanshift 会对目标进行建模,比如利用目标的颜色分布来描述目标,然后计算目标在下一帧图像上的概率分布,从而迭代得到局部最密集的区域。

KalmanFilter卡尔曼滤波器是通过前一状态预测当前状态,并使用当前观测状态进行校正,从而保证输出状态平稳变化,可有效抵抗观测误差。因此在运动目标跟踪中也被广泛使用。

Particle Filter:粒子滤波方法是一种基于粒子分布统计的方法。以跟踪为例,首先对跟踪目标进行建模,并定义一种相似度度量确定粒子与目标的匹配程度。在目标搜索的过程中,它会按照一定的分布(比如均匀分布或高斯分布)撒一些粒子,统计这些粒子的相似度,确定目标可能的位置。在这些位置上,下一帧加入更多新的粒子,确保在更大概率上跟踪上目标。

2009年到2013年

Sparse Representation:稀疏表示方法是给定一组过完备字典,将输入信号用这组过完备字典线性表示,对线性表示的系数做一个稀疏性的约束(即使得系数向量的分量尽可能多的为0),那么这一过程就称为稀疏表示。基于稀疏表示的目标跟踪方法则将跟踪问题转化为稀疏逼近问题来求解。

2017年至今

Correlation Filters:相关滤波器Correlation Filter 最早应用于信号处理,用来描述两个信号之间的相关性,或者说相似性(有点像早期的概率密度)。在目标跟踪判别式模型中,基于相关滤波器的追踪算法表现比较好。

最近三年,目标跟踪在速度和精度上都取得了非常重要的突破,主要有两个方向:

* 一个方向是相关滤波算法和深度学习的结合;

* 一个方向是端到端的深度神经网络。

本篇论文中的框架就是Correlation Filters和深度学习特征相结合的一个框架。

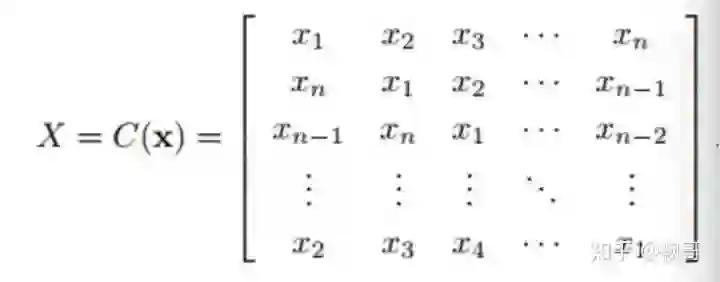

相关滤波是在循环移位的样本的基础上实现的岭回归:

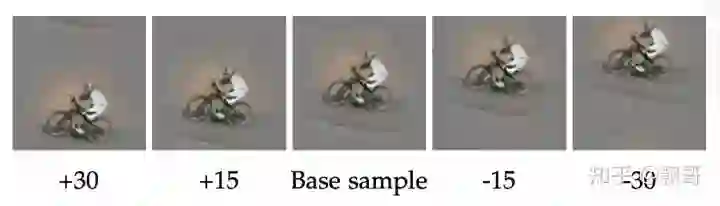

举个例子,如果背景足够干净,可以用循环移位的操作,取代滑动窗机制获得正样本,

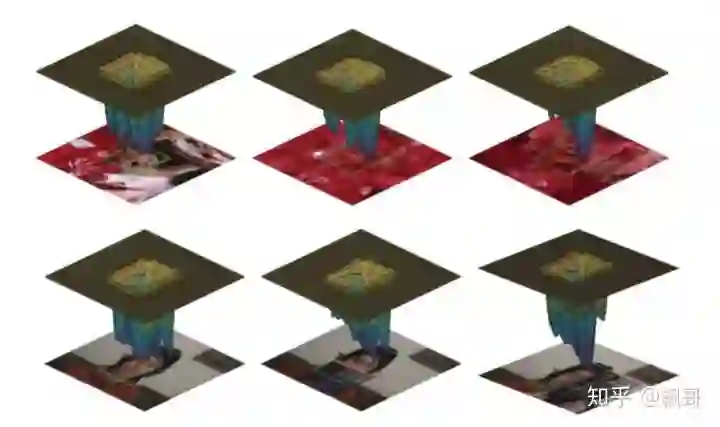

如上图,第三张为正样本,第四,第五张就可以是负样本。然后根据循环移位的属性,在训练时用傅立叶变换和反变换,不需要利用整个矩阵,只要利用循环矩阵的一行或者一列去做就可以。

所以相关滤波器在实践中达到非常高效的结果。

上图是一个测试过程,输入一张search window喂入系统进行特征提取,再经过傅立叶变换,和滤波器的傅立叶变换做乘积,然后再逆变换获得响应图,然后可以在响应图上进行定位和跟踪。

Correlation Filter应用在目标跟踪领域的思想是:相关是衡量两个信号相似值的度量,如果两个信号越相似,那么其相关值就越高,在目标跟踪中,需要设计一个滤波模板,使得当它作用在跟踪目标上时,得到的响应最大。

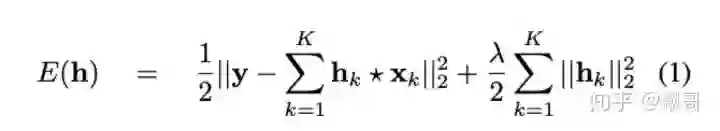

经典相关滤波器框架:

basic cf model

上面是一个基本的相关滤波模型,代表的是不同的特征通道,就是我们用多通道的卷积操作来拟合一个假设的真实响应。但循环移位方式是假想的一种结果,所以在实际过程中,产生的一些样本并不真实,所以会导致一定的问题,所以学习的最后reponse map就会比较凌乱。造成一定的定位困难

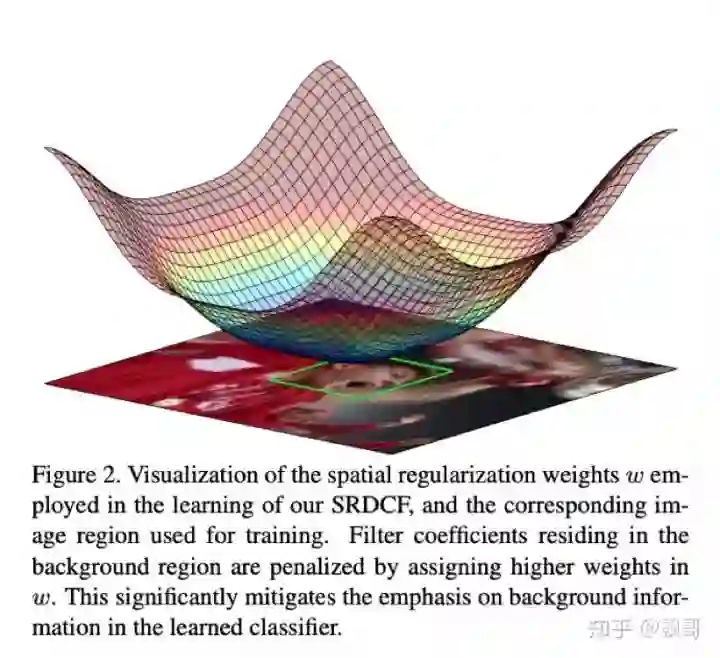

SRDCF:《Learning Spatially Regularized Correlation Filters for Visual Tracking》

Spatially Regularized Discriminative Correlation Filter ,SRDCF(2015)是在DCF的基础上针对边界效应提出的解决方案,它加入了空间惩罚项,在效果上取得了突破性的进步,但空间惩罚项的加入破坏了岭回归方程的封闭解,只能用高斯-赛德尔迭代法求解,使得运算速度非常慢。 SRDCF是在学习滤波器的基础上加了一个逆高斯形状的空间正则,让你学习的滤波器组更加关注目标的中心,关注更加真实的区域。

BACF: ICCV17《Learning Background-Aware Correlation Filters for Visual Tracking》

Bacf对滤波器组成了一个二值mask,直接让滤波器组观测到目标的区域。

但当我们再把相关滤波和深度特征结合起来时,发现了一些问题:

第一个问题:深度特征

特别是在imagenet上以检测任务或分类任务pre train model,会有一些我们不期望的响应,如要跟踪的是一个人,但他特征响应却在其他区域是高亮度,这时候你就会在滤波器学习的过程中驱动滤波器关注高亮显示的区域,

会关注上图中车手把手之间有高亮的灯光。也就是在目标框内,有拍得比较明显的背景,会导致相关滤波学效果不好。

第二个问题:相关滤波的计算速度问题

相关滤波提出的动机是能够高效的进行计算,所以相关滤波开始提出的算法都是非常快的,甚至在CPU下都是非常快的。但结合深度特征之后,它的速度会变得很慢。

本文工作的的动机是针对解决这两个问题。在文中给出了一个更加有效的一个限制,和一个更加高效的尺度估计的方案。

ASRCF

下面介绍本文的模型Adaptive Spatially-Regularized Correlation Filters(ASRCF)

本文model非常简单,在传统CF基础上加自适应空间正则Adaptive Spatially-Regularized(下图画框部分)

就是这个空间正则是要进行学习的。自适应的呈在滤波器组上,同时给他一个先验信息。由于卷积操作包括一个二值的抠图操作,所以导致这个原始的问题解起来很难,本文对对它做了一个变形,

还进行了傅立叶变换,把原始的无限制优化问题,变成了一个等式限制的优化问题。然后用admm算法求解。

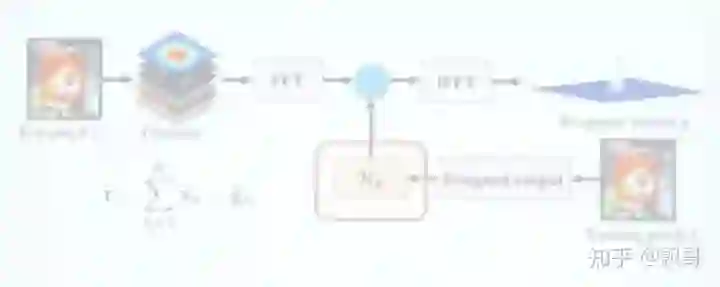

当学习到滤波器组,就可以用傅立叶变换和滤波器组的反变换去定位目标。 然后传统的相关滤波算法的一些工作,想要做目标的尺度估计,他们是把图像块做不同的缩放再做提取,对它们提取同样的特征后在多尺度上进行估计,然后选择response最大的尺度。 当用深度特征会比较麻烦,每次都要重新提取深度特征,导致计算效率会比较低。本文用了一个非常简单的策略,这个策略可以移植到任何一个相关滤波算法中,

只需要在一些浅层特征,甚至在手工设计特征上非常高效的去估计尺度,然后在深度特征层上去估计定位,因为本文用的特征都是分类任务pre train model, 所以说它并不完全对应的跟踪问题,在目标表示方面,就能够表示目标这个类的属性,所以它具有一定的定位优势。但是由于它过于抽象,并不能给目标一个很好的边界支撑,所以本文采用在浅层特征,如hog特征上估计尺度,这两个迭代的去求解。这个估计会非常快,比如传统的kcf model在的cpu情况下达到300多fps。

实验

平台

MAT- LAB2017a platform with the MatConvNet toolbox, and runs on a PC machine with an Intel i7 8700 CPU, 32GB RAM and a single NVIDIA GTX 1080Ti GPU, 11G memory。 大概速度在28fps,这个配置在相关滤波在深度学习特征算法中是比较快的。

Feature

an ensemble of deep (Norm1 from VGG-M, Conv4-3 from VGG-16) and hand- crafted (HOG) features for object representation. 深度特征和浅层特征的结合

scale estimation

merely use five-scale HOG features for scale estimation. 尺度估计用了5层的hog特征

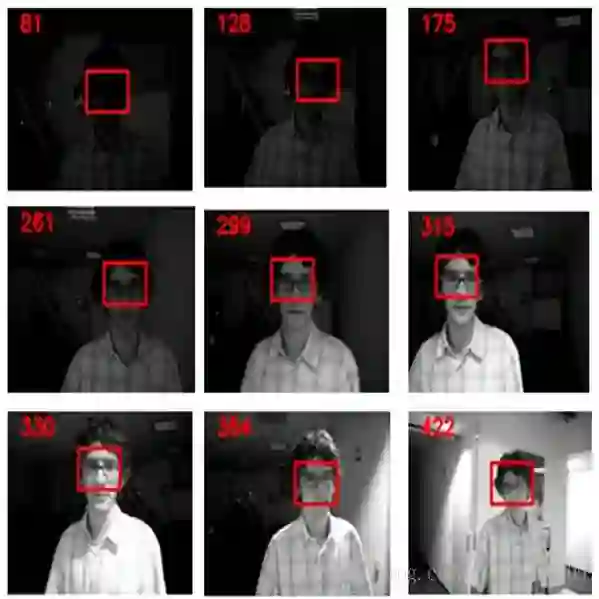

上图中图片的上部分是学习到的w(可视化),当目标发生遮挡时候(第二行第二张第三张),w的值会变大,就是给滤波器的惩罚变大了,滤波器自身学习到的幅度变小,在下一帧跟踪的时候,这部分滤波器起到的作用就会比较小。

下面是定量的结果

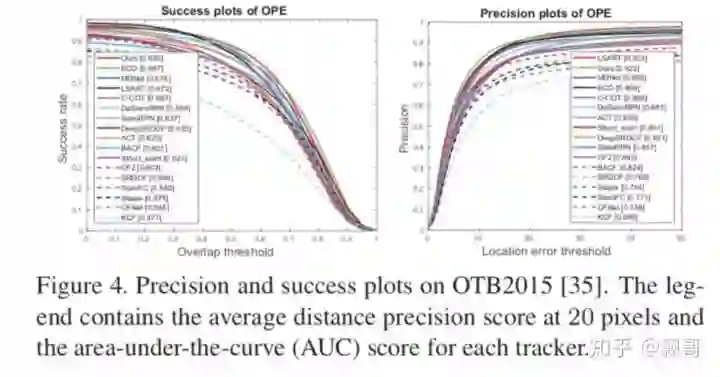

上图是在otb数据集上的测试结果。下图是与相关算法做比较的结果:

经过实验对比,验证了本文的方法在精度和速度上都具有一定优势,速度优势的来源是在浅层特征上估计尺度。这种估计方案很简单,可以移植到任何相关滤波算法中。

下图是在tc128数据集上的测试结果:

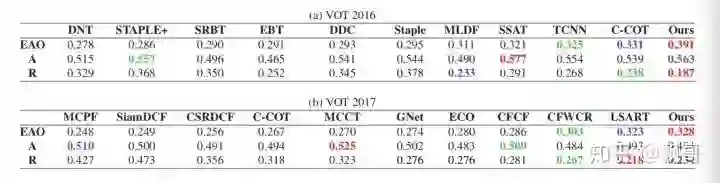

下图是在vot2016和vot2017数据集上的测试结果:

在这两个测试数据集上的测试结果,比官方汇报的所有tracker都要好。

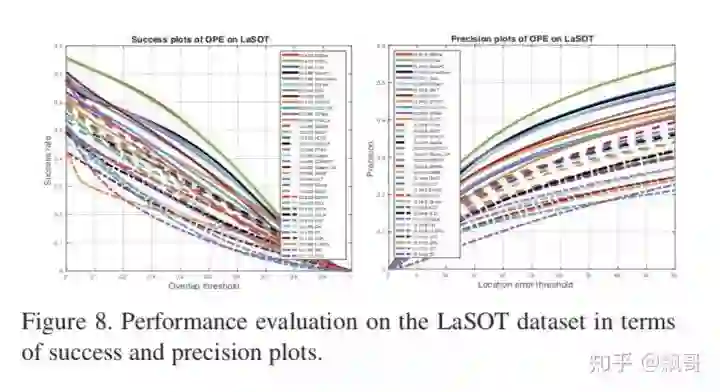

(LaSOT由1400个序列组成,总帧数超过350万。这些序列中的每一帧都小心翼翼地用一个边界框手工标注,使LaSOT成为我们所知最大的、标注密集的跟踪基准。LaSOT的平均视频长度超过2500帧,每个序列都包含来自野外的各种挑战。) 上图是在最新的数据集A High-quality Benchmark for Large-scale Single Object Tracking上测试的结果,与其他算法相比非常有竞争力,但不是最好的结果。

上图a是本文对ASRCF算法做了自我比较分析,试验结果表明自适应正则和浅层特征上的尺度估计都会对结果有一定的提升。 另外用浅层特征和尺度估计重新实现了几个相关的model(上图b),也会达到最好的结果,说明model是有效的。 本文的贡献是提出了自适应相关滤波算法,而且取得了很高的精度和速度。

未来的工作方向

offline feature learning

如何在offilne端学习到更适合相关滤波的特征temporal consisitency modeling

如何做时间一致性的建模long term visual tracking

长时视觉跟踪,本文作者发现在lasot数据库上的结果表现的不好的原因是lasot数据库的帧数非常长(2500帧),这种相关滤波在线自适应学习拟合的机制,本文作者测算了达到500帧的时候会达到一个性能瓶颈,超过500帧会有学习失败的风险,所以做长时跟踪和短时跟踪交互也是一个有意思的问题。

*延伸阅读

点击左下角“阅读原文”,即可申请加入极市目标跟踪、目标检测、工业检测、人脸方向、视觉竞赛等技术交流群,更有每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流,一起来让思想之光照的更远吧~

觉得有用麻烦给个好看啦~