KDD20 | 基于动态知识图谱的多事件预测

论文专栏: KDD2020知识图谱相关论文分享

论文解读者: 北邮 GAMMA Lab 博士生 马昂

题目: 基于动态知识图谱的多事件预测

会议: KDD 2020

论文地址: https://dl.acm.org/doi/10.1145/3394486.3403209

推荐理由: 从开源社交传感器对多种类型的并发事件及其参与者进行建模是许多领域的重要任务,例如,医疗保健,救灾和财务分析。事件预测可以帮助人类了解动态并做出快速而准确的决策。预期可能参与这些活动的参与者也可以帮助利益相关者更好地应对意外事件。在本文中,作者首先利用GCN和CompGCN对Temporal Event Graph 和 Temporal Word Graph进行建模,学习节点表示。其次,基于Attention机制,对Temporal Event Graph和Temporal Word Graph的节点表示进行融合。最后,利用RNN,对时间信息进行编码,完成事件预测和事件参与者预测任务。在数据集ICEWS上进行了实验,结果表明,该方法优于目前用于社会事件预测的最新方法,并且该方法还具备可解释性。

1 引言

对多种类型的并发事件及其参与者进行建模是许多领域的重要任务。目前,此类工作面临着一些挑战:

-

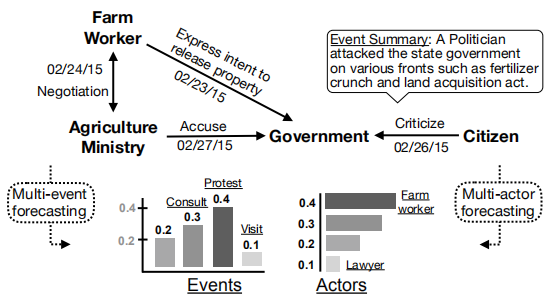

结构化和非结构化特征。事件数据包含结构化数据,例如,时间、参与者、类型等,同时也包含很多非结构化数据,例如,文本信息(如下图边上的event summary),很少有研究进行异构数据融合以进行并发事件预测。 -

大多数知识图谱补全方法仅对关系数据的固有结构建模,而无法利用全局历史数据来进行未来事件预测 -

对事件建模的先前研究主要集中在使用预定义特征或预训练嵌入来预测将来的事件发生或计数。从基于图的文本特征中自动提取事件参与者是一项困难的工作。

问题定义

本文主要解决两个问题:事件预测、事件参与者预测。

-

Multi-Event Forecasting.

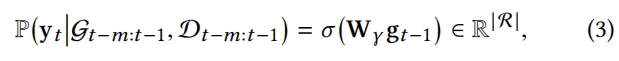

我们基于历史输入数据 对未来时间戳 t 发生的一组事件类型的概率进行建模:

在本文中,事件预测的问题定义可以形式化为下图所示,我们利用 和 来替代前m段历史输入数据 ,问题将转化为如何计算 t-1时刻global latent embedding

-

Multi-Actor Forecasting

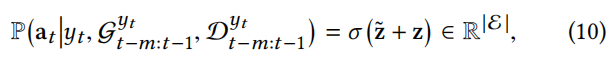

给定事件的相关历史数据,我们对给定类型的事件 中涉及的一组参与者(实体)的概率进行建模:

在本文中,事件参与者预测的问题定义可以形式化为下图所示,

相关定义:

-

Temporal Event Graph

时间事件图建立在以时间顺序 递增的事件集序列上,时间 t 处的事件集为

-

Temporal Word Graph

对于每个时间戳 t ,Temporal Word Graph为一个无向图,记为 ,其中每个节点表示 中的唯一词。边是根据单词共现形成的。我们使用point-wise mutual information (PMI)来度量两个单词的语义相关性-作为边缘权重。

2 方法

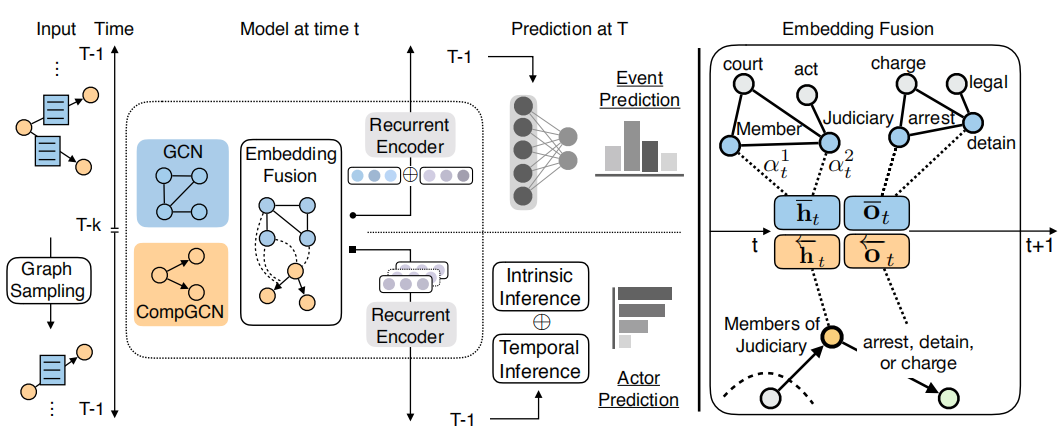

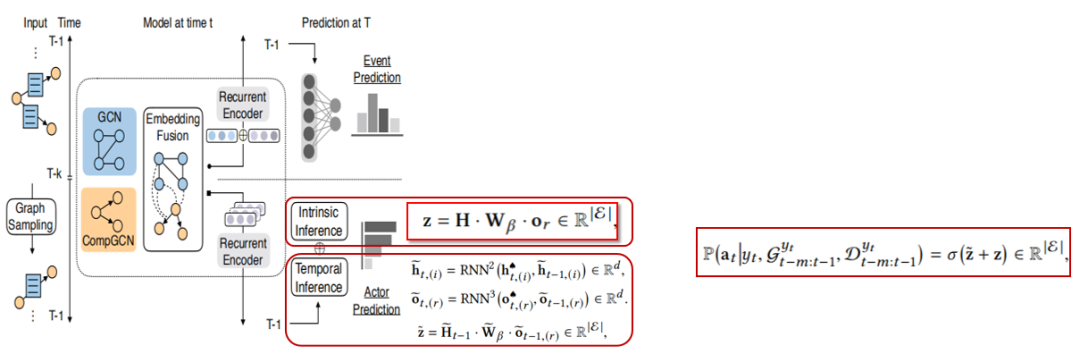

本文方法的框架结构,如下图所示。主要由3部分构成,首先利用GCN和CompGCN对Temporal Event Graph 和 Temporal Word Graph进行建模,学习节点表示。其次,基于Attention机制,对Temporal Event Graph和Temporal Word Graph的节点表示进行融合。最后,利用RNN,对时间信息进行编码,完成事件预测和事件参与者预测任务。

2.1 事件预测

如前所述,事件预测主要由3部分构成:Graph Aggregation、Context-aware Embedding Fusion、Recurrent Encoder,下面将进行具体介绍。

Graph Aggregation

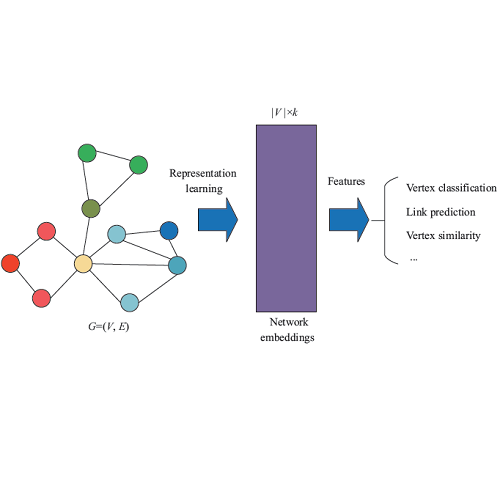

在这一部分,我们将分别从Temporal Event Graph 和 Temporal Word Graph中,学习节点表示。

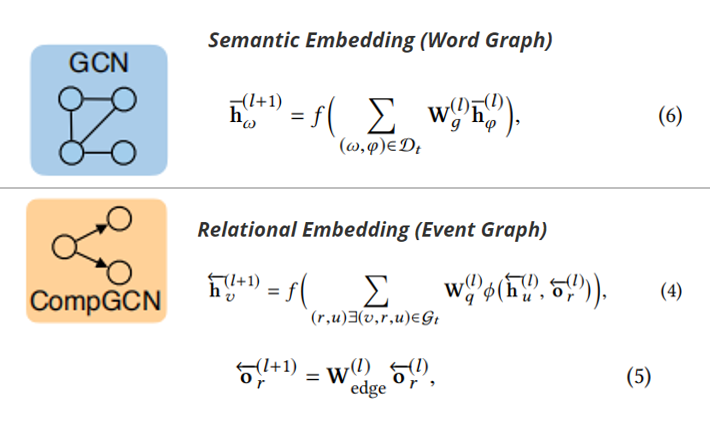

(1)针对事件图谱,我们利用CompGCN(多关系图神经网络)来对事件图谱的节点和边进行embedding(如下图的公式(4)(5)所示)。

(2)针对词图,我们利用经典的GCN方法,聚合邻居节点(如果PMI>0, 则表示有边)的信息,来对每一个word进行embedding。

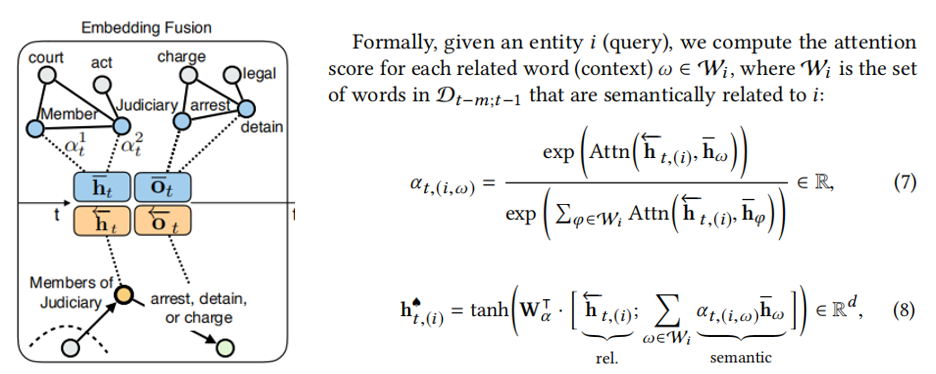

Context-aware Embedding Fusion

通过Graph Aggregation,我们分别得到了Event graph和Word Graph的节点表示。接下来,是利用word的信息对事件图谱中的节点进行补充,进而得到新的节点表示(基于Attention 机制)。下图展示的是事件知识图谱中实体(事件)节点的融合,关系节点(事件类型)的融合与之类似,只需将

替换为

-

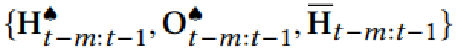

Recurrent Encoder

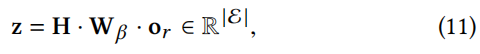

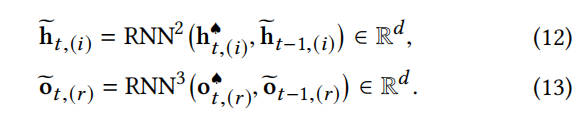

给定一系列事件和事件类型的融合embedding(下图前两位)以及单词embedding(下图最后一位),我们采用递归神经网络对时间信息进行建模。

具体如下图所示,有了 之后,套入前面所介绍的公式(3),即可完成事件预测任务。

2.2 事件参与者预测

由公式(10)可知,事件参与者预测是在给定事件类型 的情况下,进行的预测任务。因此,我们无需在整个Event Graph和整个Word Graph在进行操作,可以进行一个Graph Sampling操作。

Graph Sampling

(1) 针对Event Graph,我们采用 edge sampling 从 global temporal event graphs 得到 subgraph. 具体来说,给定时刻t下的Event graph 以及事件类型r, 我们首先从 中找出事件类型为r的元组, 记为,

在从中得到 subject set ,记为,

并找到 first level neighboring edges.

总的sampled edge set 记为,

重复此操作,以对更高级别的相邻边进行采样。最终,在时间t,r的事件子图可以表示为

(2) 针对Word Graph,我们仅考虑事件子图中的事件/边的文本摘要。r在时间t的时间词子图表示为

在事件参与者预测中,我们考虑两个因素:Intrinsic Inference、Temporal Inference

(1) Intrinsic inference

我们利用RESCAL方法,对实体(事件)和每个给定的事件类型的固有关联进行建模,如下所示,

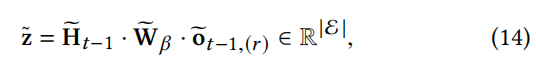

(2) Temporal Inference

与事件预测类似,我们使用RNN对时间信息进行编码,如下图所示,

这部分的结构,如下图所示,

2.3 学习与推测

在多标签学习中,我们定义了一个实例空间X和标签空间 . 其中, 介于0-1,且

我们使用真实标签的分布,而不是二进制1或0。

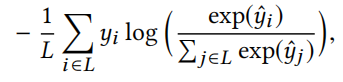

我们采用分类交叉熵损失,其定义为

其中, 是有公式(3)和公式(10)计算得到的预测值。

在推断时,我们利用类别得分 以及阈值0.5来确定多事件预测问题中事件的发生。事件参与者预测问题与排名问题类似。

3 实验

实验数据集采用冲突早期预警系统数据集(Integrated Conflict Early Warning System,ICEWS)

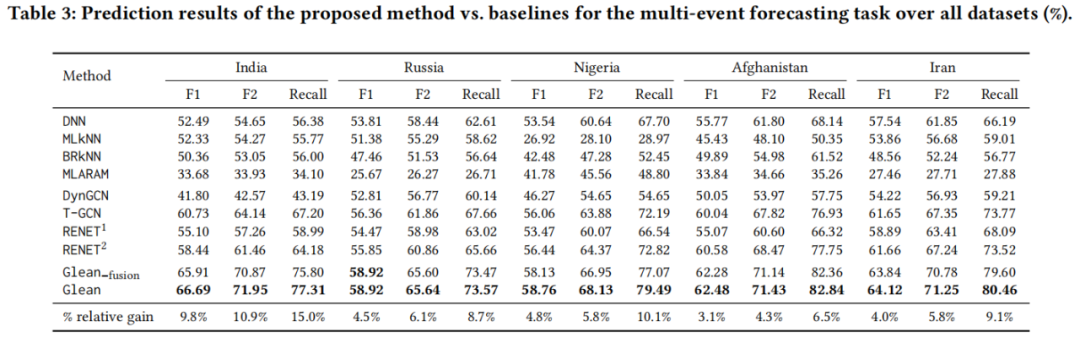

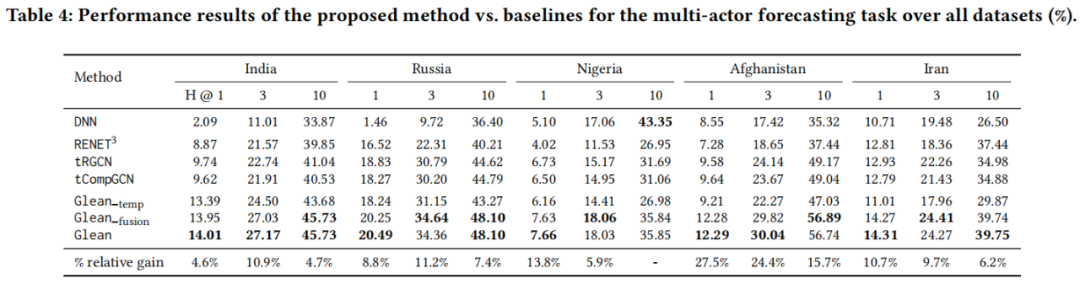

本文测试了模型在事件预测,如表3所示,和事件参与者预测,如表4所示,的效果。评价指标采用了预测常用的指标F1、F2、Recall,以及排名问题常用指标H@X。Glean-fusion、Glean-temp分别表示省略事件预测中的Context-aware Embedding Fusion模块,以及省略事件参与者预测的temporal inference 模块。可以看出在事件预测部分Glean的效果普遍优于目前的基线方法。在事件参与者预测部分,Glean与Glean-fusion的效果相差不大,一个可能的原因是,在图采样之后,word subgraph可能没有包含足够的语义信息,从而使融合的嵌入变得毫无用处。它还证明了关系信息在预测事件参与者中的重要性。

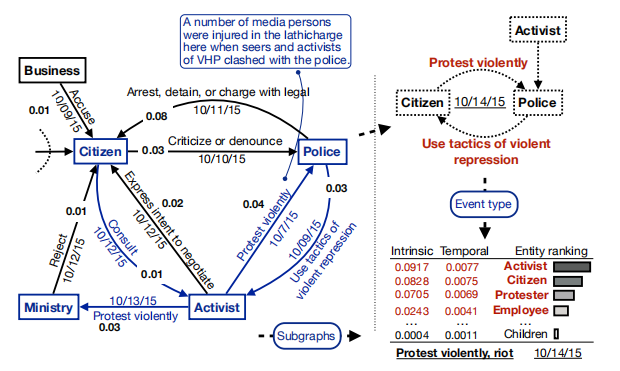

下图是一个Case Study,蓝色部分来自采样的子图,红色部分是预测的结果。

4 总结

预测不同类型的并发事件并推断参与人员是决策者和政策制定者的重要任务。本文提出一种新的基于动态知识图的模型,具有上下文感知的嵌入融合来处理异构图数据。在真实数据集上的实验表明,提出的模型在事件预测与事件参与者预测等方面效果都超过了现有的模型。未来的工作将考虑为看不见的和罕见的事件类型或实体建模,并在新数据到达时动态扩展参与者和事件类型集。另一个重要的方向是对事件主体和客体之间的隐藏关系进行建模以推断出完整的事实。

由于微信平台算法改版,公号内容将不再以时间排序展示,如果大家想第一时间看到我们的推送,强烈建议星标我们和给我们多点点【在看】。星标具体步骤为:

(1)点击页面最上方"AINLP",进入公众号主页。

(2)点击右上角的小点点,在弹出页面点击“设为星标”,就可以啦。

感谢支持,比心

推荐阅读

征稿启示| 200元稿费+5000DBC(价值20个小时GPU算力)

完结撒花!李宏毅老师深度学习与人类语言处理课程视频及课件(附下载)

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

文本自动摘要任务的“不完全”心得总结番外篇——submodular函数优化

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

阅读至此了,分享、点赞、在看三选一吧🙏