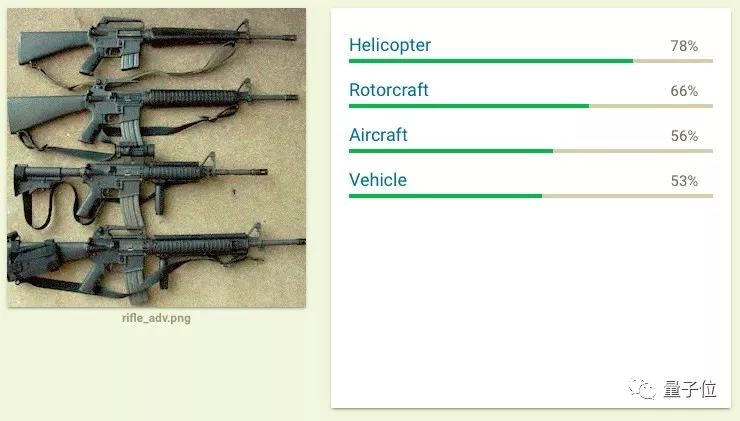

这一次,MIT的科学家让谷歌AI把步枪误认成直升机

安妮 编译整理

量子位 出品 | 公众号 QbitAI

这是什么?

熟悉枪械的盆友可能一眼就认出这是步枪,即使对枪种类不熟悉的同学也能认出这最可能是枪。

但……这道题对谷歌Cloud Vision API并不简单,经过推理后,这个AI认定图中物体为直升机。

看到谷歌AI认错,MIT CSAIL(计算机科学与人工智能实验室)的研究人员可能要笑了。事实证明,他们的“恶作剧”成功了。

曾有段黑历史

这不是CSAIL研究人员的首次尝试。

今年11月,他们创建的Expectation Over Transformation (EOT)算法在识别带纹理图案的3D模型后,继而生成它的对抗性图像,骗过了谷歌InceptionV3图像分类器,让系统将3D乌龟模型误认为是步枪。

△ 这又是什么?

这个对抗样例很大程度上是在“白盒”设置中设计的,研究人员了解InceptionV3的工作机制,知道如何去捉弄它。

因为这种对抗性例子与真实世界不太相似,AI系统攻击者无处寻找特定算法,因此“白盒”攻击的威胁性不大。

步枪=直升机?

但这次步枪当成直升机的研究,不一样。

在将步枪错认成直升机的例子中,MIT研究人员是在“黑盒”环境下进行研究的,他们事先不知道里面的算法是什么样的。

他们设计出了一种快速生成黑盒对抗示例的方法,具备骗过不同算法的能力,连谷歌的Cloud Vision API也不幸遇难。仅仅稍微调整了图像像素,这一排枪就被识别成了直升机。

研究人员不只是随机调整照片,他们用一种标准方法试图欺骗AI系统。每一次试图愚弄AI时,他们会分析结果,然后慢慢向可以欺骗系统认为这是特定物体的方向引导。

研究人员随机生成标签,在步枪的例子中,“直升机”分类器也可以很容易地成为“羚羊”分类器。他们想证明他们的系统是有效的,无论选择什么标签。

也可以误导AI将滑雪的人类认成是狗,比如下面这个视频——

谷歌对此不予置评。

黑盒机器学习分类器的对抗样本

在论文Query-Efficient Black-box Adversarial Examples中,研究人员从技术层面介绍了这项研究的重要性和研究方法:

当前,基于神经网络的图像分类器易受到对抗样例的影响,即使在被限制在查询访问而非梯度访问的黑盒设置中也是如此。像以往替代网络(substitute networks)和基于坐标的有限差分法等要么不可靠,要么查询效率低,在一些问题上并不可行。

在这篇文章中,研究人员引入了一种可靠的生成对抗样例的新方法,这也适用于更具限制性和实际性的黑盒研究中。

首先,研究人员用自然进化策略来执行黑盒攻击,使用的query比以前的方法少2到3个数量级。紧接着,研究人员引入了一种新算法,可在局部信息设置中进行针对性的对抗攻击,攻击者可访问的目标类别有限。通过这种技术,MIT研究人员成功在局部信息设置中进行了首次针对性的对抗性攻击,谷歌的Cloud Vision API首当其冲。

相关资料

论文地址:

https://arxiv.org/abs/1712.07113

如果想在谷歌Cloud Vision中自己验证是否会将滑雪的人类误认成狗,还能自己去验证一下:

原图地址:

http://www.labsix.org/media/2017/12/20/skier_orig.png

处理后图像:

http://www.labsix.org/media/2017/12/20/skier_adv.png

谷歌Cloud Vision Demo:

https://cloud.google.com/vision/

— 完 —

活动报名

加入社群

量子位AI社群12群开始招募啦,欢迎对AI感兴趣的同学,加小助手微信qbitbot4入群;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进群请加小助手微信号qbitbot4,并务必备注相应群的关键词~通过审核后我们将邀请进群。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态