MIT本科学神重启基于能量的生成模型,新框架堪比GAN

选自 OpenAI

作者:Yilun Du、Igor Mordatch

机器之心编译

参与:思源、张倩

自从 GAN 出世以来,顶尖的生成模型都采用了这种框架。然而从去年的 Glow 到最近的 EBM,很多研究者都尝试探索不同的生成框架。在这篇论文中,OpenAI 的研究者提出一种能高效训练基于能量模型(EBM)的方法,它能获得媲美 GAN 的效果。

值得注意的是,一作 Yilun Du 还是 MIT 的大四本科生,他从 15 年大一开始就发过 ECCV 16、NIPS 18 等多个大会和 Workshop 的论文,加上这篇论文一共 8 篇。Yilun Du 的工作经验也非常多,他在 Facebook 做过软件工程实习生,目前在 OpenAI 多智能体强化学习团队做研究。Yilun Du 的简历表示,他在 MIT 的 GPA 为 5.0/5.0,这基本上属于学神的领域了。

在 Yilun Du 等研究者的这篇论文中,OpenAI 在基于能量模型(EBM)的稳定和可扩展训练方面已经取得了进展,从而获得了比现有模型更好的样本质量和泛化能力。EBM 中的生成过程花费更多的算力来不断精炼(refinement)其生成结果,这样做可以在低 temperature 条件下生成与 GAN 媲美的样本,同时还具有基于似然模型的模式覆盖率保证。他们希望这些发现能促进对这类模型的进一步研究。

生成建模是一种与观察数据(如图像或文本)有关的任务,它需要学习建模潜在的数据分布。完成这项任务可以让模型理解数据中的高级特征,并合成看起来真实的样例。生成模型在自然语言、机器人学和计算机视觉方面已经有广泛的应用。

基于能量的模型通过为每个输入数据点分配一个非归一化的概率标量(或「能量」)来表示数据上的概率分布。这提供了实用的模型灵活性——在给定输入的情况下,任何输出实数的模型都可以用作能量模型。然而难点在于从这些模型中采样,它也导致了 EBM 模型不能像 GAN 或 VAE 那样快速训练。

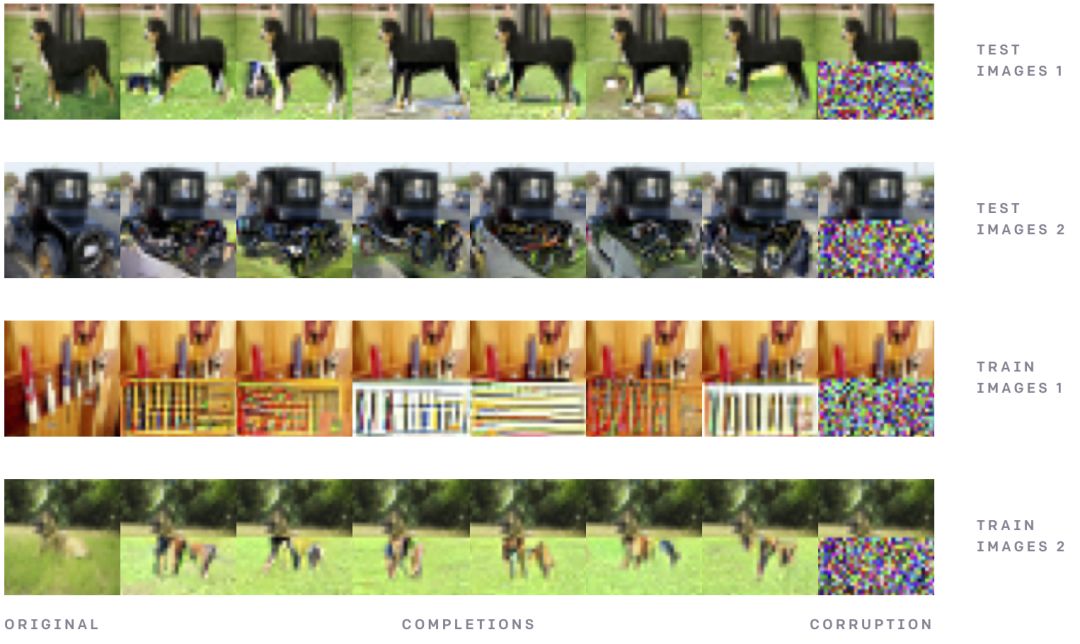

条件 ImageNet 32x32 模型样本。

为了从 EBM 中生成样本,Open AI 使用了一种基于 Langevin dynamics 的迭代精炼过程。通俗地说,这包含了在能量函数上执行噪声梯度下降,以达到低能量配置(更多细节见论文)。与 GAN、VAE 和基于 Flow 的模型不同,这种方法不需要一个显式的神经网络来生成样本,也就是说,样本的生成过程是隐式的。EBM 和迭代精炼的结合有以下好处:

自适应计算时间:可以长时间执行序列精炼,以生成优质、多元的样本,也可以在较短时间内生成粗糙、单一的样本。已知在有限的时间内,这一过程可以从能量模型中生成真实的样本。

不受生成网络限制:在 VAE 和基于 Flow 的模型中,生成器都必须学习如何从连续空间映射到到包含不同数据模型的不连续空间,这需要模型有很大的拟合能力,而且可能无法完成学习。相比之下,EBM 可以轻松学习在互斥区域分配低能量。

内置语义合成:由于每个模型都表示一个非归一化的概率分布,因此可以通过专家模型或其他分层模型自然地组合模型。

生成

作者发现基于能量的模型能够生成高质量、高数量的高清图片,特别是在测试阶段长时间运行精炼流程。通过在单张图像上执行迭代优化,研究者可以自动补全图像,并把图像从一种类别(卡车)改变为另一种类别(青蛙)。

在条件 ImageNet 模型上执行图像补全,该模型展示了图像修补中的多样性。注意输入来自于测试分布,并非模型样本,它表示测试数据的覆盖范围。

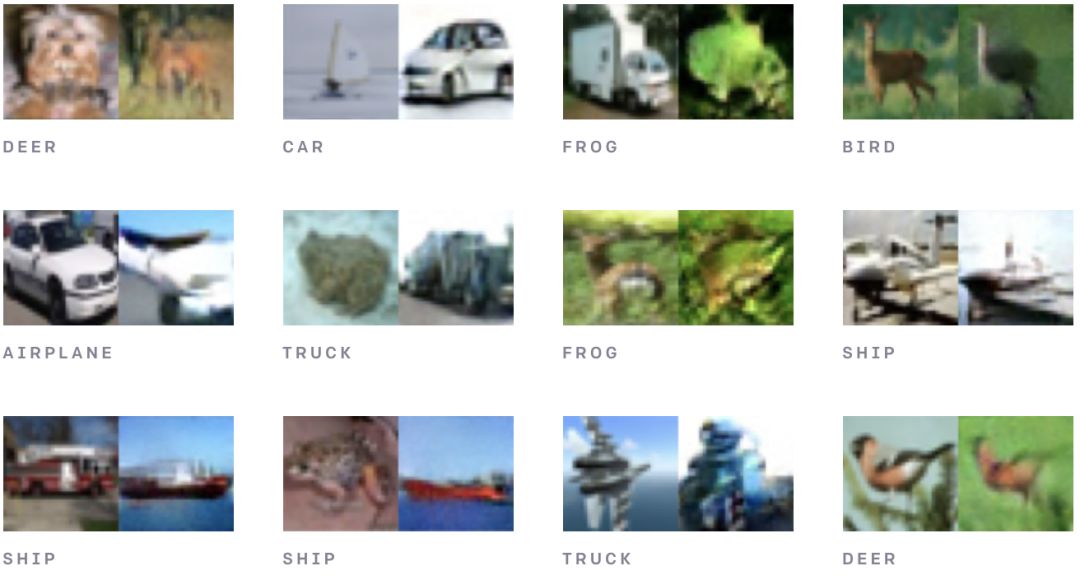

在条件模型上的跨类别隐式采样,模型以特定类别为条件,但用一张来自独立类别的图像做初始化。

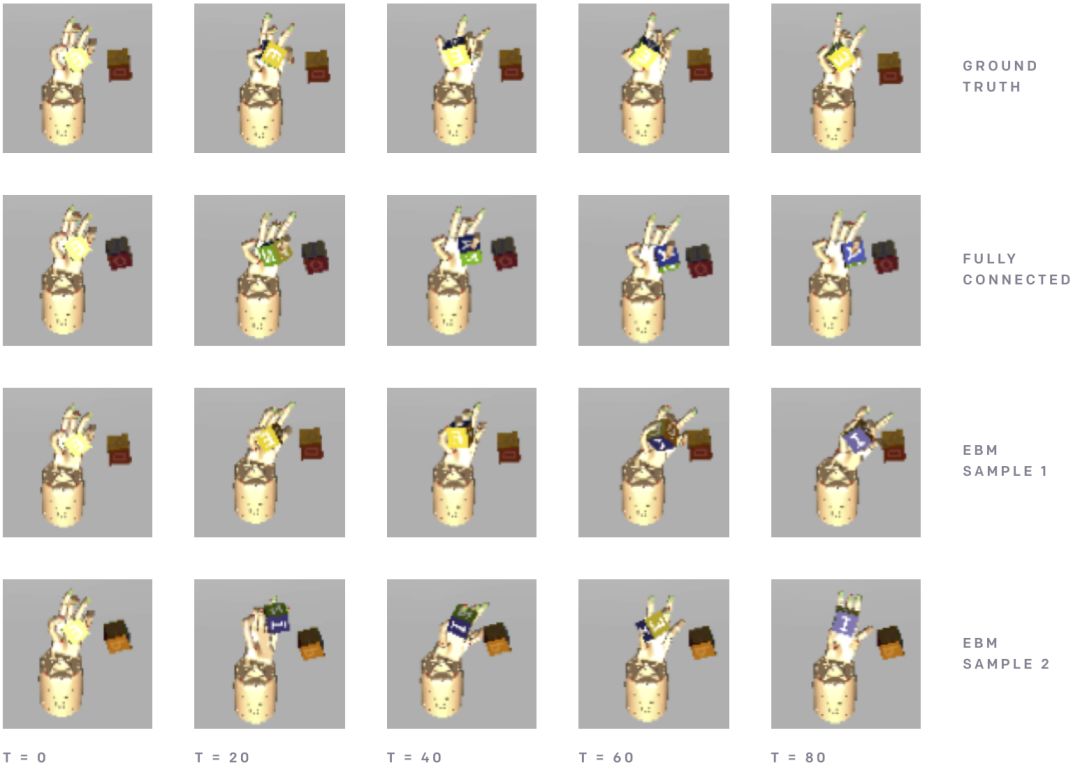

除了生成图像,作者发现基于能量的模型在大量时间步骤上能够生成稳定的机器人动态轨迹。虽然前馈模型不能做均值预测,EBM 却能够生成一系列不同的可能性。

自上而下查统一启动状态下无条件生成的机器臂操作轨迹。FC 网络预测到了一个不动的手臂,然而 EBM 能够生成可执行的不同轨迹。

泛化性

研究者还在几种不同的分布外(out-of-distribution)数据集上测试了 EBM 的分类效果,他们发现基于能量的模型要比其它似然模型有更好的效果,例如流模型或自回归模型等。作者同样使用条件 EBM 测试了分类任务,并发现分类结果对于对抗扰动具有很好的泛化性。尽管他们的模型从未为分类任务训练过,但比那些专门为对抗扰动进行分类训练的模型效果还要好。

研究经验

研究者发现了很多有意思的观察结果,但目前并不是太确定这些结果是不是正确,不过这些经验可能对后续研究有一些帮助。

研究者发现原版 HMC 用于 EBM 训练非常困难,因为训练过程中的最佳步长和 leapfrog 模拟数量差别很大,不过应用适应性 HMC 可能是比较有意思的扩展。

研究者发现执行能量函数的集成训练会很有帮助,即采样和评估都在集成上进行,但并不值得为这些提升而增加模型复杂性。

研究者在添加梯度罚项时并不能取得很好的效果,可能是因为梯度罚项会损失模型的能力与采样效果。

更多的模型细节与实验细节可以查阅该研究论文。

论文:Implicit Generation and Generalization in Energy-Based Models

论文地址:https://arxiv.org/pdf/1903.08689.pdf

项目地址:https://github.com/openai/ebm_code_release

摘要:因为在似然函数建模中的简洁与通用,基于能量的模型(EBM)吸引了很多研究者的关注,但这种模型不太容易训练。我们提出了一种技术以扩展连续神经网络上基于 MCMC 的 EBM 训练,展示了它在高维数据上的效果,例如 ImageNet 32x32、ImageNet 128x128、CIFAR-10 和机械臂轨迹。在这些数据集中,EBM 比其它似然模型能显著生成更好的样本,它能在覆盖数据所有模式的同时得到和 GAN 相媲美的性能。

我们强调隐式生成的独特能力,例如能量的合成性、图像修复重建和图像补全等。最后,我们展示了 EBM 能泛化地非常好,并能实现当前最优的分布外(out-of-distribution)分类效果。此外,EBM 还能展现出对抗性鲁棒的分类、连贯地长期预测轨迹变化,并生成 zero-shot 的模型合成。

点击阅读原文报名参与↓