CSIG云上微表情第21期研讨会成功举办--Facial Expression Coding

研究背景

情感是人对客观事物满足的态度体验,对人的心理健康和社会行为起着至关重要的作用。情绪由三部分组成:主观体验、外在表现和生理唤起。情绪的外在表现往往体现在面部表情上,面部表情是表达和识别情绪的重要工具。表达和识别面部表情是人类社会交往的重要技能。

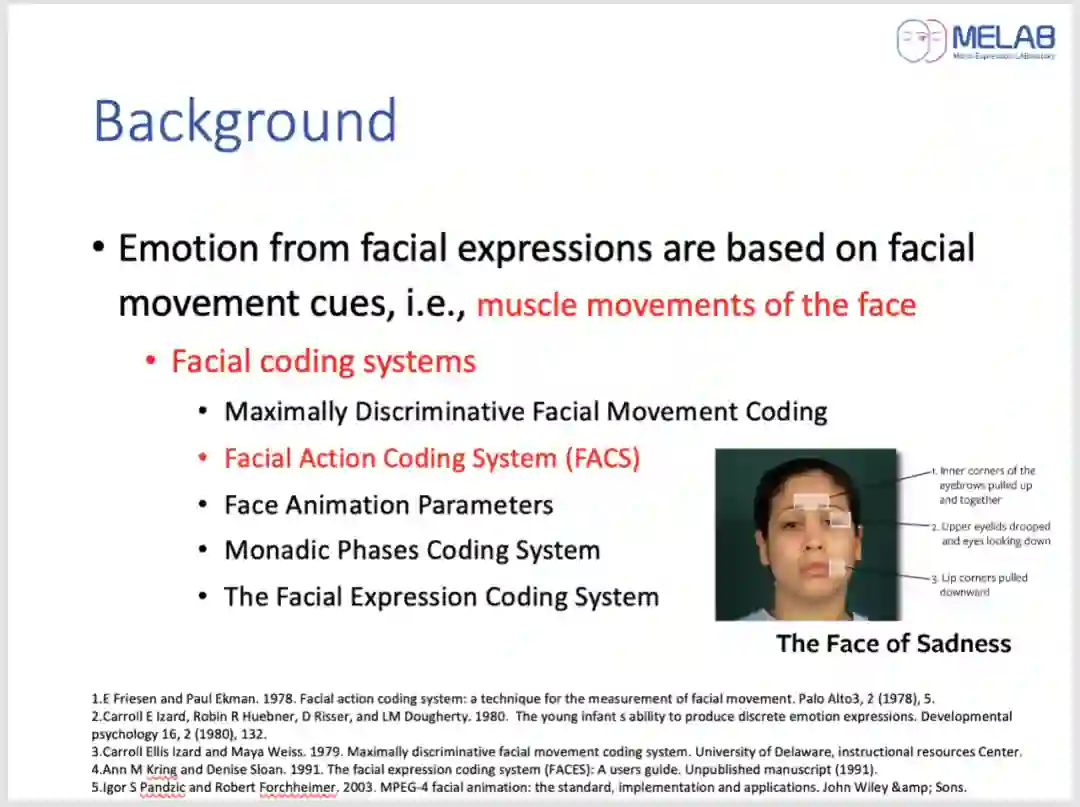

许多研究已经证明,从面部表情推断情绪是基于面部运动线索,即面部肌肉运动。基于对面部肌肉运动的认识,研究者通常通过建立面部编码系统来客观地描述面部肌肉运动。

近年来,随着计算科学技术的快速发展,深度学习方法开始被广泛应用于面部动作单元的自动检测和识别,使自动表情识别在实际应用中成为可能,包括安全、临床等领域。

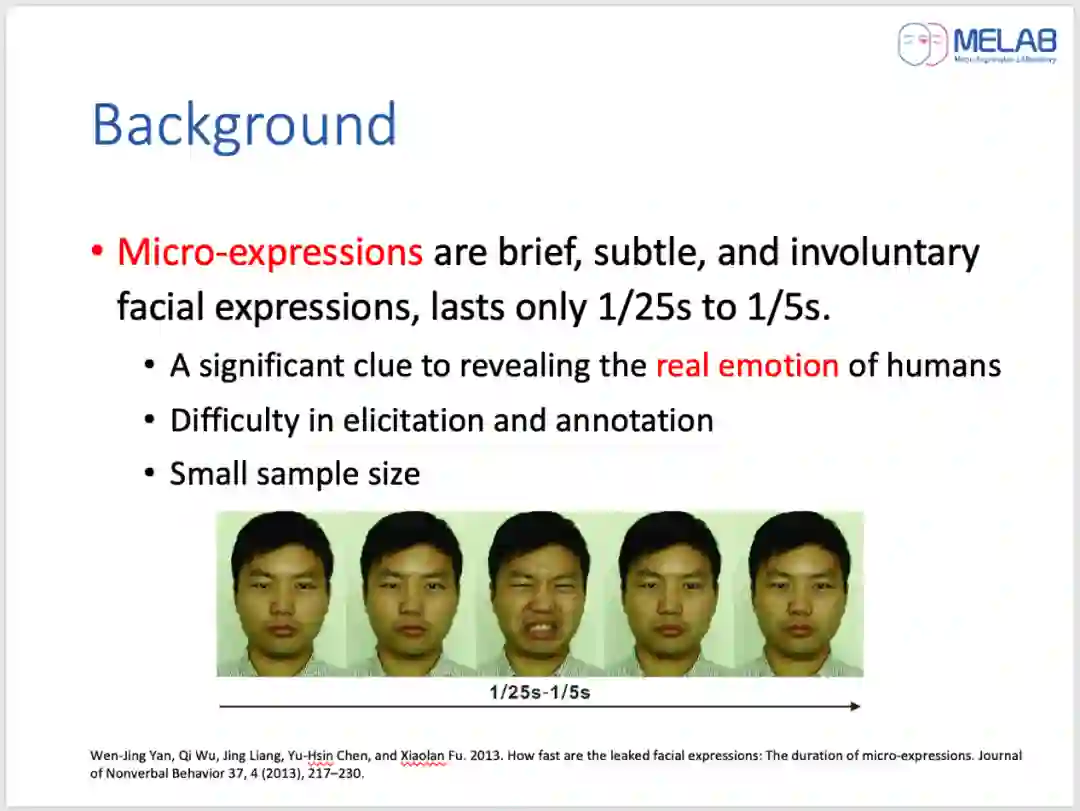

但是,研究人员发现,普通的面部表情(宏观表情)并不能一直反映一个人的真实情绪。而微表情的出现则被认为是揭示人类真实情感的重要线索。研究表明,当人们试图隐藏或抑制自己真实的主观感受时,他们会表现微表情。微表情是短暂的、微妙的、不由自主的面部表情。与宏表情不同,微表情只持续1/25到1/5s。

目前常用的标注方法是参照Ekman等人提出的FACS对AU进行标注。FACS是使用最广泛的人脸编码系统,手册超过500页。手册中包括了Ekman对每个AU及其含义的详细解释,并提供了AU的示意图和可能的组合。然而,当AU被视为面部表情(宏表情和微表情)分类的标准之一时,通常需要一个经过FACS认证的专家来进行标注。冗长的手册和认证过程提高了AU编码的门槛。

因此,报告将重点放在对真实情绪做出反应的宏表情或微表情上,分析控制面部肌肉运动的大脑皮层、面部肌肉、动作单位与表情之间的关系。基于这些分析,从理论上解构AU编码,系统地突出每种情绪的特定区域。最后,为标注者提供了一个便于AU编码、表情标注和情感分类的标注框架。

-

动作单元(AU)与情绪之间的关系

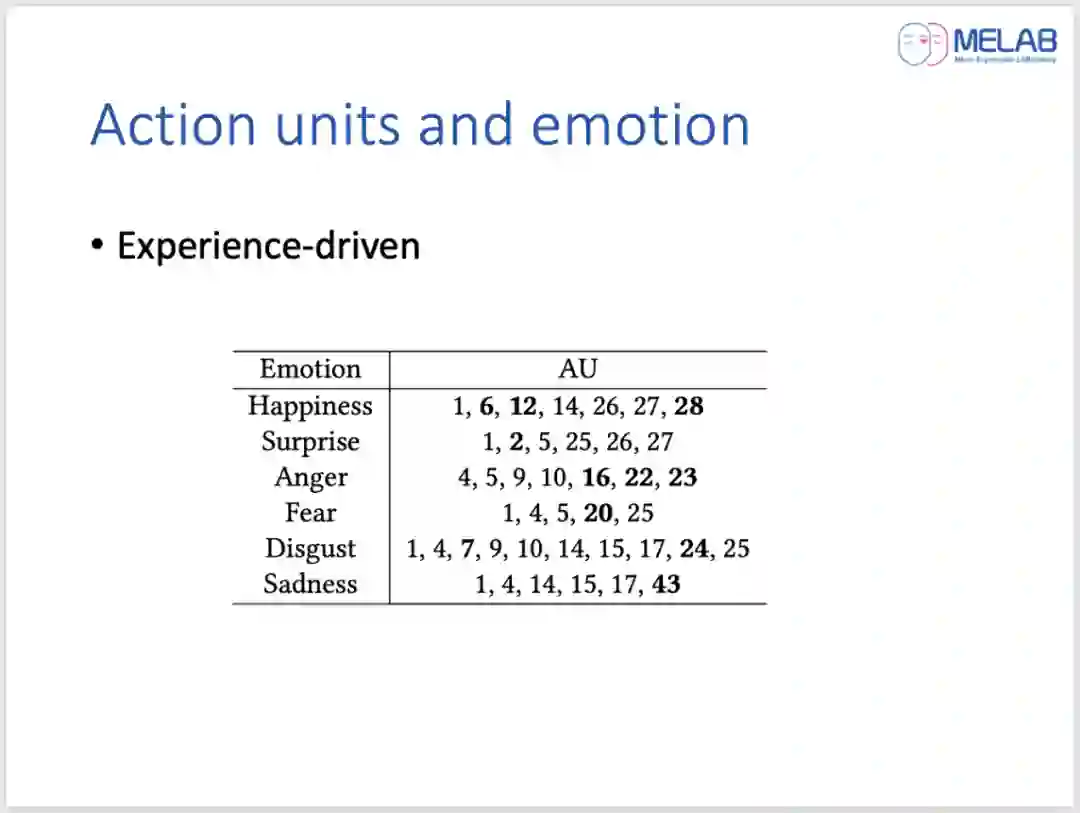

首先介绍了面部表情的生理基础。然后通过对RAF-AU数据库中的5000张图像进行数据驱动分析,并结合专业编码器的经验,得出了AU和情绪之间的关系。

使用了两种方法对数据进行了分析:第一种是取得分最高的作为该图像的表情,然后和标注的AU进行组合。该方法中需要去除重复的组合,避免由于某一类样本居多而导致的结果差异,从而缓解样本的不平衡性。第二种是不去除重复,统计所有AU对六种情绪贡献的加权和。

伪代码细节见下面的算法1和2。表1和表2分别列出了对六种基本情绪贡献度排名前十的AU。

从表一中可以看出,AU25在六种基本情绪中的贡献排名都非常靠前,这显然是不太符合实际的。因为AU25嘴角张开这个动作是由降下唇肌放松、颏肌放松和口轮匝肌共同引发的,从主观感受来看,高兴、悲伤和生气这三种情绪很少会出现AU25,表中统计的数据靠前可能是由于众包注释的弊端引起的,因为可能是有的人的主观随意标记导致的。这样对表一和表二其余的AU同样筛查,最后,基于专业编码者的经验、数据分析结果以及其它文献中的总结,最终得出了AU和情绪关系汇总表,详细结果见表3。

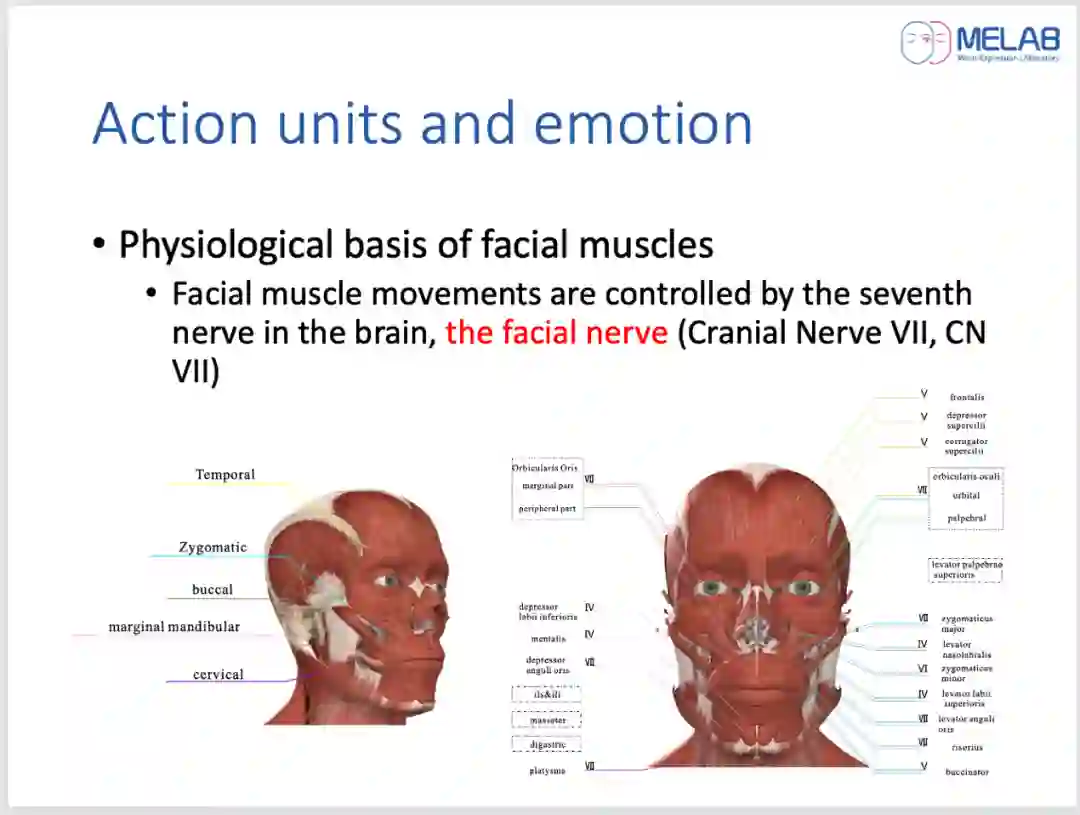

面部肌肉运动的神经生理学基础

接下来介绍了面部运动的大脑皮层网络系统。

面部运动系统是一个复杂的专门皮层区域网络,依赖于多个平行系统,自主、非自主运动系统、情感系统、视觉系统等,这些系统在解剖学和功能上都相差甚远,最终都到达面部核支配面部运动。由面神经核团发出的神经是面神经。面神经起源于脑干,其路径通常分为3个部分,颅内、颞内和颅外。人类的面神经运动核是脑干所有运动核中最大的。包含大约10,000个神经元,主要由运动神经元的细胞体组成。分为上下两部分,上部分受双侧大脑皮质运动区的支配,并发出运动纤维支配同侧颜面上半部的肌肉,核的下半部分仅受对侧大脑皮质的支配,并发出运动纤维支配同侧颜面下半部的肌肉。

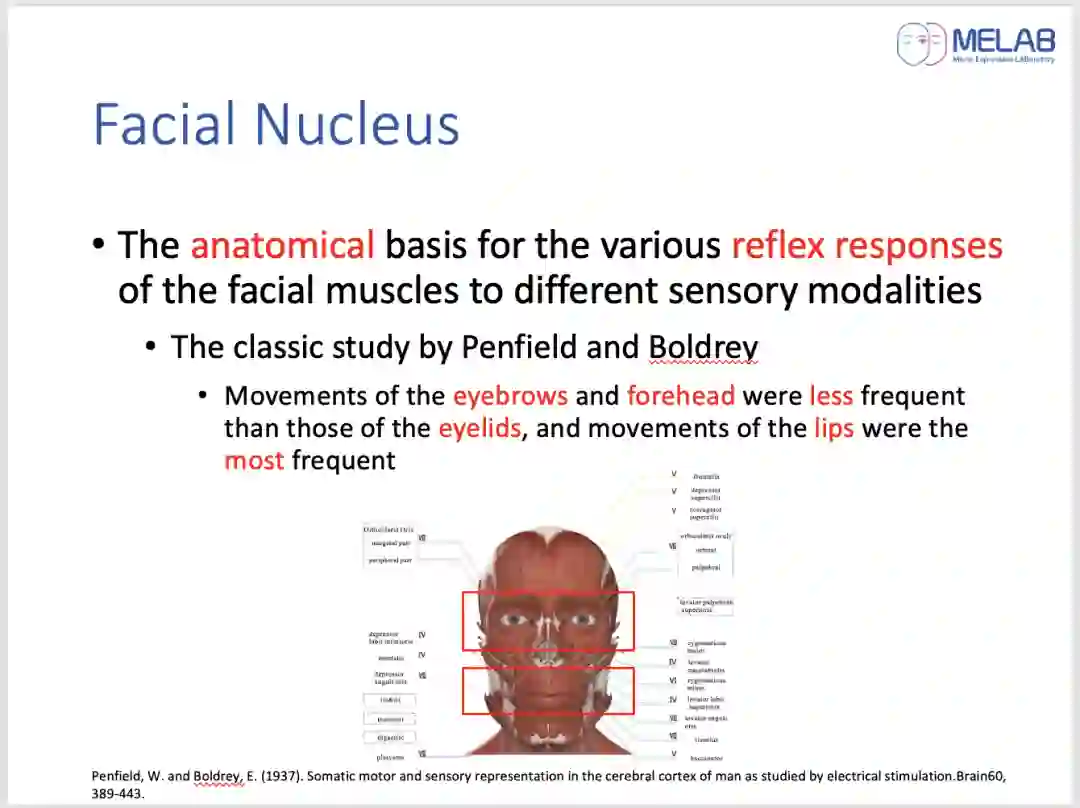

面部神经核的大量神经元为面部肌肉对不同感觉方式的各种反射反应提供了解剖学基础。例如,Penfield和Boldrey的经典研究中发现,由电刺激大脑皮层引起面部不同部位运动,以及在没有运动的情况下发生引起的面部运动的感觉和移动脸部的冲动/欲望时,眉毛和前额的运动比眼睑的运动更少,嘴唇的运动是最频繁的。

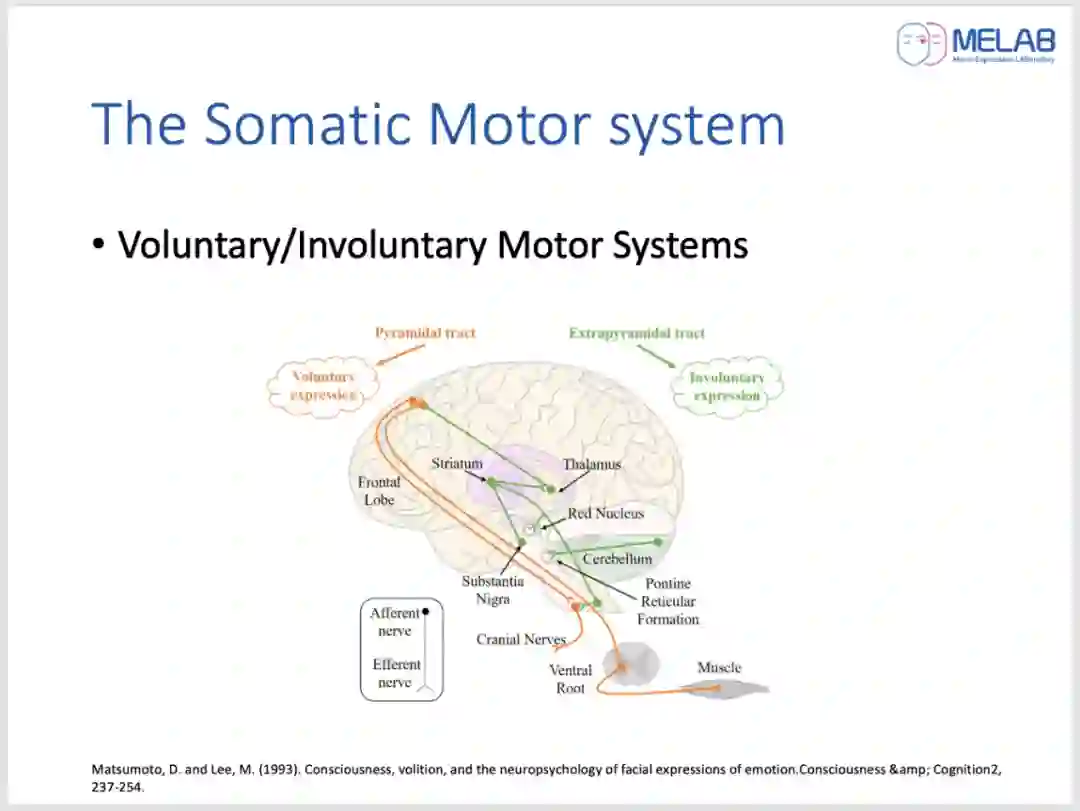

根据骨骼肌的运动形式,躯体运动分为自主运动和非自主运动。自主运动由大脑皮质中枢发出,是根据本人意识执行的动作,特点是先感觉后运动;非自主运动是不经意识控制的自发运动,比如寒颤。与此同时,自主表情和非自主表情之间的神经解剖学区别已经在临床神经学中被确立。自主表情被认为是从皮质运动带发出,并通过锥体束进入面部核;非自主表情源于沿锥体外束的神经支配。

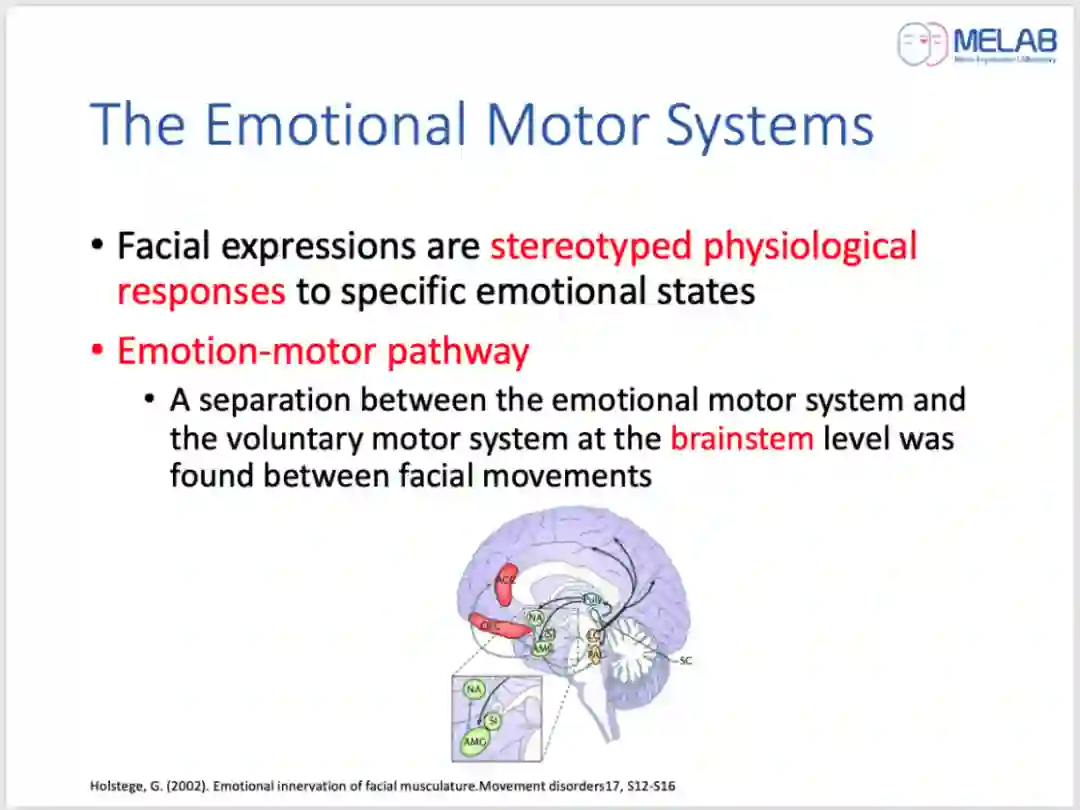

面部表情是对特殊情感状态的刻板生理反应,由情绪运动系统控制的自主和躯体系统所控制。表情只是情绪动作的躯体部分之一,其中还包括身体的姿势变化和语音等。然而,在人类中,面部表情是情绪重要的外部表现.

情感运动通路起源于杏仁核,外侧下丘脑和纹状体周围的灰质。这些灰质大多数反过来投射到网状结构中控制面部前运动神经元,少数投射到面部运动神经元直接控制面部肌肉。在研究创伤性面瘫时,在脑干水平发现情绪运动系统和自主运动系统在面部运动之间的分离。它表明这两个系统在面部核之前是完全独立的。这可能是为什么不可能通过意志产生真正的情感表达的原因。

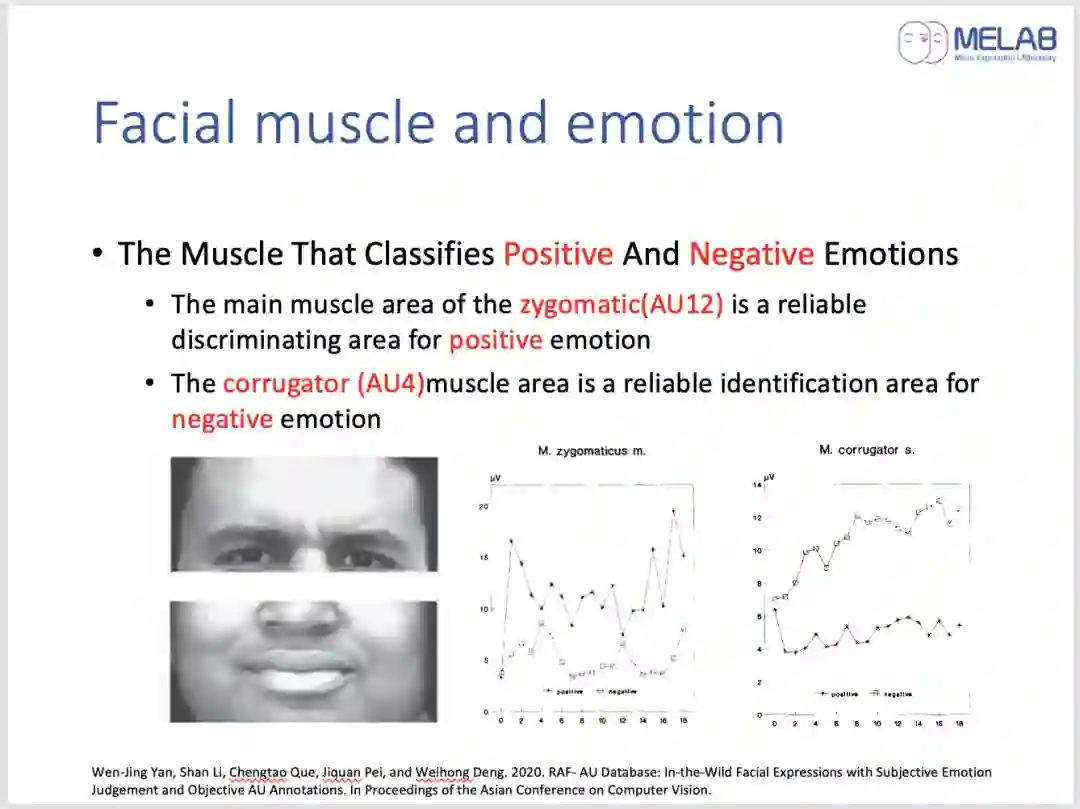

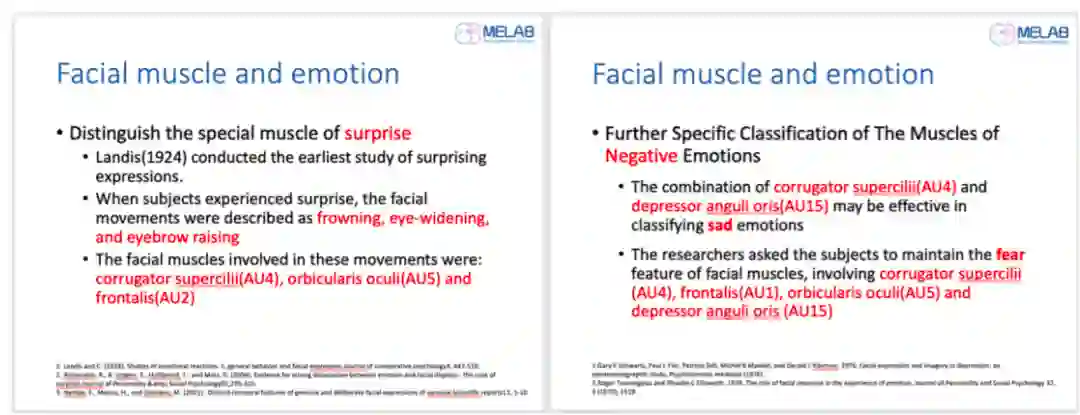

随后介绍了面部肌肉与情绪之间特殊性关系的解剖学基础。

情绪标定的过程

接下来详细介绍了情绪标注的过程。

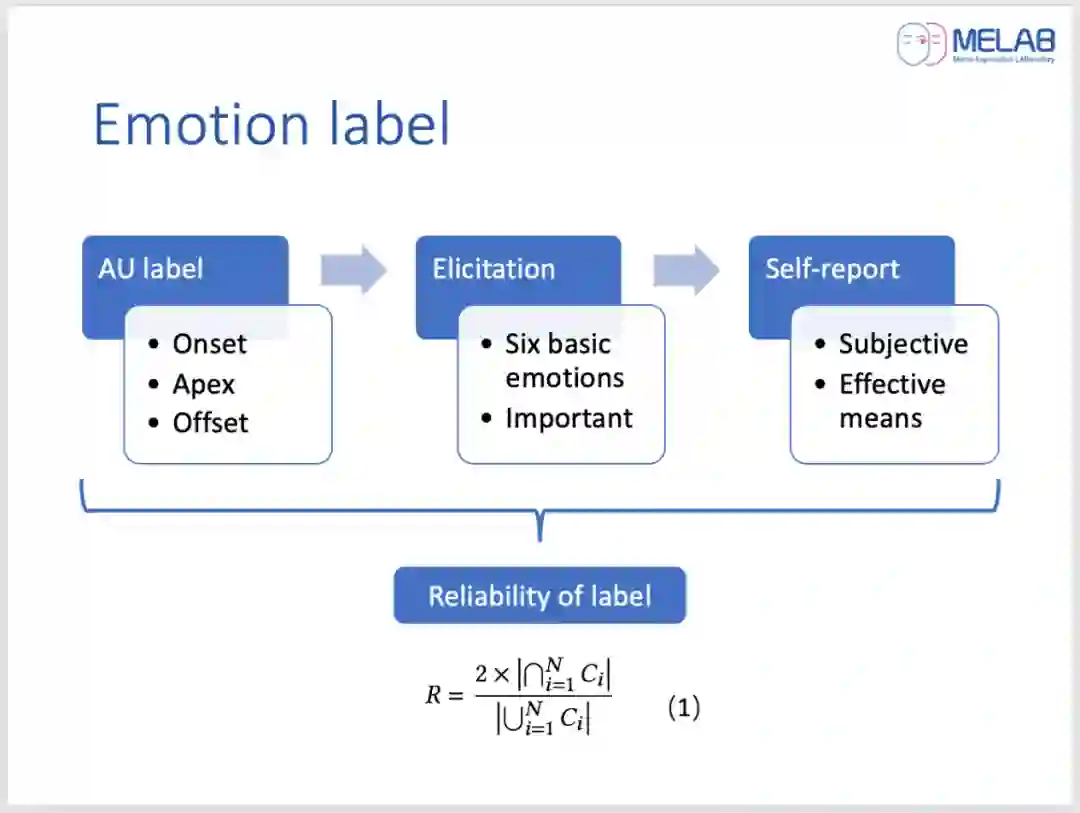

在标注中,表情或微表情通常会被分为四种或六种情绪。六种情绪分类包括六种基本情绪,分别是高兴、厌恶、悲伤、恐惧、愤怒和惊讶。一般情况下,对一个面部动作进行情绪标注需要考虑三个条件,AU标签、启发式材料和被试对该视频的自我报告。同时,还应该消除一些习惯行为,如眨眼或吸气时皱眉。

(1)在进行AU标注时,标注者需要熟练掌握面部编码系统,逐帧的对表情视频进行观看,寻找并记录表情发生的开始帧、高峰帧和结束帧,得到表情发生区间,并在此区间标注出AU。开始帧表示面部从面无表情(中性表情)开始变化的一帧。高峰帧表示该面部表情中强度最大的一帧,也是面部肌肉运动最明显的一帧。结束帧表示表情结束恢复至面无表情(中性表情)的一帧。

(2)在心理学上,研究者通常使用不同的情绪刺激材料诱发不同性质与强度的情绪,刺激材料是诱发实验性情绪的重要工具。通常使用现有的情绪材料数据库中的刺激材料,通过操纵刺激材料的情绪类型来控制被试的诱发情绪类型。

(3)主观报告是检验情绪是否被成功诱发的有效手段。

最后,为了保证数据标注的有效性或可靠性,标注情绪的过程通常需要两到三个标注者的参与,并计算标注者间的信度。标注者间的信度是衡量一个内容分析(标注情绪)研究效度的必要条件,没有信度,该研究的结论便值得怀疑,甚至显得毫无意义。

总结

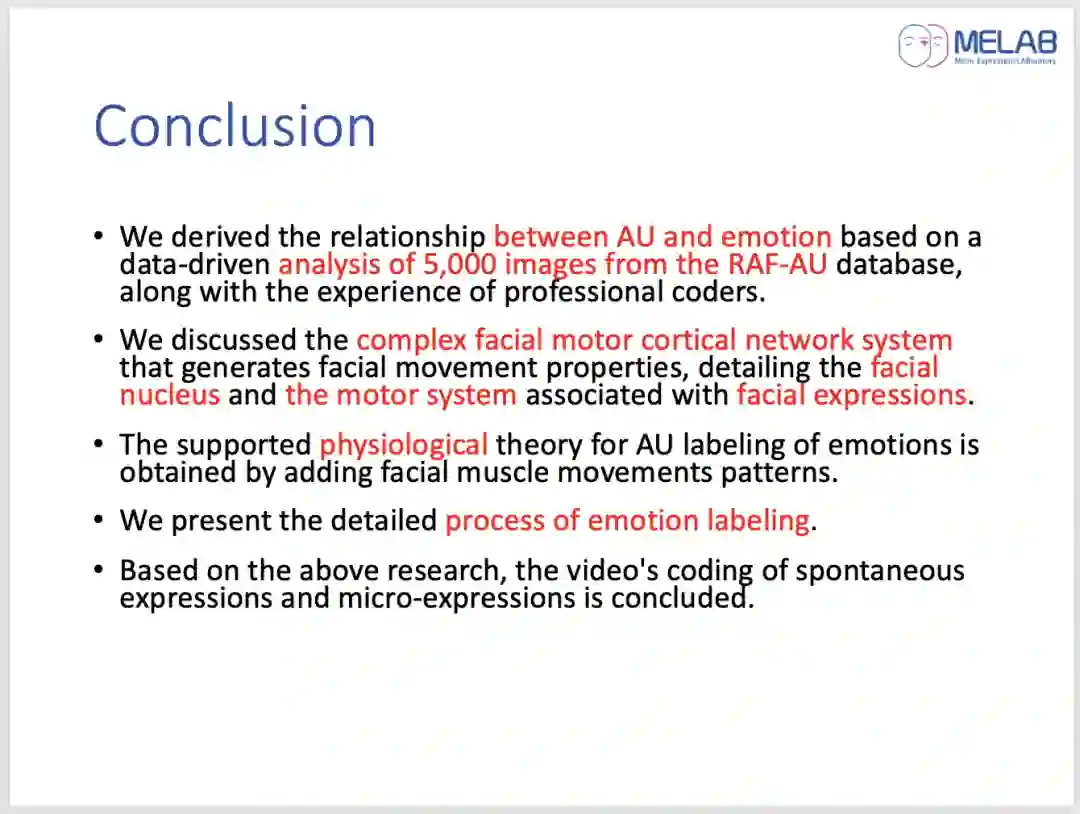

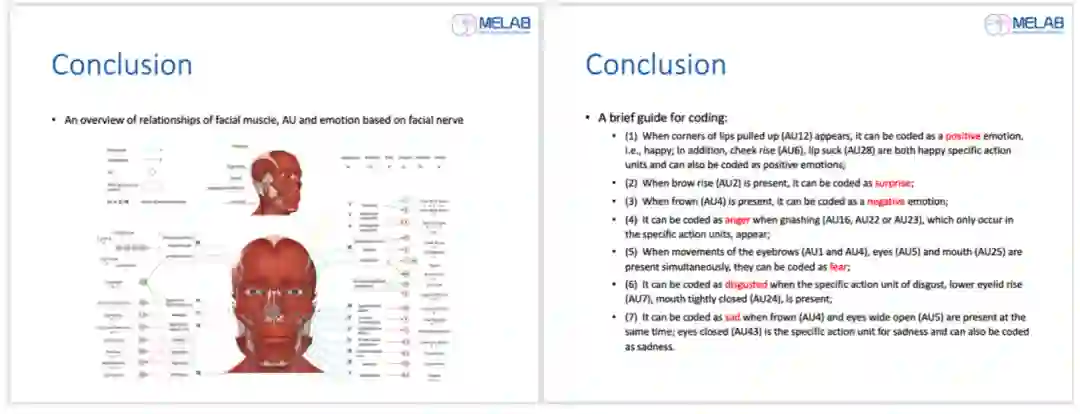

通过对raf-AU数据库中的5000张图像进行数据驱动分析,并结合专业编码器的经验,得出了AU和情绪之间的关系。

讨论了产生面部运动特性的复杂面部运动皮层网络系统,详细介绍了与面部表情相关的面部核和运动系统。

通过增加面部肌肉运动模式,得到AU情绪标记支持的生理学理论。

然后详细介绍了情绪标记的过程和关于AU的检测与识别。

在以上研究的基础上,对自发表情和微表情的视频编码进行总结。

得到了一张基于面神经的面部肌肉、AU与情绪的关系图,以及关于编码的简明指南。

在活动的最后,讲座的主持人李婧婷博士对活动进行了总结并对第二十二期CSIG云上微表情活动进行了预告,将由来自甘肃政法大学的范刚教授带来犯罪心理学方面的主题报告,敬请继续关注!

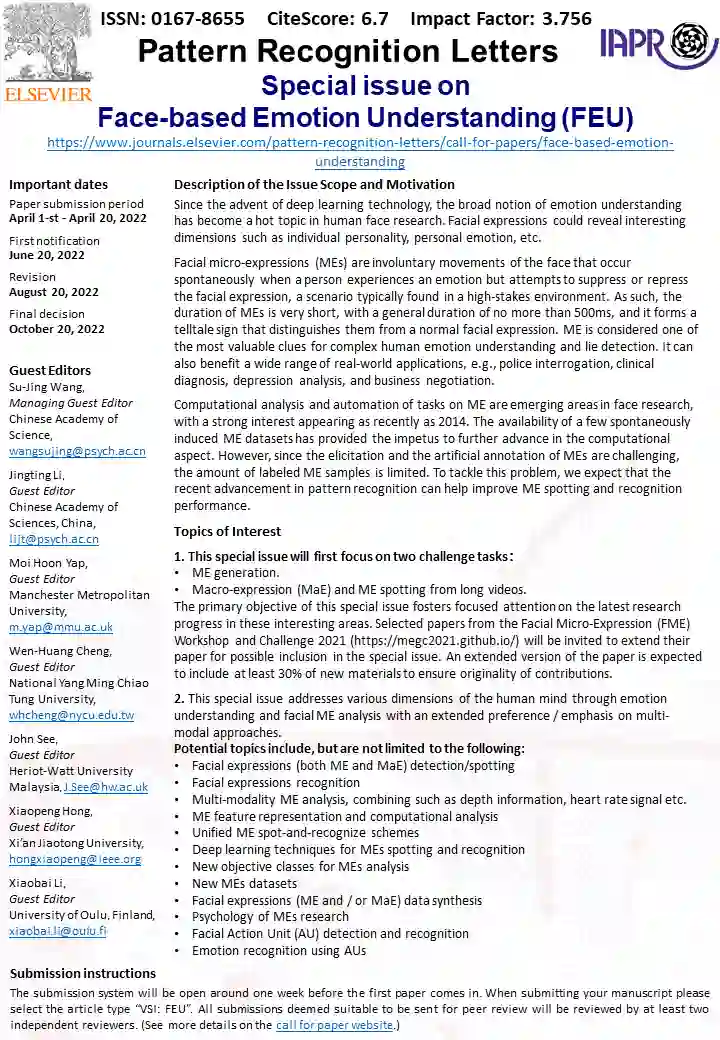

此外,王甦菁博士等人在Pattern Recognition Letters申请了主题为“Face-based Emotion Understanding”的专刊,欢迎大家关注。

此次讲座的回放已经发布在B站:https://www.bilibili.com/video/BV1QQ4y1i7yJ,欢迎观看。

另外,中国科学院心理研究所微表情实验室(MELAB)诚聘博士后,微表情相关方向,计算机或心理学专业皆可,有意请联系王甦菁老师(wangsujing@psych.ac.cn)。