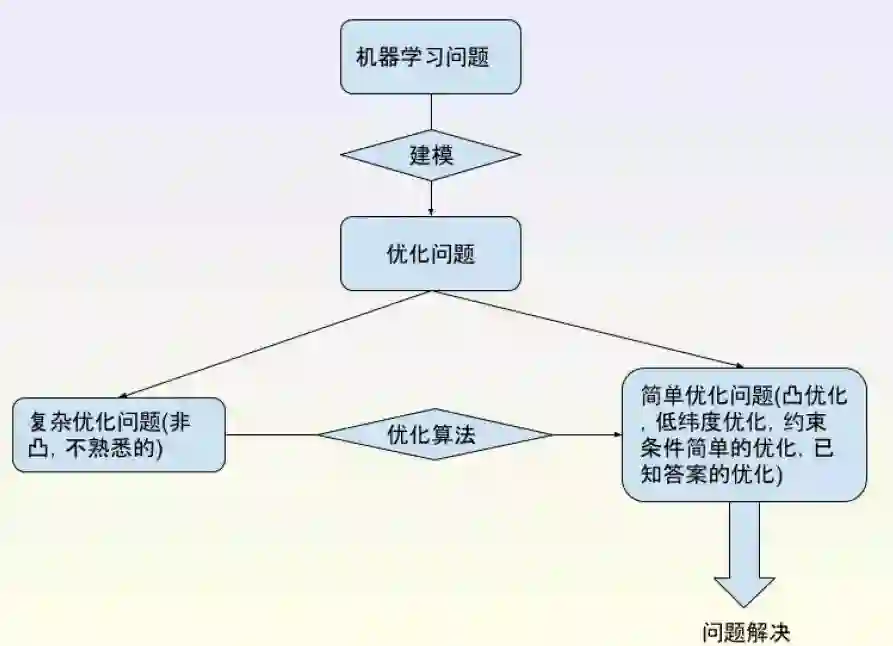

“优化都不懂,你还想做机器学习?”

机器学习的基础是什么?是“数学”,而“优化”就是数学中的核心知识之一。

而且在机器学习遇到的复杂优化问题(非凸,不熟悉的),最高效的方法就是利用凸优化的思路去解决。

小七这次把《机器学习中的数学 第二期》,中关于优化的部分PPT送给大家。

其中优化问题简介、凸集合与凸函数、优化和凸优化是属于非常基础的部分,后续两大板块有一定难度。

目录:

一、优化问题简介

二、凸集合与凸函数

知识点:

凸集合与凸函数的关系

琴生不等式的几何解释

三、优化与凸优化

知识点:

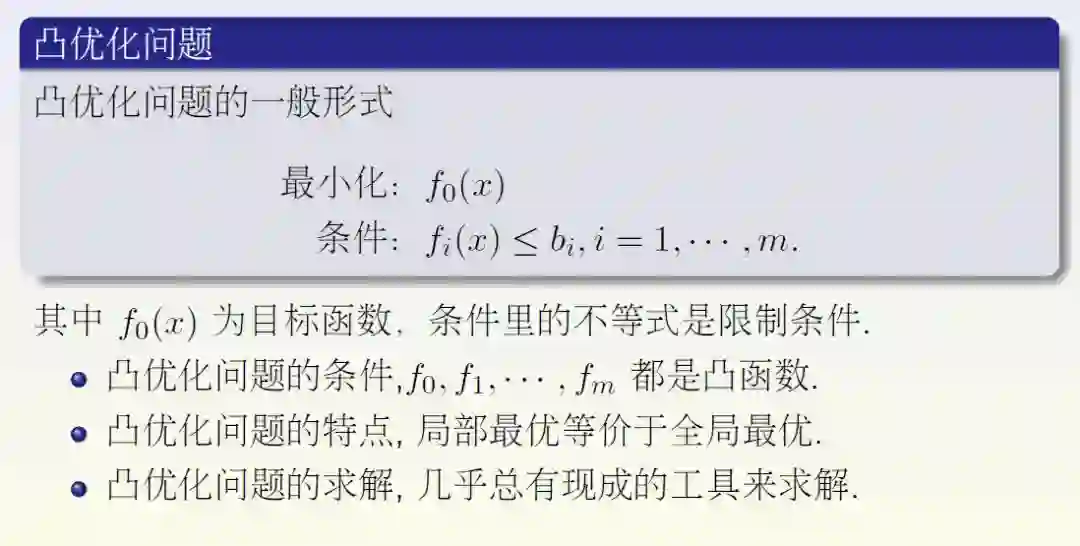

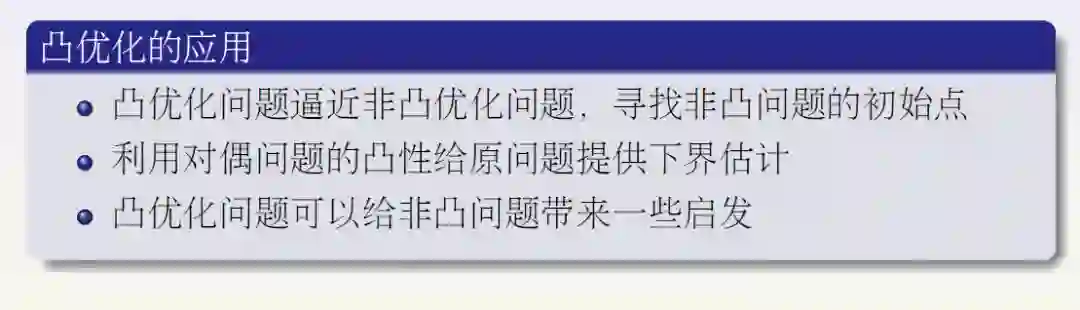

凸优化问题

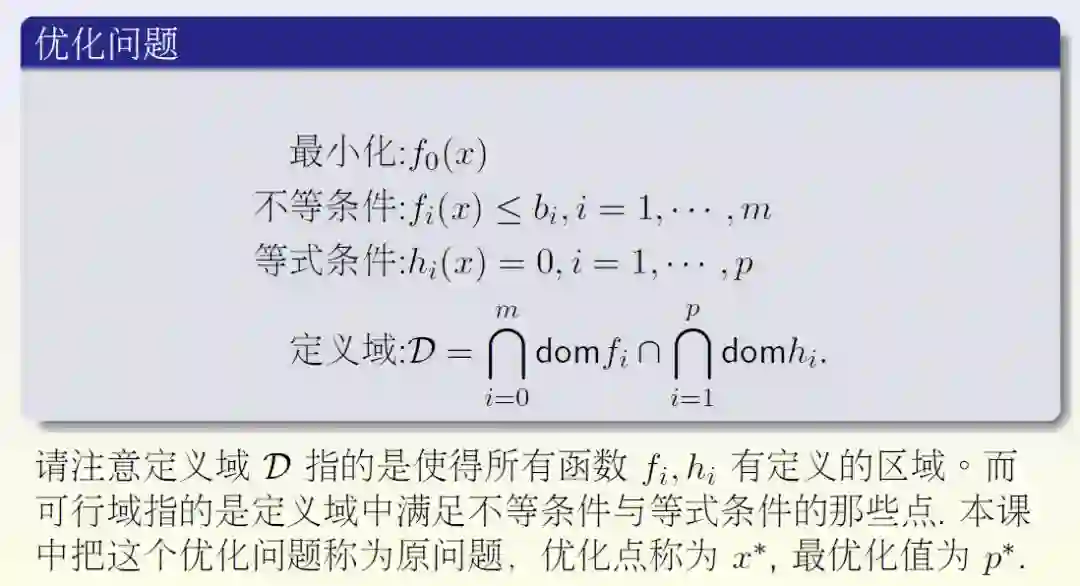

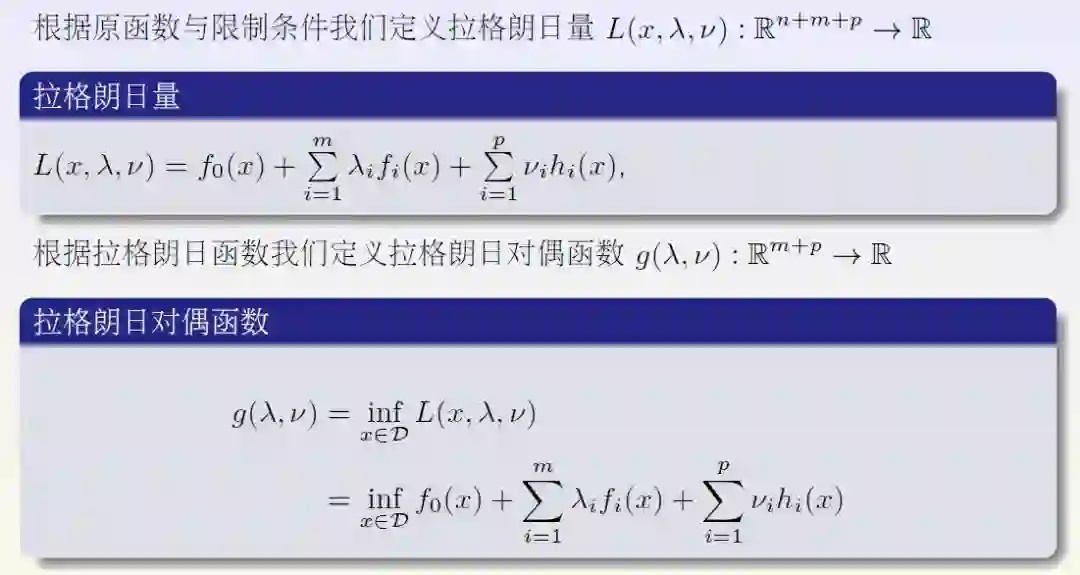

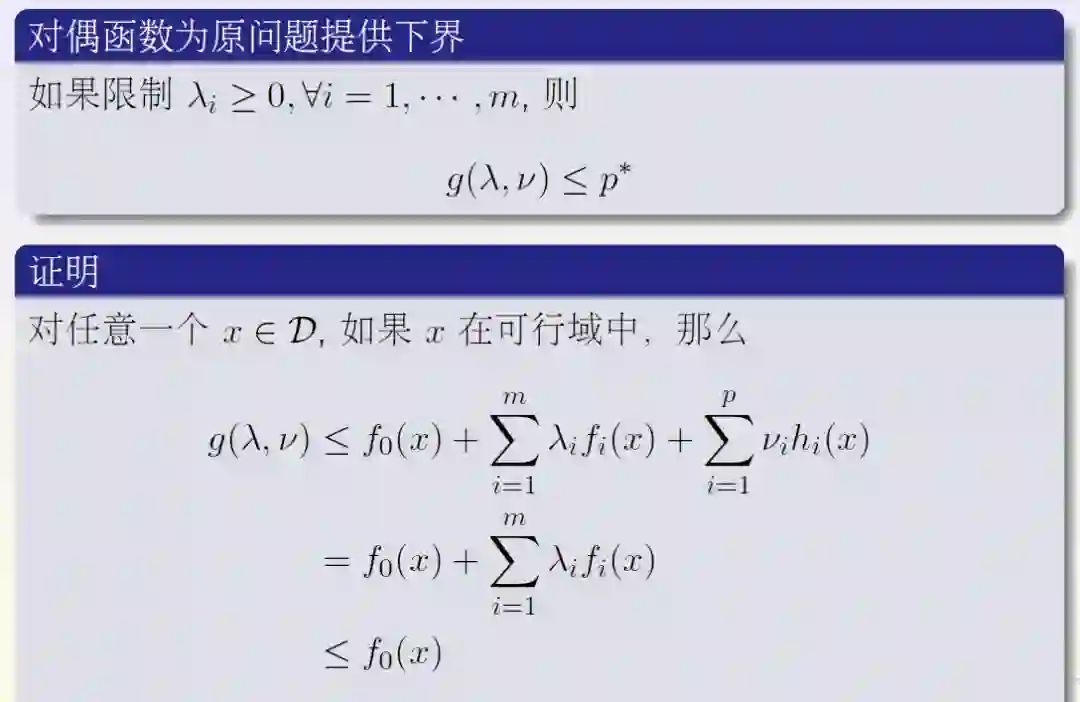

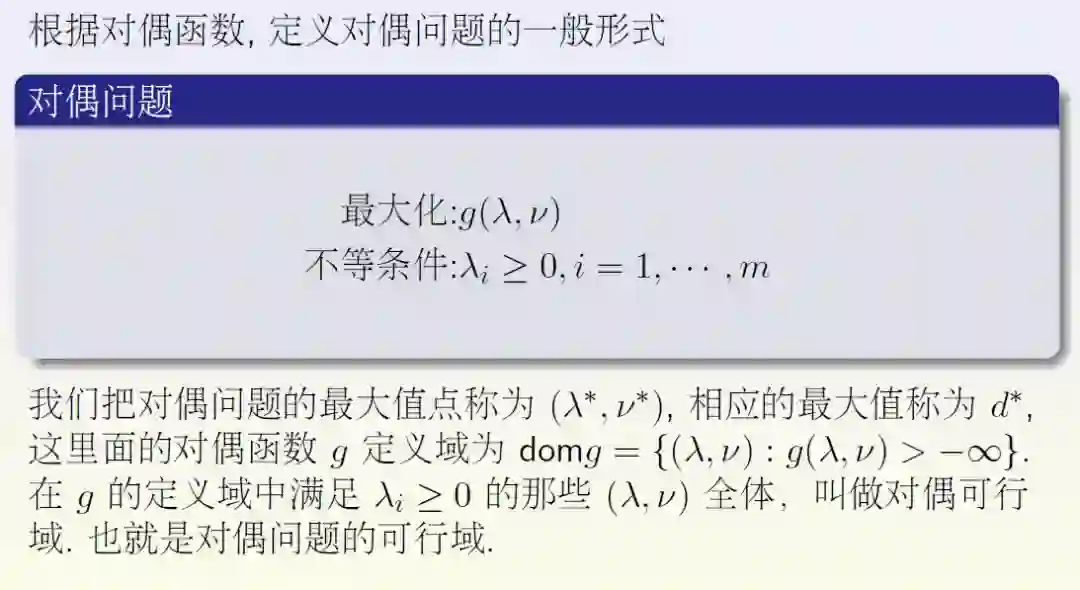

对偶问题

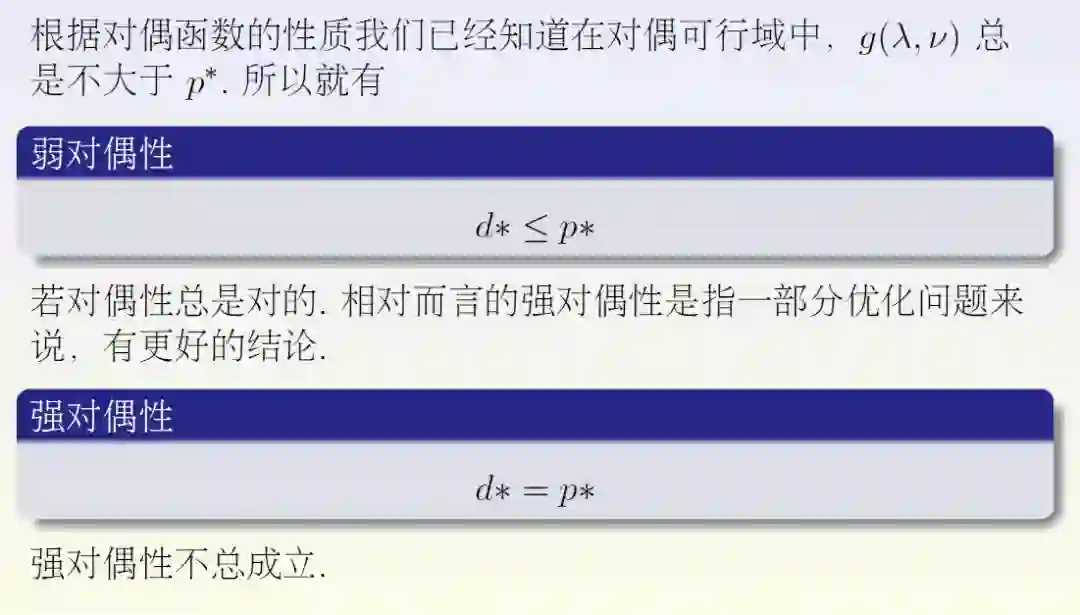

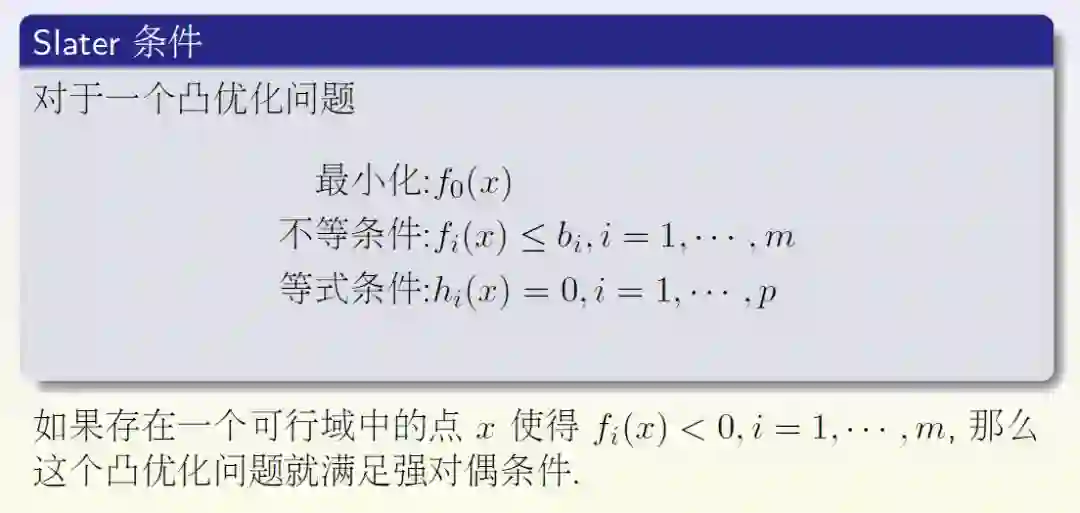

对偶性

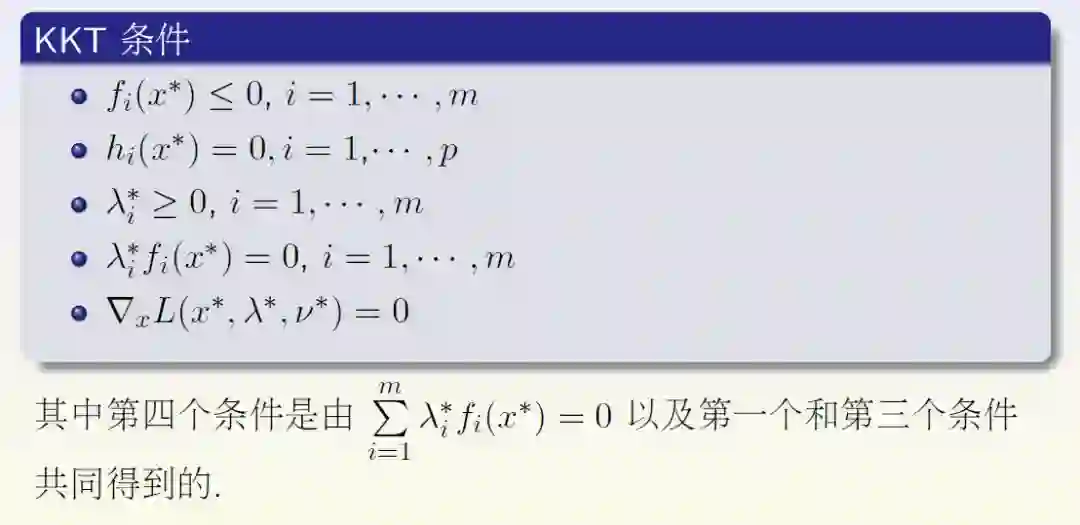

KKT条件

拉格朗日乘数法

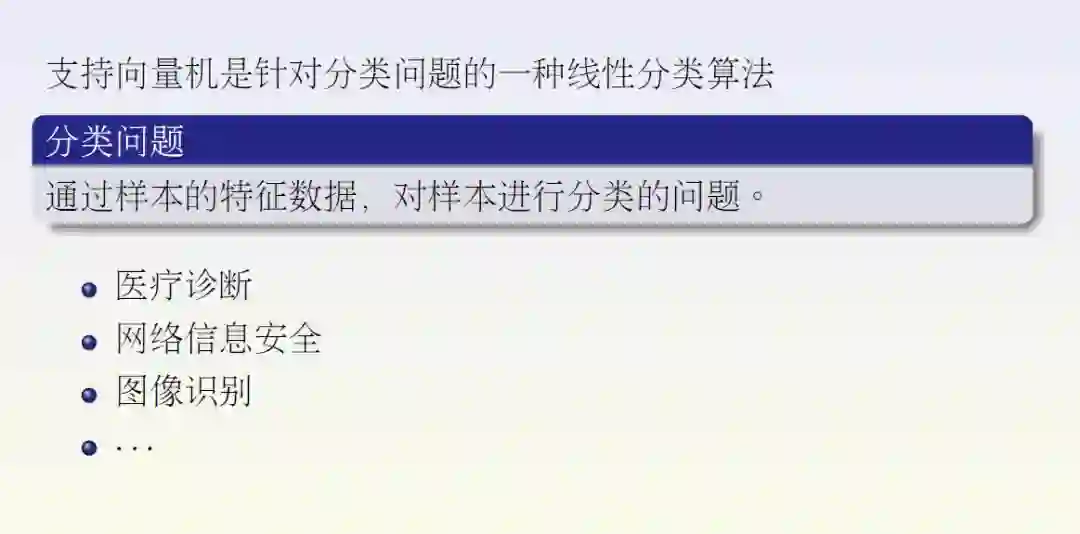

四、支持向量机(SVM)简介

知识点:

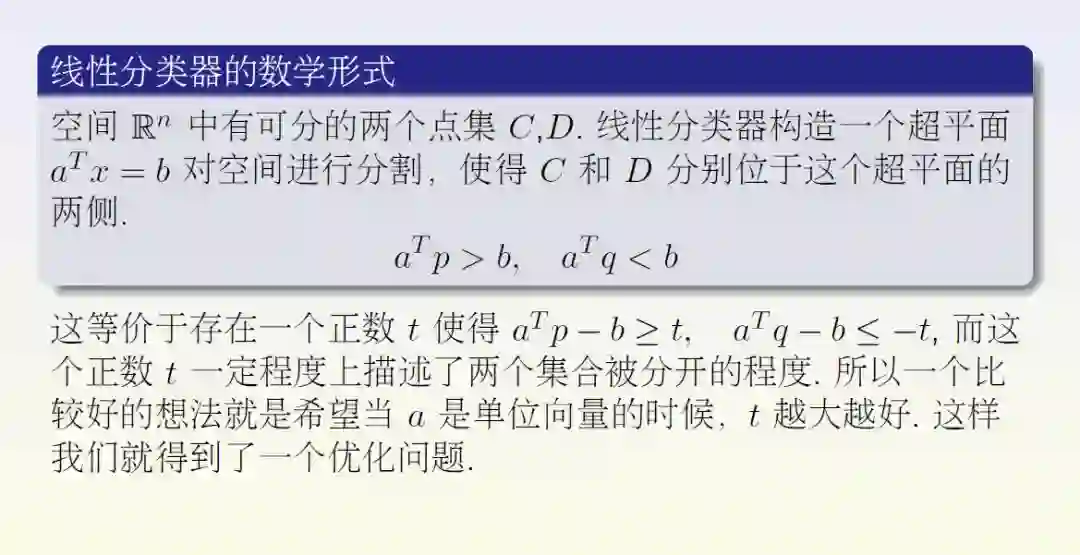

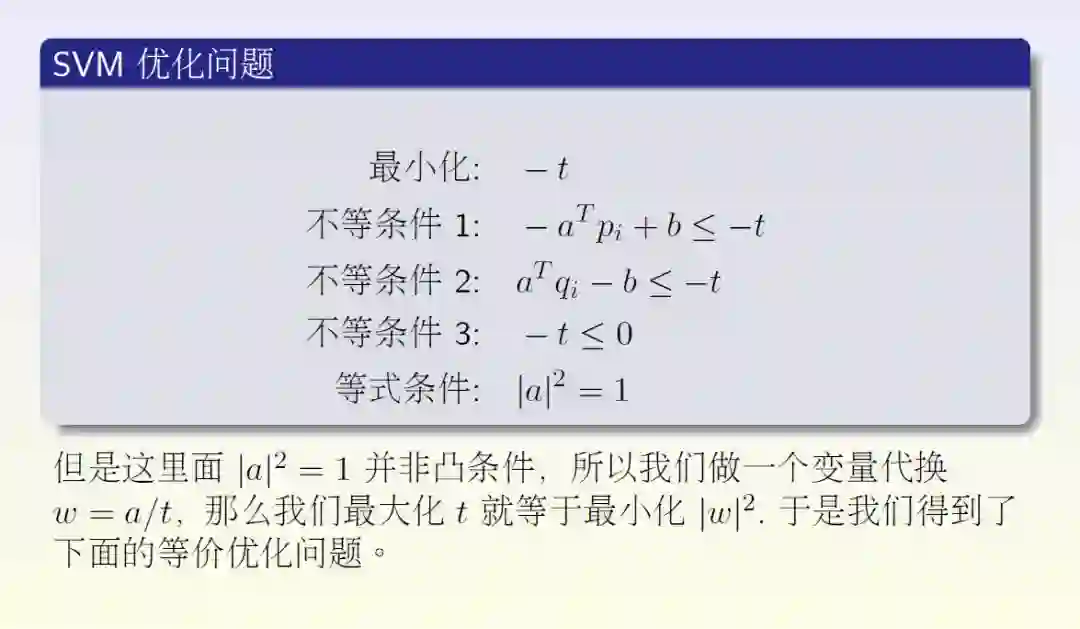

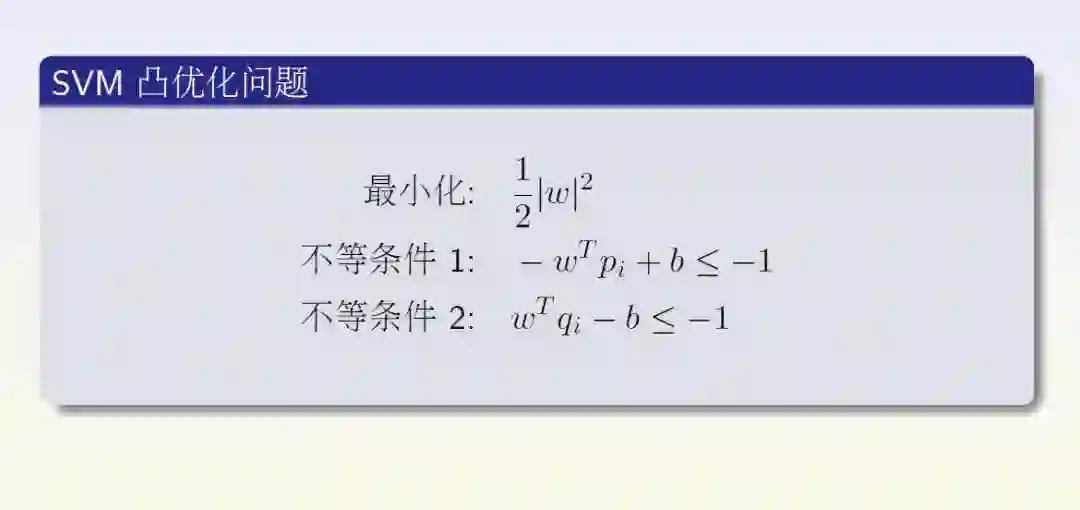

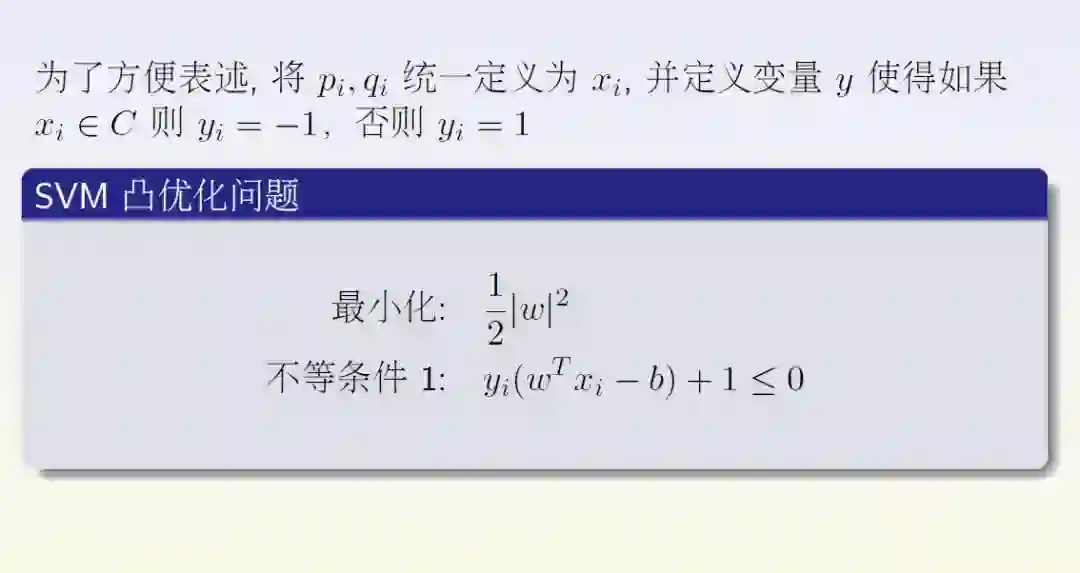

线性分类器

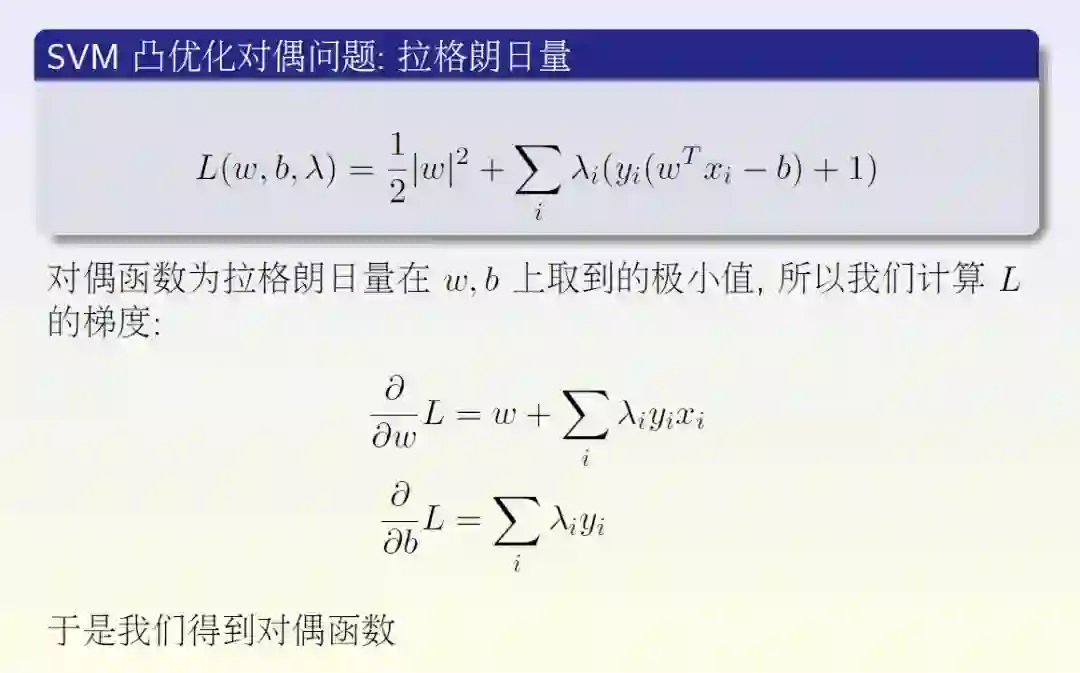

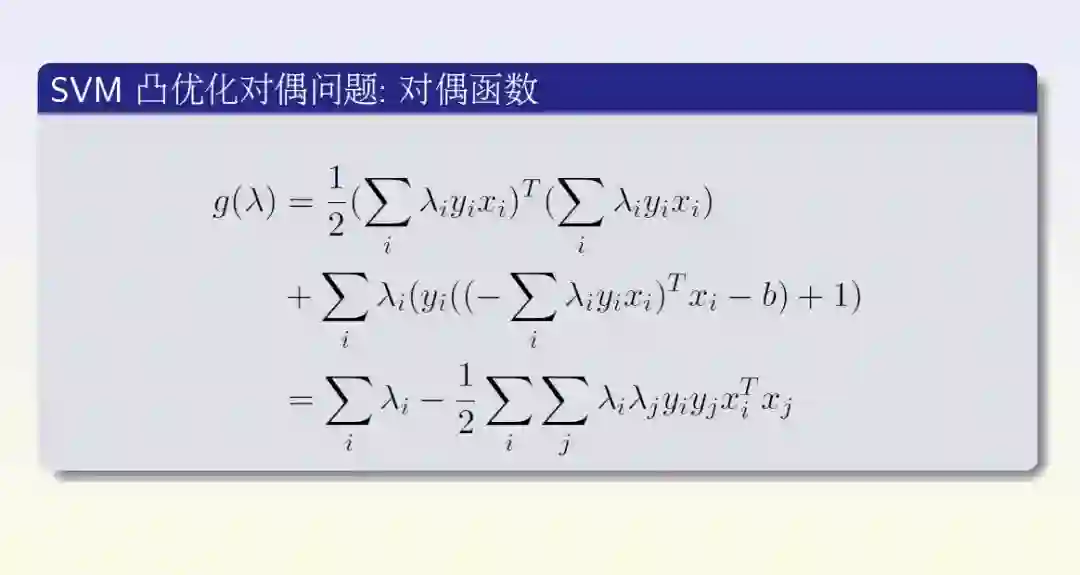

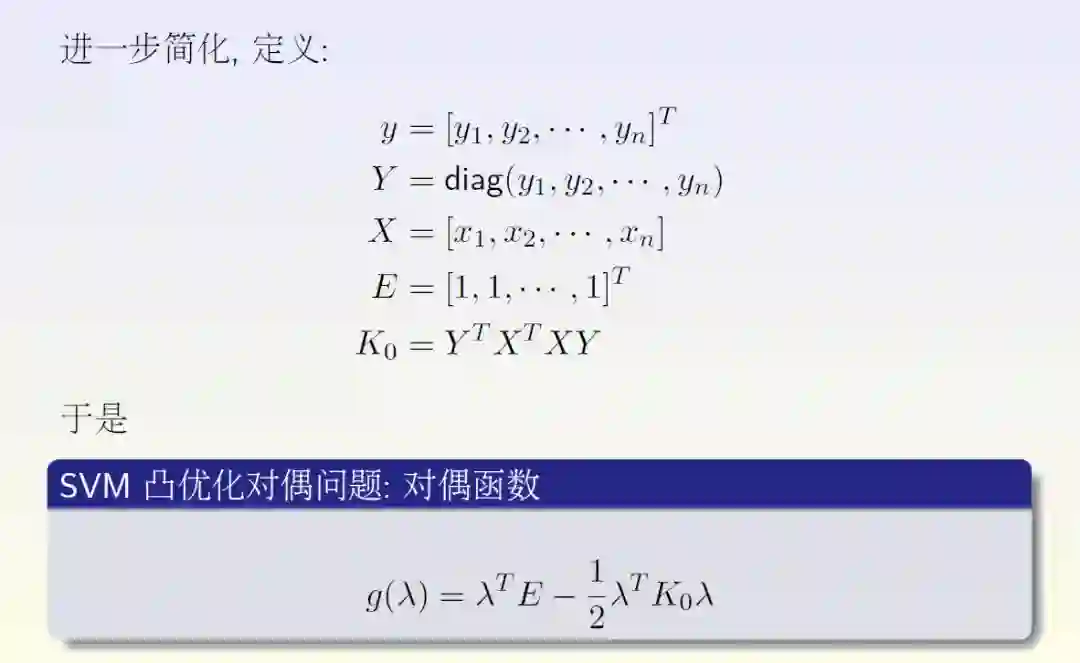

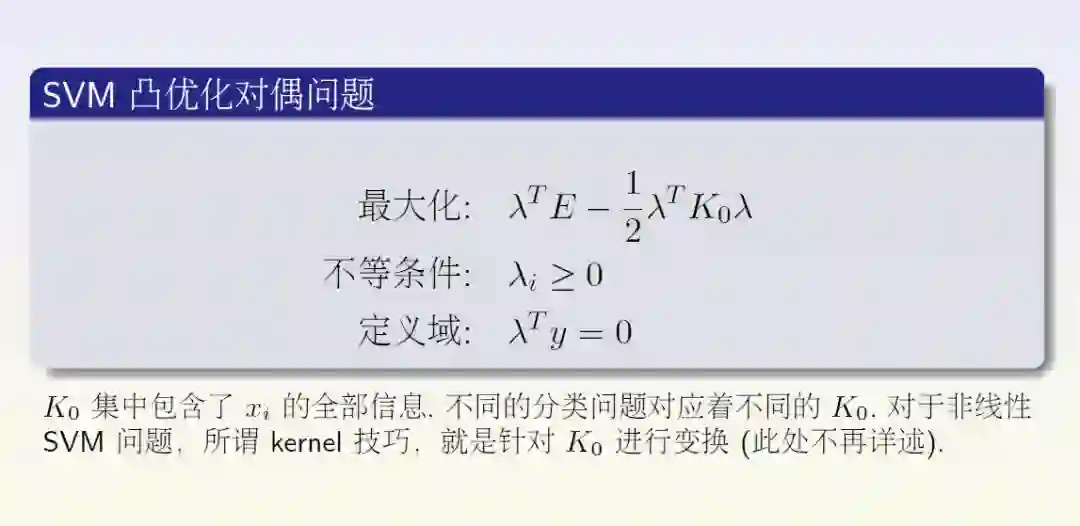

对偶方法推导SVM

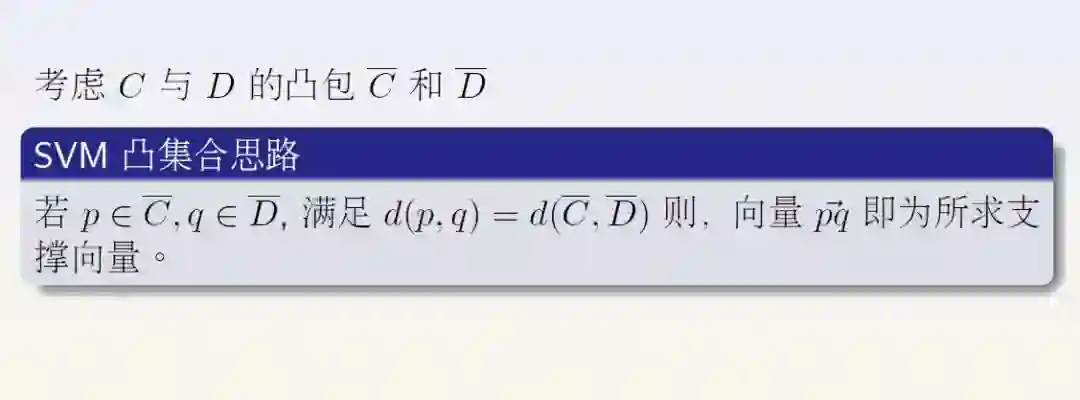

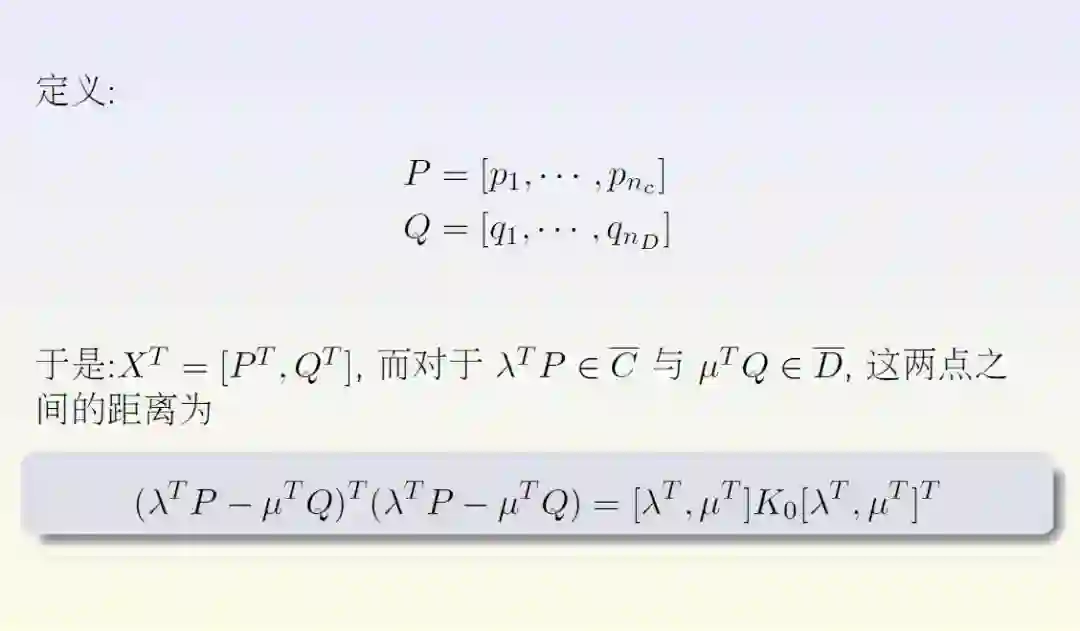

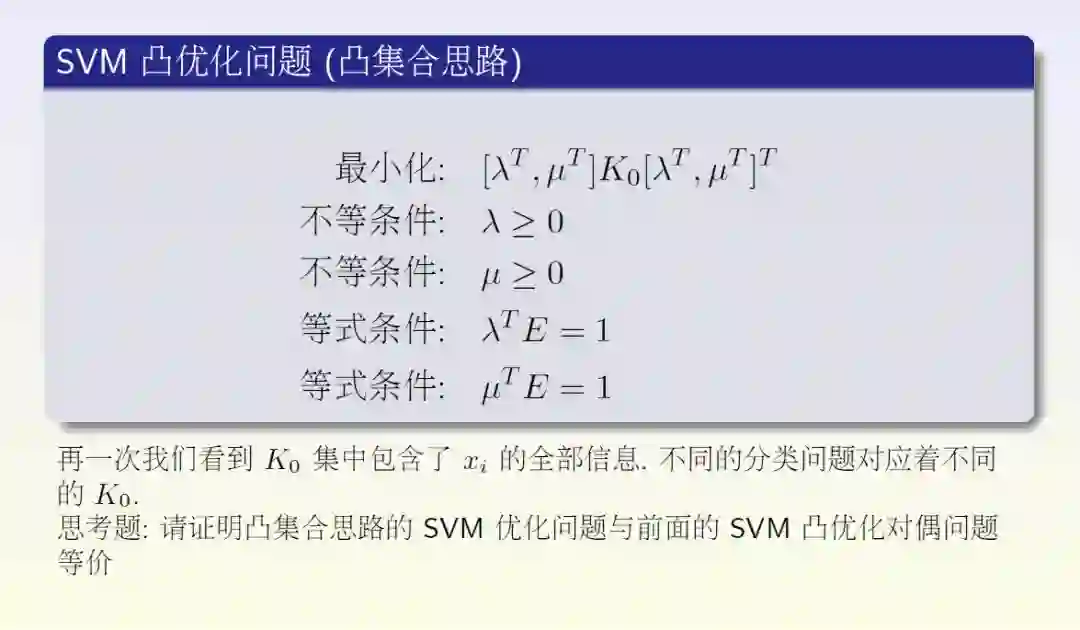

几何方法推导SVM

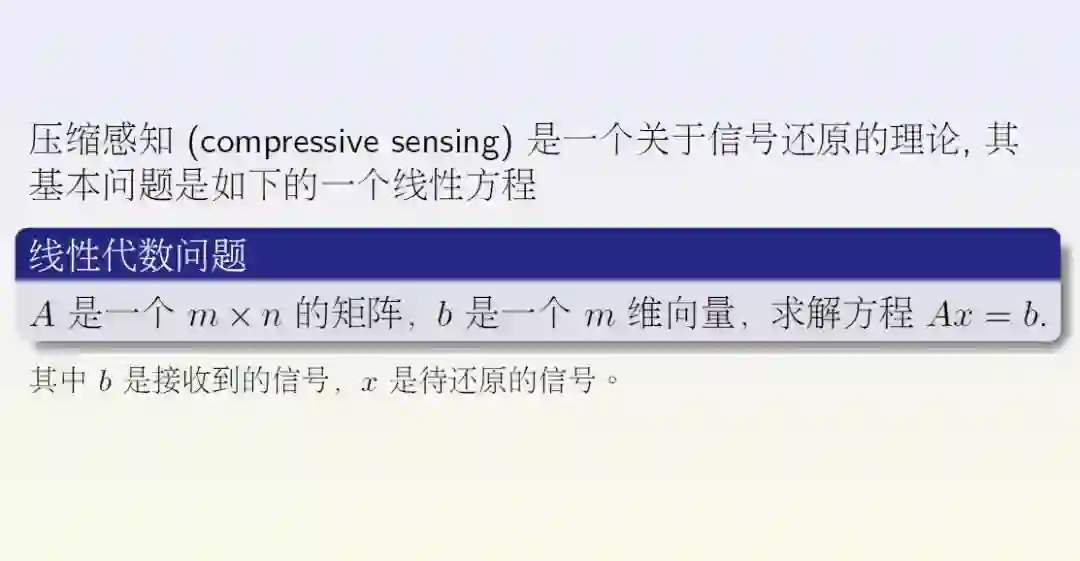

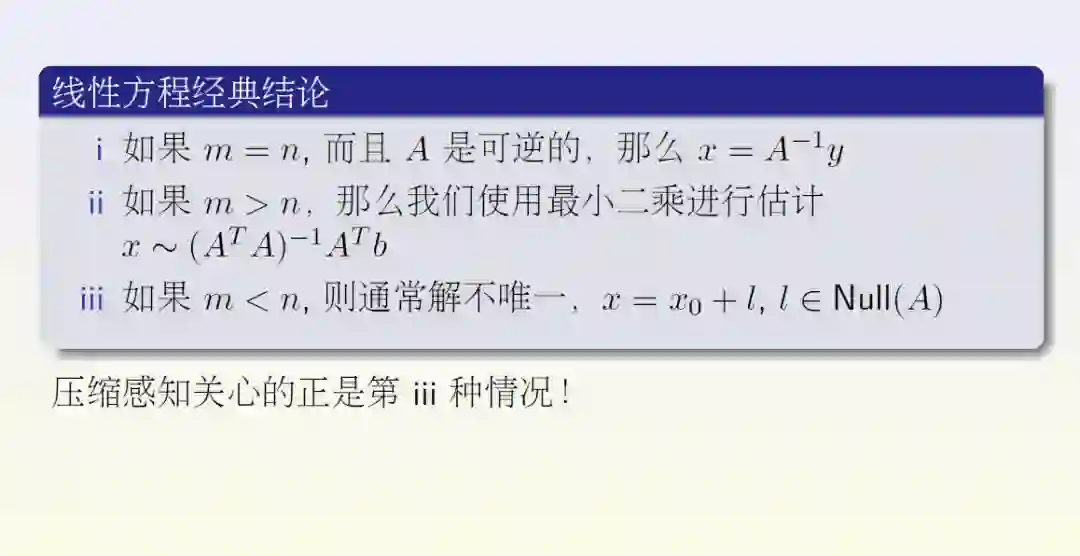

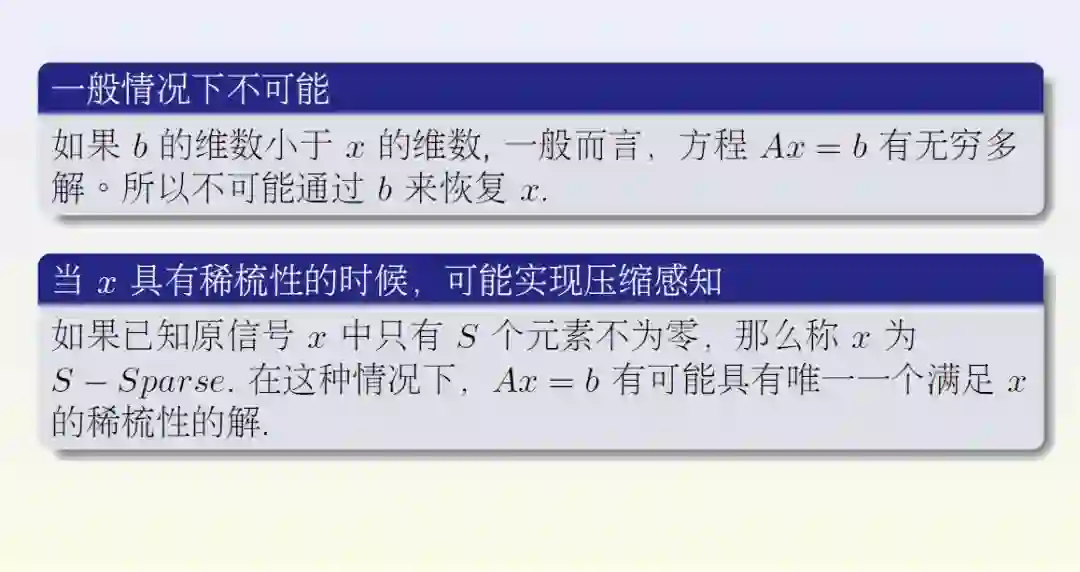

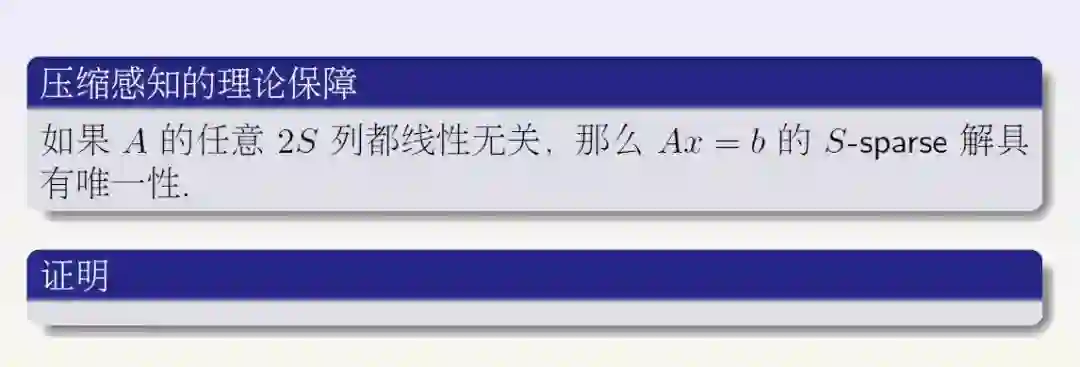

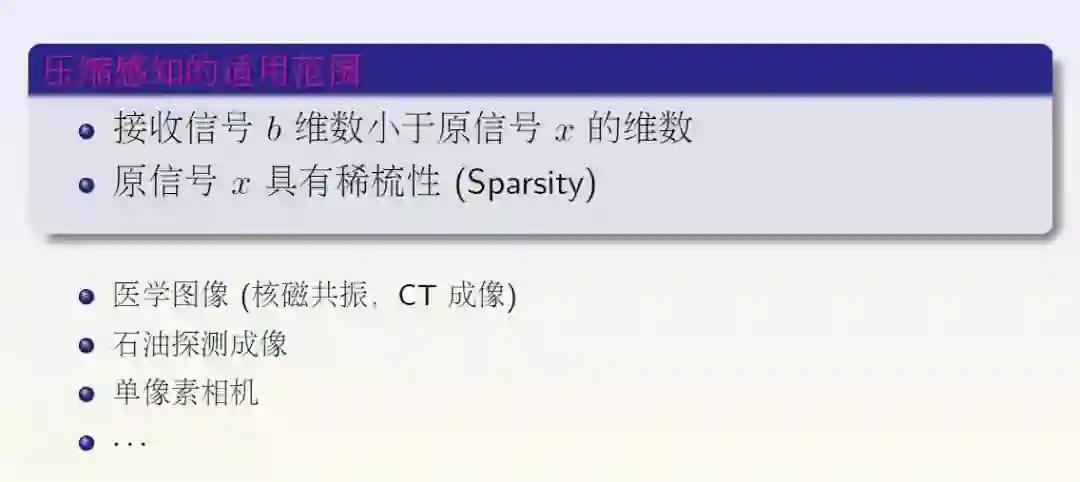

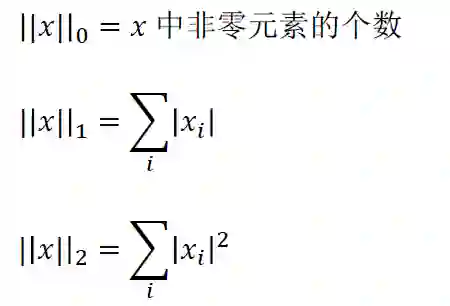

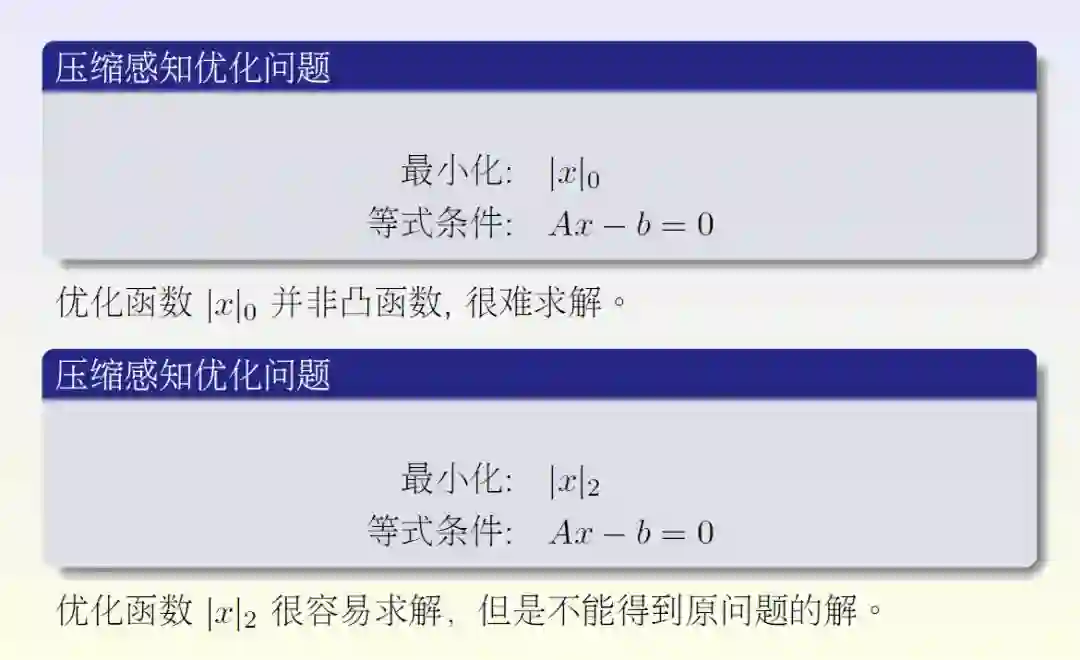

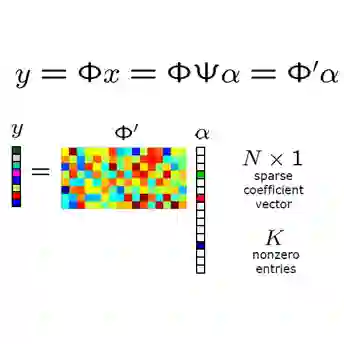

五、压缩感知简介

知识点:

信号还原问题

压缩感知

求解压缩感知的优化方法

Lasso方法与优化的稳定性

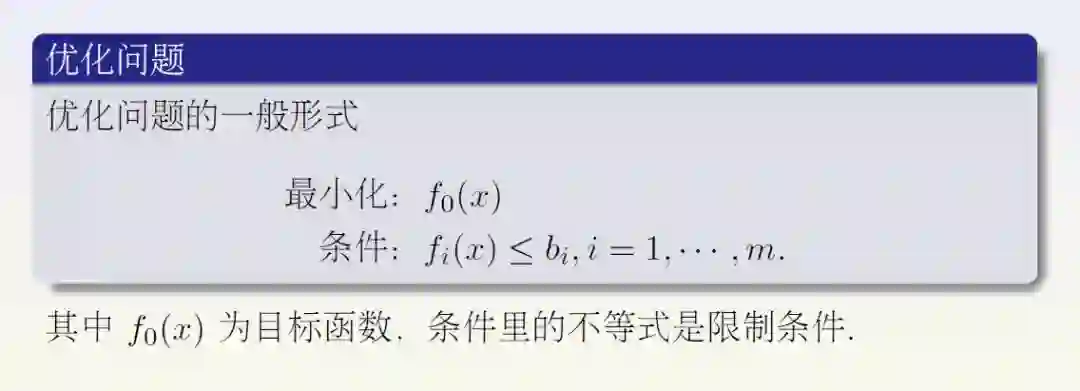

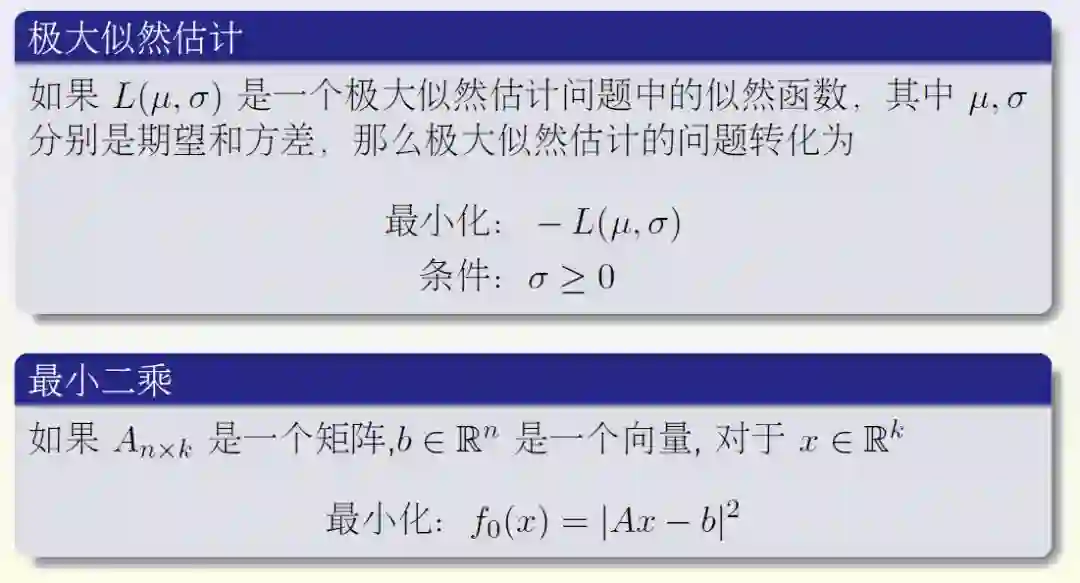

优化问题简介

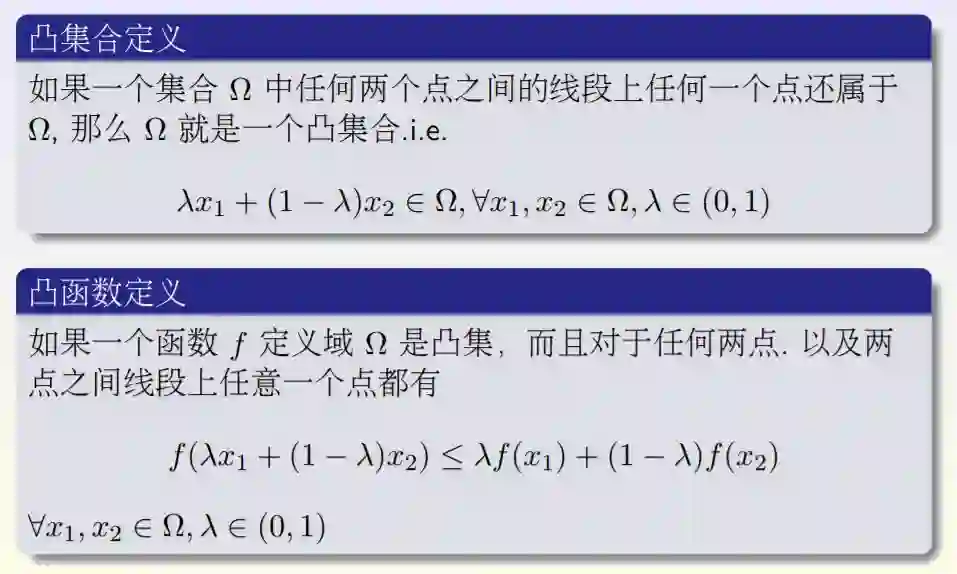

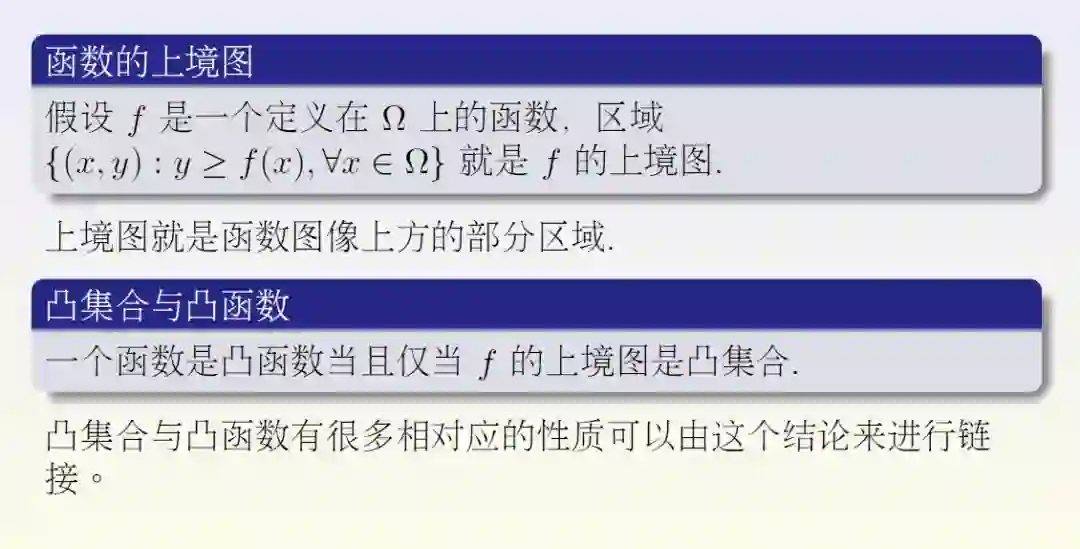

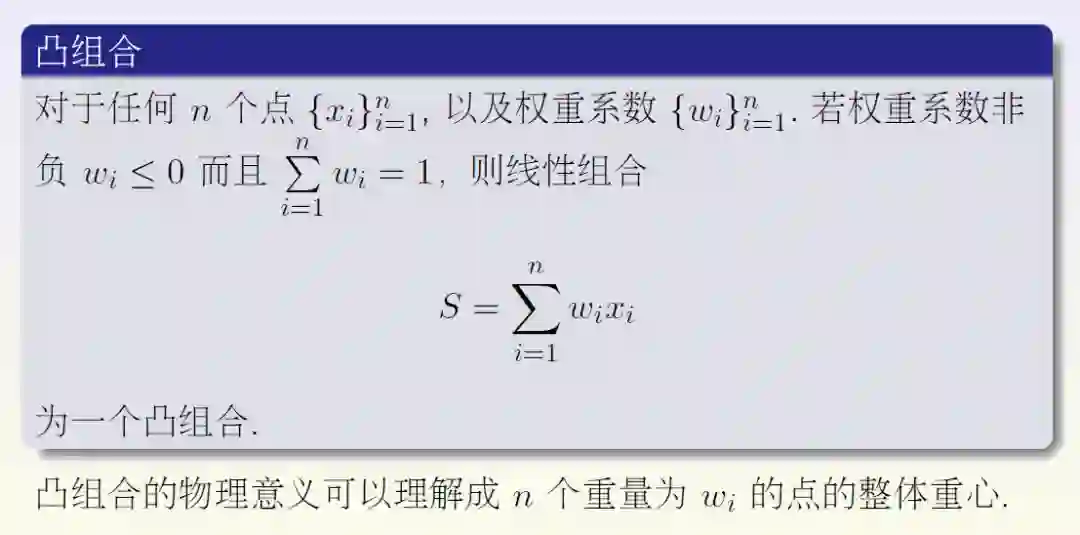

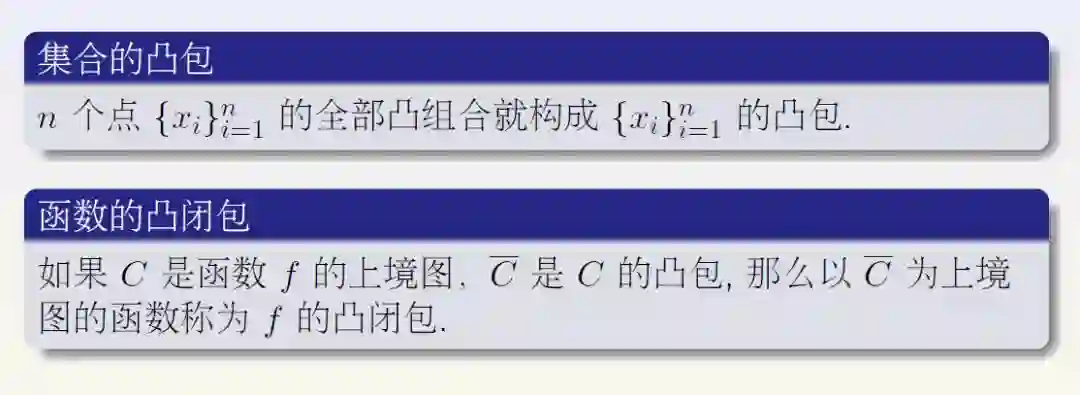

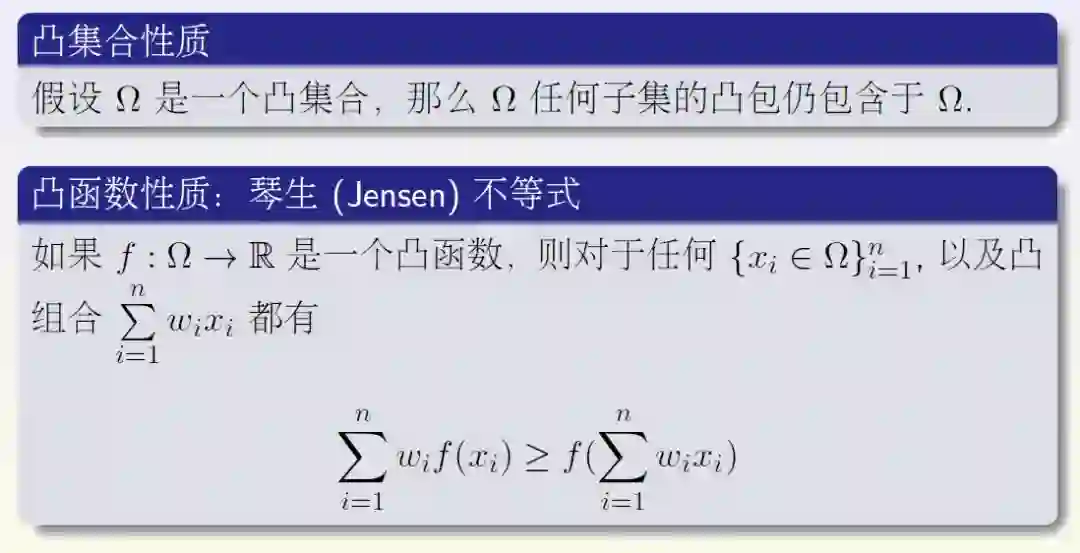

凸集合与凸函数

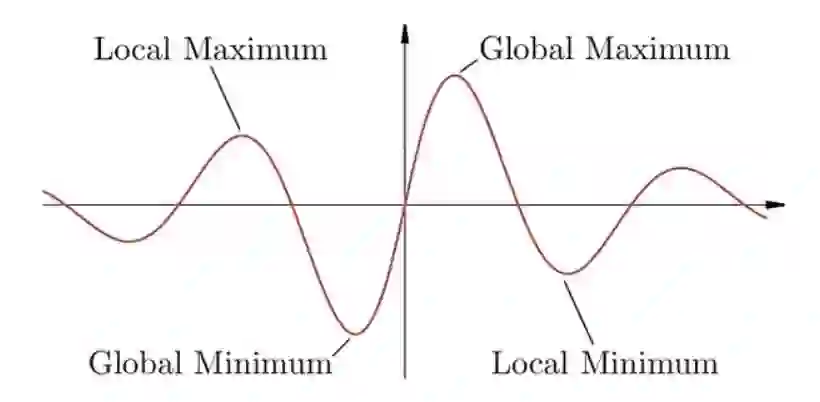

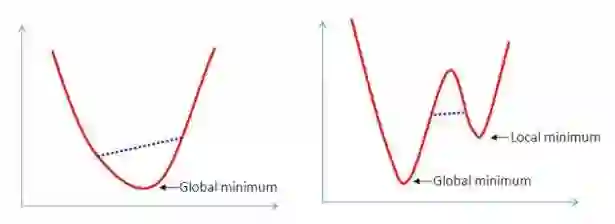

局部极值与全局极值:

凸函数的重要性质:局部极值一定是全局极值

(下图左侧为凸函数,右侧为非凸函数)

凸优化

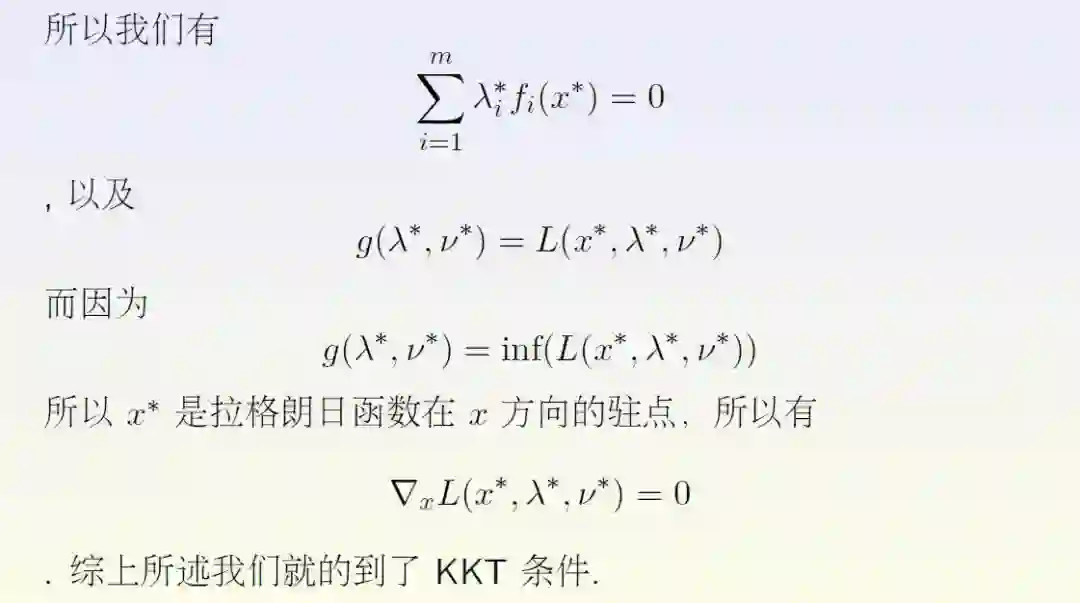

当原问题只有等式约束而没有不等式约束时,KKT条件即为拉格朗日乘数法。

阶段总结

优化问题在机器学习的模型训练中有重要应用。

凸函数代数性质与凸集合的几何性质;琴生不等式的几何解释。

凸优化是一类相对简单的优化问题;凸函数的局部最小值就是全局最小值。

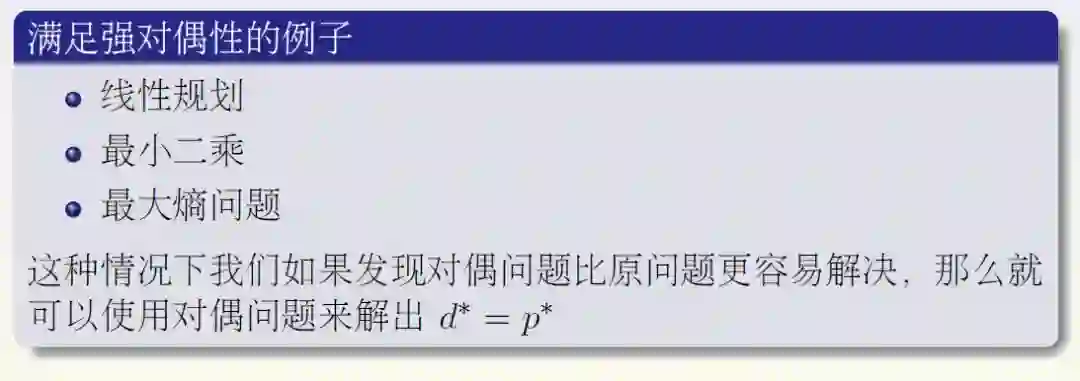

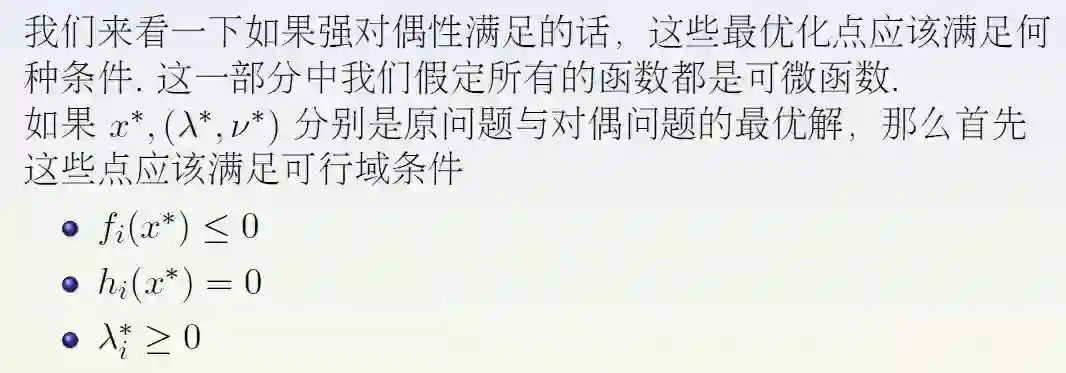

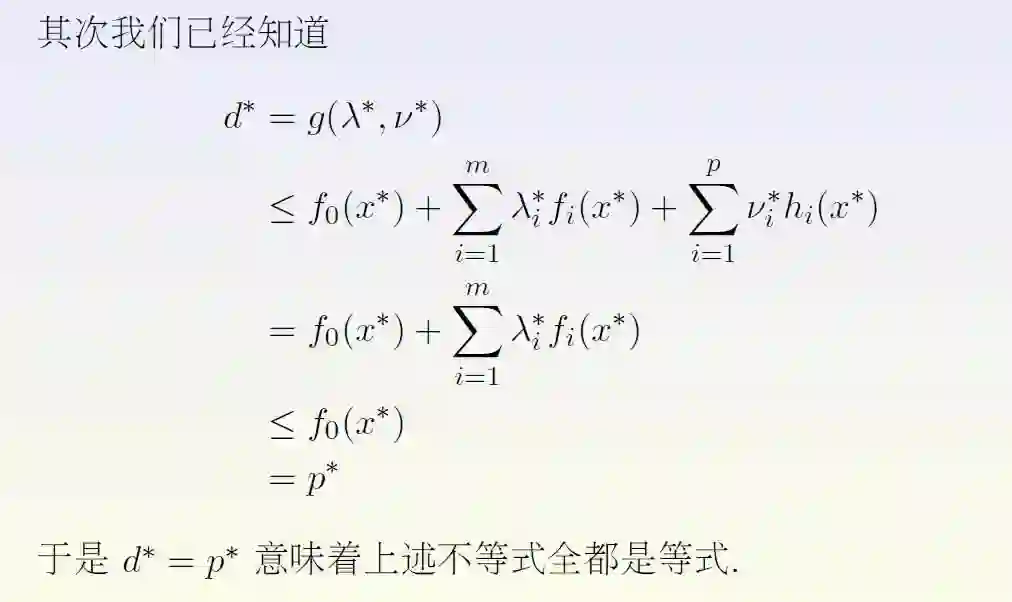

对偶方法的主要目的是处理原问题中的复杂边界条件;对偶问题永远是凸问题; 弱对偶性永远成立,可以为原问题提供下界。

KKT条件可以用来求解一些优化问题;拉格朗日乘数法是KKT条件的一种特殊形式。

支持向量机简介

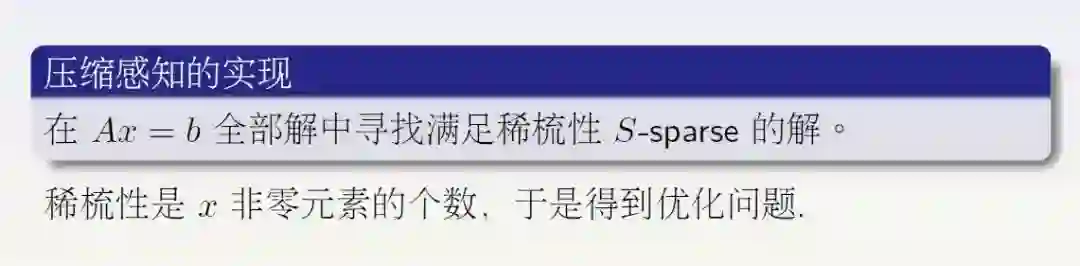

压缩感知介绍

向量的范数:

对于一个向量:𝑥=𝑥1,⋯,𝑥𝑛,通常定义:

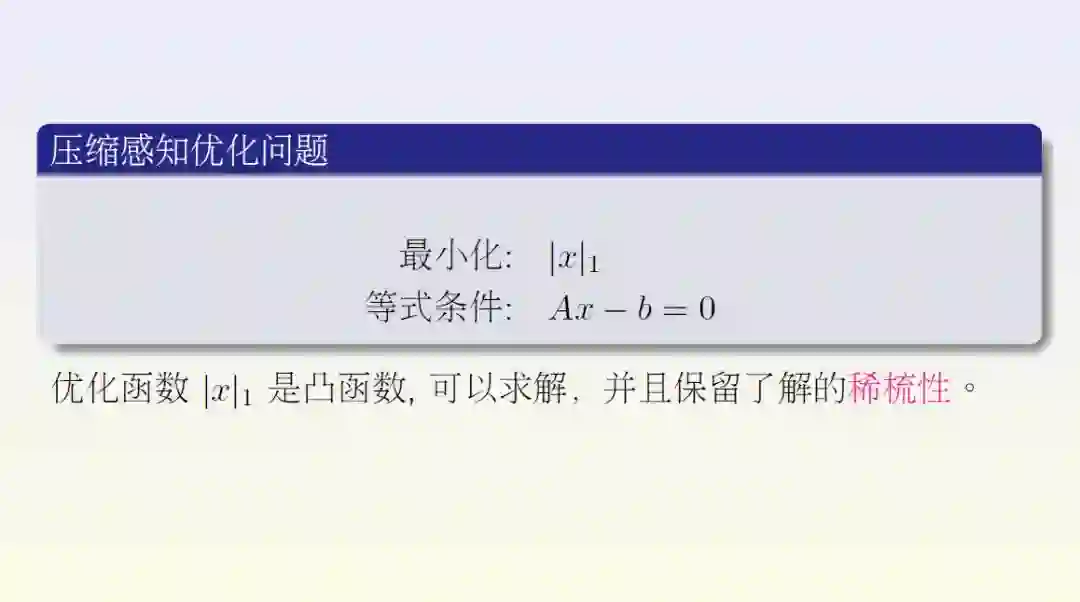

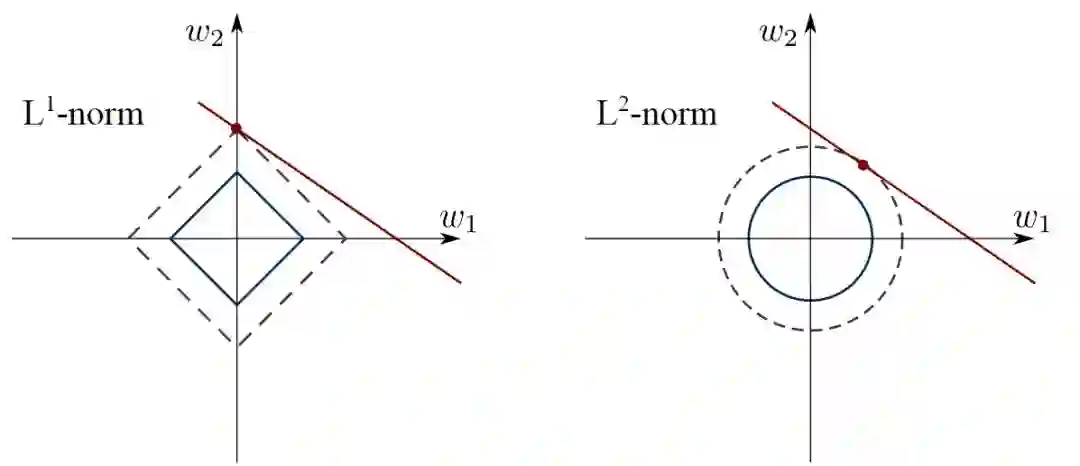

Lasso 方法与优化的稳定性:

左图:𝑥1+𝑥2的等高线有尖点,此处最优解中𝑤1=0。

右图:𝑥12+𝑥22的等高线是圆,此处最优解中𝑤1,𝑤2≠0,不具备稀疏性。

当线性条件(图中红色直线)由于噪音,产生微小变动时:

左图:最优解中𝑤1=0,较稳定。

右图:最优解中𝑤1,𝑤2同时改变,较为不稳定。

代码示例

SVM 分类器:

https://scikit-learn.org/stable/modules/svm.html

压缩感知:

https://scikit-learn.org/stable/auto_examples/applications/plot_tomography_l1_reconstruction.html

机器学习所需的数学基础,主要就是四大方面:微积分、线性代数、概率论、以及上文分享的优化。

大家如果对其他三方面感兴趣,目前《机器学习中的数学第二期》可以免费试听。快用PC端打开网页,开始学习吧

课程网址:

https://www.julyedu.com/course/getDetail/103&from=dl

大量学员拿到30-40万年薪

多位名校博士+BAT专家手把手教学

现在报名

送18VIP会员

[包2018全年在线课程和全年GPU]

前80人可享特惠价

↓立刻扫码查看详情↓