视频 | Nature新论文:机器人可以像动物一样进化了

机器人学习的过程就像是我们人类一样,反复练习,更新知识,不断试错,快速迭代,直到最后获得新的技能。

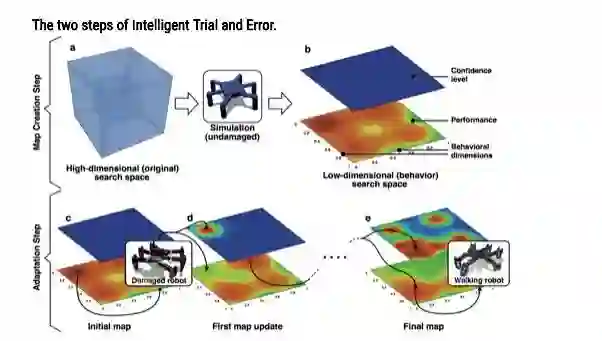

《像动物一样适应的机器人(This Robot Adapts Like Animals)》论文提出一种智能试错法算法,算法允许机器人快速适应破坏,完全不需要自我诊断或是提前准备应急措施。

This Robot Adapts Like Animals

对于人类而言,有很多危险的工作,例如扑灭森林火灾,寻找地震废墟下的幸存者,或者是关闭福岛核电站等等。如果这些高危工作能让AI来完成,那该有多好!

本期介绍的论文中出现了两个机器人:一个六组机器人和一个机械手臂,以此来展示动作方面的智能试错算法。这是一种快速有效的损坏恢复算法,可以使机器人更加高效和可靠地运行。

与传统强化学习(RL)方法相比,本期介绍的论文更加有效率,机器人上只需要花上几分钟和几次物理试验,而RL算法通常必须进行数百次测试才能学会如何完成任务。论文介绍了机器人有一个「模拟童年」(simulated childhood),在这里它学习了移动身体的不同方式,在经过几次测试和大约两分钟后就可以适应。

本期论文跟之前的研究有两个主要区别:

(1)机器人不需要知道损伤是什么,它只需要一种方法来衡量其性能;

(2)我们没有一个大型资料库来指导,遭受各种类型的损害之后应该怎么做。相反,我们的机器人可以像动物那样,自行学会应对各种损害的场景。

在这项研究中,机器人使用自己的模拟,找到成千上万种不同的行走方式。一旦损坏,机器人会进行体验并更新其关于每种可能行为的性能的知识(该更新将通过机器学习算法完成:高斯过程回归)。之前所习得的13000种行为通通变得不管用了,因此,机器人必须利用之前的知识进行下一步操作的可行性测试:在大多数情况下,它会测试少于10种行为,以找到一个尽管受到损害仍能正常工作的行为。

论文原址:

https://members.loria.fr/jbmouret/nature_press.html

扫描二维码,即刻报名参与IV2018

📚往期文章推荐

🔗还用PDF读论文你就out了:打破传统的“互动式论文”已经登上舞台

🔗Ian Goodfellow:生成对抗网络GAN的公式是怎样推导出来的

🔗【YAC2018】第33届中国自动化学会青年学术年会在南京召开

🔗中国高校国际学术影响哪家强?浙大国际发文量居首,清华被引最多

🔗真学霸!这位“90后”不是海归,博士毕业直接被聘为985高校教授

🔗民办高校也能发Science!浙江万里学院80后教授团队发表一篇Science

🔗他被称作“吝啬鬼”,30年捐赠50亿,名字被镌刻在中国几乎所有的大学内

德先生公众号 | 往期精选

在公众号会话位置回复以下关键词,查看德先生往期文章!

人工智能|机器崛起|区块链|名人堂

虚拟现实|智能制造|专家智库|科技快讯

名人轶事|峥嵘岁月|专题探讨|学术活动

……

更多精彩文章正在赶来,敬请期待!

点击“阅读原文”,移步求知书店,可查阅选购德先生推荐书籍。