ICRL 2020 会议日程解读

因疫情影响,The International Conference on Learning Representations(ICLR 2020)遗憾地成为首个线上虚拟学术顶会,而所有被接受的论文都要预先录制展示视频。虽然少了与大佬们当面交流的机会,但在家就能坐听大咖开讲也是种不错的选择。

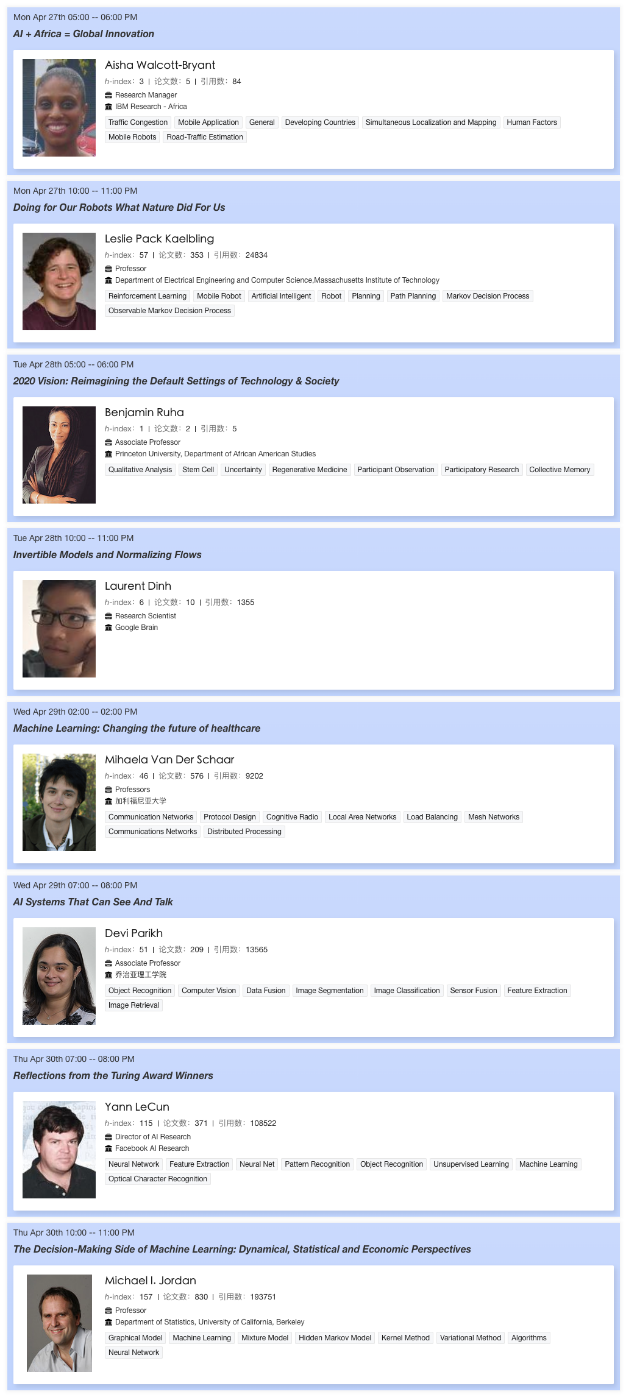

在 ICLR 2020 共 5 天(2020 年 4 月 26 日-2020 年 4 月 30 日)的会议日程中,一共邀请了 8 位全球高影响力的学者(4 位女性学者、4 位男性学者)做报告,每天可以听到两位学术大咖的精彩分享。这些学者中有很多来自机器学习领域的大牛,诸如机器学习泰斗、美国三院院士 Michael I. Jordan,“卷积网络之父”Yann LeCun、Facebook 人工智能研究院(FAIR)首席科学家 Devi Parikh 等,非常值得期待!

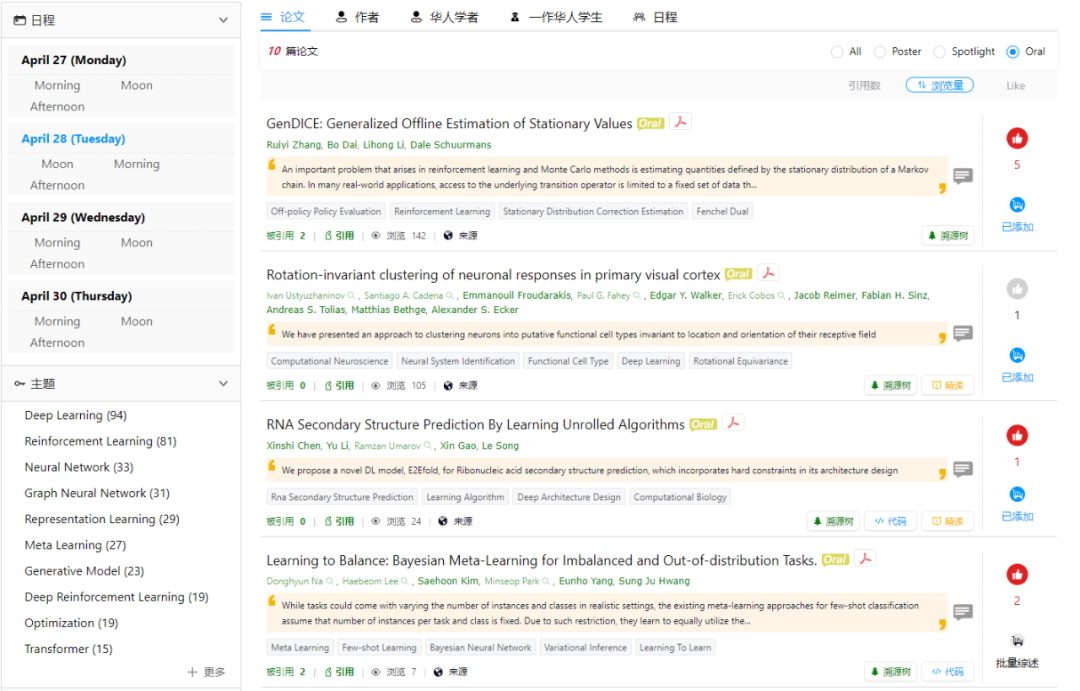

4 月 27 日,展示 172 篇论文(涵盖元学习、对抗网络、多智能体学习、联邦学习、深度强化学习等主题),包括 14 篇 Oral、32 篇 Spotlight、126 篇 Poster。其中,德克萨斯大学团队发表的 Meta-Q-Learning,介绍了一种新的元-Q 学习(Meta-Q-Learning,MQL)算法,这是一种新的用于元强化学习的离线策略算法。元-Q 学习借鉴了倾向性估计的思想,从而扩充了用于自适应的可用数据量。在标准连续控制基准上的实验表明,与最新的元强化学习算法相比,元-Q 学习更具有优势。

4 月 30 日,展示 177 篇论文(涵盖图神经网络、神经机器翻译、图嵌入表示、问答系统、超网络优化、强化学习、联合学习、自然语言生成、神经网络剪枝等主题),包括 12 篇 Oral、26 篇 Spotlight、139 篇 Poster。其中,南京大学团队发表的 Mirror-Generative Neural Machine Translation 获得满分评价。该论文提出一种镜像生成式机器翻译模型:MGNMT(mirror-generative NMT)。MGNMT 是一个统一的框架,同时集成了 source-target 和 target-source 的翻译模型及其各自语种的语言模型。MGNMT 中的翻译模型和语言模型共享隐语义空间,所以能够从非平行语料中更有效地学习两个方向上的翻译。此外,翻译模型和语言模型还能够联合协作解码,提升翻译质量。实验表明本文方法确实有效,MGNMT 在各种场景和语言(包括 resource rich 和 low-resource 语言)中始终优于现有方法。

【3D视觉】:《3D视觉技术白皮书》