NeurIPS 2022 | 马里兰、北大等机构提出量子算法用于采样对数凹分布和估计归一化常数

机器之心专栏

本文是 NeurIPS 2022 入选论文《Quantum Algorithms for Sampling Log-Concave Distributions and Estimating Normalizing Constants》的解读。该方法对数凹采样(log-concave sampling)在机器学习、物理、统计等领域有着诸多应用。

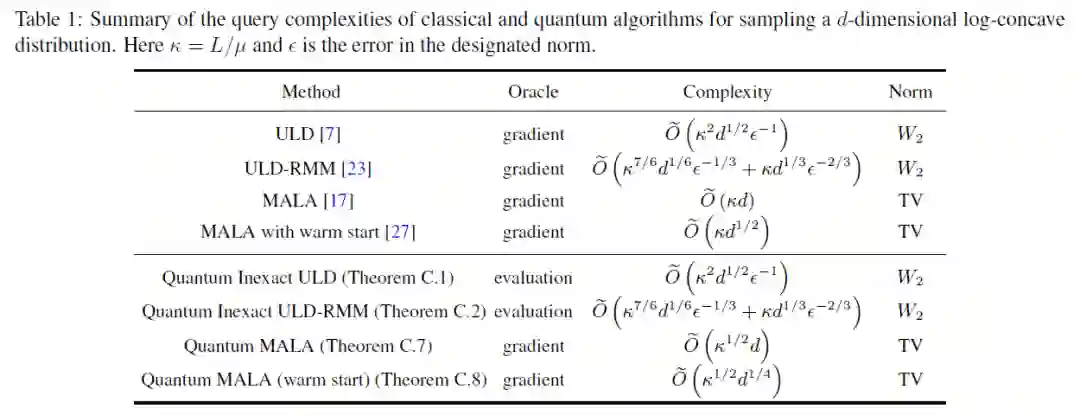

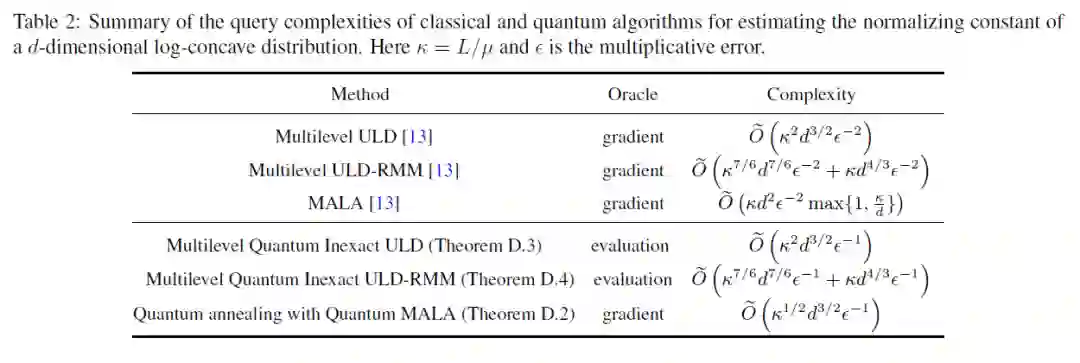

对数凹采样(log-concave sampling)在机器学习、物理、统计等领域有着诸多应用。本文基于朗之万扩散(Langevin diffusion)设计了新的量子算法,用于采样对数凹分布和估计归一化常数,相比最好的经典算法对于精度(ε),维度(d),条件数(κ)等参数达到了多项式级加速。

论文地址:https://arxiv.org/abs/2210.06539

本文作者包括:Andrew M. Childs(马里兰大学),李彤阳(北京大学),刘锦鹏(加州大学伯克利分校西蒙斯研究所),王春昊(宾州州立大学)和张睿哲(德州大学奥斯汀分校)。

问题介绍

问题模型

-

对数凹采样:输出一个随机变量满足分布 -

归一化常数估计:输出一个随机变量

主要贡献

-

-

-

对于量子访问 oracle 的查询复杂度为 -

对于量子梯度 oracle 的查询复杂度为

技术改进

参考文献

[1] Andrew M. Childs, Tongyang Li, Jin-Peng Liu, Chunhao Wang, and Ruizhe Zhang, "Quantum Algorithms for Sampling Log-Concave Distributions and Estimating Normalizing Constants," to appear in NeurIPS 2022.

[2] Rong Ge, Holden Lee, and Jianfeng Lu, "Estimating normalizing constants for log-concave distributions: Algorithms and lower bounds," STOC 2020.

[3] Xiang Cheng, Niladri S. Chatterji, Peter L. Bartlett, and Michael I. Jordan, "Underdamped langevin mcmc: A non-asymptotic analysis," COLT 2018.

[4] Yin Tat Lee, Ruoqi Shen, and Kevin Tian, "Logsmooth gradient concentration and tighter runtimes for metropolized Hamiltonian Monte Carlo," COLT 2020.

[5] Ruoqi Shen and Yin Tat Lee, "The randomized midpoint method for log-concave sampling," NeurIPS 2019.

[6] Keru Wu, Scott Schmidler, and Yuansi Chen, "Minimax mixing time of the Metropolis-adjusted Langevin algorithm for log-concave sampling," 2021, arXiv:2109.13055.

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com