多角度理解CNN

本文主题

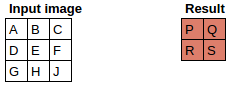

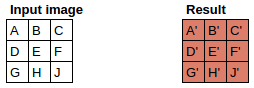

图像

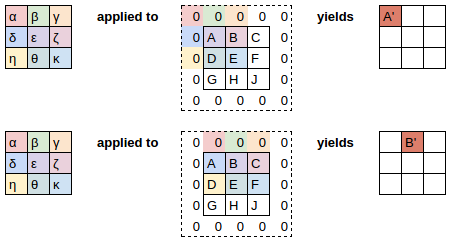

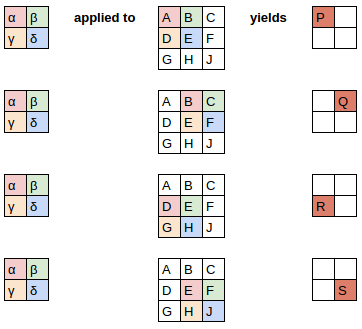

Filter

Filter 作用图像后结果

如何得到?

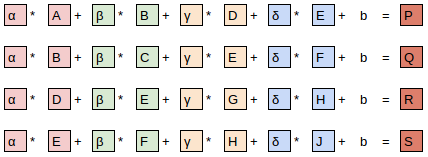

等式角度

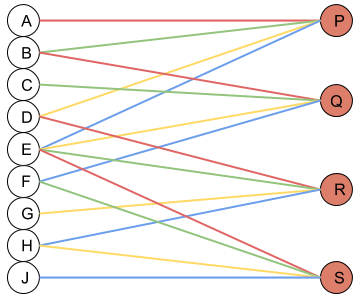

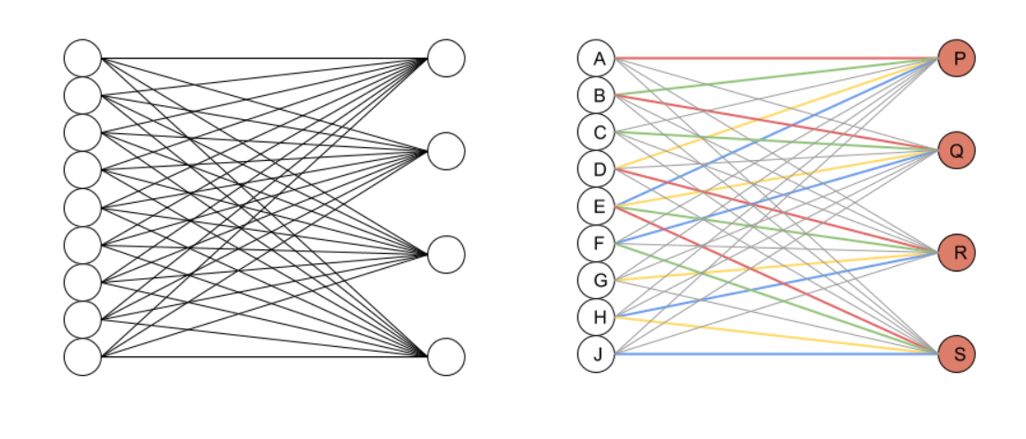

神经网络角度

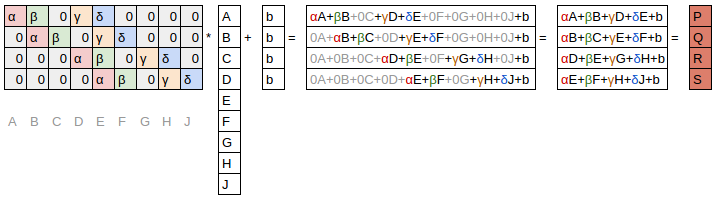

矩阵乘法角度

-

灰色显示的 0是不可训练的,这意味着它们在整个优化过程中保持为零; -

有些权重是相等的,虽然它们是可训练的(即可改变的),但它们必须保持相等。这些被称为“ 共享权重”。

Dense 神经网络角度

通过 zero-padding 保持原尺寸

注意到我们以上是从 3x3 矩阵变成了 2x2,

Reference

-

Fast.ai 课程 [1],特别是其中的conv-example [2]以及对应的视频(0:00-14:00) [3] -

Michael Nielsen 的神经网络与深度学习 [4]书 -

Realistic views [5] -

Visualizing what ConvNets learn [6]

本文参考资料

Fast.ai 课程: https://course.fast.ai/

[2]conv-example: https://github.com/fastai/courses/blob/master/deeplearning1/excel/conv-example.xlsx

[3]对应的视频(0:00-14:00): https://www.youtube.com/watch?v=V2h3IOBDvrA

[4]Michael Nielsen 的神经网络与深度学习: http://neuralnetworksanddeeplearning.com/

[5]Realistic views: http://setosa.io/ev/image-kernels/

[6]Visualizing what ConvNets learn: http://cs231n.github.io/understanding-cnn/

- END -

推荐阅读

大幅减少GPU显存占用:可逆残差网络(The Reversible Residual Network)

AINLP-DBC GPU 云服务器租用平台建立,价格足够便宜

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLP君微信(id:AINLP2),备注工作/研究方向+加群目的。