最新最全的视觉Transformer教程!论文分析 + 逐行Coding,带你轻松玩转ViT

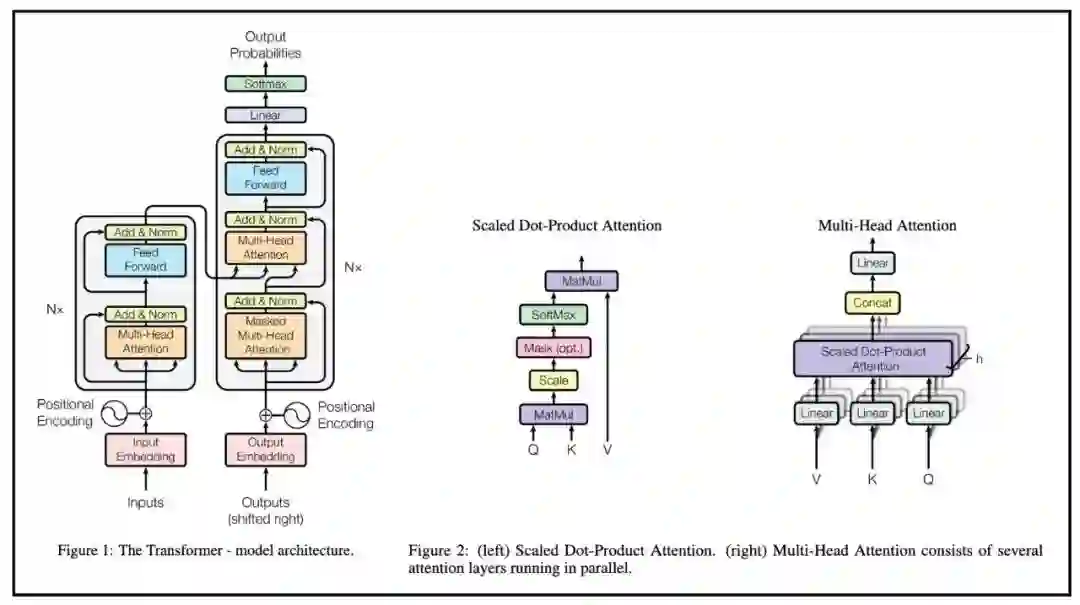

Transformer自2017年被提出后,从横扫NLP领域的风光无二,到陷入一片对其在CV任务有效性的质疑声中,再到不久前在多项图像任务中显示出直逼CNN的优异性能 以及 ICCV2021 best paper:Swin Transformer的火热出炉,Transformer逐步在CV领域大放异彩!

也因此,Transformer、Vision Transformer、QKV、Attention is all you need等字眼又一次引爆学术圈!

作为开发者,在为这颗学术巨星拍手叫好的同时,何不及时上车,搞明白编码器解码器里的QKV到底是什么、火遍全网的Swin Transformer做对了什么?Transformer为何能横扫NLP,又是怎么在CV任务中发挥作用的?以及最近的 CV大神新作MAE算法又是如何运作的?

花10个小时时间真正搞懂这些热词背后的技术价值,亲自动手实现这些爆款ViT算法,甚至将其应用在自己当前的工作与科研中,成为下一个顶会爆款!

《ViT十讲》

Is All You Need!

11月23日(周二),AI顶会审稿人、百度深度学习研究院资深研究员朱欤博士直播讲授《Vision Transformer十讲》。每晚1小时、连续10天,朱欤博士带你从零玩转ViT算法!

Vision Transformer前沿技术全面讲解:从ViT经典算法到最新学界前沿,从技术原理到实现细节, ViT, Swin, DETR逐个带你掌握视觉算法新范式。

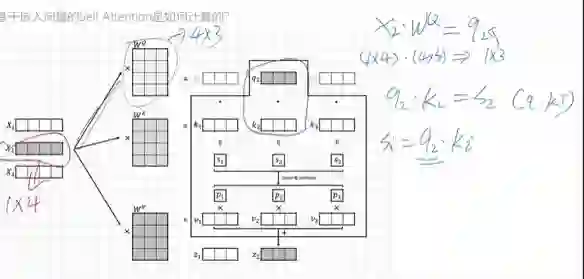

论文分析 + 逐行Coding、现场板书,手推公式:详细解析论文要点,每节课有一半时间会带着大家现场写代码~带大家实现自己的ViT模型,对小白也很友好。

全程carry 玩转ViT:课程内容完全开源、全程中文直播授课、高水平助教团队社群内答疑、配套有不同难度的实践任务以满足各阶段学习需求,并提供免费GPU算力支持!

加入开源技术小组,和研究院大佬们一起成为学术套件PPViT 的核心 contributor:共同降低ViT模型实现门槛,提高科研学习生产力。(https://github.com/BR-IDL/PaddleViT )

课程大纲

第一讲

理论:Hello, Vision Transformer!

实践:Warmup:模型搭建和训练

第二讲

理论:从Transformer到Vision Transformer

实践:玩转Tensor操作,开始搭建ViT

第三讲

理论:你看你的,我看我的之详解注意力

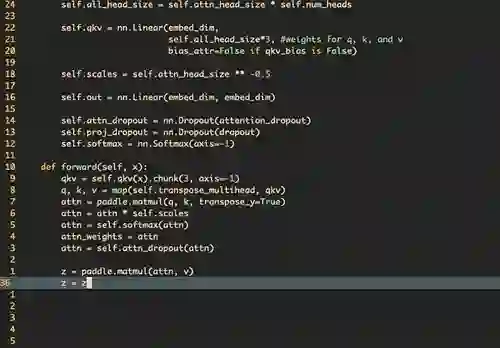

实践:Multi-Head Self Attention

第四讲

理论:搭建你的第一个ViT模型

实践:如何实现ViT模型

第五讲

理论:ViT模型搭建好了,如何高效训练?

实践:实战模型搭建和训练

第六讲

理论:什么是Window Attention?

实践:图像窗口上的注意力机制

第七讲

理论:大名鼎鼎的Swin Transformer

实践:实现你的第二个ViT模型

第八讲

理论:Conv和Transformer的结合

实践:从框架源码看如何实现数据加载

第九讲

理论:带你了解前沿算法:视觉上的BERT

实践:模型训练的技巧

第十讲

理论:检测算法新范式-DETR

实践:实战ViT训练测试全流程

你将收获

无论你是刚接触深度学习,还是已经在做科研,无论你是CV想转NLP,还是NLP想搞CV,又或者你想用最新的视觉技术打比赛、发论文,通过学习《Vision Transformer十讲》,你都将获得将论文中的模型图变成一行行代码的能力,告别简单的git clone和调包!

万元豪礼 只等你来

参与课程、致敬开源,即可获得:PaddlePaddle官方结业证书、Marshall ACTON II BLUETOOTH无线重低音音箱、HHKB Professional静电容蓝牙键盘、Tesla V100 GPU算力卡、百度网盘超级会员等超多奖励!上不封顶!更有直播间花式抽奖等你来拿!

开课时间

11月23日 — 12月2日

每晚八点半

立即免费报名

扫码关注【飞桨】公众号

10节课带你掌握ViT前沿技术

回复【打卡营】 获取课程地址

加入官方QQ群(群号:920200490),获取开课地址、直播提醒、课程代码、免费算力、在线答疑等福利!